说明:部分内容来源于网络教程,如有侵权请联系本人删除相关内容。

教程链接:1.1Transformer背景介绍_哔哩哔哩_bilibili

一、优势

相比于之前介绍的RNN以及其变种LSTM和GRU,Transfomer有两个优势:

1.可以利用分布式GPU并行训练,提升训练效果

2.相比于LSTM和GRU,可以关联间隔时间更长的样本,效果更好

二、作用

基于seq2seq的Transformer模型可以完成NLP领域的典型任务。但是也可以被应用到图像识别、语音识别等领域。例如可以用CNN+Transformer进行语音识别。

三、架构

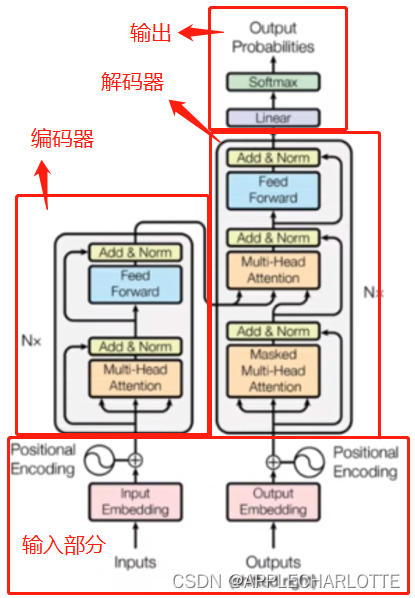

图1:Tranfomer架构

1.编码器部分

编码器部分由N个编码器层堆叠而成。每个编码器层由2个子层连接:

子层1:多头自注意力层+规范化层+残差连接

子层2:前馈全连接层+规范化层+残差连接

2.解码器部分

解码器部分由N个解码器层堆叠而成。每个解码器层由3个子层连接:

子层1:带有掩码的多头注意力层+规范化层+残差连接

子层2:多头自注意力层+规范化层+残差连接

子层3:前馈全连接层+规范化层+残差连接