一、GBDT

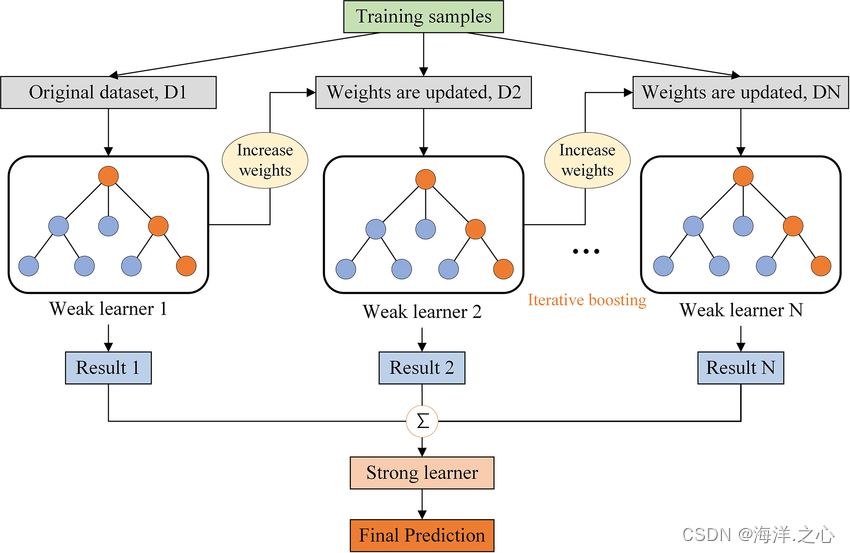

GBDT(Gradient Boosting Decision Tree)是一种集成学习算法,属于Boosting家族的一员。它通过迭代地训练多个决策树,每个决策树都尝试纠正上一个树的错误,从而提高整体模型的预测性能。GBDT在回归和分类问题中都有广泛的应用,被认为是一种强大的机器学习算法。

GBDT的主要特点和步骤如下:

-

基础模型: GBDT通常使用决策树作为基础模型(弱学习器)。初始时,训练一个包含单一叶节点的树,该叶节点的值为所有样本的平均值(对于回归问题)或概率(对于分类问题)。

-

迭代训练: GBDT通过迭代的方式训练多个决策树。在每一轮迭代中,根据上一轮的预测结果和实际标签之间的残差,训练一个新的决策树来纠正上一轮的误差。然后将新树的预测结果加到之前的预测中,从而逐步改善模型预测。</