nvidia-smi(NVIDIA System Management Interface) 是基于nvml的gpu的系统管理接口,主要用于显卡的管理和状态监控。

nvidia-smi简称NVSMI,提供监控GPU使用情况和更改GPU状态的功能,是一个跨平台工具,支持所有标准的NVIDIA驱动程序支持的Linux和WindowsServer 2008 R2 开始的64位系统。这个工具是N卡驱动附带的,只要装好驱动,就会有这个命令

1.基础命令nvidia-smi

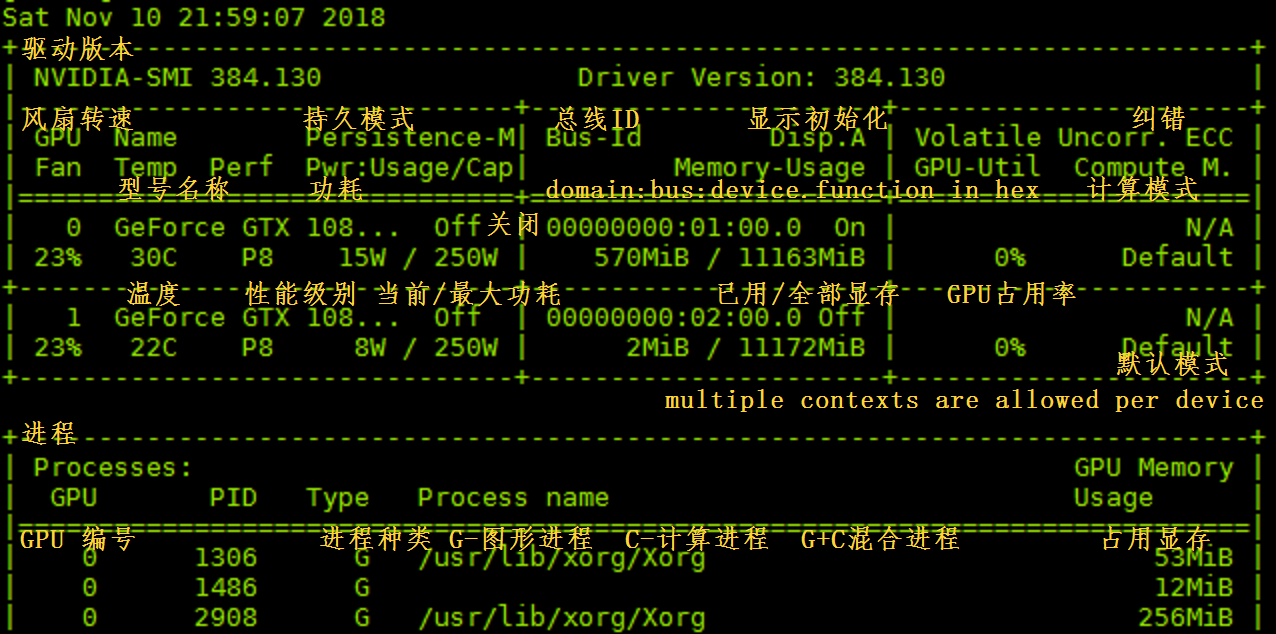

安装完成后在命令行或终端输入命令nvidia-smi,即可看到下面的信息:

包含了显卡的信号、温度、风扇、功率、显存、使用率、计算模式等信息。

表格参数详解:

-

GPU:本机中的GPU编号(有多块显卡的时候,从0开始编号)图上GPU的编号是:0

-

Fan:风扇转速(0%-100%),N/A表示没有风扇

-

Name:GPU类型,图上GPU的类型是:Tesla T4

-

Temp:GPU的温度(GPU温度过高会导致GPU的频率下降)

-

Perf:GPU的性能状态,从P0(最大性能)到P12(最小性能),图上是:P0

-

Persistence-M:持续模式的状态,持续模式虽然耗能大,但是在新的GPU应用启动时花费的时间更少,图上显示的是:off

-

Pwr:Usager/Cap:能耗表示,Usage:用了多少,Cap总共多少

-

Bus-Id:GPU总线相关显示,domain:bus:device.function

-

Disp.A:Display Active ,表示GPU的显示是否初始化

-

Memory-Usage:显存使用率

-

Volatile GPU-Util:GPU使用率

-

Uncorr. ECC:关于ECC的东西,是否开启错误检查和纠正技术,0/disabled,1/enabled

-

Compute M:计算模式,0/DEFAULT,1/EXCLUSIVE_PROCESS,2/PROHIBITED

-

Processes:显示每个进程占用的显存使用率、进程号、占用的哪个GPU

2.实用命令

#帮助

nvidia-smi -h

#持续监控gpu状态 (-lms 可实现毫秒级监控)

nvidia-smi -l 3 #每三秒刷新一次状态,持续监控

#列出所有GPU,大写L

nvidia-smi -L

#查询所有信息

nvidia-smi -q

#查询特定卡的信息,0.1.2.为GPU编号

nvidia-smi -i 0

#显示特定的信息 MEMORY, UTILIZATION, ECC, TEMPERA-TURE, POWER, CLOCK, COMPUTE, PIDS, PERFORMANCE, SUPPORTED_CLOCKS, #PAGE_RETIREMENT, ACCOUNTING 配合-q使用

nvidia-smi -q -d MEMORY

#监控线程

nvidia-smi pmon

#监控设备

nvidia-smi dmon

#此外还有一系列可以配置模式的属性,可以直接利用nvidia-smi配置

#查询命令外的配置命令,请慎重使用!!!

#对于配置类命令,务必事先确认命令的含义!!!

REF:http://developer.download.nvidia.com/compute/DCGM/docs/nvidia-smi-367.38.pdf