本篇博客主要讲将Excel表格百万数据转成csv文件导入到Mysql,用20多秒导入百万数据

测试环境:

注意:不同操作系统的回车换行不大一样,会得出不同的结果。

mysql Load Data InFile大量数据插入,load data infile语句以很高的速度从一个文本文件中读取行到一个表中

先将excel转成.csv文件,格式是"UTF-8",

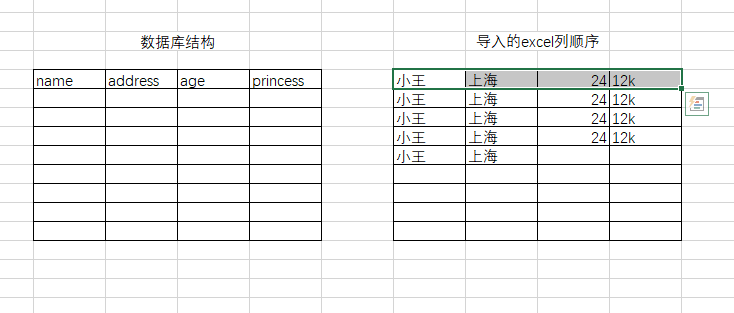

如果是导入有中文的数据,我的mysql 设置的utf8 字符集,所以你要导入的 文件也要保存utf-8的字符集,数据表列的顺序必须和excel的对应,否则导入的数据会有错误,

数据表的列顺序必须和导入的excel列顺序一样,否者导入的数据不对,就会发生A列的数据导入到了B列中

下面写sql语句,我用的是windows+Mysql

注意: 文件路径名要上的 " \ "要变成 “ \\ ”或者 " / ",否则会报错

load data local infile 'C:/GoogleDownload/csv/tempdata.csv'

into table tablename

fields terminated by ',' enclosed by '\"'

属性:

tablename 要写入的数据表名

terminated by ',' -- 字段以”,“分隔

enclosed by ' " ' --字段闭合标签

在使用load data到mysql的时候,有2种情况:

(1)在远程客户端(需要添加选项:--local-infile=1)导入远程客户端文本到mysql,需指定local(默认就是ignore),加ignore选项会放弃数据,加replace选项会更新数据,都不会出现唯一性约束问题。

(2)在本地服务器导入本地服务器文本到mysql,不指定local,出现唯一性约束冲突,会失败回滚,数据导入不进去,这个时候就需要加ignore或者replace来导入数据。

load data是一个很有用的命令,而且命令的选项很多,但大多都用不到,如果真的需要,用的时候看看官方文档