kubernetes集群(一主多从)环境搭建完整教程

一、前言

1.1 kubernetes简介

kubernetes是一个全新的基于容器技术的分布式架构领先方案,是谷歌严格保密十几年的秘密武器,它的本质是一组服务器集群,它可以在集群的每个节点上运行特定的程序,来对节点中的容器进行管理。目的是实现资源管理的自动化,主要提供了如下的主要功能:

自我修复:一旦某一个容器崩溃,能够在1秒中左右迅速启动新的容器

弹性伸缩:可以根据需要,自动对集群中正在运行的容器数量进行调整

服务发现:服务可以通过自动发现的形式找到它所依赖的服务

负载均衡:如果一个服务起动了多个容器,能够自动实现请求的负载均衡

版本回退:如果发现新发布的程序版本有问题,可以立即回退到原来的版本

存储编排:可以根据容器自身的需求自动创建存储卷

1.2 kubernetes概念

Master:集群控制节点,每个集群需要至少一个master节点负责集群的管控

Node:工作负载节点,由master分配容器到这些node工作节点上,然后node节点上的docker负责容器的运行

Pod:kubernetes的最小控制单元,容器都是运行在pod中的,一个pod中可以有1个或者多个容器

Controller:控制器,通过它来实现对pod的管理,比如启动pod、停止pod、伸缩pod的数量等等

Service:pod对外服务的统一入口,下面可以维护者同一类的多个pod

Label:标签,用于对pod进行分类,同一类pod会拥有相同的标签

NameSpace:命名空间,用来隔离pod的运行环境

1.3 kubernetes组件

Docker : 负责节点上容器的各种操作

Kubelet : 负责维护容器的生命周期,即通过控制docker,来创建、更新、销毁容器

KubeProxy : 负责提供集群内部的服务发现和负载均衡

ApiServer : 资源操作的唯一入口,接收用户输入的命令,提供认证、授权、API注册和发现等机制

Scheduler : 负责集群资源调度,按照预定的调度策略将Pod调度到相应的node节点上

ControllerManager : 负责维护集群的状态,比如程序部署安排、故障检测、自动扩展、滚动更新等

Etcd :负责存储集群中各种资源对象的信息

二、准备工作

2.1 准备三台虚拟机(一主两从)

操作系:CentOS-7-x86_64

硬件配置:2GB或更多RAM,2 个CPU或更多CPU,硬盘20GB或更多

集群中所有机器之间网络互通

可以访问外网,需要拉取镜像

禁止swap 分区

具体配置如下:

| 主机名 | IP | 系统配置 | 安装组件 |

|---|---|---|---|

| k8s-master | 192.168.0.129 | 4GB,2 个CPU,硬盘40GB | docker,kubectl,kubeadm,kubelet |

| k8s-node1 | 192.168.0.130 | 2GB,2 个CPU,硬盘20GB | docker,kubectl,kubeadm,kubelet |

| k8s-node2 | 192.168.0.131 | 2GB,2 个CPU,硬盘20GB | docker,kubectl,kubeadm,kubelet |

2.2 在三台虚拟机中安装docker

#配置yum源

sudo yum install -y yum-utils

sudo yum-config-manager --add-repo http://mirrors.aliyun.com/docker-ce/linux/centos/docker-ce.repo

#安装docker

sudo yum install -y docker-ce docker-ce-cli containerd.io

#设置开机自启并马上启动docker

systemctl enable docker --now

配置阿里云镜像加速器

具体执行命令:

sudo mkdir -p /etc/docker

sudo tee /etc/docker/daemon.json <<-'EOF'

{

"registry-mirrors": ["https://vsxcs7sq.mirror.aliyuncs.com"]

}

EOF

sudo systemctl daemon-reload

sudo systemctl restart docker

三、使用kubeadm安装方式kubernetes

3.1 在三台服务器中执行以下操作

#为三台虚拟机设置自己的域名

master:hostnamectl set-hostname k8s-master

node1:hostnamectl set-hostname k8s-node1

node2:hostnamectl set-hostname k8s-node2

# 将 SELinux 设置为 permissive 模式(相当于将其禁用)

sudo setenforce 0

sudo sed -i 's/^SELINUX=enforcing$/SELINUX=permissive/' /etc/selinux/config

#关闭swap

swapoff -a

sed -ri 's/.*swap.*/#&/' /etc/fstab

#关闭firewalld服务

systemctl stop firewalld

systemctl disable firewalld

#允许 iptables 检查桥接流量

cat <<EOF | sudo tee /etc/modules-load.d/k8s.conf

br_netfilter

EOF

cat <<EOF | sudo tee /etc/sysctl.d/k8s.conf

net.bridge.bridge-nf-call-ip6tables = 1

net.bridge.bridge-nf-call-iptables = 1

EOF

sudo sysctl --system

3.2 在三台机器中安装kubelet、kubeadm、kubectl

cat <<EOF | sudo tee /etc/yum.repos.d/kubernetes.repo

[kubernetes]

name=Kubernetes

baseurl=http://mirrors.aliyun.com/kubernetes/yum/repos/kubernetes-el7-x86_64

enabled=1

gpgcheck=0

repo_gpgcheck=0

gpgkey=http://mirrors.aliyun.com/kubernetes/yum/doc/yum-key.gpg

http://mirrors.aliyun.com/kubernetes/yum/doc/rpm-package-key.gpg

exclude=kubelet kubeadm kubectl

EOF

#安装kubelet、kubeadm、kubectl

sudo yum install -y kubelet-1.20.9 kubeadm-1.20.9 kubectl-1.20.9 --disableexcludes=kubernetes

#设置开机自启并立即启动kubelet

sudo systemctl enable --now kubelet

3.3 通过脚本使用kubeadm引导集群

sudo tee ./images.sh <<-'EOF'

#!/bin/bash

images=(

kube-apiserver:v1.20.9

kube-proxy:v1.20.9

kube-controller-manager:v1.20.9

kube-scheduler:v1.20.9

coredns:1.7.0

etcd:3.4.13-0

pause:3.2

)

for imageName in ${images[@]} ; do

docker pull registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images/$imageName

done

EOF

#添加脚本可执行权限并立即执行脚本

chmod +x ./images.sh && ./images.sh

#在三台机器中添加master域名映射,ip需要修改为自己的master主机地址

echo "192.168.0.129 cluster-endpoint" >> /etc/hosts

3.4 在master主机上初始化

kubeadm init \

--apiserver-advertise-address=192.168.0.129 \

--control-plane-endpoint=cluster-endpoint \

--image-repository registry.cn-hangzhou.aliyuncs.com/lfy_k8s_images \

--kubernetes-version v1.20.9 \

--service-cidr=10.10.1.0/16 \

--pod-network-cidr=192.168.0.0/16

成功后提示如下:

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

You can now join any number of control-plane nodes by copying certificate authorities

and service account keys on each node and then running the following as root:

kubeadm join cluster-endpoint:6443 --token 9h833z.6w79p5rzim9ihw4q \

--discovery-token-ca-cert-hash sha256:dbb8bf9145671e254ec75941976dca58af44fb3e1d308759ca8b8fc253235a4f \

--control-plane

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join cluster-endpoint:6443 --token 9h833z.6w79p5rzim9ihw4q \

--discovery-token-ca-cert-hash sha256:dbb8bf9145671e254ec75941976dca58af44fb3e1d308759ca8b8fc253235a4f

根据提示在master上执行下面的命令

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

#创建yaml目录并进入

mkdir -p /home/kubernetes/yaml

cd /home/kubernetes/yaml

#安装网络组件calico版本需要匹配,这里使用v.3.20版本

curl https://docs.projectcalico.org/v3.20/manifests/calico.yaml -O

kubectl apply -f calico.yaml

3.5 在node从节点上加入集群

#node节点加入集群

kubeadm join cluster-endpoint:6443 --token 9h833z.6w79p5rzim9ihw4q \

--discovery-token-ca-cert-hash sha256:dbb8bf9145671e254ec75941976dca58af44fb3e1d308759ca8b8fc253235a4f

#令牌失效可以在master上获取新令牌

kubeadm token create --print-join-command

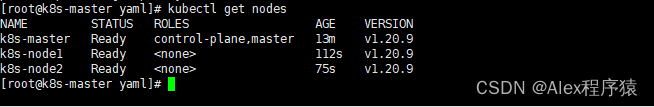

#在master上验证集群状态

kubectl get nodes

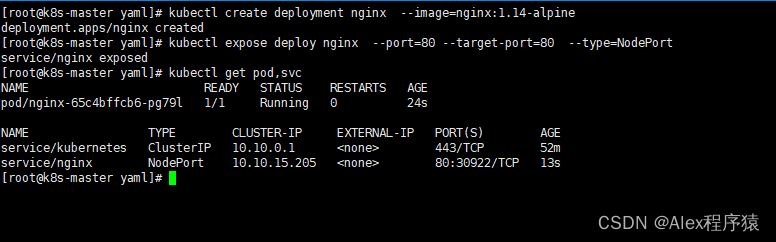

四、测试下集群部署Nginx服务

#创建一个nginx服务

kubectl create deployment nginx --image=nginx:1.14-alpine

#暴露端口

kubectl expose deploy nginx --port=80 --target-port=80 --type=NodePort

#查看服务

kubectl get pod,svc

#删除deployment

kubectl delete deploy nginx

#删除service

kubectl delete svc nginx -n default

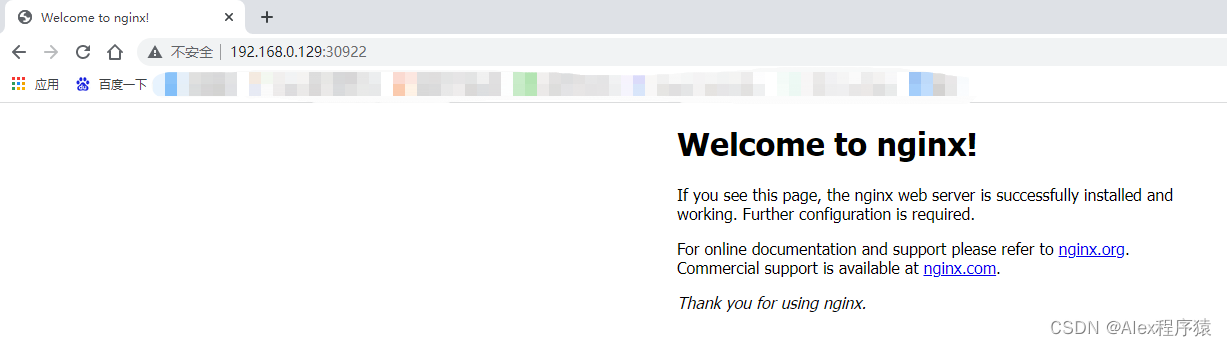

访问:http:192.168.0.129:30922 或者 http:192.168.0.130:30922 或者 http:192.168.0.131:30922

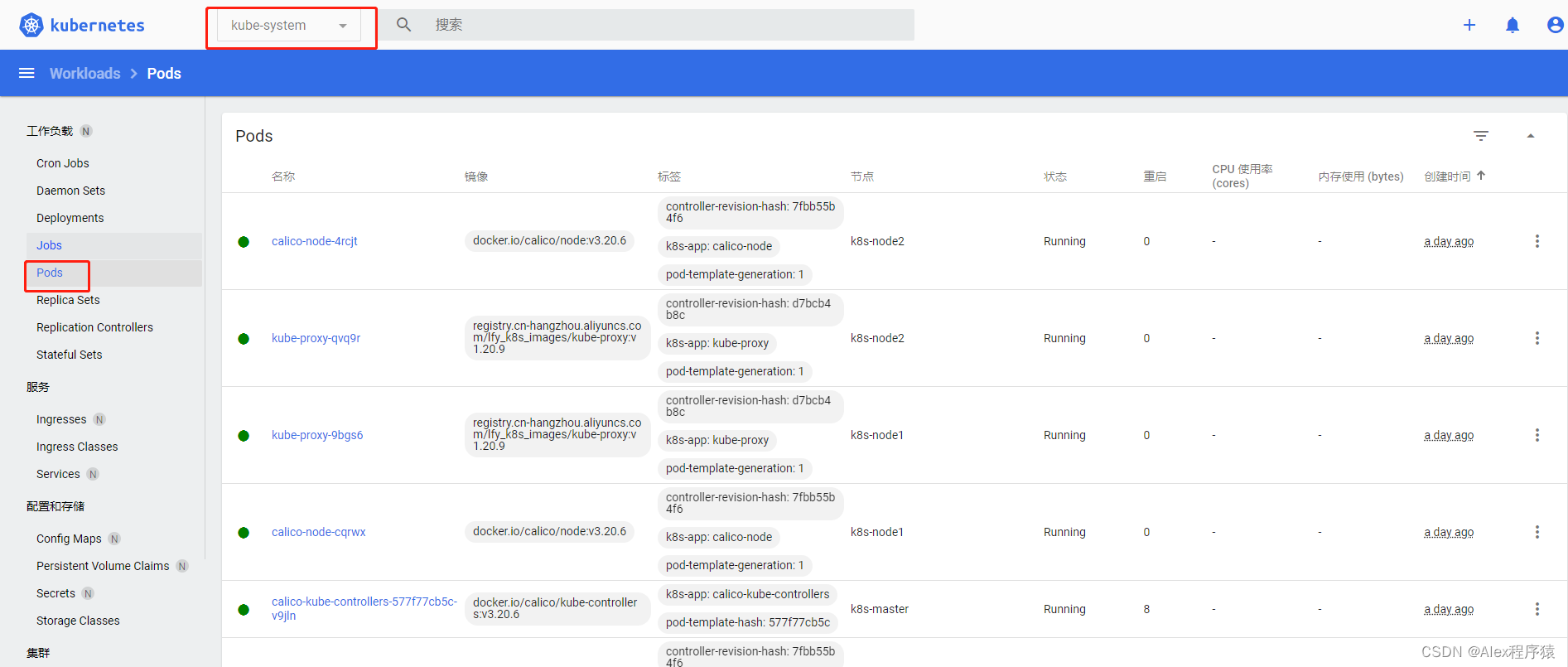

五、安装可视化管理工具dashboard

5.1 官方链接: https://github.com/kubernetes/dashboard

#下载recommended.yaml

curl https://raw.githubusercontent.com/kubernetes/dashboard/v2.7.0/aio/deploy/recommended.yaml

#修改recommended.yaml

vim recommended.yaml

{

1.type: ClusterIP 改为 type: NodePort

2.新增nodePort:30000

3.nodeSelector 改为 nodeName: k8s-master (主机名)

}

#启动

kubectl apply -f recommended.yaml

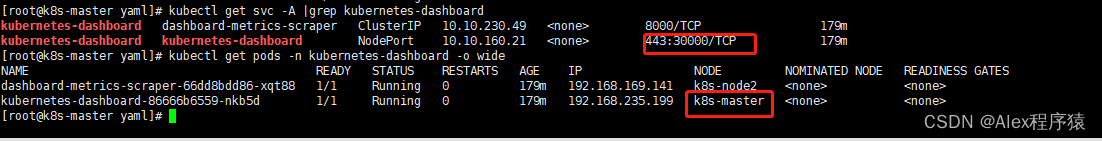

#查看端口号

kubectl get svc -A |grep kubernetes-dashboard

#查看pod的运行情况

kubectl get pods -n kubernetes-dashboard -o wide

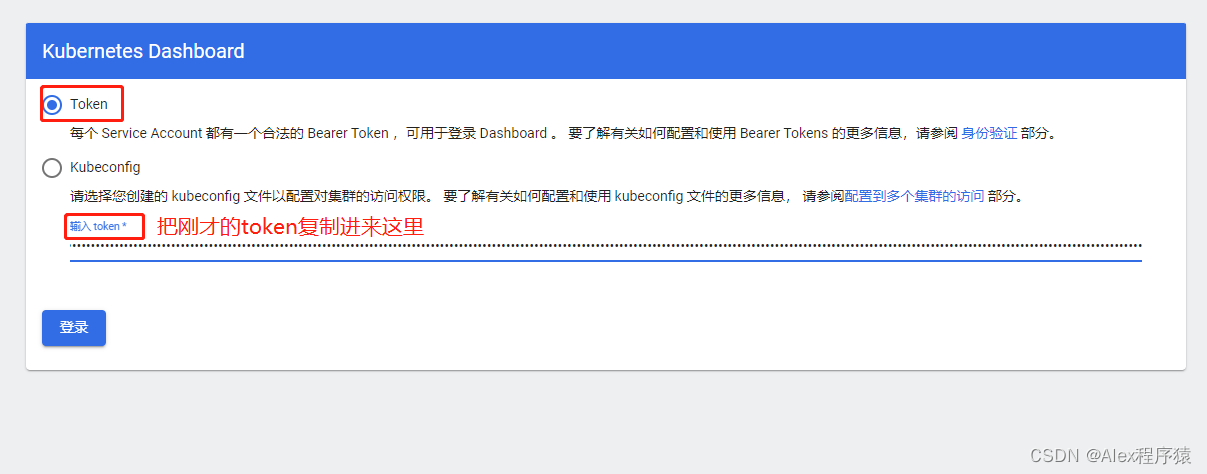

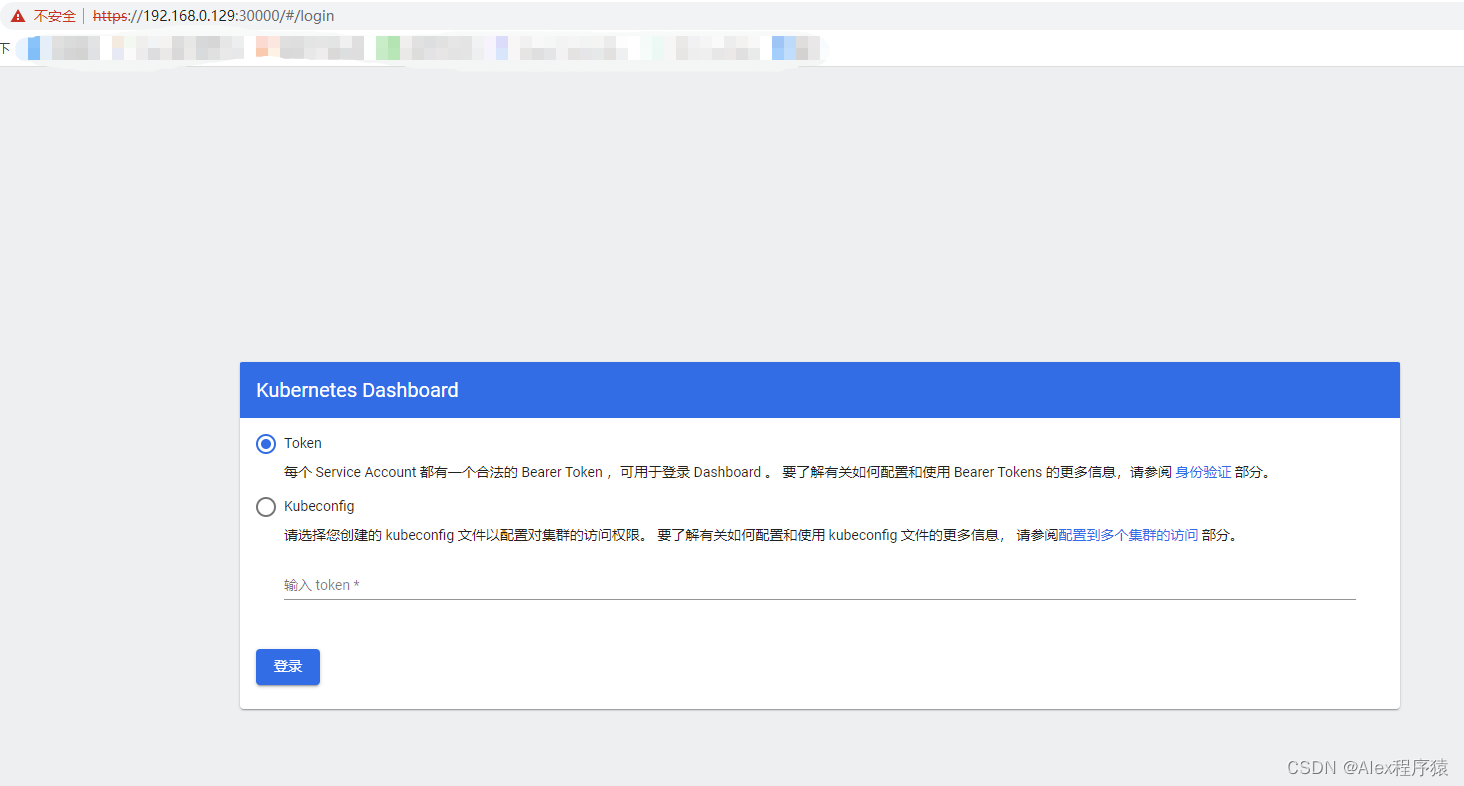

5.2 浏览器访问控制台

地址:https://192.168.0.129:30000/#/login

创建访问账户,获取token

方式1:创建dash-admin.yaml

apiVersion: v1

kind: ServiceAccount

metadata:

name: admin-user

namespace: kubernetes-dashboard

---

apiVersion: rbac.authorization.k8s.io/v1

kind: ClusterRoleBinding

metadata:

name: admin-user

roleRef:

apiGroup: rbac.authorization.k8s.io

kind: ClusterRole

name: cluster-admin

subjects:

- kind: ServiceAccount

name: admin-user

namespace: kubernetes-dashboard

启动程序:

#启动dash-admin.yaml

kubectl apply -f dash-admin.yaml

#获取访问令牌

kubectl -n kubernetes-dashboard get secret $(kubectl -n kubernetes-dashboard get sa/admin-user -o jsonpath="{.secrets[0].name}") -o go-template="{

{.data.token | base64decode}}"

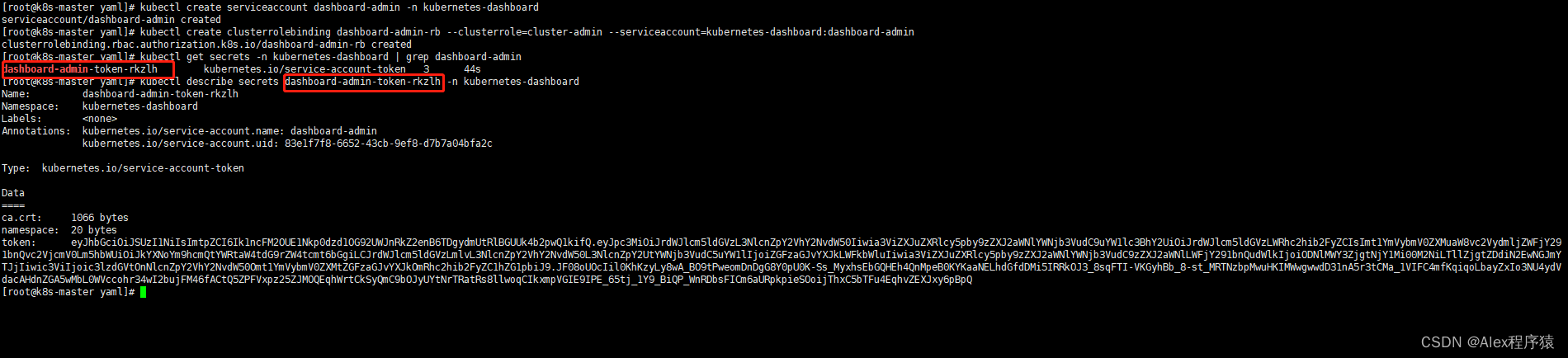

方式2:

#创建账号

kubectl create serviceaccount dashboard-admin -n kubernetes-dashboard

#授权

kubectl create clusterrolebinding dashboard-admin-rb --clusterrole=cluster-admin --serviceaccount=kubernetes-dashboard:dashboard-admin

#获取账号token

kubectl get secrets -n kubernetes-dashboard | grep dashboard-admin

kubectl describe secrets dashboard-admin-token-rkzlh -n kubernetes-dashboard