译者:飞龙

本文来自【OpenDocCN 饱和式翻译计划】,采用译后编辑(MTPE)流程来尽可能提升效率。

真相一旦入眼,你就再也无法视而不见。——《黑客帝国》

九、并发实践

本章涵盖

- 防止 goroutines 和通道的常见错误

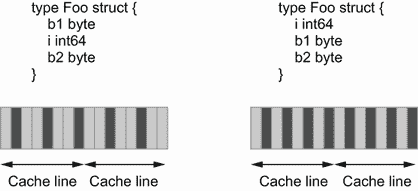

- 了解使用标准数据结构和并发代码的影响

- 使用标准库和一些扩展

- 避免数据竞争和死锁

在前一章中,我们讨论了并发的基础。现在是时候看看 Go 开发人员在使用并发原语时所犯的实际错误了。

9.1 #61:传播不适当的上下文

在 Go 中处理并发时,上下文无处不在,在许多情况下,可能建议传播它们。然而,上下文传播有时会导致细微的错误,阻止子函数的正确执行。

让我们考虑下面的例子。我们公开一个 HTTP 处理器,它执行一些任务并返回一个响应。但是就在返回响应之前,我们还想把它发送到一个kafka主题。我们不想降低 HTTP 消费者的延迟,所以我们希望在新的 goroutine 中异步处理发布操作。我们假设我们有一个接受上下文的publish函数,例如,如果上下文被取消,发布消息的操作就会被中断。下面是一个可能的实现:

func handler(w http.ResponseWriter, r *http.Request) {

response, err := doSomeTask(r.Context(), r) // ❶

if err != nil {

http.Error(w, err.Error(), http.StatusInternalServerError)

return

}

go func() {

// ❷

err := publish(r.Context(), response)

// Do something with err

}()

writeResponse(response) // ❸

}

❶ 执行一些任务来 HTTP 响应

❷ 创建了一个goroutine来向kafka发送响应

❸ 编写 HTTP 响应

首先我们调用一个doSomeTask函数来获得一个response变量。它在调用publish的 goroutine 中使用,并格式化 HTTP 响应。此外,当调用publish时,我们传播附加到 HTTP 请求的上下文。你能猜出这段代码有什么问题吗?

我们必须知道附加到 HTTP 请求的上下文可以在不同的情况下取消:

-

当客户端连接关闭时

-

在 HTTP/2 请求的情况下,当请求被取消时

-

当响应被写回客户端时

在前两种情况下,我们可能会正确处理事情。例如,如果我们从doSomeTask得到一个响应,但是客户端已经关闭了连接,那么调用publish时可能已经取消了一个上下文,所以消息不会被发布。但是最后一种情况呢?

当响应被写入客户端时,与请求相关联的上下文将被取消。因此,我们面临着一种竞争状态:

-

如果响应是在 Kafka 发布之后写的,我们都返回响应并成功发布消息。

-

然而,如果响应是在kafka发表之前或发表期间写的,则该消息不应被发表。

在后一种情况下,调用publish将返回一个错误,因为我们快速返回了 HTTP 响应。

我们如何解决这个问题?一种想法是不传播父上下文。相反,我们会用一个空的上下文调用publish:

err := publish(context.Background(), response) // ❶

❶ 使用空上下文代替 HTTP 请求上下文

在这里,这将工作。不管写回 HTTP 响应需要多长时间,我们都可以调用publish。

但是如果上下文包含有用的值呢?例如,如果上下文包含用于分布式跟踪的关联 ID,我们可以将 HTTP 请求和 Kafka 发布关联起来。理想情况下,我们希望有一个新的上下文,它与潜在的父取消无关,但仍然传达值。

标准包没有提供这个问题的直接解决方案。因此,一个可能的解决方案是实现我们自己的 Go 上下文,类似于所提供的上下文,只是它不携带取消信号。

一个context.Context是一个接口,包含四个方法:

type Context interface {

Deadline() (deadline time.Time, ok bool)

Done() <-chan struct{

}

Err() error

Value(key any) any

}

通过Deadline方法管理上下文的截止时间,通过Done和Err方法管理取消信号。当截止时间已过或上下文已被取消时,Done应该返回一个关闭的通道,而Err应该返回一个错误。最后,通过Value方法传送这些值。

让我们创建一个自定义上下文,将取消信号从父上下文中分离出来:

type detach struct {

// ❶

ctx context.Context

}

func (d detach) Deadline() (time.Time, bool) {

return time.Time{

}, false

}

func (d detach) Done() <-chan struct{

} {

return nil

}

func (d detach) Err() error {

return nil

}

func (d detach) Value(key any) any {

return d.ctx.Value(key) // ❷

}

❶ 自定义结构充当初始上下文顶部的包装

❷ 将获取值的调用委托给父上下文

除了调用父上下文获取值的Value方法之外,其他方法都返回默认值,因此上下文永远不会被视为过期或取消。

由于我们的自定义上下文,我们现在可以调用publish并分离取消信号:

err := publish(detach{

ctx: r.Context()}, response) // ❶

❶ 在 HTTP 上下文上使用detach

现在传递给publish的上下文将永远不会过期或被取消,但是它将携带父上下文的值。

总之,传播一个上下文要谨慎。在本节中,我们用一个基于与 HTTP 请求相关联的上下文处理异步操作的例子来说明这一点。因为一旦我们返回响应,上下文就会被取消,所以异步操作也可能会意外停止。让我们记住传播给定上下文的影响,如果有必要,总是可以为特定的操作创建自定义上下文。

下一节讨论一个常见的并发错误:启动一个 goroutine 而没有计划停止它。

9.2 #62:启动一个 goroutine 而不知道何时停止它

启动 goroutine 既容易又便宜——如此容易又便宜,以至于我们可能没有必要计划何时停止新的 goroutine,这可能会导致泄漏。不知道何时停止 goroutine 是一个设计问题,也是 Go 中常见的并发错误。我们来了解一下为什么以及如何预防。

首先,让我们量化一下 goroutine 泄漏意味着什么。在内存方面,一个 goroutine 的最小栈大小为 2 KB,可以根据需要增加和减少(最大栈大小在 64 位上是 1 GB,在 32 位上是 250 MB)。在内存方面,goroutine 还可以保存分配给堆的变量引用。与此同时,goroutine 可以保存 HTTP 或数据库连接、打开的文件和网络套接字等资源,这些资源最终应该被正常关闭。如果一个 goroutine 被泄露,这些类型的资源也会被泄露。

让我们看一个例子,其中 goroutine 停止的点不清楚。这里,父 goroutine 调用一个返回通道的函数,然后创建一个新的 goroutine,它将继续从该通道接收消息:

ch := foo()

go func() {

for v := range ch {

// ...

}

}()

当ch关闭时,创建的 goroutine 将退出。但是我们知道这个通道什么时候会关闭吗?这可能不明显,因为ch是由foo函数创建的。如果通道从未关闭,那就是泄漏。因此,我们应该始终保持警惕,确保最终到达一个目标。

我们来讨论一个具体的例子。我们将设计一个需要观察一些外部配置的应用(例如,使用数据库连接)。这是第一个实现:

func main() {

newWatcher()

// Run the application

}

type watcher struct {

/* Some resources */ }

func newWatcher() {

w := watcher{

}

go w.watch() // ❶

}

❶ 创建了一个监视外部配置的 goroutine

我们调用newWatcher,它创建一个watcher结构,并启动一个负责监视配置的 goroutine。这段代码的问题是,当主 goroutine 退出时(可能是因为 OS 信号或者因为它的工作负载有限),应用就会停止。因此,由watcher创建的资源没有被优雅地关闭。如何才能防止这种情况发生?

一种选择是传递给newWatcher一个当main返回时将被取消的上下文:

func main() {

ctx, cancel := context.WithCancel(context.Background())

defer cancel()

newWatcher(ctx) // ❶

// Run the application

}

func newWatcher(ctx context.Context) {

w := watcher{

}

go w.watch(ctx) // ❷

}

❶ 传递给newWatcher一个最终会取消的上下文

❷ 传播这一上下文

我们将创建的上下文传播给watch方法。当上下文被取消时,watcher结构应该关闭它的资源。然而,我们能保证watch有时间这样做吗?绝对不是——这是一个设计缺陷。

问题是,我们使用信号来传达必须停止 goroutine。直到资源关闭后,我们才阻塞父 goroutine。让我们确保做到:

func main() {

w := newWatcher()

defer w.close() // ❶

// Run the application

}

func newWatcher() watcher {

w := watcher{

}

go w.watch()

return w

}

func (w watcher) close() {

// Close the resources

}

❶ 延迟调用close方法

watcher有了新方法:close。我们现在调用这个close方法,使用defer来保证在应用退出之前关闭资源,而不是用信号通知watcher该关闭它的资源了。

总之,我们要注意的是,goroutine 和任何其他资源一样,最终都必须被关闭以释放内存或其他资源。启动 goroutine 而不知道何时停止是一个设计问题。无论什么时候开始,我们都应该有一个明确的计划,知道它什么时候会停止。最后但同样重要的是,如果一个 goroutine 创建资源,并且它的生命周期与应用的生命周期绑定在一起,那么在退出应用之前等待这个 goroutine 完成可能更安全。这样,我们可以确保释放资源。

现在让我们讨论在 Go 中工作时最常见的错误之一:错误处理 goroutines 和循环变量。

9.3 #63:对 goroutines 和循环变量不够小心

错误处理 goroutines 和循环变量可能是 Go 开发者在编写并发应用时最常犯的错误之一。我们来看一个具体的例子;然后我们将定义这种 bug 的条件以及如何防止它。

在下面的例子中,我们初始化一个切片。然后,在作为新的 goroutine 执行的闭包中,我们访问这个元素:

s := []int{

1, 2, 3}

for _, i := range s {

// ❶

go func() {

fmt.Print(i) // ❷

}()

}

❶ 迭代每个元素

❷ 访问循环变量

我们可能希望这段代码不按特定的顺序打印123(因为不能保证创建的第一个 goroutine 会首先完成)。然而,这段代码的输出是不确定的。比如有时候打印233有时候打印333。原因是什么?

在这个例子中,我们从一个闭包创建新的 goroutines。提醒一下,闭包是一个从其正文外部引用变量的函数值:这里是i变量。我们必须知道,当执行闭包 goroutine 时,它不会捕获创建 goroutine 时的值。相反,所有的 goroutines 都引用完全相同的变量。当一个 goroutine 运行时,它在执行fmt.Print时打印出i的值。因此,i可能在 goroutine 上市后被修改过。

图 9.1 显示了代码打印233时可能的执行情况。随着时间的推移,i的值会发生变化:1、2,然后是3。在每次迭代中,我们都会旋转出一个新的 goroutine。因为不能保证每个 goroutine 什么时候开始和完成,所以结果也会不同。在这个例子中,第一个 goroutine 在i等于2时打印它。然后,当值已经等于3时,其他 goroutines 打印i。因此,本例打印233。这段代码的行为是不确定的。

图 9.1 goroutines 访问一个不固定但随时间变化的i变量。

如果我们想让每个闭包在创建 goroutine 时访问i的值,有什么解决方案?如果我们想继续使用闭包,第一个选项包括创建一个新变量:

for _, i := range s {

val := i // ❶

go func() {

fmt.Print(val)

}()

}

❶ 为每次迭代创建一个局部变量

为什么这段代码会起作用?在每次迭代中,我们创建一个新的局部变量val。该变量在创建 goroutine 之前捕获i的当前值。因此,当每个闭包 goroutine 执行 print 语句时,它会使用预期的值。这段代码打印123(同样,没有特别的顺序)。

第二个选项不再依赖于闭包,而是使用一个实际的函数:

for _, i := range s {

go func(val int) {

// ❶

fmt.Print(val)

}(i) // ❷

}

❶ 执行一个以整数为参数的函数

❷ 调用这个函数并传递i的当前值

我们仍然在新的 goroutine 中执行匿名函数(例如,我们不运行go f(i)),但这一次它不是闭包。该函数没有从其正文外部引用val作为变量;val现在是函数输入的一部分。通过这样做,我们在每次迭代中修正了i,并使我们的应用按预期工作。

我们必须小心 goroutines 和循环变量。如果 goroutine 是一个访问从其正文外部声明的迭代变量的闭包,那就有问题了。我们可以通过创建一个局部变量(例如,我们已经看到在执行 goroutine 之前使用val := i)或者使函数不再是一个闭包来修复它。两种选择都可行,我们不应该偏向其中一种。一些开发人员可能会发现闭包方法更方便,而其他人可能会发现函数方法更具表现力。

在多个通道上使用select语句会发生什么?让我们找出答案。

9.4 #64:使用select和通道预期确定性行为

Go 开发人员在使用通道时犯的一个常见错误是对select如何使用多个通道做出错误的假设。错误的假设会导致难以识别和重现的细微错误。

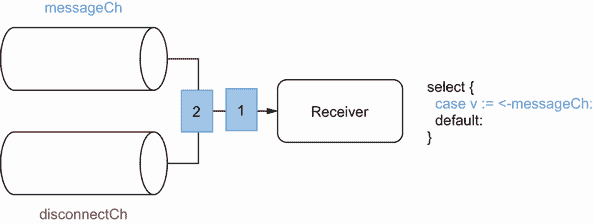

假设我们想要实现一个需要从两个通道接收数据的 goroutine:

-

messageCh为待处理的新消息。 -

disconnectCh接收传达断线的通知。在这种情况下,我们希望从父函数返回。

这两个通道,我们要优先考虑messageCh。例如,如果发生断开连接,我们希望在返回之前确保我们已经收到了所有的消息。

我们可以决定这样处理优先级:

for {

select {

// ❶

case v := <-messageCh: // ❷

fmt.Println(v)

case <-disconnectCh: // ❸

fmt.Println("disconnection, return")

return

}

}

❶ 使用select语句从多个通道接收

❷ 接收新消息

❸ 断开连接

我们使用select从多个通道接收。因为我们想要区分messageCh的优先级,我们可以假设我们应该首先编写messageCh案例,然后是disconnectCh案例。但是这些代码真的有用吗?让我们通过编写一个发送 10 条消息然后发送一个断开通知的伪生产者 goroutine 来尝试一下:

for i := 0; i < 10; i++ {

messageCh <- i

}

disconnectCh <- struct{

}{

}

如果我们运行这个例子,如果messageCh被缓冲,这里是一个可能的输出:

0

1

2

3

4

disconnection, return

我们没有收到这 10 条信息,而是收到了其中的 5 条。原因是什么?它在于规范的多通道的select语句(go.dev/ref/spec):

如果一个或多个通信可以进行,则通过统一的伪随机选择来选择可以进行的单个通信。

与switch语句不同,在语句中,第一个匹配的案例获胜,如果有多个选项,则select语句随机选择。

这种行为乍一看可能很奇怪,但有一个很好的理由:防止可能的饥饿。假设选择的第一个可能的通信是基于源顺序的。在这种情况下,我们可能会陷入这样一种情况,例如,由于发送者速度快,我们只能从一个通道接收。为了防止这种情况,语言设计者决定使用随机选择。

回到我们的例子,即使case v := <-messageCh在源代码顺序中排在第一位,如果messageCh和disconnectCh中都有消息,也不能保证哪种情况会被选中。因此,这个例子的行为是不确定的。我们可能会收到 0 条、5 条或 10 条消息。

如何才能克服这种情况?如果我们想在断线情况下返回之前接收所有消息,有不同的可能性。

如果只有一个制片人,我们有两个选择:

-

使

messageCh成为非缓冲通道,而不是缓冲通道。因为发送方 goroutine 阻塞,直到接收方 goroutine 准备好,所以这种方法保证了在从disconnectCh断开连接之前,接收到来自messageCh的所有消息。 -

用单通道代替双通道。例如,我们可以定义一个

struct来传递一个新消息或者一个断开。通道保证发送消息的顺序与接收消息的顺序相同,因此我们可以确保最后接收到断开连接。

如果我们遇到有多个生产者 goroutines 的情况,可能无法保证哪一个先写。因此,无论我们有一个无缓冲的messageCh通道还是一个单一的通道,都会导致生产者之间的竞争。在这种情况下,我们可以实现以下解决方案:

-

从

messageCh或disconnectCh接收。 -

如果接收到断开连接

- 阅读

messageCh中所有已有的信息,如果有的话。 - 然后返回。

- 阅读

以下是解决方案:

for {

select {

case v := <-messageCh:

fmt.Println(v)

case <-disconnectCh:

for {

// ❶

select {

case v := <-messageCh: // ❷

fmt.Println(v)

default: // ❸

fmt.Println("disconnection, return")

return

}

}

}

}

❶ 内部for/select

❷ 读取剩下的信息

❸ 然后返回

该解决方案使用带有两个外壳的内部for/select:一个在messageCh上,一个在default外壳上。在中使用default,只有当其他情况都不匹配时,才选择select语句。在这种情况下,这意味着我们只有在收到了messageCh中所有剩余的消息后才会返回。

让我们来看一个代码如何工作的例子。我们将考虑这样的情况,在messageCh中有两个消息,在disconnectCh中有一个断开,如图 9.2 所示。

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-BUYOlQ0J-1684395591001)(https://gitcode.net/OpenDocCN/100-go-mistakes-zh/-/raw/master/docs/img/CH09_F02_Harsanyi.png)]

图 9.2 初始状态

在这种情况下,正如我们已经说过的,select随机选择一种情况或另一种情况。假设select选择第二种情况;参见图 9.3。

图 9.3 接收断开连接

因此,我们接收到断开连接并进入内部select(图 9.4)。这里,只要消息还在messageCh中,select将总是优先于default(图 9.5)。

图 9.4 内部select

图 9.5 接收剩余消息

一旦我们收到来自messageCh的所有消息,select不会阻塞并选择default的情况(图 9.6)。因此,我们返回并阻止 goroutine。

图 9.6 默认情况

这是一种确保我们通过多个通道上的接收器从一个通道接收所有剩余消息的方法。当然,如果在 goroutine 返回后发送了一个messageCh(例如,如果我们有多个生产者 goroutine),我们将错过这个消息。

当使用多通道的select时,我们必须记住,如果有多个选项,源顺序中的第一种情况不会自动胜出。相反,Go 随机选择,所以不能保证哪个选项会被选中。为了克服这种行为,在单个生产者 goroutine 的情况下,我们可以使用无缓冲通道或单个通道。在多个生产者 goroutines 的情况下,我们可以使用内部选择和default来处理优先级。

下一节讨论一种常见的通道类型:通知通道。

9.5 #65:不使用通知通道

通道是一种通过信号进行跨例程通信的机制。信号可以有数据,也可以没有数据。但是对于 Go 程序员来说,如何处理后一种情况并不总是那么简单。

我们来看一个具体的例子。我们将创建一个通道,当某个连接断开时,它会通知我们。一种想法是将它作为一个chan bool来处理:

disconnectCh := make(chan bool)

现在,假设我们与一个为我们提供这样一个通道的 API 进行交互。因为这是一个布尔通道,我们可以接收true或false消息。大概很清楚true传达的是什么。但是false是什么意思呢?是不是说明我们没有断线?在这种情况下,我们收到这种信号的频率有多高?是不是意味着我们又重新联系上了?

我们应该期待收到false吗?也许我们应该只期待收到true消息。如果是这样的话,意味着我们不需要特定的值来传达一些信息,我们需要一个没有数据的通道。惯用的处理方式是一个空的结构的通道:chan struct{}。

在 Go 中,空结构是没有任何字段的结构。无论架构如何,它都不占用任何字节的存储空间,我们可以使用unsafe.Sizeof来验证这一点:

var s struct{

}

fmt.Println(unsafe.Sizeof(s))

0

注意为什么不用空接口(var i interface{})?因为空接口不是免费的;它在 32 位架构上占用 8 个字节,在 64 位架构上占用 16 个字节。

一个空的结构是一个事实上的标准来表达没有意义。例如,如果我们需要一个散列集合结构(唯一元素的集合),我们应该使用一个空结构作为值:map[K]struct{}。

应用于通道,如果我们想要创建一个通道来发送没有数据的通知,在 Go 中这样做的合适方法是一个chan struct{}。空结构通道的一个最著名的应用是 Go 上下文,我们将在本章中讨论。

通道可以有数据,也可以没有数据。如果我们想设计一个关于 Go 标准的惯用 API,让我们记住没有数据的通道应该用achan类型来表示。这样,它向接收者阐明了他们不应该从信息的内容中期待任何意义——仅仅是他们已经收到信息的事实。在 Go 中,这样的通道称为通知通道。

下一节将讨论 Go 如何处理nil通道以及使用它们的基本原理。

9.6 #66:不使用nil通道

在使用 Go 和通道时,一个常见的错误是忘记了nil通道有时是有帮助的。那么什么是nil通道,我们为什么要关心它们呢?这是本节的范围。

让我们从创建一个nil通道并等待接收消息的 goroutine 开始。这段代码应该做什么?

var ch chan int // ❶

<-ch

❶ nil通道

ch是chan int型。通道的零值为零,ch为nil。goroutine 不会惊慌;但是,会永远屏蔽。

如果我们向nil通道发送消息,原理是相同的。这条路永远不通:

var ch chan int

ch <- 0

那么 Go 允许从nil通道接收消息或者向nil通道发送消息的目的是什么呢?我们将用一个具体的例子来讨论这个问题。

我们将实现一个func merge(ch1, ch2 <-chan int) <-chan int函数来将两个通道合并成一个通道。通过合并它们(参见图 9.7),我们的意思是在ch1或ch2中接收的每个消息都将被发送到返回的通道。

图 9.7 将两个通道合并为一个

在GO中如何做到这一点?让我们首先编写一个简单的实现,它启动一个 goroutine 并从两个通道接收数据(得到的通道将是一个包含一个元素的缓冲通道):

func merge(ch1, ch2 <-chan int) <-chan int {

ch := make(chan int, 1)

go func() {

for v := range ch1 {

// ❶

ch <- v

}

for v := range ch2 {

// ❷

ch <- v

}

close(ch)

}()

return ch

}

❶ 从ch1接收并发布到合并的通道

❷ 从ch2接收并发布到合并的通道

在另一个 goroutine 中,我们从两个通道接收信息,每条信息最终都在ch中发布。

这个第一个版本的主要问题是我们从ch1接收,然后从ch2接收。这意味着在ch1关闭之前,我们不会收到来自ch2的信息。这不符合我们的用例,因为ch1可能会永远打开,所以我们希望同时从两个通道接收。

让我们使用select编写一个带有并发接收者的改进版本:

func merge(ch1, ch2 <-chan int) <-chan int {

ch := make(chan int, 1)

go func() {

for {

select {

// ❶

case v := <-ch1:

ch <- v

case v := <-ch2:

ch <- v

}

}

close(ch)

}()

return ch

}

❶ 同时接收ch1和ch2

select语句让一个 goroutine 同时等待多个操作。因为我们将它包装在一个for循环中,所以我们应该重复地从一个或另一个通道接收消息,对吗?但是这些代码真的有用吗?

一个问题是close(ch)语句是不可达的。当通道关闭时,使用range操作符在通道上循环中断。然而,当ch1或ch2关闭时,我们实现for / select的方式并不适用。更糟糕的是,如果在某个点ch1或ch2关闭,当记录值时,合并通道的接收器将接收到以下内容:

received: 0

received: 0

received: 0

received: 0

received: 0

...

所以接收器会重复接收一个等于零的整数。为什么?从封闭通道接收是一种非阻塞操作:

ch1 := make(chan int)

close(ch1)

fmt.Print(<-ch1, <-ch1)

尽管我们可能认为这段代码会恐慌或阻塞,但是它会运行并打印出0 0。我们在这里捕获的是闭包事件,而不是实际的消息。要检查我们是否收到消息或结束信号,我们必须这样做:

ch1 := make(chan int)

close(ch1)

v, open := <-ch1 // ❶

fmt.Print(v, open)

无论通道是否打开,❶都会指定打开

使用open布尔值,我们现在可以看到ch1是否仍然打开:

0 false

同时,我们也将0赋给v,因为它是一个整数的零值。

让我们回到我们的第二个解决方案。我们说ch1关了不太好用;例如,因为select案例是case v := <-ch1,所以我们会一直输入这个案例,并向合并后的通道发布一个零整数。

让我们后退一步,看看处理这个问题的最佳方法是什么(见图 9.8)。我们必须从两个通道接收。那么,要么

-

的

ch1是先关闭的,所以我们要从ch2开始接收,直到它关闭。 -

ch2先关闭,所以我们要从ch1接收,直到它关闭。

图 9.8 根据先关闭ch1还是先关闭ch2来处理不同情况

如何在 Go 中实现这一点?让我们编写一个版本,就像我们可能使用状态机方法和布尔函数所做的那样:

func merge(ch1, ch2 <-chan int) <-chan int {

ch := make(chan int, 1)

ch1Closed := false

ch2Closed := false

go func() {

for {

select {

case v, open := <-ch1:

if !open {

// ❶

ch1Closed = true

break

}

ch <- v

case v, open := <-ch2:

if !open {

// ❷

ch2Closed = true

break

}

ch <- v

}

if ch1Closed && ch2Closed {

// ❸

close(ch)

return

}

}

}()

return ch

}

❶ 处理ch1是否关闭

❷ 处理ch2是否关闭

❸ 如果两个通道都关闭,将关闭ch并返回

我们定义了两个布尔值ch1Closed和ch2Closed。一旦我们从一个通道接收到一个消息,我们就检查它是否是一个关闭信号。如果是,我们通过将通道标记为关闭来处理(例如,ch1Closed = true)。两个通道都关闭后,我们关闭合并的通道并停止 goroutine。

这段代码除了开始变得复杂之外,还有什么问题呢?有一个主要问题:当两个通道中的一个关闭时,for循环将充当一个忙等待循环,这意味着即使在另一个通道中没有接收到新消息,它也将继续循环。在我们的例子中,我们必须记住语句的行为。假设ch1关闭(所以我们在这里不会收到任何新消息);当我们再次到达select时,它将等待以下三个条件之一发生:

-

ch1关闭。 -

ch2有新消息。 -

ch2关闭。

第一个条件ch1是关闭的,将永远有效。因此,只要我们在ch2中没有收到消息,并且这个通道没有关闭,我们将继续循环第一个案例。这将导致浪费 CPU 周期,必须避免。因此,我们的解决方案不可行。

我们可以尝试增强状态机部分,并在每种情况下实现子for/select循环。但是这将使我们的代码更加复杂和难以理解。

是时候回到nil通道了。正如我们提到的,从nil通道接收将永远阻塞。在我们的解决方案中使用这个想法怎么样?我们将把这个通道赋值为nil,而不是在一个通道关闭后设置一个布尔值。让我们写出最终版本:

func merge(ch1, ch2 <-chan int) <-chan int {

ch := make(chan int, 1)

go func() {

for ch1 != nil || ch2 != nil {

// ❶

select {

case v, open := <-ch1:

if !open {

ch1 = nil // ❷

break

}

ch <- v

case v, open := <-ch2:

if !open {

ch2 = nil // ❸

break

}

ch <- v

}

}

close(ch)

}()

return ch

}

❶ 如果至少有一个通道不为nil,将继续

❷一旦关闭,将nil通道分配给ch1

❷一旦关闭,将nil通道分配给ch2

首先,只要至少一个通道仍然打开,我们就循环。然后,例如,如果ch1关闭,我们将ch1赋值为零。因此,在下一次循环迭代期间,select语句将只等待两个条件:

-

ch2有新消息。 -

ch2关闭。

ch1不再是等式的一部分,因为它是一个nil通道。同时,我们为ch2保留相同的逻辑,并在它关闭后将其赋值为nil。最后,当两个通道都关闭时,我们关闭合并的通道并返回。图 9.9 显示了这种实现的模型。

图 9.9 从两个通道接收。如果一个是关闭的,我们把它赋值为 0,这样我们只从一个通道接收。

这是我们一直在等待的实现。我们涵盖了所有不同的情况,并且不需要会浪费 CPU 周期的繁忙循环。

总之,我们已经看到,等待或发送到一个nil通道是一个阻塞行为,这种行为是有用的。正如我们在合并两个通道的例子中所看到的,我们可以使用nil通道来实现一个优雅的状态机,该状态机将从一个select语句中移除一个case。让我们记住这个想法:nil通道在某些情况下是有用的,在处理并发代码时应该成为 Go 开发者工具集的一部分。

在下一节中,我们将讨论创建通道时应设置的大小。

9.7 #67:对通道大小感到困惑

当我们使用make内置函数创建通道时,通道可以是无缓冲的,也可以是缓冲的。与这个话题相关,有两个错误经常发生:不知道什么时候使用这个或那个;如果我们使用缓冲通道,应该使用多大的缓冲通道。让我们检查一下这几点。

首先,让我们记住核心概念。无缓冲通道是没有任何容量的通道*。它可以通过省略尺寸或提供一个0尺寸来创建:*

ch1 := make(chan int)

ch2 := make(chan int, 0)

使用无缓冲通道(有时称为同步通道),发送方将阻塞,直到接收方从该通道接收到数据。

相反,缓冲通道有容量,必须创建大于或等于1的大小:

ch3 := make(chan int, 1)

使用缓冲通道,发送方可以在通道未满时发送消息。一旦通道满了,它就会阻塞,直到接收者或路由器收到消息。例如:

ch3 := make(chan int, 1)

ch3 <-1 // ❶

ch3 <-2 // ❷

❶ 无阻塞

❷ 阻塞

第一个发送没有阻塞,而第二个阻塞了,因为这个阶段通道已满。

让我们后退一步,讨论这两种通道类型之间的根本区别。通道是一种并发抽象,用于支持 goroutines 之间的通信。但是同步呢?在并发中,同步意味着我们可以保证多个 goroutines 在某个时刻处于已知状态。例如,互斥锁提供同步,因为它确保同一时间只有一个 goroutine 在临界区。关于通道:

-

无缓冲通道支持同步。我们保证两个 goroutines 将处于已知状态:一个接收消息,另一个发送消息。

-

缓冲通道不提供任何强同步。事实上,如果通道未满,生产者 goroutine 可以发送消息,然后继续执行。唯一的保证是 goroutine 在消息发送之前不会收到消息。但这只是一个保证,因为因果关系(你不喝你的咖啡之前,你准备好了)。

牢记这一基本区别至关重要。两种通道类型都支持通信,但只有一种提供同步。如果我们需要同步,我们必须使用无缓冲通道。无缓冲通道也可能更容易推理:缓冲通道可能会导致不明显的死锁,而无缓冲通道会立即显现出来。

在其他情况下,无缓冲通道更可取:例如,在通知通道的情况下,通知是通过通道关闭(close(ch))来处理的。这里,使用缓冲通道不会带来任何好处。

但是如果我们需要一个缓冲通道呢?我们应该提供多大的尺寸?我们应该为缓冲通道使用的默认值是它的最小值:1。因此,我们可以从这个角度来处理这个问题:有什么好的理由不使用1的值吗?这里列出了我们应该使用另一种尺寸的可能情况:

-

使用类似工作器池的模式,意味着旋转固定数量的 goroutines,这些 goroutines 需要将数据发送到共享通道。在这种情况下,我们可以将通道大小与创建的 goroutines 的数量联系起来。

-

使用通道进行限速问题时。例如,如果我们需要通过限制请求数量来加强资源利用率,我们应该根据限制来设置通道大小。

如果我们在这些情况之外,使用不同的通道尺寸应该谨慎。使用幻数设置通道大小的代码库非常常见:

ch := make(chan int, 40)

为什么是40?有什么道理?为什么不是50甚至1000?设置这样的值应该有充分的理由。也许这是在基准测试或性能测试之后决定的。在许多情况下,对这样一个值的基本原理进行注释可能是一个好主意。

让我们记住,决定一个准确的队列大小并不是一个简单的问题。首先,这是 CPU 和内存之间的平衡。值越小,我们面临的 CPU 争用就越多。但是值越大,需要分配的内存就越多。

另一个需要考虑的问题是 2011 年关于 LMAX Disruptor 的白皮书中提到的问题(马丁·汤普森等人; lmax-exchange.github.io/disruptor/files/Disruptor-1.0.pdf ):

由于消费者和生产者之间的速度差异,队列通常总是接近满或接近空。他们很少在一个平衡的中间地带运作,在那里生产和消费的比率是势均力敌的。

因此,很难找到一个稳定准确的通道大小,这意味着一个不会导致太多争用或内存分配浪费的准确值。

这就是为什么,除了所描述的情况,通常最好从默认的通道大小1开始。例如,当不确定时,我们仍然可以使用基准来度量它。

与编程中的几乎任何主题一样,可以发现异常。因此,这一节的目标不是详尽无遗,而是给出创建通道时应该使用什么尺寸的指导。同步是无缓冲通道而非缓冲通道的保证。此外,如果我们需要一个缓冲通道,我们应该记住使用一个作为通道大小的默认值。我们应该通过精确的过程谨慎地决定使用另一个值,并且应该对基本原理进行注释。最后但并非最不重要的一点是,我们要记住,选择缓冲通道也可能导致不明显的死锁,而使用无缓冲通道更容易发现这种死锁。

在下一节中,我们将讨论处理字符串格式时可能出现的副作用。

9.8 #68:忘记字符串格式化可能带来的副作用

格式化字符串是开发者的常用操作,无论是返回错误还是记录消息。然而,在并发应用中工作时,很容易忘记字符串格式的潜在副作用。本节将看到两个具体的例子:一个来自 etcd 存储库,导致数据竞争,另一个导致死锁情况。

9.8.1 etcd 数据竞争

etcd 是在 Go 中实现的分布式键值存储。它被用于许多项目,包括 Kubernetes,来存储所有的集群数据。它提供了与集群交互的 API。例如,Watcher接口用于接收数据变更通知:

type Watcher interface {

// Watch watches on a key or prefix. The watched events will be returned

// through the returned channel.

// ...

Watch(ctx context.Context, key string, opts ...OpOption) WatchChan

Close() error

}

API 依赖于 gRPC 流。如果你不熟悉它,它是一种在客户机和服务器之间不断交换数据的技术。服务器必须维护使用该函数的所有客户端的列表。因此,Watcher接口由包含所有活动流的watcher结构实现:

type watcher struct {

// ...

// streams hold all the active gRPC streams keyed by ctx value.

streams map[string]*watchGrpcStream

}

该映射的键基于调用Watch方法时提供的上下文:

func (w *watcher) Watch(ctx context.Context, key string,

opts ...OpOption) WatchChan {

// ...

ctxKey := fmt.Sprintf("%v", ctx) // ❶

// ...

wgs := w.streams[ctxKey]

// ...

❶ 根据提供的上下文格式化映射键

ctxKey是映射的键,由客户端提供的上下文格式化。当格式化由值(context.WithValue)创建的上下文中的字符串时,Go 将读取该上下文中的所有值。在这种情况下,etcd 开发人员发现提供给Watch的上下文在某些条件下是包含可变值(例如,指向结构的指针)的上下文。他们发现了一种情况,其中一个 goroutine 正在更新一个上下文值,而另一个正在执行Watch,因此读取这个上下文中的所有值。这导致了一场数据竞争。

修复(github.com/etcd-io/etcd/pull/7816)是不依赖fmt.Sprintf来格式化映射的键,以防止遍历和读取上下文中的包装值链。相反,解决方案是实现一个定制的streamKeyFromCtx函数,从特定的不可变的上下文值中提取键。

注意:上下文中潜在的可变值会引入额外的复杂性,以防止数据竞争。这可能是一个需要仔细考虑的设计决策。

这个例子说明了我们必须小心并发应用中字符串格式化的副作用——在这个例子中,是数据竞争。在下面的例子中,我们将看到导致死锁情况的副作用。

9.8.2 死锁

假设我们必须处理一个可以并发访问的Customer结构。我们将使用sync.RWMutex来保护访问,无论是读还是写。我们将实现一个UpdateAge方法来更新客户的年龄,并检查年龄是否为正数。同时,我们将实现和Stringer接口。

你能看出这段代码中的问题是什么吗?一个Customer结构公开了一个UpdateAge方法,而实现了fmt.Stringer接口。

type Customer struct {

mutex sync.RWMutex // ❶

id string

age int

}

func (c *Customer) UpdateAge(age int) error {

c.mutex.Lock() // ❷

defer c.mutex.Unlock()

if age < 0 {

// ❸

return fmt.Errorf("age should be positive for customer %v", c)

}

c.age = age

return nil

}

func (c *Customer) String() string {

c.mutex.RLock() // ❹

defer c.mutex.RUnlock()

return fmt.Sprintf("id %s, age %d", c.id, c.age)

}

❶ 使用sync.RWMutex保护并发访问

❷ 锁定并延迟解锁,因为我们更新客户

❸ 如果年龄为负,将返回错误

❹ 锁定和延迟解锁,因为我们读取客户

这里的问题可能并不简单。如果提供的age是负的,我们返回一个错误。因为错误被格式化了,使用接收者上的%s指令,它将调用String方法来格式化Customer。但是因为UpdateAge已经获得了互斥锁,所以String方法将无法获得互斥锁(见图 9.10)。

图 9.10 如果age为负,执行UpdateAge

因此,这会导致死锁情况。如果所有的 goroutines 也睡着了,就会导致恐慌:

fatal error: all goroutines are asleep - deadlock!

goroutine 1 [semacquire]:

sync.runtime_SemacquireMutex(0xc00009818c, 0x10b7d00, 0x0)

...

这种情况应该怎么处理?首先,它说明了单元测试的重要性。在这种情况下,我们可能会认为创建一个负年龄的测试是不值得的,因为逻辑非常简单。然而,没有适当的测试覆盖,我们可能会错过这个问题。

这里可以改进的一点是限制互斥锁的范围。在UpdateAge中,我们首先获取锁并检查输入是否有效。我们应该反其道而行之:首先检查输入,如果输入有效,就获取锁。这有利于减少潜在的副作用,但也会对性能产生影响——仅在需要时才获取锁,而不是在此之前:

func (c *Customer) UpdateAge(age int) error {

if age < 0 {

return fmt.Errorf("age should be positive for customer %v", c)

}

c.mutex.Lock() // ❶

defer c.mutex.Unlock()

c.age = age

return nil

}

只有当输入被验证后,❶才会锁定互斥体

在我们的例子中,只有在检查了年龄之后才锁定互斥体可以避免死锁情况。如果年龄为负,则调用String而不事先锁定互斥体。

但是,在某些情况下,限制互斥锁的范围并不简单,也不可能。在这种情况下,我们必须非常小心字符串格式。也许我们想调用另一个不试图获取互斥体的函数,或者我们只想改变我们格式化错误的方式,这样它就不会调用的String方法。例如,下面的代码不会导致死锁,因为我们只在直接访问id字段时记录客户 ID:

func (c *Customer) UpdateAge(age int) error {

c.mutex.Lock()

defer c.mutex.Unlock()

if age < 0 {

return fmt.Errorf("age should be positive for customer id %s", c.id)

}

c.age = age

return nil

}

我们已经看到了两个具体的例子,一个格式化上下文中的键,另一个返回格式化结构的错误。在这两种情况下,格式化字符串都会导致一个问题:数据竞争和死锁情况。因此,在并发应用中,我们应该对字符串格式化可能产生的副作用保持谨慎。

下一节讨论并发调用append时的行为。

9.9 #69:使用append创建数据竞争

我们之前提到过什么是数据竞争,有哪些影响。现在,让我们看看片,以及使用append向片添加元素是否是无数据竞争的。剧透?看情况。

在下面的例子中,我们将初始化一个切片并创建两个 goroutines,这两个 goroutines 将使用append创建一个带有附加元素的新切片:

s := make([]int, 1)

go func() {

// ❶

s1 := append(s, 1)

fmt.Println(s1)

}()

go func() {

// ❷

s2 := append(s, 1)

fmt.Println(s2)

}()

❶ 在一个新的 goroutine 中,在s上追加了一个新元素

❷ 相同

你相信这个例子有数据竞争吗?答案是否定的。

我们必须回忆一下第 3 章中描述的一些切片基础知识。切片由数组支持,有两个属性:长度和容量。长度是切片中可用元素的数量,而容量是后备数组中元素的总数。当我们使用append时,行为取决于切片是否已满(长度==容量)。如果是,Go 运行时创建一个新的后备数组来添加新元素;否则,运行库会将其添加到现有的后备数组中。

在这个例子中,我们用make([]int, 1)创建一个切片。该代码创建一个长度为一、容量为一的切片。因此,因为切片已满,所以在每个 goroutine 中使用append会返回一个由新数组支持的切片。它不会改变现有的数组;因此,它不会导致数据竞争。

现在,让我们运行同一个例子,只是在初始化s的方式上稍作改变。我们不是创建长度为1的切片,而是创建长度为0但容量为1的切片:

s := make([]int, 0, 1) // ❶

// Same

❶ 改变了切片初始化的方式

这个新例子怎么样?是否包含数据竞争?答案是肯定的:

==================

WARNING: DATA RACE

Write at 0x00c00009e080 by goroutine 10:

...

Previous write at 0x00c00009e080 by goroutine 9:

...

==================

我们用make([]int, 0, 1)创建一个切片。因此,数组没有满。两个 goroutines 都试图更新后备数组的同一个索引(索引 1),这是一种数据竞争。

如果我们希望两个 goroutines 都在一个包含初始元素s和一个额外元素的片上工作,我们如何防止数据竞争?一种解决方案是创建s的副本:

s := make([]int, 0, 1)

go func() {

sCopy := make([]int, len(s), cap(s))

copy(sCopy, s) // ❶

s1 := append(sCopy, 1)

fmt.Println(s1)

}()

go func() {

sCopy := make([]int, len(s), cap(s))

copy(sCopy, s) // ❷

s2 := append(sCopy, 1)

fmt.Println(s2)

}()

❶ 制作了一个副本,并在拷贝的切片上使用了append

❷ 相同

两个 goroutines 都会制作切片的副本。然后他们在切片副本上使用append,而不是原始切片。这防止了数据竞争,因为两个 goroutines 都处理孤立的数据。

切片和映射的数据竞争

数据竞争对切片和映射的影响有多大?当我们有多个 goroutines 时,以下为真:

-

用至少一个 goroutine 更新值来访问同一个片索引是一种数据竞争。goroutines 访问相同的内存位置。

-

不管操作如何,访问不同的片索引不是数据竞争;不同的索引意味着不同的内存位置。

-

用至少一个 goroutine 更新来访问同一个映射(不管它是相同的还是不同的键)是一种数据竞争。为什么这与切片数据结构不同?正如我们在第 3 章中提到的,映射是一个桶数组,每个桶是一个指向键值对数组的指针。哈希算法用于确定桶的数组索引。因为该算法在映射初始化期间包含一些随机性,所以一次执行可能导致相同的数组索引,而另一次执行可能不会。竞争检测器通过发出警告来处理这种情况,而不管实际的数据竞争是否发生。

当在并发上下文中使用片时,我们必须记住在片上使用append并不总是无竞争的。根据切片以及切片是否已满,行为会发生变化。如果切片已满,append是无竞争的。否则,多个 goroutines 可能会竞争更新同一个数组索引,从而导致数据竞争。

一般来说,我们不应该根据片是否已满而有不同的实现。我们应该考虑到在并发应用中的共享片上使用append会导致数据竞争。因此,应该避免使用它。

现在,让我们讨论一个切片和映射上不精确互斥锁的常见错误。

9.10 #70:对切片和映射不正确地使用互斥

在数据可变和共享的并发环境中工作时,我们经常需要使用互斥体来实现对数据结构的保护访问。一个常见的错误是在处理切片和贴图时不准确地使用互斥。让我们看一个具体的例子,了解潜在的问题。

我们将实现一个用于处理客户余额缓存的Cache结构。该结构将包含每个客户 ID 的余额映射和一个互斥体,以保护并发访问:

type Cache struct {

mu sync.RWMutex

balances map[string]float64

}

注意这个解决方案使用一个sync.RWMutex来允许多个读者,只要没有作者。

接下来,我们添加一个AddBalance方法来改变balances图。改变是在一个临界区中完成的(在互斥锁和互斥解锁内):

func (c *Cache) AddBalance(id string, balance float64) {

c.mu.Lock()

c.balances[id] = balance

c.mu.Unlock()

}

同时,我们必须实现一个方法来计算所有客户的平均余额。一种想法是这样处理最小临界区:

func (c *Cache) AverageBalance() float64 {

c.mu.RLock()

balances := c.balances // ❶

c.mu.RUnlock()

sum := 0.

for _, balance := range balances {

// ❷

sum += balance

}

return sum / float64(len(balances))

}

❶ 创建了balances的副本

❷ 在临界区之外迭代副本

首先,我们创建一个映射到本地balances变量的副本。仅在临界区中进行复制,以迭代每个余额,并计算临界区之外的平均值。这个解决方案有效吗?

如果我们使用带有两个并发 goroutines 的-race标志运行测试,一个调用AddBalance(因此改变balances),另一个调用AverageBalance,就会发生数据竞争。这里有什么问题?

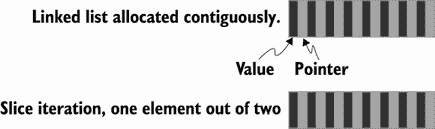

在内部,映射是一个runtime.hmap结构,主要包含元数据(例如,计数器)和引用数据桶的指针。所以,balances := c.balances不会复制实际的数据。切片也是同样的原理:

s1 := []int{

1, 2, 3}

s2 := s1

s2[0] = 42

fmt.Println(s1)

即使我们修改了s2,打印s1也会返回[42 2 3]。原因是s2 := s1创建了一个新的切片:s2与s1有相同的长度和相同的容量,并由相同的数组支持。

回到我们的例子,我们给balances分配一个新的映射,引用与c.balances相同的数据桶。同时,两个 goroutines 对同一个数据集执行操作,其中一个对它进行了改变。因此,这是一场数据竞争。我们如何解决数据竞争?我们有两个选择。

如果迭代操作并不繁重(这里就是这种情况,因为我们执行增量操作),我们应该保护整个函数:

func (c *Cache) AverageBalance() float64 {

c.mu.RLock()

defer c.mu.RUnlock() // ❶

sum := 0.

for _, balance := range c.balances {

sum += balance

}

return sum / float64(len(c.balances))

}

函数返回时,❶解锁

临界区现在包含了整个函数,包括迭代。这可以防止数据竞争。

如果迭代操作不是轻量级的,另一个选择是处理数据的实际副本,并且只保护副本:

func (c *Cache) AverageBalance() float64 {

c.mu.RLock()

m := make(map[string]float64, len(c.balances)) // ❶

for k, v := range c.balances {

m[k] = v

}

c.mu.RUnlock()

sum := 0.

for _, balance := range m {

sum += balance

}

return sum / float64(len(m))

}

❶ 复制了这个映射

一旦我们完成了深层拷贝,我们就释放互斥体。迭代是在临界区之外的副本上完成的。

让我们考虑一下这个解决方案。我们必须在映射值上迭代两次:一次是复制,一次是执行操作(这里是增量)。但关键部分只是映射副本。因此,当且仅当操作不是快速时,这种解决方案可能是一个很好的选择。例如,如果一个操作需要调用外部数据库,这个解决方案可能会更有效。在选择一个解决方案或另一个解决方案时,不可能定义一个阈值,因为选择取决于元素数量和结构的平均大小等因素。

总之,我们必须小心互斥锁的边界。在本节中,我们已经看到了为什么将一个现有的映射(或一个现有的片)分配给一个映射不足以防止数据竞争。无论是映射还是切片,新变量都由相同的数据集支持。有两种主要的解决方案可以防止这种情况:保护整个函数,或者处理实际数据的副本。在所有情况下,让我们在设计临界截面时保持谨慎,并确保准确定义边界。

现在让我们讨论一下使用sync.WaitGroup时的一个常见错误。

9.11 #71:误用sync.WaitGroup

sync.WaitGroup是一种等待n操作完成的机制;通常,我们使用它来等待ngoroutines 完成。我们先回忆一下公开的 API 然后,我们将看到一个导致非确定性行为的常见错误。

可以用零值sync.WaitGroup创建一个等待组:

wg := sync.WaitGroup{

}

在内部,sync.WaitGroup保存默认初始化为0的内部计数器。我们可以使用Add(int)方法递增这个计数器,使用带有负值的Done()或Add递减它。如果我们想等待计数器等于0,我们必须使用阻塞的Wait()方法。

注意计数器不能为负,否则 goroutine 将会恐慌。

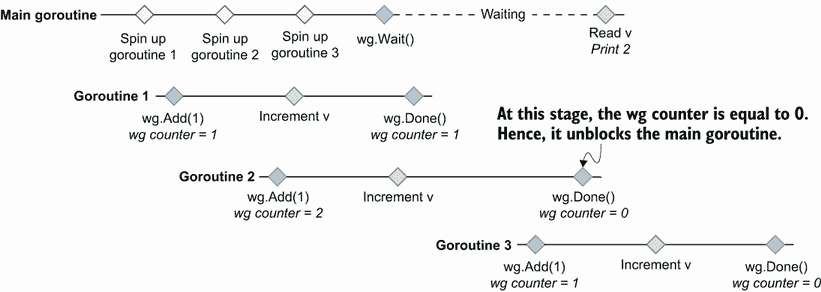

在下面的例子中,我们将初始化一个等待组,启动三个自动更新计数器的 goroutines,然后等待它们完成。我们希望等待这三个 goroutines 打印计数器的值(应该是3)。你能猜出这段代码是否有问题吗?

wg := sync.WaitGroup{

}

var v uint64

for i := 0; i < 3; i++ {

go func() {

// ❶

wg.Add(1) // ❷

atomic.AddUint64(&v, 1) // ❸

wg.Done() // ❹

}()

}

wg.Wait() // ❺

fmt.Println(v)

❶ 创建了一个 goroutine

❷ 递增等待组计数器

❸ 原子地递增v

❹ 递减等待组计数器

❺ 一直等到所有的 goroutines 都递增了v才打印它

如果我们运行这个例子,我们会得到一个不确定的值:代码可以打印从0到3的任何值。同样,如果我们启用了-race标志,Go 甚至会发生数据竞争。考虑到我们正在使用sync/atomic包来更新v,这怎么可能呢?这个代码有什么问题?

问题是wg.Add(1)是在新创建的 goroutine 中调用的,而不是在父 goroutine 中。因此,不能保证我们已经向等待组表明我们想在调用wg.Wait()之前等待三次 goroutines。

图 9.11 显示了代码打印2时的可能场景。在这个场景中,主 goroutine 旋转了三个 goroutine。但是最后一个 goroutine 是在前两个 goroutine 已经调用了wg.Done()之后执行的,所以父 goroutine 已经解锁。因此,在这种情况下,当主 goroutine 读取v时,它等于2。竞争检测器还可以检测对v的不安全访问。

图 9.11 主 goroutine 已经解封后,最后一个 goroutine 调用wg.Add(1)。

在处理 goroutines 时,关键是要记住,没有同步,执行是不确定的。例如,以下代码可以打印ab或ba:

go func() {

fmt.Print("a")

}()

go func() {

fmt.Print("b")

}()

两个 goroutines 都可以分配给不同的线程,不能保证哪个线程会先被执行。

CPU 有来使用内存屏障(也称为内存屏障)来确保顺序。Go 为实现内存栅栏提供了不同的同步技术:例如,sync.WaitGroup支持wg.Add和wg.Wait之间的先发生关系。

回到我们的例子,有两个选项来解决我们的问题。首先,我们可以用 3:

wg := sync.WaitGroup{

}

var v uint64

wg.Add(3)

for i := 0; i < 3; i++ {

go func() {

// ...

}()

}

// ...

或者,第二,我们可以在每次循环迭代中调用wg.Add,然后旋转子 goroutines:

wg := sync.WaitGroup{

}

var v uint64

for i := 0; i < 3; i++ {

wg.Add(1)

go func() {

// ...

}()

}

// ...

两种解决方案都可以。如果我们想要最终设置给等待组计数器的值是预先知道的,那么第一个解决方案可以避免我们不得不多次调用wg.Add。然而,它需要确保在任何地方都使用相同的计数,以避免细微的错误。

让我们小心不要重现这种GO开发者常犯的错误。使用sync.WaitGroup时,Add操作必须在父 goroutine 中启动 goroutine 之前完成,而Done操作必须在 goroutine 中完成。

下面讨论的另一个原语sync包:sync.Cond。

9.12 #72:忘记sync.Cond

在sync包中的同步原语中,sync.Cond可能是使用和理解最少的。但是,它提供了我们用通道无法实现的功能。本节通过一个具体的例子来说明sync.Cond何时有用以及如何使用。

本节中的示例实现了一个捐赠目标机制:一个每当达到特定目标时就会发出警报的应用。我们将有一个 goroutine 负责增加余额(一个更新器 goroutine)。相反,其他 goroutines 将接收更新,并在达到特定目标时打印一条消息(监听 goroutines)。例如,一个 goroutine 正在等待 10 美元的捐赠目标,而另一个正在等待 15 美元的捐赠目标。

第一个简单的解决方案是使用互斥。更新程序 goroutine 每秒增加一次余额。另一方面,监听 goroutines 循环,直到达到它们的捐赠目标:

type Donation struct {

// ❶

mu sync.RWMutex

balance int

}

donation := &Donation{

}

// Listener goroutines

f := func(goal int) {

// ❷

donation.mu.RLock()

for donation.balance < goal {

// ❸

donation.mu.RUnlock()

donation.mu.RLock()

}

fmt.Printf("$%d goal reached\n", donation.balance)

donation.mu.RUnlock()

}

go f(10)

go f(15)

// Updater goroutine

go func() {

for {

// ❹

time.Sleep(time.Second)

donation.mu.Lock()

donation.balance++

donation.mu.Unlock()

}

}()

❶ 创建并实例化包含当前余额和互斥体的Donation结构

❷ 创建了一个目标

❸ 检查目标是否达到

❹ 不断增加余额

我们使用互斥来保护对共享的donation.balance变量的访问。如果我们运行这个示例,它会像预期的那样工作:

$10 goal reached

$15 goal reached

主要问题——也是使这种实现变得糟糕的原因——是繁忙循环。每个监听 goroutine 一直循环,直到达到它的捐赠目标,这浪费了大量的 CPU 周期,并使 CPU 的使用量巨大。我们需要找到一个更好的解决方案。

让我们后退一步。每当平衡被更新时,我们必须找到一种方法从更新程序发出信号。如果我们考虑GO中的信令,就要考虑通道。因此,让我们尝试使用通道原语的另一个版本:

type Donation struct {

balance int

ch chan int // ❶

}

donation := &Donation{

ch: make(chan int)}

// Listener goroutines

f := func(goal int) {

for balance := range donation.ch {

// ❷

if balance >= goal {

fmt.Printf("$%d goal reached\n", balance)

return

}

}

}

go f(10)

go f(15)

// Updater goroutine

for {

time.Sleep(time.Second)

donation.balance++

donation.ch <- donation.balance // ❸

}

❶ 更新Donation,所以它包含一个通道

❷ 从通道接收更新

❸ 每当余额更新时,都会发送一条消息

每个监听程序从一个共享的通道接收。与此同时,每当余额更新时,更新程序 goroutine 就会发送消息。但是,如果我们尝试一下这个解决方案,下面是一个可能的输出:

$11 goal reached

$15 goal reached

当余额为 10 美元而不是 11 美元时,应该通知第一个 goroutine。发生了什么事?

发送到通道的消息只能由一个 goroutine 接收。在我们的例子中,如果第一个 goroutine 在第二个之前从通道接收,图 9.12 显示了可能发生的情况。

图 9.12 第一个 goroutine 接收$1 消息,然后第二个 goroutine 接收$2 消息,然后第一个 goroutine 接收$3 消息,依此类推。

从共享通道接收多个 goroutines 的默认分发模式是循环调度。如果一个 goroutine 没有准备好接收消息(没有在通道上处于等待状态),它可能会改变;在这种情况下,Go 将消息分发到下一个可用的 goroutine。

每条消息都由一个单独的 goroutine 接收。因此,在这个例子中,第一个 goroutine 没有收到 10 美元消息,但是第二个收到了。只有一个通道关闭事件可以广播到多个 goroutines。但是这里我们不想关闭通道,因为那样的话更新程序 goroutine 就不能发送消息了。

在这种情况下使用通道还有另一个问题。只要达到了捐赠目标,监听器就会回来。因此,更新程序 goroutine 必须知道所有监听器何时停止接收到该通道的消息。否则,通道最终会变满,阻塞发送方。一个可能的解决方案是在组合中添加一个sync.WaitGroup,但是这样做会使解决方案更加复杂。

理想情况下,我们需要找到一种方法,每当余额更新到多个 goroutines 时,重复广播通知。好在 Go 有解:sync.Cond。我们先讨论理论;然后我们将看到如何使用这个原语解决我们的问题。

根据官方文档(pkg.go.dev/sync),

Cond 实现了一个条件变量,即等待或宣布事件发生的 goroutines 的集合点。

条件变量是等待特定条件的线程(这里是 goroutines)的容器。在我们的例子中,条件是余额更新。每当余额更新时,更新程序 gorroutine 就会广播一个通知,监听程序 gorroutine 会一直等到更新。此外,sync.Cond依靠一个sync.Locker(一个*sync .Mutex或*sync.RWMutex)来防止数据竞争。下面是一个可能的实现:

type Donation struct {

cond *sync.Cond // ❶

balance int

}

donation := &Donation{

cond: sync.NewCond(&sync.Mutex{

}), // ❷

}

// Listener goroutines

f := func(goal int) {

donation.cond.L.Lock()

for donation.balance < goal {

donation.cond.Wait() // ❸

}

fmt.Printf("%d$ goal reached\n", donation.balance)

donation.cond.L.Unlock()

}

go f(10)

go f(15)

// Updater goroutine

for {

time.Sleep(time.Second)

donation.cond.L.Lock()

donation.balance++ // ❹

donation.cond.L.Unlock()

donation.cond.Broadcast() // ❺

}

❶ 添加一个*sync.Cond

❷ *sync.Cond依赖于互斥体。

❸ 在锁定/解锁状态下等待条件(余额更新)

❹ 在锁定/解锁范围内增加余额

❺ 广播满足条件的事实(余额更新)

首先,我们使用sync.NewCond创建一个*sync.Cond,并提供一个*sync.Mutex。监听器和更新程序 goroutines 呢?

监听 goroutines 循环,直到达到捐赠余额。在循环中,我们使用Wait方法,该方法一直阻塞到满足条件。

注意,让我们确保术语条件在这里得到理解。在这种情况下,我们讨论的是更新余额,而不是捐赠目标条件。所以,这是两个监听器共享的一个条件变量。

对Wait的调用必须发生在临界区内,这听起来可能有些奇怪。锁不会阻止其他 goroutines 等待相同的条件吗?实际上,Wait的实现是这样的:

-

解锁互斥体。

-

暂停 goroutine,并等待通知。

-

通知到达时锁定互斥体。

因此,监听 goroutines 有两个关键部分:

-

访问

for donation.balance < goal中的donation.balance时 -

访问

fmt.Printf中的donation.balance时

这样,对共享donation.balance变量的所有访问都受到保护。

现在,更新程序 goroutine 怎么样了?平衡更新在临界区内完成,以防止数据竞争。然后我们调用Broadcast方法,它在每次余额更新时唤醒所有等待条件的 goroutines。

因此,如果我们运行这个示例,它会打印出我们期望的结果:

10$ goal reached

15$ goal reached

在我们的实现中,条件变量基于正在更新的余额。因此,监听器变量在每次进行新的捐赠时都会被唤醒,以检查它们的捐赠目标是否达到。这种解决方案可以防止我们在重复检查中出现消耗 CPU 周期的繁忙循环。

让我们也注意一下使用sync.Cond时的一个可能的缺点。当我们发送一个通知时——例如,发送给一个chan struct——即使没有活动的接收者,消息也会被缓冲,这保证了这个通知最终会被接收到。使用sync.Cond和Broadcast方法唤醒当前等待该条件的所有 goroutines 如果没有,通知将被错过。这也是我们必须牢记的基本原则。

信号()与广播()

我们可以使用Signal()而不是Broadcast()来唤醒单个 goroutine。就语义而言,它与以非阻塞方式在chan struct中发送消息是一样的:

ch := make(chan struct{

})

select {

case ch <- struct{

}{

}:

default:

}

GO中的信令可以用通道来实现。多个 goroutines 可以捕获的唯一事件是通道关闭,但这只能发生一次。因此,如果我们重复向多个 goroutines 发送通知,sync.Cond是一个解决方案。这个原语基于条件变量,这些变量设置了等待特定条件的线程容器。使用sync.Cond,我们可以广播信号来唤醒所有等待某个条件的 goroutines。

让我们使用golang.org/x和errgroup包来扩展我们关于并发原语的知识。

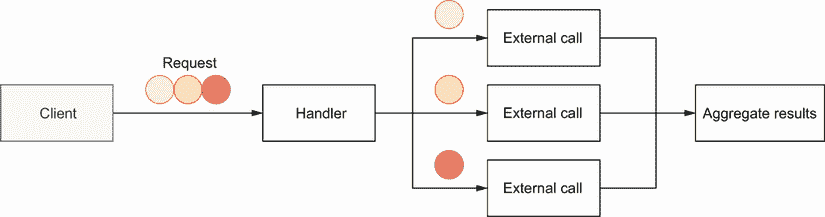

9.13 #73:不使用errgroup

不管什么编程语言,多此一举很少是个好主意。代码库重新实现如何旋转多个 goroutines 并聚合错误也很常见。但是 Go 生态系统中的一个包就是为了支持这种频繁的用例而设计的。让我们看看它,并理解为什么它应该成为 Go 开发者工具集的一部分。

是一个为标准库提供扩展的库。sync子库包含一个便利的包:errgroup。

假设我们必须处理一个函数,我们接收一些数据作为参数,我们希望用这些数据来调用外部服务。由于条件限制,我们不能打一个电话;我们每次都用不同的子集打多个电话。此外,这些调用是并行进行的(参见图 9.13)。

图 9.13 每个圆圈导致一个并行调用。

万一通话过程中出现错误,我们希望返回。如果有多个错误,我们只想返回其中一个。让我们只使用标准的并发原语来编写实现的框架:

func handler(ctx context.Context, circles []Circle) ([]Result, error) {

results := make([]Result, len(circles))

wg := sync.WaitGroup{

} // ❶

wg.Add(len(results))

for i, circle := range circles {

i := i // ❷

circle := circle // ❸

go func() {

// ❹

defer wg.Done() // ❺

result, err := foo(ctx, circle)

if err != nil {

// ?

}

results[i] = result // ❻

}()

}

wg.Wait()

// ...

}

❶ 创建了一个等待组来等待我们旋转的所有 goroutines

❷ 在 goroutine 中创建了一个新的i变量(参见错误#63,“不小心使用 goroutine 和循环变量”)

❸ 同样适用于circle

❹ 每个循环触发一次 goroutine

❺ 指示 goroutine 何时完成

❻ 汇总了结果

我们决定使用一个sync.WaitGroup来等待所有的 goroutines 完成,并在一个片上处理聚合。这是做这件事的一种方法;另一种方法是将每个部分结果发送到一个通道,并在另一个 goroutine 中聚合它们。如果需要排序,主要的挑战将是重新排序传入的消息。因此,我们决定采用最简单的方法和共享切片。

注意因为每个 goroutine 都写入一个特定的索引,所以这个实现是无数据竞争的。

然而,有一个关键案例我们还没有解决。如果foo(在新的 goroutine 中进行的调用)返回一个错误怎么办?应该怎么处理?有各种选项,包括:

-

就像

results切片一样,我们可以在 goroutines 之间共享一个错误切片。每个 goroutine 都会在出错时写入这个片。我们必须在父 goroutine 中迭代这个切片,以确定是否发生了错误(O(n)时间复杂度)。 -

我们可以通过一个共享互斥体让 goroutines 访问一个错误变量。

-

我们可以考虑共享一个错误通道,父 goroutine 将接收并处理这些错误。

不管选择哪个选项,它都会使解决方案变得非常复杂。出于这个原因,errgroup包是设计和开发的。

它导出一个函数WithContext,这个函数返回一个给定上下文的*Group结构。该结构为一组 goroutines 提供同步、错误传播和上下文取消,并且只导出两种方法:

-

Go在新的 goroutine 中触发调用。 -

Wait阻塞,直到所有程序完成。它返回第一个非零错误(如果有)。

让我们使用errgroup重写解决方案。首先我们需要导入errgroup包:

$ go get golang.org/x/sync/errgroup

实现如下:

func handler(ctx context.Context, circles []Circle) ([]Result, error) {

results := make([]Result, len(circles))

g, ctx := errgroup.WithContext(ctx) // ❶

for i, circle := range circles {

i := i

circle := circle

g.Go(func() error {

// ❷

result, err := foo(ctx, circle)

if err != nil {

return err

}

results[i] = result

return nil

})

}

if err := g.Wait(); err != nil {

// ❸

return nil, err

}

return results, nil

}

❶ 创建了一个errgroup。给定父上下文的组

❷ 调用 Go 来提升处理错误的逻辑,并将结果聚合到一个新的 goroutine 中

❸ 调用Wait来等待所有的 goroutines

首先,我们通过提供父上下文来创建和*errgroup.Group。在每次迭代中,我们使用g.Go在新的 goroutine 中触发一个调用。这个方法将一个func() error作为输入,用一个闭包包装对foo的调用,并处理结果和错误。与我们第一个实现的主要区别是,如果我们得到一个错误,我们从这个闭包返回它。然后,g.Wait允许我们等待所有的 goroutines 完成。

这个解决方案本质上比第一个更简单(第一个是部分的,因为我们没有处理错误)。我们不必依赖额外的并发原语,并且errgroup.Group足以处理我们的用例。

我们还没有解决的另一个好处是共享环境。假设我们必须触发三个并行调用:

-

第一个在 1 毫秒内返回一个错误。

-

第二次和第三次调用在 5 秒内返回结果或错误。

我们想要返回一个错误,如果有的话。因此,没有必要等到第二次和第三次通话结束。使用errgroup.WithContext创建一个在所有并行调用中使用的共享上下文。因为第一个调用在 1 毫秒内返回一个错误,所以它将取消上下文,从而取消其他 goroutines。所以,我们不必等 5 秒钟就返回一个错误。这是使用errgroup的另一个好处。

注意由g.Go调用的流程必须是上下文感知的。否则,取消上下文不会有任何效果。

总之,当我们必须触发多个 goroutines 并处理错误和上下文传播时,可能值得考虑errgroup是否是一个解决方案。正如我们所看到的,这个包支持一组 goroutines 的同步,并提供了处理错误和共享上下文的答案。

本章的最后一节讨论了 Go 开发者在复制sync 类型时的一个常见错误。

9.14 #74:复制同步类型

sync包提供了基本的同步原语,比如互斥、条件变量和等待组。对于所有这些类型,有一个硬性规则要遵循:它们永远不应该被复制。让我们了解一下基本原理和可能出现的问题。

我们将创建一个线程安全的数据结构来存储计数器。它将包含一个代表每个计数器当前值的map[string]int。我们还将使用一个sync.Mutex,因为访问必须受到保护。让我们添加一个increment方法来递增给定的计数器名称:

type Counter struct {

mu sync.Mutex

counters map[string]int

}

func NewCounter() Counter {

// ❶

return Counter{

counters: map[string]int{

}}

}

func (c Counter) Increment(name string) {

c.mu.Lock() // ❷

defer c.mu.Unlock()

c.counters[name]++

}

❶ 工厂函数

❷ 在临界区增加计数器

增量逻辑在一个临界区完成:在c.mu.Lock()和c.mu .Unlock()之间。让我们通过使用和-race选项运行下面的例子来尝试我们的方法,该例子加速两个 goroutines 并递增它们各自的计数器:

counter := NewCounter()

go func() {

counter.Increment("foo")

}()

go func() {

counter.Increment("bar")

}()

如果我们运行这个例子,它会引发一场数据竞争:

==================

WARNING: DATA RACE

...

我们的Counter实现中的问题是互斥体被复制了。因为Increment的接收者是一个值,所以每当我们调用Increment时,它执行Counter结构的复制,这也复制了互斥体。因此,增量不是在共享的临界区中完成的。

sync不应复制类型。此规则适用于以下类型:

-

sync.Cond -

sync.Map -

sync.Mutex -

sync.RWMutex -

sync.Once -

sync.Pool -

sync.WaitGroup

因此,互斥体不应该被复制。有哪些替代方案?

首先是修改Increment方法的接收器类型:

func (c *Counter) Increment(name string) {

// Same code

}

改变接收器类型可避免调用Increment时复制Counter。因此,内部互斥体不会被复制。

如果我们想保留一个值接收器,第二个选项是将Counter中的mu字段的类型改为指针:

type Counter struct {

mu *sync.Mutex // ❶

counters map[string]int

}

func NewCounter() Counter {

return Counter{

mu: &sync.Mutex{

}, // ❷

counters: map[string]int{

},

}

}

❶ 改变了mu的类型

❷ 改变了Mutex的初始化方式

如果Increment有一个值接收器,它仍然复制Counter结构。然而,由于mu现在是一个指针,它将只执行指针复制,而不是sync.Mutex的实际复制。因此,这种解决方案也防止了数据竞争。

注意我们也改变了mu的初始化方式。因为mu是一个指针,如果我们在创建Counter的时候省略了它,那么它会被初始化为一个指针的零值:nil。这将导致调用c.mu.Lock()时 goroutine 恐慌。

在以下情况下,我们可能会面临无意中复制sync字段的问题:

-

调用带有值接收器的方法(如我们所见)

-

调用带有

sync参数的函数 -

调用带有包含

sync字段的参数的函数

在每一种情况下,我们都应该非常谨慎。另外,让我们注意一些 linters 可以捕捉到这个问题——例如,使用go vet:

$ go vet .

./main.go:19:9: Increment passes lock by value: Counter contains sync.Mutex

根据经验,每当多个 goroutines 必须访问一个公共的sync元素时,我们必须确保它们都依赖于同一个实例。这个规则适用于包sync中定义的所有类型。使用指针是解决这个问题的一种方法:我们可以有一个指向sync元素的指针,或者一个指向包含sync元素的结构的指针。

总结

-

在传播上下文时,理解可以取消上下文的条件应该很重要:例如,当响应已经发送时,HTTP 处理器取消上下文。

-

避免泄露意味着无论何时启动 goroutine,你都应该有一个最终阻止它的计划。

-

为了避免 goroutines 和循环变量的错误,创建局部变量或调用函数,而不是闭包。

-

了解拥有多个通道的

select在多个选项可能的情况下随机选择案例,可以防止做出错误的假设,从而导致微妙的并发错误。 -

使用

chan struct{}类型发送通知。 -

使用

nil通道应该是你的并发工具集的一部分,因为它允许你从select语句中移除用例。 -

给定一个问题,仔细决定要使用的正确通道类型。只有无缓冲通道才能提供强同步保证。

-

除了为缓冲通道指定通道尺寸之外,您应该有一个很好的理由来指定通道尺寸。

-

意识到字符串格式化可能会导致调用现有函数意味着要小心可能的死锁和其他数据竞争。

-

调用

append并不总是无数据竞争的;因此,它不应该在共享片上并发使用。 -

记住切片和图是指针可以防止常见的数据竞争。

-

为了准确地使用

sync.WaitGroup,在旋转 goroutines 之前调用Add方法。 -

您可以使用

sync.Cond向多个 goroutines 发送重复通知。 -

你可以同步一组 goroutines,并用

errgroup包处理错误和上下文。 -

sync不该复制的类型。

十、标准库

本章涵盖

- 提供正确的持续时间

- 使用

time.After时了解潜在的内存泄漏 - 避免 JSON 处理和 SQL 中的常见错误

- 关闭暂态资源

- 记住 HTTP 处理器中的

return语句 - 为什么生产级应用不应该使用默认的 HTTP 客户端和服务器

Go 标准库是一组增强和扩展该语言的核心包。例如,Go 开发人员可以编写 HTTP 客户端或服务器,处理 JSON 数据,或者与 SQL 数据库进行交互。所有这些特性都由标准库提供。然而,误用标准库是很容易的,或者我们可能对它的行为了解有限,这可能导致错误和编写不应该被认为是生产级的应用。让我们看看使用标准库时最常见的一些错误。

10.1 #75:提供了错误的持续时间

标准库提供了接受time.Duration的通用函数和方法。然而,因为time.Duration是int64类型的别名,对这种语言的新来者可能会感到困惑,并提供错误的持续时间。例如,具有 Java 或 JavaScript 背景的开发人员习惯于传递数值类型。

为了说明这个常见的错误,让我们创建一个新的time.Ticker,它将提供每秒钟的时钟滴答声:

ticker := time.NewTicker(1000)

for {

select {

case <-ticker.C:

// Do something

}

}

如果我们运行这段代码,我们会注意到分笔成交点不是每秒都有;它们每微秒传送一次。

因为time.Duration基于int64类型,所以之前的代码是正确的,因为1000是有效的int64。但是time.Duration代表两个瞬间之间经过的时间,单位为纳秒。所以我们给NewTicker提供了 1000 纳秒= 1 微秒的持续时间。

这种错误经常发生。事实上,Java 和 JavaScript 等语言的标准库有时会要求开发人员以毫秒为单位提供持续时间。

此外,如果我们想有目的地创建一个间隔为 1 微秒的time.Ticker,我们不应该直接传递一个int64。相反,我们应该始终使用time.Duration API 来避免可能的混淆:

ticker = time.NewTicker(time.Microsecond)

// Or

ticker = time.NewTicker(1000 * time.Nanosecond)

这并不是本书中最复杂的错误,但是具有其他语言背景的开发人员很容易陷入这样一个陷阱,认为time包中的函数和方法应该是毫秒级的。我们必须记住使用time.Duration API 和提供一个int64和一个时间单位。

现在,让我们讨论一下在使用time.After和包时的一个常见错误。

10.2 #76:time.After和内存泄漏

time.After(time.Duration)是一个方便的函数,它返回一个通道,并在向该通道发送消息之前等待一段规定的时间。通常,它用在并发代码中;否则,如果我们想要睡眠给定的持续时间,我们可以使用time.Sleep(time.Duration)。time.After的优势在于它可以用于实现这样的场景,比如“如果我在这个通道中 5 秒钟没有收到任何消息,我会…"但是代码库经常在循环中包含对time.After的调用,正如我们在本节中所描述的,这可能是内存泄漏的根本原因。

让我们考虑下面的例子。我们将实现一个函数,该函数重复使用来自通道的消息。如果我们超过 1 小时没有收到任何消息,我们也希望记录一个警告。下面是一个可能的实现:

func consumer(ch <-chan Event) {

for {

select {

case event := <-ch: // ❶

handle(event)

case <-time.After(time.Hour): // ❷

log.Println("warning: no messages received")

}

}

}

❶ 处理事件

❷ 递增空闲计数器

这里,我们在两种情况下使用select:从ch接收消息和 1 小时后没有消息(time.After在每次迭代中被求值,因此超时每次被重置)。乍一看,这段代码还不错。但是,这可能会导致内存使用问题。

我们说过,time.After返回一个通道。我们可能期望这个通道在每次循环迭代中都是关闭的,但事实并非如此。一旦超时,由time.After创建的资源(包括通道)将被释放,并使用内存直到超时结束。多少内存?在 Go 1.15 中,每次调用time.After大约使用 200 字节的内存。如果我们收到大量的消息,比如每小时 500 万条,我们的应用将消耗 1 GB 的内存来存储和time.After资源。

我们可以通过在每次迭代中以编程方式关闭通道来解决这个问题吗?不会。返回的通道是一个<-chan time.Time,意味着它是一个只能接收的通道,不能关闭。

我们有几个选择来修正我们的例子。第一种是使用上下文来代替time.After:

func consumer(ch <-chan Event) {

for {

// ❶

ctx, cancel := context.WithTimeout(context.Background(), time.Hour) // ❷

select {

case event := <-ch:

cancel() // ❸

handle(event)

case <-ctx.Done(): // ❹

log.Println("warning: no messages received")

}

}

}

❶ 主循环

❷ 创建了一个超时的上下文

❸ 如果我们收到消息,取消上下文

❹ 上下文取消

这种方法的缺点是,我们必须在每次循环迭代中重新创建一个上下文。创建上下文并不是 Go 中最轻量级的操作:例如,它需要创建一个通道。我们能做得更好吗?

第二个选项来自time包:time.NewTimer。这个函数创建了一个结构,该结构导出了以下内容:

-

一个

C字段,它是内部计时器通道 -

一种

Reset(time.Duration)方法来重置持续时间 -

一个

Stop()方法来停止计时器

时间。内部构件后

我们要注意的是time.After也依赖于time.Timer。但是,它只返回C字段,所以我们无法访问Reset方法:

package time

func After(d Duration) <-chan Time {

return NewTimer(d).C // ❶

}

❶ 创建了一个新计时器并返回通道字段

让我们使用time.NewTimer实现一个新版本:

func consumer(ch <-chan Event) {

timerDuration := 1 * time.Hour

timer := time.NewTimer(timerDuration) // ❶

for {

// ❷

timer.Reset(timerDuration) // ❸

select {

case event := <-ch:

handle(event)

case <-timer.C: // ❹

log.Println("warning: no messages received")

}

}

}

❶ 创建了一个新的计时器

❷ 主循环

❸ 重置持续时间

❹ 计时器到期

在这个实现中,我们在每次循环迭代中保持一个循环动作:调用Reset方法。然而,调用Reset比每次都创建一个新的上下文要简单得多。它速度更快,对垃圾收集器的压力更小,因为它不需要任何新的堆分配。因此,使用time.Timer是我们最初问题的最佳解决方案。

注意为了简单起见,在这个例子中,前面的 goroutine 没有停止。正如我们在错误#62 中提到的,“启动一个 goroutine 却不知道何时停止”,这不是一个最佳实践。在生产级代码中,我们应该找到一个退出条件,比如可以取消的上下文。在这种情况下,我们还应该记得使用defer timer.Stop()停止time.Timer,例如,在timer创建之后。

在循环中使用time.After并不是导致内存消耗高峰的唯一情况。该问题与重复调用的代码有关。循环是一种情况,但是在 HTTP 处理函数中使用time.After会导致同样的问题,因为该函数会被多次调用。

一般情况下,使用time.After时要谨慎。请记住,创建的资源只有在计时器到期时才会被释放。当重复调用time.After时(例如,在一个循环中,一个 Kafka 消费函数,或者一个 HTTP 处理器),可能会导致内存消耗的高峰。在这种情况下,我们应该倾向于time.NewTimer。

下一节讨论 JSON 处理过程中最常见的错误。

10.3 #77:常见的 JSON 处理错误

Go 用encoding/json包对 JSON 有极好的支持。本节涵盖了与编码(编组)和解码(解组)JSON 数据相关的三个常见错误。

10.3.1 类型嵌入导致的意外行为

在错误#10“没有意识到类型嵌入可能存在的问题”中,我们讨论了与类型嵌入相关的问题。在 JSON 处理的上下文中,让我们讨论类型嵌入的另一个潜在影响,它会导致意想不到的封送/解封结果。

在下面的例子中,我们创建了一个包含 ID 和嵌入时间戳的Event结构:

type Event struct {

ID int

time.Time // ❶

}

❶ 嵌入字段

因为time.Time是嵌入式的,以我们之前描述的方式,我们可以在Event级别直接访问和time.Time方法:例如,event .Second()。

JSON 封送处理对嵌入式字段有哪些可能的影响?让我们在下面的例子中找出答案。我们将实例化一个Event,并将其封送到 JSON 中。这段代码的输出应该是什么?

event := Event{

ID: 1234,

Time: time.Now(), // ❶

}

b, err := json.Marshal(event)

if err != nil {

return err

}

fmt.Println(string(b))

❶ 结构实例化期间匿名字段的名称是结构的名称(时间)。

我们可能期望这段代码打印出如下内容:

{

"ID":1234,"Time":"2021-05-18T21:15:08.381652+02:00"}

相反,它会打印以下内容:

"2021-05-18T21:15:08.381652+02:00"

我们如何解释这个输出?ID字段和1234值怎么了?因为此字段是导出的,所以它应该已被封送。要理解这个问题,我们必须强调两点。

首先,正如错误#10 中所讨论的,如果一个嵌入字段类型实现了一个接口,那么包含该嵌入字段的结构也将实现这个接口。其次,我们可以通过让一个类型实现json.Marshaler接口来改变默认的封送处理行为。该接口包含单个MarshalJSON函数:

type Marshaler interface {

MarshalJSON() ([]byte, error)

}

下面是一个自定义封送处理的示例:

type foo struct{

} // ❶

func (foo) MarshalJSON() ([]byte, error) {

// ❷

return []byte(`"foo"`), nil // ❸

}

func main() {

b, err := json.Marshal(foo{

}) // ❹

if err != nil {

panic(err)

}

fmt.Println(string(b))

}

❶ 定义了这个结构

❷ 实现了MarshalJSON方法

❸ 响应了一个静态响应

❹ 然后,json.Marshal依赖于自定义MarshalJSON实现。

因为我们通过实现和Marshaler接口改变了默认的 JSON 封送行为,所以这段代码打印出了"foo"。

澄清了这两点之后,让我们回到最初关于Event结构的问题:

type Event struct {

ID int

time.Time

}

我们必须知道time.Time实现了json.Marshaler接口。因为time.Time是Event的嵌入字段,所以编译器会提升它的方法。因此,Event也实现了json.Marshaler。

因此,向json.Marshal传递一个Event会使用time.Time提供的封送处理行为,而不是默认行为。这就是为什么封送一个Event会导致忽略ID字段。

注意,如果我们使用json.Unmarshal解组一个Event,我们也会面临相反的问题。

要解决这个问题,有两种主要的可能性。首先,我们可以添加一个名称,这样time.Time字段就不再被嵌入:

type Event struct {

ID int

Time time.Time // ❶

}

❶ time.Time不再是嵌入的。

这样,如果我们封送这个Event结构的一个版本,它将打印如下内容:

{

"ID":1234,"Time":"2021-05-18T21:15:08.381652+02:00"}

如果我们希望或者必须保留嵌入的time.Time字段,另一个选择是让Event实现的json.Marshaler接口:

func (e Event) MarshalJSON() ([]byte, error) {

return json.Marshal(

struct {

// ❶

ID int

Time time.Time

}{

ID: e.ID,

Time: e.Time,

},

)

}

❶ 创建了一个匿名结构

在这个解决方案中,我们实现了一个定制的MarshalJSON方法,而定义了一个反映Event结构的匿名结构。但是这种解决方案更麻烦,并且要求我们确保MarshalJSON方法和Event结构总是最新的。

我们应该小心嵌入字段。虽然提升嵌入字段类型的字段和方法有时会很方便,但它也会导致微妙的错误,因为它会使父结构在没有明确信号的情况下实现接口。还是那句话,在使用嵌入字段的时候,要清楚的了解可能产生的副作用。

在下一节中,我们将看到另一个与使用time.Time相关的常见 JSON 错误。

10.3.2 JSON 和单调时钟

当封送或解封一个包含time.Time类型的结构时,我们有时会面临意想不到的比较错误。检查time.Time有助于完善我们的假设并防止可能的错误。

一个操作系统处理两种不同的时钟类型:墙时钟和单调时钟。本节首先看这些时钟类型,然后看使用 JSON 和time.Time时可能产生的影响。

挂钟用来确定一天中的当前时间。这个钟可能会有变化。例如,如果使用网络时间协议(NTP)同步时钟,它可以在时间上向后或向前跳转。我们不应该使用挂钟来测量持续时间,因为我们可能会面临奇怪的行为,例如负持续时间。这就是操作系统提供第二种时钟类型原因:单调时钟。单调时钟保证时间总是向前移动,不受时间跳跃的影响。它会受到频率调整的影响(例如,如果服务器检测到本地石英钟的移动速度与 NTP 服务器不同),但不会受到时间跳跃的影响。

在下面的例子中,我们考虑一个包含单个time.Time字段(非嵌入式)的Event结构:

type Event struct {

Time time.Time

}

我们实例化一个Event,将它封送到 JSON 中,并将其解包到另一个结构中。然后我们比较这两种结构。让我们看看编组/解组过程是否总是对称的:

t := time.Now() // ❶

event1 := Event{

// ❷

Time: t,

}

b, err := json.Marshal(event1) // ❸

if err != nil {

return err

}

var event2 Event

err = json.Unmarshal(b, &event2) // ❹

if err != nil {

return err

}

fmt.Println(event1 == event2)

❶ 得到当前的当地时间

❷ 实例化一个Event结构

❸ 编组 JSON

❹ 解组 JSON

这段代码的输出应该是什么?它打印的是false,不是true。我们如何解释这一点?

首先,让我们打印出event1和event2的内容:

fmt.Println(event1.Time)

fmt.Println(event2.Time)

2021-01-10 17:13:08.852061 +0100 CET m=+0.000338660

2021-01-10 17:13:08.852061 +0100 CET

代码为event1和event2打印不同的内容。除了m=+0.000338660部分,它们是一样的。这是什么意思?

在 Go 中,time.Time可能包含一个挂钟和一个单调时间,而不是将两个时钟分成两个不同的 API。当我们使用time.Now()获得本地时间时,它返回一个time.Time和两个时间:

2021-01-10 17:13:08.852061 +0100 CET m=+0.000338660

------------------------------------ --------------

Wall time Monotonic time

相反,当我们解组 JSON 时,time.Time字段不包含单调时间——只包含墙时间。因此,当我们比较这些结构时,由于单调的时间差,结果是false;这也是为什么我们在打印两个结构时会看到差异。我们如何解决这个问题?有两个主要选项。

当我们使用==操作符来比较两个time.Time字段时,它会比较所有的结构字段,包括单调部分。为了避免这种情况,我们可以使用Equal方法来代替:

fmt.Println(event1.Time.Equal(event2.Time))

true

Equal方法没有考虑单调时间;因此,这段代码打印了true。但是在这种情况下,我们只比较了time.Time字段,而不是父Event结构。

第二个选项是保留==来比较两个结构,但是使用和Truncate方法去除单调时间。该方法返回将time.Time值向下舍入到给定持续时间的倍数的结果。我们可以通过提供零持续时间来使用它,如下所示:

t := time.Now()

event1 := Event{

Time: t.Truncate(0), // ❶

}

b, err := json.Marshal(event1)

if err != nil {

return err

}

var event2 Event

err = json.Unmarshal(b, &event2)

if err != nil {

return err

}

fmt.Println(event1 == event2) // ❷

❶ 剥离了单调的时间

❷ 使用==运算符执行比较

在这个版本中,两个time.Time字段是相等的。因此,这段代码打印了true。

时间。时间和地点

我们还要注意,每个time.Time都与一个代表时区的time.Location相关联。例如:

t := time.Now() // 2021-01-10 17:13:08.852061 +0100 CET

这里,位置被设置为 CET,因为我使用了time.Now(),它返回我当前的本地时间。JSON 封送结果取决于位置。为了防止这种情况,我们可以坚持一个特定的位置:

location, err := time.LoadLocation("America/New_York") // ❶

if err != nil {

return err

}

t := time.Now().In(location) // 2021-05-18 22:47:04.155755 -0500 EST

❶ 获得"America/New_York"的当前位置

或者,我们可以获得 UTC 的当前时间:

t := time.Now().UTC() // 2021-05-18 22:47:04.155755 +0000 UTC

总之,编组/解组过程并不总是对称的,我们面对的这种情况是一个包含time.Time的结构。我们应该记住这个原则,这样我们就不会写错误的测试。

10.3.3 任何的映射

在解组数据的时候,我们可以提供一个映射来代替结构。基本原理是,当键和值不确定时,传递映射比传递静态结构更灵活。然而,有一个规则要记住,以避免错误的假设和可能的恐慌。

让我们编写一个将消息解组到映射中的示例:

b := getMessage()

var m map[string]any

err := json.Unmarshal(b, &m) // ❶

if err != nil {

return err

}

❶ 提供了映射指针

让我们为前面的代码提供以下 JSON:

{

"id": 32,

"name": "foo"

}

因为我们使用了一个通用的map[string]any,它会自动解析所有不同的字段:

map[id:32 name:foo]

然而,如果我们使用any的映射,有一个重要的问题需要记住:任何数值,不管它是否包含小数,都被转换为float64类型。我们可以通过打印m["id"]的类型来观察这一点:

fmt.Printf("%T\n", m["id"])

float64

我们应该确保我们没有做出错误的假设,并期望默认情况下没有小数的数值被转换为整数。例如,对类型转换做出不正确的假设可能会导致 goroutine 崩溃。

下一节讨论编写与 SQL 数据库交互的应用时最常见的错误。

10.4 #78:常见的 SQL 错误

database/sql包为 SQL(或类似 SQL 的)数据库提供了一个通用接口。在使用这个包时,看到一些模式或错误也是相当常见的。让我们深入探讨五个常见错误。

10.4.1 忘记了sql.Open不一定要建立到数据库的连接

使用sql.Open时,一个常见的误解是期望该函数建立到数据库的连接:

db, err := sql.Open("mysql", dsn)

if err != nil {

return err

}

但这不一定是事实。据文献记载(pkg.go.dev/database/sql),

Open 可能只是验证它的参数,而不创建到数据库的连接。

实际上,行为取决于所使用的 SQL 驱动程序。对于某些驱动程序来说,sql.Open并不建立连接:这只是为以后使用做准备(例如,与db.Query)。因此,到数据库的第一个连接可能是延迟建立的。

为什么我们需要了解这种行为?例如,在某些情况下,我们希望只有在我们知道所有的依赖项都已正确设置并且可以访问之后,才准备好服务。如果我们不知道这一点,服务可能会接受流量,尽管配置是错误的。

如果我们想确保使用sql.Open的函数也保证底层数据库是可访问的,我们应该使用Ping方法:

db, err := sql.Open("mysql", dsn)

if err != nil {

return err

}

if err := db.Ping(); err != nil {

// ❶

return err

}

❶ 在sql.Open之后调用Ping方法

Ping强制代码建立一个连接,确保数据源名称有效并且数据库可访问。注意,Ping的另一种选择是PingContext,它要求一个额外的上下文来传达 ping 何时应该被取消或超时。

尽管可能违反直觉,但让我们记住sql.Open不一定建立连接,第一个连接可以被延迟打开。如果我们想测试我们的配置并确保数据库是可达的,我们应该在sql.Open之后调用Ping或PingContext方法。

10.4.2 忘记连接池

正如默认的 HTTP 客户端和服务器提供了在生产中可能无效的默认行为一样(参见错误#81,“使用默认的 HTTP 客户端和服务器”),理解 Go 中如何处理数据库连接是至关重要的。sql.Open返回一个*sql.DB结构。此结构不代表单个数据库连接;相反,它代表一个连接池。这是值得注意的,所以我们不会尝试手动实现它。池中的连接可以有两种状态:

-

已被使用(例如,被另一个触发查询的 goroutine 使用)

-

闲置(已经创建但暂时没有使用)

同样重要的是要记住,创建池会导致四个可用的配置参数,我们可能想要覆盖它们。这些参数中的每一个都是*sql.DB的导出方法:

-

SetMaxOpenConns——数据库的最大打开连接数(默认值:unlimited) -

SetMaxIdleConns——最大空闲连接数(默认值:2) -

SetConnMaxIdleTime——连接关闭前可以空闲的最长时间(默认值:unlimited) -

SetConnMaxLifetime——连接关闭前可以保持打开的最长时间(默认值:unlimited)

图 10.1 显示了一个最多有五个连接的例子。它有四个正在进行的连接:三个空闲,一个在使用中。因此,仍有一个插槽可用于额外的连接。如果有新的查询进来,它将选择一个空闲连接(如果仍然可用)。如果没有更多的空闲连接,如果有额外的时隙可用,池将创建一个新的连接;否则,它将一直等到连接可用。

图 10.1 具有五个连接的连接池

那么,我们为什么要调整这些配置参数呢?

-

设置

SetMaxOpenConns对于生产级应用非常重要。因为默认值是无限制的,所以我们应该设置它以确保它适合底层数据库可以处理的内容。 -

如果我们的应用生成大量并发请求,那么

SetMaxIdleConns(默认:2)的值应该增加。否则,应用可能会经历频繁的重新连接。 -

如果我们的应用可能面临突发的请求,设置

SetConnMaxIdleTime是很重要的。当应用返回到一个更和平的状态时,我们希望确保创建的连接最终被释放。 -

例如,如果我们连接到一个负载平衡的数据库服务器,设置

SetConnMaxLifetime会很有帮助。在这种情况下,我们希望确保我们的应用不会长时间使用连接。

对于生产级应用,我们必须考虑这四个参数。如果一个应用面临不同的用例,我们也可以使用多个连接池。

10.4.3 不使用预准备语句

预准备语句是很多 SQL 数据库为了执行重复的 SQL 语句而实现的功能。在内部,SQL 语句被预编译并与提供的数据分离。有两个主要好处:

-

效率——语句不用重新编译(编译就是解析+优化+翻译)。

-

安全——这种方法降低了 SQL 注入攻击的风险。

因此,如果一个语句是重复的,我们应该使用预准备语句。我们还应该在不受信任的上下文中使用预准备语句(比如在互联网上公开一个端点,其中请求被映射到一个 SQL 语句)。

为了使用预准备语句,我们不调用*sql.DB的Query方法,而是调用Prepare:

stmt, err := db.Prepare("SELECT * FROM ORDER WHERE ID = ?") // ❶

if err != nil {

return err

}

rows, err := stmt.Query(id) // ❷

// ...

❶ 预准备语句

❷ 执行准备好的查询

我们准备语句,然后在提供参数的同时执行它。Prepare方法的第一个输出是一个*sql.Stmt,它可以被重用和并发运行。当不再需要该语句时,必须使用和Close()方法将其关闭。

注意,Prepare和Query方法提供了另外一个上下文:PrepareContext和QueryContext。

为了效率和安全,我们需要记住在有意义的时候使用预准备语句。

10.4.4 错误处理空值

下一个错误是用查询错误处理空值。让我们写一个例子,其中我们检索雇员的部门和年龄:

rows, err := db.Query("SELECT DEP, AGE FROM EMP WHERE ID = ?", id) // ❶

if err != nil {

return err

}

// Defer closing rows

var (

department string

age int

)

for rows.Next() {

err := rows.Scan(&department, &age) // ❷

if err != nil {

return err

}

// ...

}

❶ 执行查询

❷ 扫描每一行

我们使用Query来执行一个查询。然后,我们对行进行迭代,并使用Scan将列复制到由department和age指针指向的值中。如果我们运行这个例子,我们可能会在调用Scan时得到以下错误:

2021/10/29 17:58:05 sql: Scan error on column index 0, name "DEPARTMENT":

converting NULL to string is unsupported

这里,SQL 驱动程序引发了一个错误,因为部门值等于NULL。如果一个列可以为空,有两个选项可以防止Scan返回错误。

第一种方法是将department声明为字符串指针:

var (

department *string // ❶

age int

)

for rows.Next() {

err := rows.Scan(&department, &age)

// ...

}

❶ 将类型从字符串更改为*string

我们给scan提供的是指针的地址,而不是直接字符串类型的地址。通过这样做,如果值为NULL,department将为nil。

另一种方法是使用sql.NullXXX类型中的,如sql.NullString:

var (

department sql.NullString // ❶

age int

)

for rows.Next() {

err := rows.Scan(&department, &age)

// ...

}

❶ 将类型更改为sql.NullString

sql.NullString是字符串顶部的包装。它包含两个导出字段:String包含字符串值,Valid表示字符串是否不是NULL。可以访问以下包装器:

-

sql.NullString -

sql.NullBool -

sql.NullInt32 -

sql.NullFloat64 -

sql.NullTime

两个都采用的工作方式,用sql.NullXXX更清晰地表达的意图,正如核心GO维护者 Russ Cox(mng.bz/rJNX)所说:

没有有效的区别。我们认为人们可能想要使用NullString,因为它太常见了,并且可能比*string更清楚地表达了意图。但是这两种方法都可以。

因此,可空列的最佳实践是要么将其作为指针处理,要么使用和sql.NullXXX类型。

10.4.5 不处理行迭代错误

另一个常见的错误是在迭代行时漏掉可能的错误。让我们看一个错误处理被误用的函数:

func get(ctx context.Context, db *sql.DB, id string) (string, int, error) {

rows, err := db.QueryContext(ctx,

"SELECT DEP, AGE FROM EMP WHERE ID = ?", id)

if err != nil {

// ❶

return "", 0, err

}

defer func() {

err := rows.Close() // ❷

if err != nil {

log.Printf("failed to close rows: %v\n", err)

}

}()

var (

department string

age int

)

for rows.Next() {

err := rows.Scan(&department, &age) // ❸

if err != nil {

return "", 0, err

}

}

return department, age, nil

}

❶ 在执行查询时处理错误

❷ 在关闭行时处理错误

❸ 在扫描行时处理错误

在这个函数中,我们处理三个错误:执行查询时,关闭行,扫描行。但这还不够。我们必须知道for rows .Next() {}循环可以中断,无论是当没有更多的行时,还是当准备下一行时发生错误时。在行迭代之后,我们应该调用rows.Err来区分两种情况:

func get(ctx context.Context, db *sql.DB, id string) (string, int, error) {

// ...

for rows.Next() {

// ...

}

if err := rows.Err(); err != nil {

// ❶

return "", 0, err

}

return department, age, nil

}

❶ 检查rows.Err确定上一个循环是否因为错误而停止

这是要记住的最佳实践:因为rows.Next可能在我们迭代完所有行时停止,或者在准备下一行时发生错误时停止,所以我们应该在迭代后检查rows.Err。

现在让我们讨论一个常见的错误:忘记关闭瞬态资源。

10.5 #79:不关闭瞬态资源

开发人员经常使用必须在代码中的某个点关闭的瞬态(临时)资源:例如,为了避免磁盘或内存中的泄漏。结构通常可以实现io.Closer接口来传达必须关闭瞬态资源。让我们来看三个常见的例子,看看当资源没有正确关闭时会发生什么,以及如何正确地处理它们。

10.5.1 HTTP 正文

首先,我们在 HTTP 的背景下讨论一下这个问题。我们将编写一个getBody方法,发出 HTTP GET 请求并返回 HTTP 正文响应。这是第一个实现:

type handler struct {

client http.Client

url string

}

func (h handler) getBody() (string, error) {

resp, err := h.client.Get(h.url) // ❶

if err != nil {

return "", err

}

body, err := io.ReadAll(resp.Body) // ❷

if err != nil {

return "", err

}

return string(body), nil

}

❶ 发出一个 HTTP GET 请求

❷ 读取resp.Body,并以[]byte的形式获取正文

我们使用http.Get并使用io.ReadAll解析响应。这个方法看起来不错,它正确地返回了 HTTP 响应体。然而,有一个资源泄漏。我们来了解一下在哪里。

resp是一个*http.Response型。它包含一个Body io.ReadCloser字段(io.ReadCloser实现了io.Reader和io.Closer)。如果http.Get没有返回错误,这个正文必须关闭;否则就是资源泄露。在这种情况下,我们的应用将保留一些不再需要但不能被 GC 回收的内存,在最坏的情况下,可能会阻止客户端重用 TCP 连接。

处理体闭包最方便的方法是像这样处理defer语句:

defer func() {

err := resp.Body.Close()

if err != nil {

log.Printf("failed to close response: %v\n", err)

}

}()

在这个实现中,我们将正文资源闭包作为一个defer函数来处理,一旦getBody返回,就会执行。

注意在服务器端,在实现 HTTP 处理器时,我们不需要关闭请求正文,因为服务器会自动关闭请求正文。

我们还应该理解,无论我们是否读取响应体,它都必须是封闭的。例如,如果我们只对 HTTP 状态代码感兴趣,而对正文不感兴趣,那么无论如何都必须关闭它,以避免泄漏:

func (h handler) getStatusCode(body io.Reader) (int, error) {

resp, err := h.client.Post(h.url, "application/json", body)

if err != nil {

return 0, err

}

defer func() {

// ❶

err := resp.Body.Close()

if err != nil {

log.Printf("failed to close response: %v\n", err)

}

}()

return resp.StatusCode, nil

}

即使我们不读,❶也会关闭响应正文

这个函数关闭了正文,即使我们没有读它。

另一件需要记住的重要事情是,当我们关闭身体时,行为是不同的,这取决于我们是否已经阅读了它:

-

如果我们在没有读取的情况下关闭正文,默认的 HTTP 传输可能会关闭连接。

-

如果我们在读取之后关闭正文,默认的 HTTP 传输不会关闭连接;因此,它可以重复使用。

因此,如果getStatusCode被重复调用并且我们想要使用保持活动的连接,我们应该读取正文,即使我们对它不感兴趣:

func (h handler) getStatusCode(body io.Reader) (int, error) {

resp, err := h.client.Post(h.url, "application/json", body)

if err != nil {

return 0, err

}

// Close response body

_, _ = io.Copy(io.Discard, resp.Body) // ❶

return resp.StatusCode, nil

}

❶ 阅读响应正文

在本例中,我们读取正文以保持连接的活力。注意,我们没有使用io.ReadAll,而是使用了io.Copy到io.Discard,一个io.Writer实现。这段代码读取正文,但丢弃它,不进行任何复制,这比io.ReadAll更有效。

何时关闭响应体

通常,如果响应不为空,实现会关闭正文,而不是如果错误为nil:

resp, err := http.Get(url)

if resp != nil {

// ❶

defer resp.Body.Close() // ❷

}

if err != nil {

return "", err

}

如果答案不是零,❶…

❷ …作为延迟函数关闭响应正文。

这个实现不是必需的。这是基于这样一个事实:在某些情况下(比如重定向失败),无论是resp还是err都不会是nil。但是根据官方GO文档(pkg.go.dev/net/http),

出错时,任何响应都可以忽略。只有当CheckRedirect失败时,才会出现带有非零错误的非零响应,即使在这种情况下,返回的响应也是如此。身体已经关闭。

因此,没有必要进行if resp != nil {}检查。我们应该坚持最初的解决方案,只有在没有错误的情况下,才在defer函数中关闭正文。

关闭资源以避免泄漏不仅仅与 HTTP 正文管理相关。一般来说,所有实现io.Closer接口的结构都应该在某个时候关闭。该接口包含单个Close方法:

type Closer interface {

Close() error

}

现在让我们看看sql.Rows的影响。

10.5.2 sql.Rows

sql.Rows是作为 SQL 查询结果使用的结构。因为这个结构实现了io.Closer,所以它必须被关闭。以下示例省略了行的关闭:

db, err := sql.Open("postgres", dataSourceName)

if err != nil {

return err

}

rows, err := db.Query("SELECT * FROM CUSTOMERS") // ❶

if err != nil {

return err

}

// Use rows

return nil

❶ 执行 SQL 查询

忘记关闭行意味着连接泄漏,这会阻止数据库连接被放回连接池中。

我们可以将闭包作为跟在if err != nil块后面的defer函数来处理:

// Open connection

rows, err := db.Query("SELECT * FROM CUSTOMERS") // ❶

if err != nil {

return err

}

defer func() {

// ❷

if err := rows.Close(); err != nil {

log.Printf("failed to close rows: %v\n", err)

}

}()

// Use rows

❶ 执行 SQL 查询

❷ 关闭一行

在Query调用之后,如果没有返回错误,我们应该最终关闭rows来防止连接泄漏。

注如前一节所述,db变量(*sql.DB类型)代表一个连接池。它还实现了io.Closer接口。但是正如文档所示,很少关闭一个sql.DB,因为它应该是长期存在的,并且由许多 goroutines 共享。

接下来,让我们讨论在处理文件时关闭资源。

10.5.3 os.File

os.File代表一个打开的文件描述符。和sql.Rows一样,最终必须关闭:

f, err := os.OpenFile(filename, os.O_APPEND|os.O_WRONLY, os.ModeAppend) // ❶

if err != nil {

return err

}

defer func() {

if err := f.Close(); err != nil {

// ❷

log.Printf("failed to close file: %v\n", err)

}

}()

❶ 打开文件

❷ 关闭文件描述符

在这个例子中,我们使用defer来延迟对Close方法的调用。如果我们最终没有关闭一个os.File,它本身不会导致泄漏:当os.File被垃圾收集时,文件会自动关闭。但是,最好显式调用Close,因为我们不知道下一个 GC 将在何时被触发(除非我们手动运行它)。

显式调用Close还有另一个好处:主动监控返回的错误。例如,可写文件应该是这种情况。

写入文件描述符不是同步操作。出于性能考虑,数据被缓冲。close(2)的 BSD 手册页提到,一个闭包会导致在 I/O 错误期间遇到的先前未提交的写操作(仍在缓冲区中)出错。因此,如果我们想要写入文件,我们应该传播关闭文件时发生的任何错误:

func writeToFile(filename string, content []byte) (err error) {

// Open file

defer func() {

// ❶

closeErr := f.Close()

if err == nil {

err = closeErr

}

}()

_, err = f.Write(content)

return

}

如果写入成功,❶将返回关闭错误

在本例中,我们使用命名参数,并在写入成功时将错误设置为f.Close的响应。通过这种方式,客户将会意识到这个函数是否出了问题,并做出相应的反应。

此外,成功关闭可写的os.File并不能保证文件将被写入磁盘。写操作仍然可以驻留在文件系统的缓冲区中,而不会刷新到磁盘上。如果持久性是一个关键因素,我们可以使用Sync()方法来提交变更。在这种情况下,来自Close的错误可以被安全地忽略:

func writeToFile(filename string, content []byte) error {

// Open file

defer func() {

_ = f.Close() // ❶

}()

_, err = f.Write(content)

if err != nil {

return err

}

return f.Sync() // ❷

}

❶ 忽略了可能的错误

❷ 将写入提交到磁盘

这个例子是一个同步写函数。它确保内容在返回之前被写入磁盘。但是它的缺点是会影响性能。

总结这一节,我们已经看到关闭短暂的资源从而避免泄漏是多么重要。短暂的资源必须在正确的时间和特定的情况下关闭。事先并不总是清楚什么必须结束。我们只能通过仔细阅读 API 文档和/或通过经验来获取这些信息。但是我们应该记住,如果一个结构实现了io.Closer接口,我们最终必须调用Close方法。最后但并非最不重要的一点是,必须理解如果闭包失败了该怎么做:记录一条消息就够了吗,或者我们还应该传播它吗?适当的操作取决于实现,如本节中的三个示例所示。

现在让我们切换到与 HTTP 处理相关的常见错误:忘记return语句。

10.6 #80:响应 HTTP 请求后忘记返回语句

在编写 HTTP 处理器时,很容易忘记响应 HTTP 请求后的语句。这可能会导致一种奇怪的情况,我们应该在出错后停止处理器,但是我们没有。

我们可以在下面的例子中观察到这种情况:

func handler(w http.ResponseWriter, req *http.Request) {

err := foo(req)

if err != nil {

http.Error(w, "foo", http.StatusInternalServerError) // ❶

}

// ...

}

❶ 处理错误

如果foo返回一个错误,我们使用http.Error来处理它,它用foo错误消息和一个 500 内部服务器错误来响应请求。这段代码的问题是,如果我们进入if err != nil分支,应用将继续执行,因为http.Error不会停止处理器的执行。

这种错误的真正影响是什么?首先我们从 HTTP 层面来讨论一下。例如,假设我们通过添加一个步骤来编写成功的 HTTP 响应正文和状态代码,从而完成了前面的 HTTP 处理器:

func handler(w http.ResponseWriter, req *http.Request) {

err := foo(req)

if err != nil {

http.Error(w, "foo", http.StatusInternalServerError)

}

_, _ = w.Write([]byte("all good"))

w.WriteHeader(http.StatusCreated)

}

在err != nil的情况下,HTTP 响应如下:

foo

all good

响应包含错误和成功消息。

我们将只返回第一个 HTTP 状态代码:在前面的例子中是 500。但是,Go 也会记录一个警告:

2021/10/29 16:45:33 http: superfluous response.WriteHeader call

from main.handler (main.go:20)

这个警告意味着我们试图多次写入状态代码,这样做是多余的。

就执行而言,主要影响是继续执行本应停止的函数。例如,如果foo在返回错误的同时还返回了一个指针,那么继续执行将意味着使用这个指针,这可能会导致一个空指针解引用(并因此导致一个 goroutine 崩溃)。

纠正这个错误的方法是继续考虑在http.Error之后添加return语句的:

func handler(w http.ResponseWriter, req *http.Request) {

err := foo(req)

if err != nil {

http.Error(w, "foo", http.StatusInternalServerError)

return // ❶

}

// ...

}

❶ 补充了返回语句

由于的return语句,如果我们在if err != nil分支结束,函数将停止执行。

这个错误可能不是这本书最复杂的。然而,很容易忘记这一点,这种错误经常发生。我们总是需要记住http.Error不会停止一个处理器的执行,必须手动添加。如果我们有足够的覆盖率,这样的问题可以而且应该在测试中被发现。

本章的最后一节继续我们对 HTTP 的讨论。我们明白了为什么生产级应用不应该依赖默认的 HTTP 客户端和服务器实现。

10.7 #81:使用默认的 HTTP 客户端和服务器

http包提供了 HTTP 客户端和服务器实现。然而,开发人员很容易犯一个常见的错误:在最终部署到生产环境中的应用的上下文中依赖默认实现。让我们看看问题和如何克服它们。

10.7.1 HTTP 客户端

我们来定义一下默认客户端是什么意思。我们将使用一个 GET 请求作为例子。我们可以像这样使用http.Client结构的零值:

client := &http.Client{

}

resp, err := client.Get("https://golang.org/")

或者我们可以使用http.Get函数:

resp, err := http.Get("https://golang.org/")

最后,两种方法都是一样的。http.Get函数使用http .DefaultClient,其也是基于http.Client的零值:

// DefaultClient is the default Client and is used by Get, Head, and Post.

var DefaultClient = &Client{

}

那么,使用默认的 HTTP 客户端有什么问题呢?

首先,默认客户端没有指定任何超时。这种没有超时的情况并不是我们想要的生产级系统:它会导致许多问题,比如永无止境的请求会耗尽系统资源。

在深入研究发出请求时的可用超时之前,让我们回顾一下 HTTP 请求中涉及的五个步骤:

-

建立 TCP 连接。

-

TLS 握手(如果启用)。

-

发送请求。

-

读取响应标题。

-

读取响应正文。

图 10.2 显示了这些步骤与主客户端超时的关系。

图 10.2 HTTP 请求期间的五个步骤,以及相关的超时

四种主要超时如下:

-

net.Dialer.Timeout——指定拨号等待连接完成的最长时间。 -

http.Transport.TLSHandshakeTimeout——指定等待 TLS 握手的最长时间。 -

http.Transport.ResponseHeaderTimeout——指定等待服务器响应头的时间。 -

http.Client.Timeout——指定请求的时限。它包括从步骤 1(拨号)到步骤 5(读取响应正文)的所有步骤。

HTTP 客户端超时

在指定http.Client .Timeout时,您可能会遇到以下错误:

net/http: request canceled (Client.Timeout exceeded while awaiting

headers)

此错误意味着端点未能及时响应。我们得到这个关于头的错误是因为读取它们是等待响应的第一步。

下面是一个覆盖这些超时的 HTTP 客户端示例:

client := &http.Client{

Timeout: 5 * time.Second, // ❶

Transport: &http.Transport{

DialContext: (&net.Dialer{

Timeout: time.Second, // ❷

}).DialContext,

TLSHandshakeTimeout: time.Second, // ❸

ResponseHeaderTimeout: time.Second, // ❹

},

}

❶ 全局请求超时

❷ 拨号超时

❸ TLS 握手超时

❹ 响应标头超时

我们创建一个客户端,拨号、TLS 握手和读取响应头的超时时间为 1 秒。同时,每个请求都有一个 5 秒的全局超时。

关于默认 HTTP 客户端,要记住的第二个方面是如何处理连接。默认情况下,HTTP 客户端使用连接池。默认客户端重用连接(可以通过将http.Transport.DisableKeepAlives设置为true来禁用)。有一个额外的超时来指定空闲连接在池中保持多长时间:http.Transport.IdleConnTimeout。默认值是 90 秒,这意味着在此期间,连接可以被其他请求重用。之后,如果连接没有被重用,它将被关闭。

要配置池中的连接数,我们必须覆盖http.Transport.MaxIdleConns。该值默认设置为100。但是有一些重要的事情需要注意:每台主机的http.Transport.MaxIdleConnsPerHost限制,默认设置为 2。例如,如果我们向同一个主机触发100请求,那么在此之后,只有 2 个连接会保留在连接池中。因此,如果我们再次触发 100 个请求,我们将不得不重新打开至少 98 个连接。如果我们必须处理对同一台主机的大量并行请求,这种配置也会影响平均延迟。

对于生产级系统,我们可能希望覆盖默认超时。调整与连接池相关的参数也会对延迟产生重大影响。

10.7.2 HTTP 服务器

在实现 HTTP 服务器时,我们也应该小心。同样,可以使用零值http.Server创建默认服务器:

server := &http.Server{

}

server.Serve(listener)

或者我们可以使用一个函数,比如http.Serve、http.ListenAndServe或http .ListenAndServeTLS,它们也依赖于默认的http.Server。

一旦连接被接受,HTTP 响应就分为五个步骤:

-

等待客户端发送请求。

-

TLS 握手(如果启用)。

-

读取请求标题。

-

读取请求正文。

-

写入响应。

注意,对于已经建立的连接,不必重复 TLS 握手。

图 10.3 显示了这些步骤与主服务器超时的关系。三种主要超时如下:

-

http.Server.ReadHeaderTimeout——字段,指定读取请求头的最大时间量 -

http.Server.ReadTimeout——指定读取整个请求的最长时间的字段 -

http.TimeoutHandler——一个包装器函数,指定处理器完成的最大时间

图 10.3 HTTP 响应的五个步骤,以及相关的超时

最后一个参数不是服务器参数,而是一个位于处理器之上的包装器,用于限制其持续时间。如果处理器未能及时响应,服务器将通过特定消息响应 503 服务不可用,传递给处理器的上下文将被取消。

注意我们故意省略了http.Server.WriteTimeout,因为http.TimeoutHandler已经发布(Go 1.8),所以没有必要。http.Server.WriteTimeout有一些问题。首先,它的行为取决于是否启用了 TLS,这使得理解和使用它变得更加复杂。如果超时,它还会关闭 TCP 连接,而不返回正确的 HTTP 代码。它不会将取消传播到处理器上下文,所以处理器可能会继续执行,而不知道 TCP 连接已经关闭。

当向不受信任的客户端公开我们的端点时,最佳实践是至少设置http.Server.ReadHeaderTimeout字段,并且使用http.TimeoutHandler包装函数。否则,客户端可能会利用此缺陷,例如,创建永无止境的连接,这可能会导致系统资源耗尽。

以下是如何设置具有这些超时的服务器:

s := &http.Server{

Addr: ":8080",

ReadHeaderTimeout: 500 * time.Millisecond,

ReadTimeout: 500 * time.Millisecond,

Handler: http.TimeoutHandler(handler, time.Second, "foo"), // ❶

}

❶ 包装了 HTTP 处理器

http.TimeoutHandler包装提供的处理器。这里,如果handler在 1 秒内没有响应,服务器返回一个 503 状态码,用foo作为 HTTP 响应。

正如我们所描述的 HTTP 客户端一样,在服务器端,我们可以在激活 keep-alive 时为下一个请求配置最长时间。我们使用http.Server.IdleTimeout来完成:

s := &http.Server{

// ...

IdleTimeout: time.Second,

}

注意,如果没有设置http.Server.IdleTimeout,则http.Server .ReadTimeout的值用于空闲超时。如果两者都没有设置,则不会有任何超时,连接将保持打开状态,直到被客户端关闭。

对于生产级应用,我们需要确保不使用默认的 HTTP 客户端和服务器。否则,请求可能会因为没有超时而永远停滞不前,甚至恶意客户端会利用我们的服务器没有任何超时这一事实。

总结

-

对接受

time.Duration的函数保持谨慎。尽管传递整数是允许的,但还是要努力使用 time API 来防止任何可能的混淆。 -

避免在重复的函数(比如循环或者 HTTP 处理器)中调用

time.After可以避免内存消耗高峰。由time.After创建的资源只有在计时器到期时才会被释放。 -

在 Go 结构中使用嵌入字段时要小心。这样做可能会导致偷偷摸摸的错误,比如实现

json .Marshaler接口的嵌入式time.Time字段,因此会覆盖默认的封送处理行为。 -

当比较两个

time.Time结构时,回想一下time.Time包含一个挂钟和一个单调时钟,使用==操作符的比较是在两个时钟上进行的。 -

为了避免在解组 JSON 数据时提供映射时的错误假设,请记住默认情况下 numerics 被转换为

float64。 -

如果您需要测试您的配置并确保数据库可访问,请调用

Ping或PingContext方法。 -

为生产级应用配置数据库连接参数。

-

使用 SQL 预准备语句使查询更高效、更安全。

-

使用指针或

sql.NullXXX类型处理表中可空的列。 -

在行迭代后调用

*sql.Rows的Err方法,以确保在准备下一行时没有遗漏错误。 -

最终关闭所有实现

io.Closer的结构以避免可能的泄漏。 -

为了避免 HTTP 处理器实现中的意外行为,如果您希望处理器在

http.Error之后停止,请确保不要错过return语句。 -

对于生产级应用,不要使用默认的 HTTP 客户端和服务器实现。这些实现缺少生产中应该强制的超时和行为。

十一、测试

本章涵盖

- 对测试进行分类,使它们更加健壮

- 使 Go 测试具有确定性

- 使用实用工具包,如

httptest和iotest - 避免常见的基准错误

- 改进测试流程

测试是项目生命周期的一个重要方面。它提供了无数的好处,比如建立对应用的信心,充当代码文档,以及使重构更容易。与其他一些语言相比,Go 拥有强大的编写测试的原语。在这一章中,我们将关注那些使测试过程变得脆弱、低效和不准确的常见错误。

11.1 #82:没有对测试进行分类

测试金字塔是一个将测试分成不同类别的模型(见图 11.1)。单元测试占据了金字塔的底部。大多数测试应该是单元测试:它们编写成本低,执行速度快,并且具有很高的确定性。通常,当我们走的时候

在金字塔的更高层,测试变得越来越复杂,运行越来越慢,并且更难保证它们的确定性。

图 11.1 测试金字塔的一个例子

一种常见的技术是明确要运行哪种测试。例如,根据项目生命周期的阶段,我们可能希望只运行单元测试或者运行项目中的所有测试。不对测试进行分类意味着潜在的浪费时间和精力,并且失去了测试范围的准确性。本节讨论了在 Go 中对测试进行分类的三种主要方法。

11.1.1 构建标签

分类测试最常见的方法是使用构建标签。构建标签是 Go 文件开头的特殊注释,后面跟一个空行。

例如,看看这个bar.go文件:

//go:build foo

package bar

这个文件包含了foo标签。请注意,一个包可能包含多个带有不同构建标记的文件。

注从 Go 1.17 开始,语法// +build foo被//go:build foo取代。目前(Go 1.18),gofmt同步这两种形式来帮助迁移。

构建标签主要用于两种情况。首先,我们可以使用build标签作为构建应用的条件选项:例如,如果我们希望只有在启用了cgo的情况下才包含源文件(cgo是一种让包调用 C 代码的方法),我们可以添加//go:build cgo``build标签。第二,如果我们想要将一个测试归类为集成测试,我们可以添加一个特定的构建标志,比如integration。

下面是一个db_test.go文件示例:

//go:build integration

package db

import (

"testing"

)

func TestInsert(t *testing.T) {

// ...

}

这里我们添加了integration``build标签来分类这个文件包含集成测试。使用构建标签的好处是我们可以选择执行哪种测试。例如,让我们假设一个包包含两个测试文件:

-

我们刚刚创建的文件:

db_test.go -

另一个不包含构建标签的文件:

contract_test.go

如果我们在这个包中运行go test而没有任何选项,它将只运行没有构建标签的测试文件(contract_test.go):

$ go test -v .

=== RUN TestContract

--- PASS: TestContract (0.01s)

PASS

然而,如果我们提供了integration标签,运行go test也将包括db_test.go:

$ go test --tags=integration -v .

=== RUN TestInsert

--- PASS: TestInsert (0.01s)

=== RUN TestContract

--- PASS: TestContract (2.89s)

PASS

因此,运行带有特定标签的测试包括没有标签的文件和匹配这个标签的文件。如果我们只想运行集成测试呢?一种可能的方法是在单元测试文件上添加一个否定标记。例如,使用!integration意味着只有当integration标志不启用时,我们才想要包含测试文件(contract_test.go):

//go:build !integration

package db

import (

"testing"

)

func TestContract(t *testing.T) {

// ...

}

使用这种方法,

-

带

integration标志运行go test仅运行集成测试。 -

在没有

integration标志的情况下运行go test只会运行单元测试。

让我们讨论一个在单个测试层次上工作的选项,而不是一个文件。

11.1.2 环境变量

正如 Go 社区的成员 Peter Bourgon 所提到的,build标签有一个主要的缺点:缺少一个测试被忽略的信号(参见 mng.bz/qYlr )。在第一个例子中,当我们在没有构建标志的情况下执行go test时,它只显示了被执行的测试:

$ go test -v .

=== RUN TestUnit

--- PASS: TestUnit (0.01s)

PASS

ok db 0.319s

如果我们不小心处理标签的方式,我们可能会忘记现有的测试。出于这个原因,一些项目喜欢使用环境变量来检查测试类别的方法。

例如,我们可以通过检查一个特定的环境变量并可能跳过测试来实现TestInsert集成测试:

func TestInsert(t *testing.T) {

if os.Getenv("INTEGRATION") != "true" {

t.Skip("skipping integration test")

}

// ...

}

如果INTEGRATION环境变量没有设置为true,测试将被跳过,并显示一条消息:

$ go test -v .

=== RUN TestInsert

db_integration_test.go:12: skipping integration test // ❶

--- SKIP: TestInsert (0.00s)

=== RUN TestUnit

--- PASS: TestUnit (0.00s)

PASS

ok db 0.319s

❶ 显示跳过测试的消息

使用这种方法的一个好处是明确哪些测试被跳过以及为什么。这种技术可能没有build标签使用得广泛,但是它值得了解,因为正如我们所讨论的,它提供了一些优势。

接下来,让我们看看另一种分类测试的方法:短模式。

11.1.3 短模式

另一种对测试进行分类的方法与它们的速度有关。我们可能必须将短期运行的测试与长期运行的测试分离开来。

作为一个例子,假设我们有一组单元测试,其中一个非常慢。我们希望对慢速测试进行分类,这样我们就不必每次都运行它(特别是当触发器是在保存一个文件之后)。短模式允许我们进行这种区分:

func TestLongRunning(t *testing.T) {

if testing.Short() {

// ❶

t.Skip("skipping long-running test")

}

// ...

}

❶ 将测试标记为长期运行

使用testing.Short,我们可以在运行测试时检索是否启用了短模式。然后我们使用Skip来跳过测试。要使用短模式运行测试,我们必须通过-short:

% go test -short -v .

=== RUN TestLongRunning

foo_test.go:9: skipping long-running test

--- SKIP: TestLongRunning (0.00s)

PASS

ok foo 0.174s

执行测试时,明确跳过TestLongRunning。请注意,与构建标签不同,该选项适用于每个测试,而不是每个文件。

总之,对测试进行分类是成功测试策略的最佳实践。在本节中,我们已经看到了三种对测试进行分类的方法:

-

在测试文件级别使用构建标签

-

使用环境变量来标记特定的测试

-

基于使用短模式的测试步速

我们还可以组合方法:例如,如果我们的项目包含长时间运行的单元测试,使用构建标签或环境变量来分类测试(例如,作为单元或集成测试)和短模式。

在下一节中,我们将讨论为什么启用-race标志很重要。

11.2 #83:不启用竞争标志

在错误#58“不理解竞争问题”中,我们将数据竞争定义为当两个 goroutines 同时访问同一个变量时发生,至少有一个变量被写入。我们还应该知道,Go 有一个标准的竞争检测工具来帮助检测数据竞争。一个常见的错误是忘记了这个工具的重要性,没有启用它。这一节讨论竞争检测器捕捉什么,如何使用它,以及它的局限性。

在 Go 中,竞争检测器不是编译期间使用的静态分析工具;相反,它是一个发现运行时发生的数据竞争的工具。要启用它,我们必须在编译或运行测试时启用-race标志。例如:

$ go test -race ./...

一旦启用了竞争检测器,编译器就会检测代码来检测数据竞争。插装指的是编译器添加额外的指令:在这里,跟踪所有的内存访问并记录它们何时以及如何发生。在运行时,竞争检测器监视数据竞争。但是,我们应该记住启用竞争检测器的运行时开销:

-

内存使用量可能会增加 5 到 10 倍。

-

执行时间可能增加 2 到 20 倍。

由于这种开销,通常建议只在本地测试或持续集成(CI)期间启用竞争检测器。在生产中,我们应该避免使用它(或者只在金丝雀释放的情况下使用它)。

如果检测到竞争,Go 会发出警告。例如,这个例子包含了一个数据争用,因为i可以同时被读取和写入:

package main

import (

"fmt"

)

func main() {

i := 0

go func() {

i++ }()

fmt.Println(i)

}

使用-race标志运行该应用会记录以下数据竞争警告:

==================

WARNING: DATA RACE

Write at 0x00c000026078 by goroutine 7: // ❶

main.main.func1()

/tmp/app/main.go:9 +0x4e

Previous read at 0x00c000026078 by main goroutine: // ❷

main.main()

/tmp/app/main.go:10 +0x88

Goroutine 7 (running) created at: // ❸

main.main()

/tmp/app/main.go:9 +0x7a

==================

❶ 指出由 goroutine 7 写入

❷ 指出由主 goroutine读取

❸ 指出了 goroutine 7 的创建时间

让我们确保阅读这些信息时感到舒适。Go 总是记录以下内容:

-

被牵连的并发 goroutine:这里是主 goroutine 和 goroutine 7。

-

代码中出现访问的地方:在本例中,是第 9 行和第 10 行。

-

创建这些 goroutine 的时间:goroutine 7 是在

main()中创建的。

注意在内部,竞争检测器使用向量时钟,这是一种用于确定事件部分顺序的数据结构(也用于分布式系统,如数据库)。每一个 goroutine 的创建都会导致一个向量时钟的产生。该工具在每次存储器访问和同步事件时更新向量时钟。然后,它比较向量时钟以检测潜在的数据竞争。

竞争检测器不能捕捉假阳性(一个明显的数据竞争,而不是真正的数据竞争)。因此,如果我们得到警告,我们知道我们的代码包含数据竞争。相反,它有时会导致假阴性(遗漏实际的数据竞争)。

关于测试,我们需要注意两件事。首先,竞争检测器只能和我们的测试一样好。因此,我们应该确保针对数据竞争对并发代码进行彻底的测试。其次,考虑到可能的假阴性,如果我们有一个测试来检查数据竞争,我们可以将这个逻辑放在一个循环中。这样做增加了捕获可能的数据竞争的机会:

func TestDataRace(t *testing.T) {

for i := 0; i < 100; i++ {

// Actual logic

}

}

此外,如果一个特定的文件包含导致数据竞争的测试,我们可以使用!race``build标签将其从竞争检测中排除:

//go:build !race

package main

import (

"testing"

)

func TestFoo(t *testing.T) {

// ...

}

func TestBar(t *testing.T) {

// ...

}

只有在禁用竞争检测器的情况下,才会构建该文件。否则,整个文件不会被构建,所以测试不会被执行。

总之,我们应该记住,如果不是强制性的,强烈推荐使用并发性为应用运行带有-race标志的测试。这种方法允许我们启用竞争检测器,它检测我们的代码来捕捉潜在的数据竞争。启用时,它会对内存和性能产生重大影响,因此必须在特定条件下使用,如本地测试或 CI。

下面讨论与和执行模式相关的两个标志:parallel和shuffle。

11.3 #84:不使用测试执行模式

在运行测试时,go命令可以接受一组标志来影响测试的执行方式。一个常见的错误是没有意识到这些标志,错过了可能导致更快执行或更好地发现可能的 bug 的机会。让我们来看看其中的两个标志:parallel和shuffle。

11.3.1 并行标志

并行执行模式允许我们并行运行特定的测试,这可能非常有用:例如,加速长时间运行的测试。我们可以通过调用t.Parallel来标记测试必须并行运行:

func TestFoo(t *testing.T) {

t.Parallel()

// ...

}

当我们使用t.Parallel标记一个测试时,它与所有其他并行测试一起并行执行。然而,在执行方面,Go 首先一个接一个地运行所有的顺序测试。一旦顺序测试完成,它就执行并行测试。

例如,以下代码包含三个测试,但其中只有两个被标记为并行运行:

func TestA(t *testing.T) {

t.Parallel()

// ...

}

func TestB(t *testing.T) {

t.Parallel()

// ...

}

func TestC(t *testing.T) {

// ...

}

运行该文件的测试会产生以下日志:

=== RUN TestA

=== PAUSE TestA // ❶

=== RUN TestB

=== PAUSE TestB // ❷

=== RUN TestC // ❸

--- PASS: TestC (0.00s)

=== CONT TestA // ❹

--- PASS: TestA (0.00s)

=== CONT TestB

--- PASS: TestB (0.00s)

PASS

❶ 暂停TestA

❷ 暂停TestB

❸ 运行TestC

❹ 恢复TestA和TestB

TestC第一个被处决。TestA和TestB首先被记录,但是它们被暂停,等待TestC完成。然后两者都被恢复并并行执行。

默认情况下,可以同时运行的最大测试数量等于GOMAXPROCS值。为了序列化测试,或者,例如,在进行大量 I/O 的长时间运行的测试环境中增加这个数字,我们可以使用的-parallel标志来改变这个值:

$ go test -parallel 16 .