文章侧重点

将单目标追踪中效果好的SiamRPN++作为基础,然后将其拓展到RGB-T追踪中。

- 针对双模态中的模态融合问题,SiamCDA分别设计了CA-MF模块融合RGB-TIR的模态特征;

- 针对融合RPN网络生成的K个anchor及其预测位置和置信分数,提出DAS模块挑选出最合适的那个anchor作为预测结果。

网络结构

如图所示,SiamCDA的网络结构主要有两个分支,模板处理分支和当前帧处理分支。具体的处理流程如下:

-

输入:第一帧的RGB-TIR对和当前帧的RGB-TIR对。

-

第一步:模态特征提取:与SiamRPN++的设置一致,这里backbone为ResNet50,将后三段的特征图保留下来,用一个特征金字塔网络生成相同纬度的特征。如下图所示,分别得到第一帧的三阶段RGB特征、三阶段TIR特征和当前帧的三阶段RGB特征、三阶段TIR特征。

-

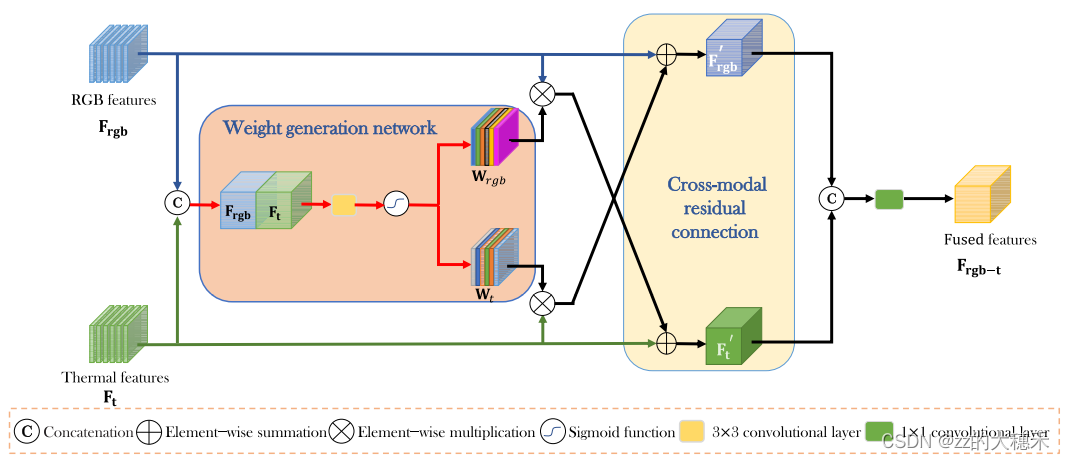

第二步:多模态融合——CA-MF模块:用这样一个加权方式,还交叉把RGB-TIR的特征相加,最后生成一个融合的特征。第一帧的RGB特征、TIR特征和当前帧的特征、TIR特征分别这样融合,得到第一帧的三阶段融合特征和当前帧的三阶段融合特征。

-

第三步:Region Proposal网络生成k个anchor,并对其用分类分支和回归分支生成对应的响应图:这里的操作是,对于前面融合的结果:第一帧的三阶段融合特征和当前帧的三阶段融合特征,分别对三个阶段的融合特征应用Region Proposal网络生成k个anchor,然后用分类分支和回归分支生成对应的响应图。根据SiamRPN++中融合这三个阶段各自生成的响应图,得到一个总的响应图,包含(x,y,w,h,score)。

-

第四步:选出最佳候选框:

1. 置信度超过0.3的候选框留下;

2. 通过非极大值抑制(NMS)的候选框留下;

3. 通过尺度和纵横比惩罚、余弦窗惩罚,将置信分数最高的框作为“太子框”;

4. 如果此时留下的框个数只有1个了,即“太子框”为预测框;如果还有不止一个框,则:

4.1 如果“太子框”与上一帧的框的交并比大于等于0.2,就选“太子框”为预测框;

4.2 如果“太子框”与上一帧的框的交并比小于0.2,就从剩下的其它框,就选其它框中与上一帧的框的交并比大于等于0.7的框且置信度最高的那个。

训练策略

因为Siamese网络离线训练的部分多,非常依赖训练数据的大规模和丰富性。文中自己通过合成数据(根据RGB图片、视频合成TIR;根据TIR图片、视频合成RGB)建立了一个大规模数据集LSS。整个模型的训练过程分为两阶段:

- 第一阶段:忽略热红外网络分支和多模态融合网络,构建单一模态的追踪网络:采用RGB追踪中的数据集:ImageNet VID、Youtube-BB、COCO、ImageNet Det作为训练集;

- 第二阶段:RGBT训练:固定所有RGB的处理分支的参数。在GTOT上测试时,训练集使用LSS、RGBT234、KAIST;在RGBT234上测试时,训练集使用LSS、GTOT、KAIST。

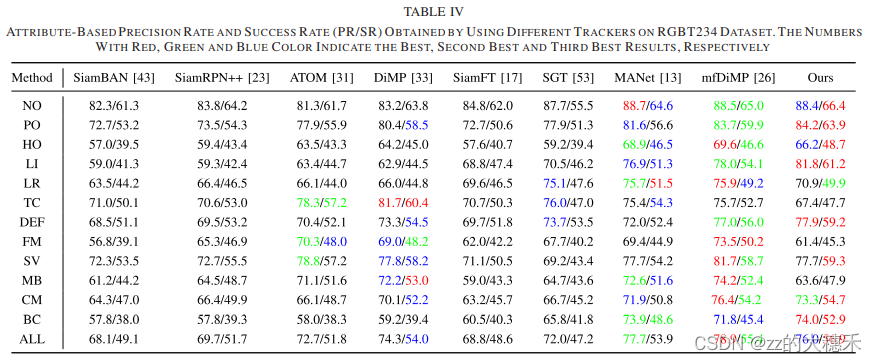

RGBT234结果(精度Precision Rate/成功率Success rate)

看看就完事,连2019年的mfDiMP都不太能打得过。可能只有强强可以。