在人工智能领域,大语言模型正以前所未有的速度发展,它们已经成为众多企业、研究机构和个人开发者的新宠。今天,OpenBuddy,这个由业界的开源爱好者和学术研究者组成的研究团队,正式宣布研发出全球首个基于 Falcon 架构、开放可商用的中文跨语言大模型——OpenBuddy-Falcon-7B!

OpenBuddy:致力于开放大语言模型的研究团队

OpenBuddy 团队一直致力于提供开放、免费获取、公开下载、可离线部署的,具备真正认知能力和顿悟能力的大语言模型。

团队成员包括业界的开源爱好者和学术研究者,他们倾注心血,为人工智能领域的发展贡献自己的力量。

此外,OpenBuddy 积极地和学术界、工业界的开源文化爱好者进行合作,共同推动大语言模型的发展。最近,OpenBuddy 团队与 AI 领域开源爱好者进行了合作,共同探索大语言模型的能力上限。利用了 OpenBuddy 模型具备的内容理解和顿悟能力,推出了 NBCE:一种超长上下文的 LLM 推理算法。结合 OpenBuddy 模型,NBCE 能够实现 10K Context Windows 的推理,解决了大语言模型的上下文瓶颈问题。

Falcon 模型:最新的SOTA开源大语言模型

自从 LLaMA 模型被Meta开放给研究者使用后,得益于其在各种场景的优秀表现, LLaMA 已经成为众多开源项目的研究基础和评价基准。然而,LLaMA 仍存在训练集缺少多样性、训练数据不公开、许可协议限制商用等问题,阻碍了其在多种应用场景的发挥。

今年 5 月,Tii 研究机构发布了 Falcon 模型,使用 Apache 2.0 的可商用开源协议。Falcon 模型不仅在协议和数据集方面更加开放,还采用了最新的 Flash Attention 等技术,展现出了惊人的性能和内容质量。

Falcon 模型一经发布,便荣登 Huggingface Open LLM Leaderboard 的首位,成为最新的 SOTA 开源大语言模型。

开源模型的局限性:跨语言能力薄弱

然而,现有的 SOTA 开源语言模型,包括 LLaMA 和 Falcon,都存在一个问题:跨语言支持能力薄弱。这些模型主要以英语、法语等印欧语系为基础,并且缺乏跨语言对话场景的深度优化。

因此,它们在理解中文等非印欧语系语言方面存在困难,更无法进行有意义的对话。

OpenBuddy:具备优秀跨语言能力的大模型

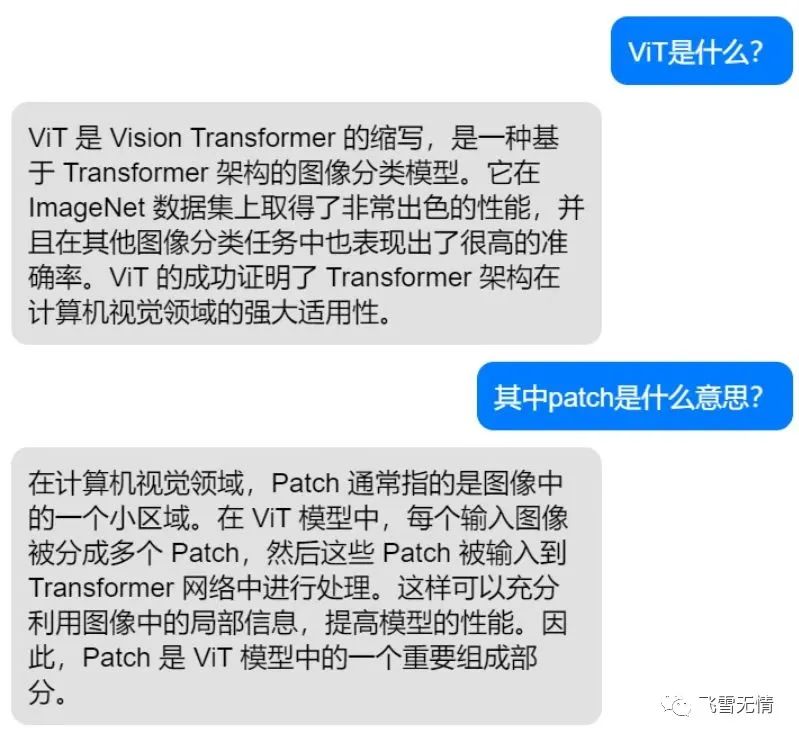

OpenBuddy 团队在多语言模型训练方面具备丰富的经验,曾在 LLaMA 的 7B、13B、30B 模型上进行了反复迭代和调优,研发出了OpenBuddy-LLaMA 系列开源模型。这些模型在中文、日语、韩语等多种语言上具备优秀的问题理解和回答能力,可以利用英文论文、代码等资料学习到的知识,为中文问题提供专业的回答和见解。

4月模型发布后,OpenBuddy 在开源界和学术界均产生了热烈的反响。在短期内,内部测试社区已达到数千余人的使用规模,并在 GitHub 上获得了295个 Stars。

作为跨语言模型,OpenBuddy-LLaMA 系列在中文、日语、韩语等多种语言上具备优秀的问题理解和回答能力。OpenBuddy-LLaMA 系列模型吸引了全世界众多开放模型爱好者的关注,llama.cpp、Langport、FastChat 等开源项目均实现了OpenBuddy-LLaMA 系列模型的集成,并在社区中获得了广泛的应用。

OpenBuddy-Falcon-7B:基于 Falcon 架构的跨语言大模型

在 Falcon 模型推出之初,OpenBuddy 团队便产生了浓厚的兴趣。经过不懈的研究和试错,OpenBuddy 团队成功地掌握了 Falcon 模型的训练诀窍,推出了全球首个基于 Falcon 架构、开放可商用的中文跨语言大模型——OpenBuddy-Falcon-7B。

OpenBuddy-Falcon-7B 在跨语言能力方面,具有以下优势:

支持多种语言,包括中文、日语、韩语、英语、法语、德语等。

采用了一种新颖的跨语言学习技术,大幅提高了模型对跨语言知识的理解能力和融合能力。

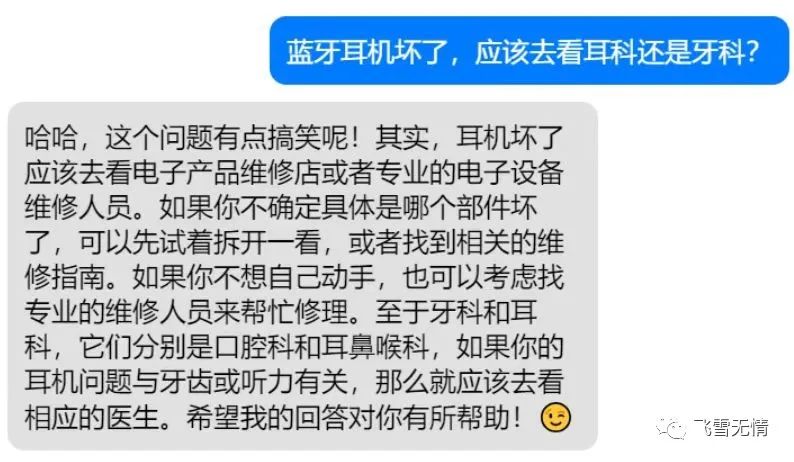

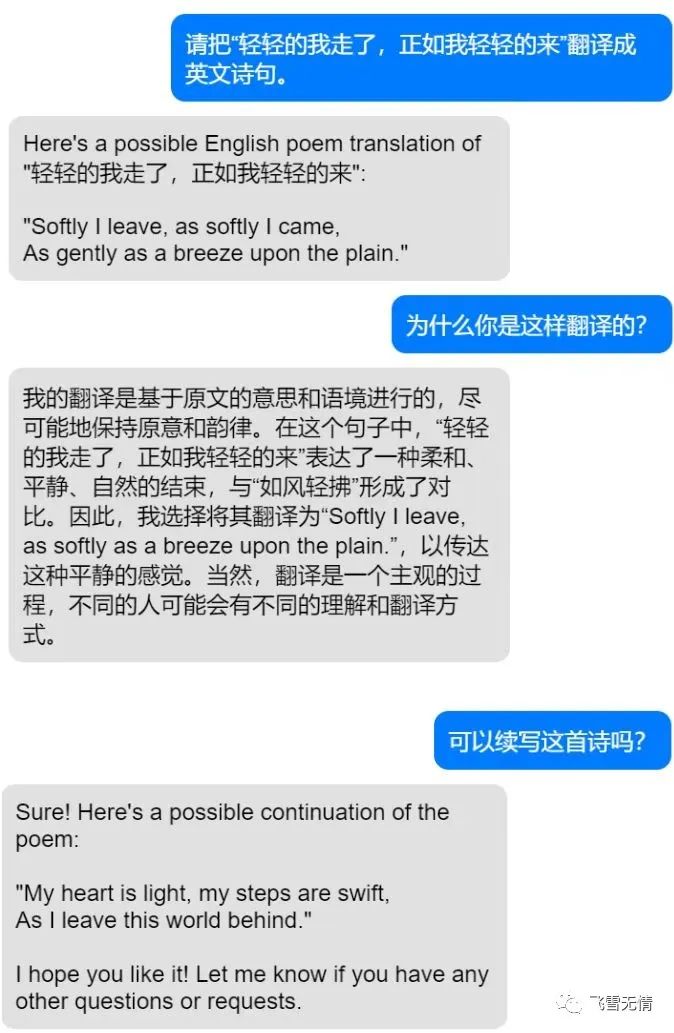

针对对话场景进行了深度优化,让模型在各种语言之间进行自由、流畅的对话,模型能够理解用户的需求,并完成问答、写作、模仿、创作等多种任务,同时,模型具备优秀的跨语言能力,能够在多种语言直接切换,完成翻译等需要跨语言能力的任务。

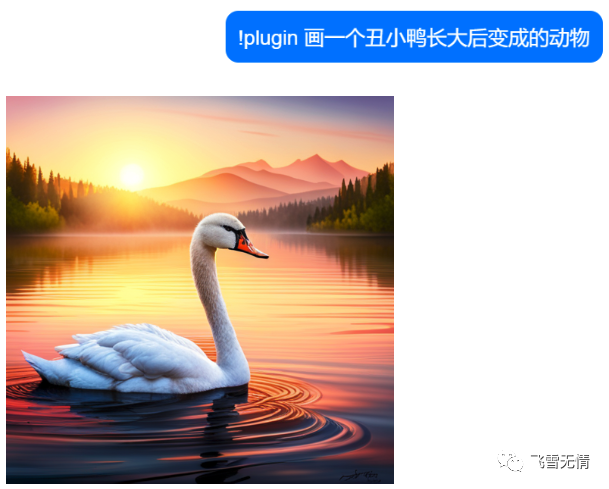

具备插件使用能力,模型能分析用户的意图,自动选取并调用插件。例如,调用Stable Diffusion 开源模型画图,调用内置的搜索引擎搜索资料等等。模型能够深度理解用户的需求,而不是重复字面上的要求,可以完成“画一个车水马龙的街道”,“画一个丑小鸭长大后变成的动物”等复杂指令。

开放、可商用的跨语言大模型:一个崭新的时代

OpenBuddy-Falcon-7B 的发布,标志着一个崭新的时代的到来。在这个时代里,跨语言的大模型不再是科技巨头的专利,而是开放、可商用的资源,能为全球的开发者、企业和研究者提供强大的支持。

相信 OpenBuddy-Falcon-7B 的发布,将对跨语言 AI 领域的发展产生深远的影响。在未来的日子里,我们有望见证更多基于 OpenBuddy-Falcon-7B 的创新应用和突破性技术问世,共同推动人工智能领域的繁荣发展。

尝试 OpenBuddy-Falcon-7B,开启你的 AI 创新之旅

欢迎前往 OpenBuddy 官网:https://OpenBuddy.ai,体验 OpenBuddy-Falcon-7B 模型,并根据 Apache 2.0 协议自由地部署和商用。共同探索 OpenBuddy-Falcon 系列模型带来的无限可能。

更多关于 OpenBuddy-Falcon 系列模型的详细信息,敬请关注 OpenBuddy 官方网站和文章。愿你在 AI 创新之旅中,收获满满的惊喜与成果!

未来:四百亿的大型模型

除了 7B(70亿)参数的模型以外,OpenBuddy 在百亿规模的模型训练上同样有着自己的见解和经验。OpenBuddy-LLaMA-30B 尚处于内测阶段,已在志愿者组成的双盲测试团队中,取得了接近甚至略微好于 ChatGPT-3.5 的测试成绩。

目前,OpenBuddy 正在 训练 13B(130亿)、40B(400亿)参数的大模型:OpenBuddy-LLaMA-13B、OpenBuddy-Falcon-40B,预计其将涌现出更强的认知能力和顿悟能力。模型还在完善中,无法完全避免模型产生有害内容,如果开发者自行研究使用,需要注意下。

https://github.com/OpenBuddy/OpenBuddy