前言:

上一节我们提到采用标记新旧数据的数据状态来快速整理需对比的数据,再选择性插入更新来保证数据的完整性。强强联合,保证了数据的高效和可用。

但是日常中,也存在部分场景,我们表输入是没有唯一性主键的,我们无法判断哪些数据有更新和插入,但我们又不能用裁剪表来直接删除后再更新,这时候我们该如何是好。很多人会想到,那就提高算力,提高数据处理速度就好,在1秒时间内完成100万数据的处理。理论上是可行,但是正如ChatGpt的发展会受到算力的制约一样,我们来分析下,怎么通过调整数据处理策略来提高效率并保证数据的可用性。

一、AI转移

1、极简数据源

因为我们没办法去提高主键,导致我们只能采用全量更新的方式来处理数据,因此我们需要将数据表输入的时间转移,我们只能在极端的时间内完成数据的更新,通常在1s内,因此表输入的读取时间是不允许超过0.2秒的,此时我们需保证表输入的SQ是select * from table。

其中的table而且数据量不能太大,只能保存需插入更新的数据,并且表输入不能包含任何where条件加字段计算等来增加耗时。因此此时的数据源是极简的。

2、AI转移

我们知道在数据处理还有一个江湖必杀技叫“空间换时间”。所谓的空间换时间,就是将整个数据步骤进行拆分,将每个步骤的数据都保存下来,保证每一步都是最高效的。因此也叫做1+1>2。此时的整体思路就是将我们需要更新的数据,保存至另外一个表里面。然后我们删除更新时间段的数据,然后再进行数据的插入。

因此整个过程变成了,更新数据输入+更新时间段数据删除+更新数据输出。因为不涉及数据的更新操作,操作效率还是非常高的,下面我们详细讲解下实现过程。

二、多线程算力分解

1、历史数据输入

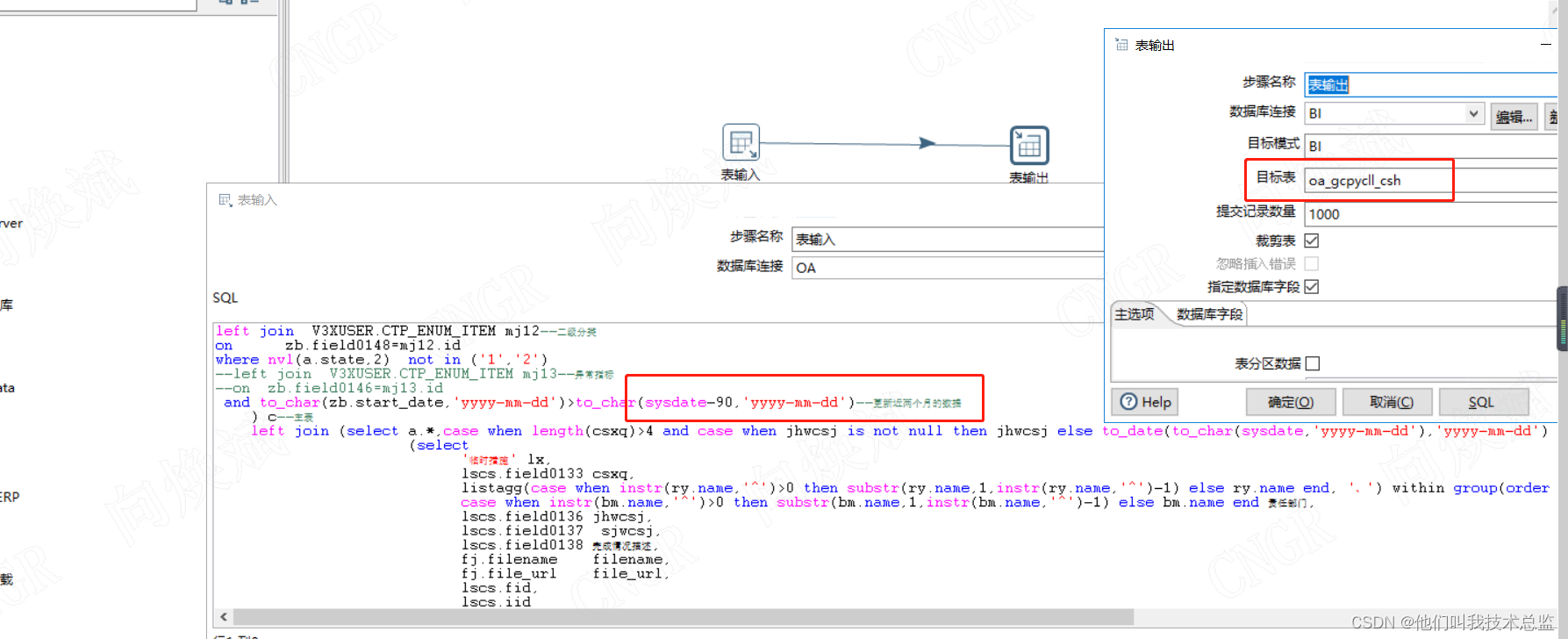

如下图所示,我们表输入是个很复杂的SQ逻辑,此时单单数据读取耗时都会在5-10分钟左右,因此在这种超复杂的应用场景下。我们保证数据的高效和完整体现的特别重要。

如下图所示我们只需要更新近90天的数据即可,根据实际要求来调整,即一般业务一个月以后就会关账,就不允许修改历史数据了。如何所示将需更新数据保存至oa_gcpycll_csh表中。

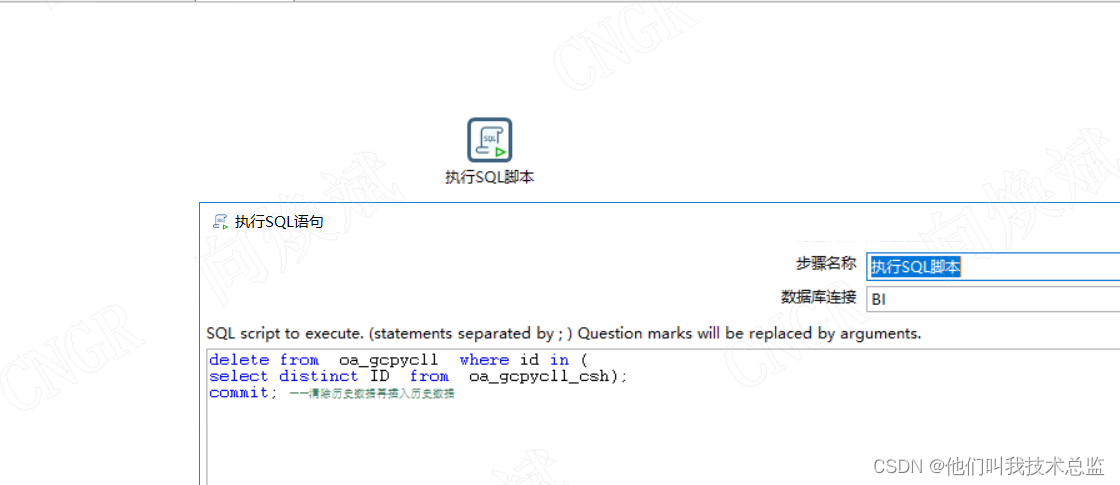

2、更新时间段数据删除

如下图所示,将更新时间数据从目标表删除,在此次转换中,表名为oa_gcpycll,对应参考代码如下所示,其中id是一个主表中的id并不是唯一的。

delete from oa_gcpycll where id in (

select distinct ID from oa_gcpycll_csh);

commit; --清除历史数据再插入历史数据3、更新数据输出

最后我们将更新数据输出至目标表oa_gcpycll,对应操作如下图所示。

三、总结

这种自定义组合的方式,可以解决因计算复杂的表输入逻辑,导致我们更新数据时,找不到合适主键的场景,通过一个中间表来存储更新的数据,从而将数据处理时间封闭至另外一个空间,不再影响目标表的性能。因此我们可以根据我们实际业务场景来是否选择这种方式来处理复杂的数据处理场景。

通过拆分步骤不仅解决了性能问题,而且极大的降低了对算力的要求,希望你能喜欢。下一节将介绍,使用kettle处理接口文件,欢迎持续关注,一起学习~