本文来源 机器之心 作者:梁楚盟,吴晓宇

本文介绍的是一篇收录于 ICML 2023 Oral 的论文,论文由位于上海交通大学的上海市可扩展计算与系统重点实验室、纽约大学和贝尔法斯特女王大学的华扬老师共同完成。论文的共同一作是即将攻读南加州大学博士学位的梁楚盟和上海交通大学的研究生吴晓宇。

自开源 AI 图像生成模型 Stable Diffusion 发布以来,数字艺术创作进入了一个全新的阶段。Textual Inversion,Dreambooth 和 LoRA 等多种以 Stable Diffusion 为基础的模型微调技术催生了大量能够创作特定风格绘画作品的艺术「私炉」。这些「私炉」能够从多则几十张少则几张的绘画作品中训练学习其艺术风格或内容,并模仿这些风格、内容创作新的作品。这些技术使得每个人都能以较低的成本创造自定义的绘画作品。

然而,这些微调技术却饱受绘画创作者们的非议和批评。在创作者们看来,「私炉」产出的绘画作品更像是在人类绘画作品的基础上进行移花接木,是一种「高明的抄袭」。更有人利用此类技术专门模仿特定画手的风格生产画作,并以此在网络上对画手本人进行攻击。一些创作者选择从互联网上撤下自己的画作,通过物理隔绝的方式避免画作被用于训练 AI。

最近的一项工作提出了一个避免绘画作品被用于 AI 模型微调训练的算法框架「AdvDM」。通过在画作中添加像素级的微小水印,该框架能够有效误导当前的模型微调技术,让模型无法从画作中正确地学习其艺术风格和内容并进行模仿创作。在相关法律法规尚不完善的当下,这一技术能够成为艺术创作者保护自身权益、对抗 AI 滥用行为的工具。

论文地址:https://arxiv.org/abs/2302.04578

项目主页:https://mist-project.github.io/

开源地址:https://github.com/mist-project/mist

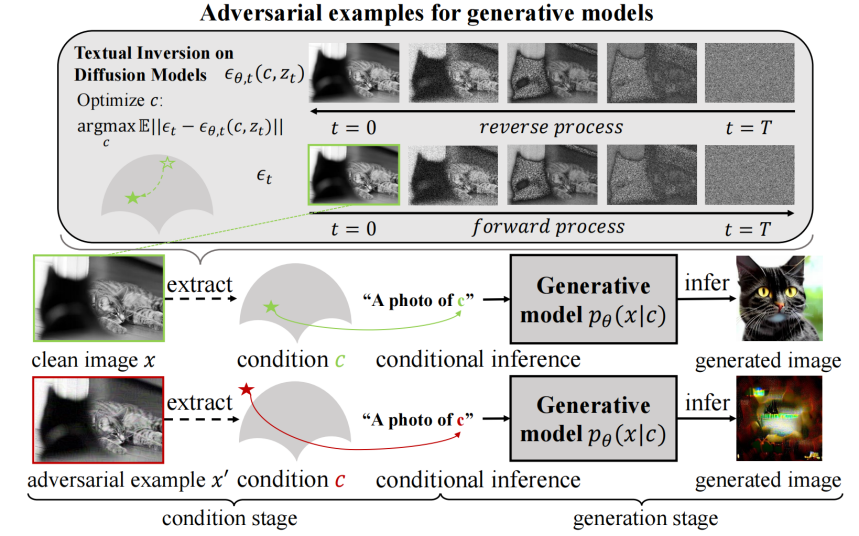

在扩散模型中定义对抗样本

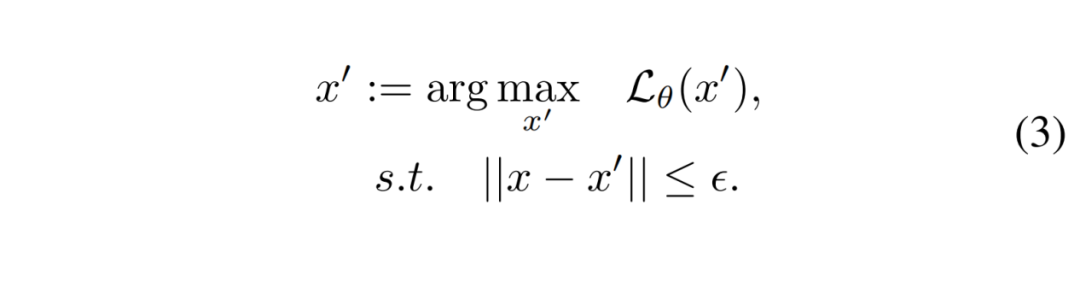

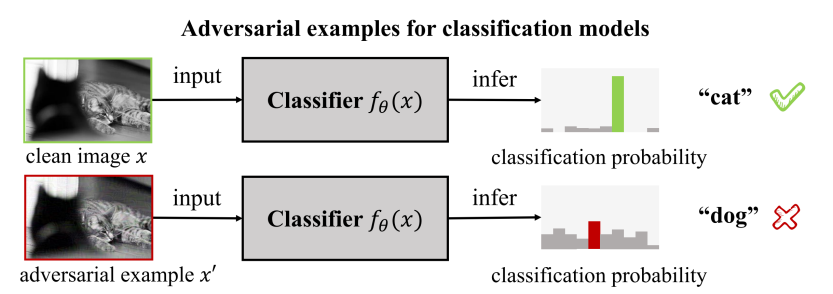

在传统图像分类任务中,对抗样本是一类被广泛研究的图像。它们和真实图像的最大差距仅有几个像素值,这一差距常常无法被人眼所识别。但图像分类的 AI 模型却会将其错误地分类。这类样本的定义由下面的公式给出:

直白地说,对抗样本是经过一点微小扰动的真实图像。这个扰动的方向由最大化模型分类损失函数的方向确定。也就是说,将真实图像向模型分类正确的反方向推动一点点。在具体操作时,推动的最大像素值的上限受到严格限制。这保证了人眼难以识别这种扰动。例如:下图中绿色方框内的猫和红色方框内的猫在人类视觉下几乎完全一样。然而,实验证明,即使是一点极其微小的像素扰动也足以让分类模型判断错误:下图中红色方框内的猫在分类模型看来是一只狗。

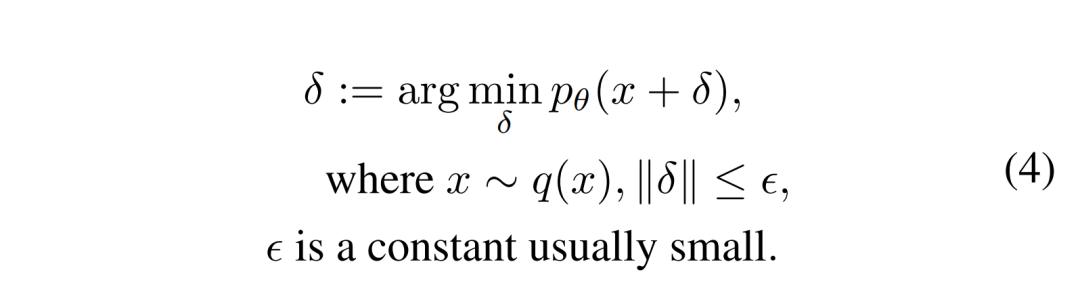

不难发现,让画作不被扩散模型通过微调正确学习的想法和对抗样本的概念有许多相似之处:它们同样要求模型在特定图像上无法完成给定任务,它们也同样不希望显著改变图像在人类视觉下的内容。受到对抗样本的启发,作者在扩散模型乃至生成模型的语境中给出对抗样本的定义:

公式中的 来自于生成模型的建模。和图像分类任务不同,图像生成任务是一个从一批训练数据集中学习怎么生成类似图像的过程。其中不存在(图像,类别)这样的输入 - 输出对。因此,无法直接通过给定输入纠正输出的方式来对模型进行训练。作为替代,生成任务通过模型参数 θ 定义了特定图像样本 x 在模型看来属于真实图像的概率

来自于生成模型的建模。和图像分类任务不同,图像生成任务是一个从一批训练数据集中学习怎么生成类似图像的过程。其中不存在(图像,类别)这样的输入 - 输出对。因此,无法直接通过给定输入纠正输出的方式来对模型进行训练。作为替代,生成任务通过模型参数 θ 定义了特定图像样本 x 在模型看来属于真实图像的概率 。对于训练数据集中的图像,作者自然希望其

。对于训练数据集中的图像,作者自然希望其 越大越好,最好无限接近于 1。因此,在训练数据集的图像 x 上最大化

越大越好,最好无限接近于 1。因此,在训练数据集的图像 x 上最大化 就成了训练生成模型最常用的优化目标。

就成了训练生成模型最常用的优化目标。

而站在对抗样本的视角,一个自然的想法是:对于一个训练好的生成模型,如果图像 的

的 非常小,那么说明模型不认为

非常小,那么说明模型不认为 是一张真实图像。因此,模型无法从自己已有的知识库中找到能够有效匹配图像

是一张真实图像。因此,模型无法从自己已有的知识库中找到能够有效匹配图像 的内容的相关信息,进而无法有效描述这张图像上的内容。模型不认识

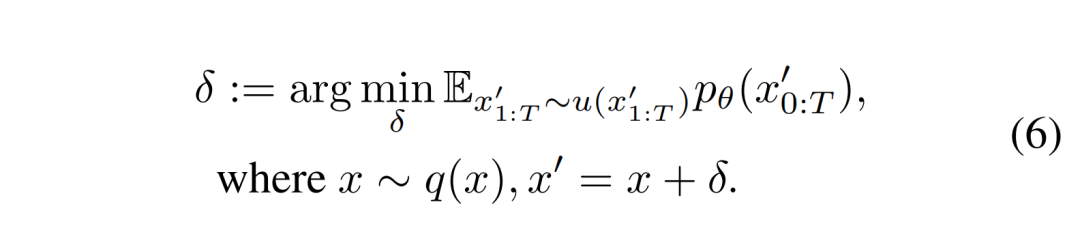

的内容的相关信息,进而无法有效描述这张图像上的内容。模型不认识 上的内容,自然也就无法正确复刻其艺术风格。这与保护艺术作品的研究动机相合。在现实应用中,艺术创作者们需要的是能够基于真实图像 x 生成在像素距离上非常接近、人眼无法识别其区别的对抗样本。因此,寻找生成模型对抗样本的过程可以被建模为:通过给真实图像 x 上添加一层微小的像素扰动

上的内容,自然也就无法正确复刻其艺术风格。这与保护艺术作品的研究动机相合。在现实应用中,艺术创作者们需要的是能够基于真实图像 x 生成在像素距离上非常接近、人眼无法识别其区别的对抗样本。因此,寻找生成模型对抗样本的过程可以被建模为:通过给真实图像 x 上添加一层微小的像素扰动 ,最小化生成模型的

,最小化生成模型的  。最后得到的对抗样本即为最优噪声

。最后得到的对抗样本即为最优噪声 和原图 x 的加和。

和原图 x 的加和。

计算扩散模型的对抗样本

然而,优化扩散模型的对抗样本并不是一个简单的任务。在生成模型的优化中, 并不能直接通过计算得出。在最大化

并不能直接通过计算得出。在最大化 的过程中,常用的一个方案是最大化

的过程中,常用的一个方案是最大化 的一个理论下界,即证据下界(ELBO)。类似地,在对抗样本的优化过程中,也可以通过最小化的一个上界来替代最小化

的一个理论下界,即证据下界(ELBO)。类似地,在对抗样本的优化过程中,也可以通过最小化的一个上界来替代最小化 的过程。具体来说,在扩散模型中,

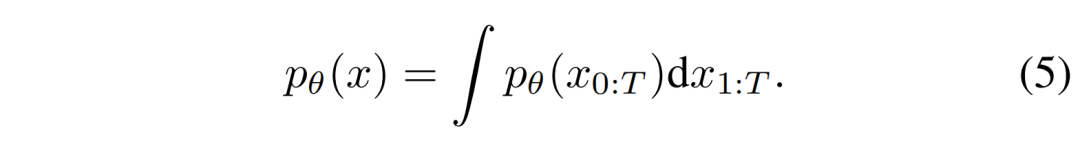

的过程。具体来说,在扩散模型中, 可展开为扩散模型中的隐变量

可展开为扩散模型中的隐变量 的积分:

的积分:

由此,可以通过蒙特卡洛方法,对隐变量 进行采样,并在采样基础上优化上式的被积函数

进行采样,并在采样基础上优化上式的被积函数 ,从而达到优化

,从而达到优化 的目的。优化目标可改写成下式:

的目的。优化目标可改写成下式:

扩散模型拥有一个非常优秀的性质:后验分布 是一个高斯分布。该分布的参数固定且与

是一个高斯分布。该分布的参数固定且与 完全独立。因此,这个分布的在对抗样本的优化过程中是不变的。在优化过程中,可以利用

完全独立。因此,这个分布的在对抗样本的优化过程中是不变的。在优化过程中,可以利用 将原优化目标改写成更易计算的形式:

将原优化目标改写成更易计算的形式:

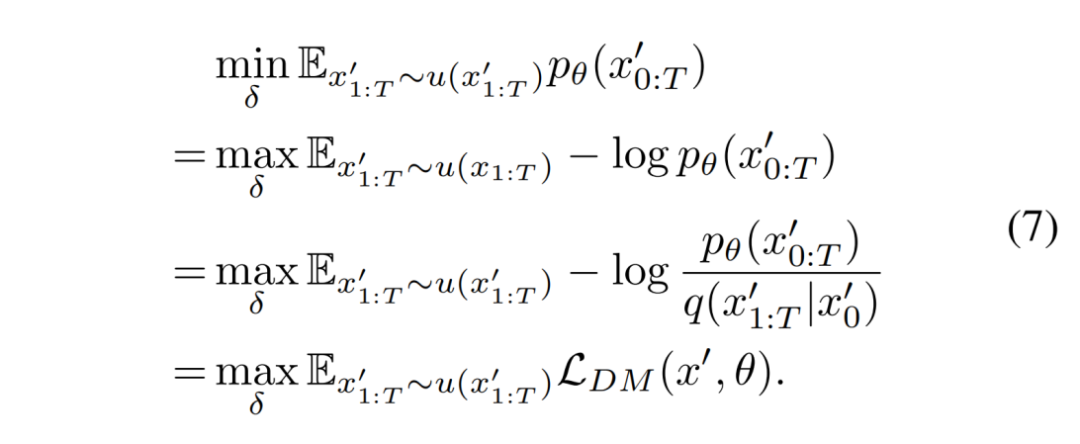

可以看到:公式(7)最后得到的目标函数形式非常类似于扩散模型训练时的损失函数。最大的区别在于优化变量的变化。在训练时,优化变量是模型参数 θ ;而在产生对抗样本时,优化变量是对抗样本上添加的扰动 。这个目标函数显然是可以直接计算的。

。这个目标函数显然是可以直接计算的。

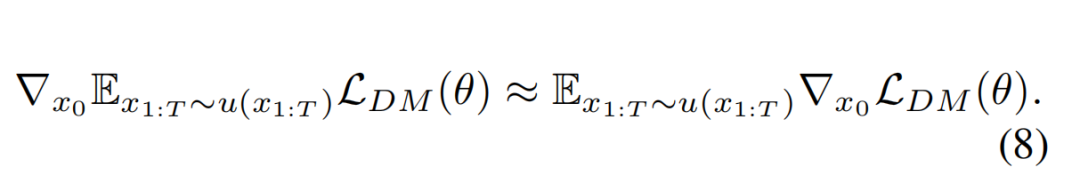

得到了优化对抗样本的目标函数之后,接下来考虑如何优化这个目标函数。而优化过程最大的难点是如何计算目标函数的梯度。很容易发现,现在的目标函数被写成了期望的形式。在计算期望的梯度时进行了一次近似:用梯度的期望近似期望的梯度,通过多次采样隐变量并计算对应采样下的 的梯度来估计

的梯度来估计 期望的梯度。

期望的梯度。

由于 由总共 T 项的单层噪声估计差异函数联合组成,作者在计算时参考扩散模型论文中给出的计算方法,在1~T的范围内均匀采样得 t,将多次采样的第 t 项函数的平均值作为

由总共 T 项的单层噪声估计差异函数联合组成,作者在计算时参考扩散模型论文中给出的计算方法,在1~T的范围内均匀采样得 t,将多次采样的第 t 项函数的平均值作为 的估计值。

的估计值。

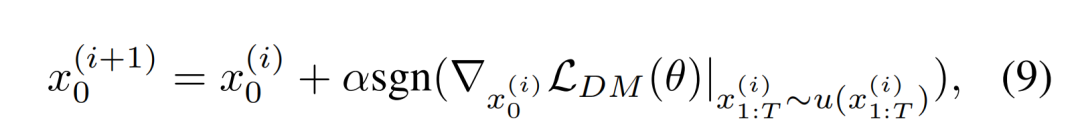

同时,在考虑对扰动 的大小进行约束时,参考了现有的对抗攻击方法的范式,即利用符号函数来约束梯度的大小。令

的大小进行约束时,参考了现有的对抗攻击方法的范式,即利用符号函数来约束梯度的大小。令 表示第步的对抗性样本。第(i+1)步的对抗性样本可以通过沿着公式(8)中梯度的方向更新单步步长

表示第步的对抗性样本。第(i+1)步的对抗性样本可以通过沿着公式(8)中梯度的方向更新单步步长 所得:

所得:

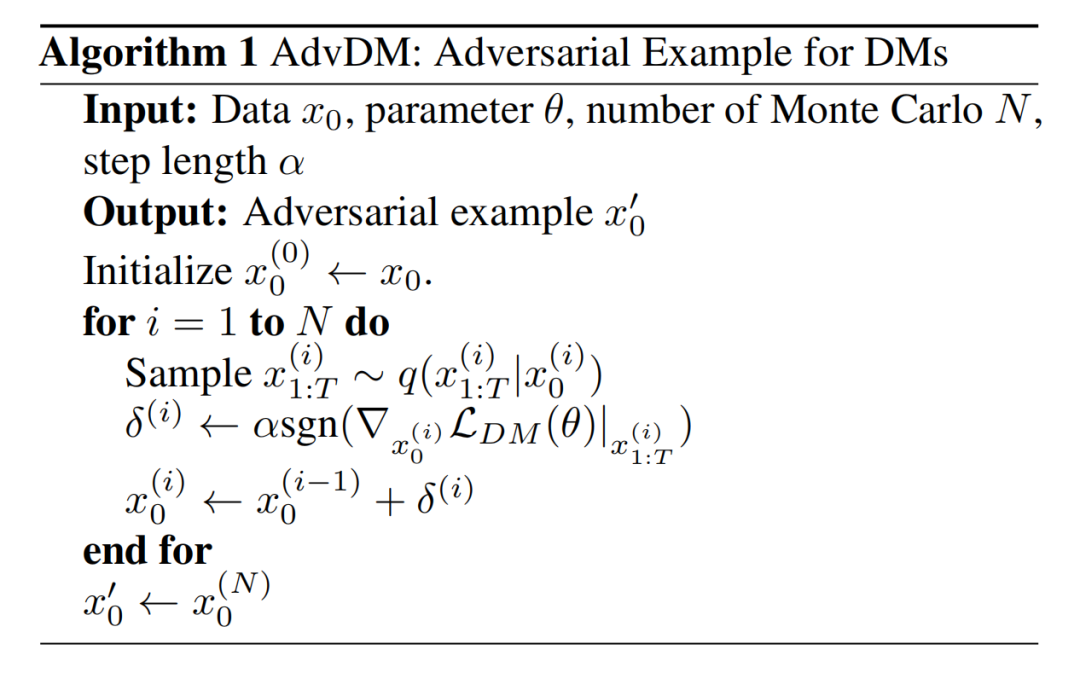

直观地说,AdvDM 算法采样不同的隐变量,并针对每个采样进行一次梯度上升。完整的算法如下:

实验结果

作者在图像内容学习和图像风格迁移两个场景下测试了 AdvDM 算法框架的效果。

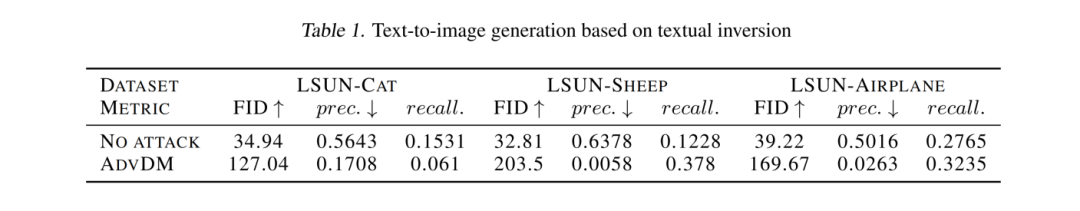

针对图像内容学习的保护

利用微调技术,扩散模型能够将一组图像中的相同物体抽取为一个概念 S*,并基于概念生成新图片。例如:通过学习一组同一只猫在森林中漫步的图片,模型能够生成这只猫在沙滩晒太阳的图片。在本实验中,作者把含有同一类物体的原图作为对照组,把原图经 AdvDM 处理后得到的对抗样本作为实验组,分别在两组图片上进行扩散模型微调训练,并利用微调中抽取的概念生成新图片。此时,比较生成图片和微调所用的训练图片的差异能够反映基于对照组和实验组图片进行模型微调的效果差别。若基于实验组生成图片与原图的差距远大于对照组中的差距,则可说明 AdvDM 算法成功阻止了模型通过微调抽取数据集中的内容。

具体实验中,作者使用了 LSUN-cat、LSUN-sheep 和 LSUN-airplane 三个单类别图像数据集。作者从每个数据集中随机抽取 1,000 张图片选作微调训练数据集。根据 Textual Inversion 微调方法的官方推荐,以每 5 张测试图片为一组抽取一个概念 S*,并用抽取的概念生成总计 10,000 张图像。作者使用 Fréchet Inception Distance(FID)和 Precision(prec.)对生成图像与原始图像的相似度进行了评估。实验结果显示在下表中。可以观察到,AdvDM 生成的对抗样本显著增加了生成的图像的 FID 值并降低了 Precision 值。这表明 AdvDM 能够有效地保护图像的内容,避免其内容概念被扩散模型抽取,并用于后续的生成。

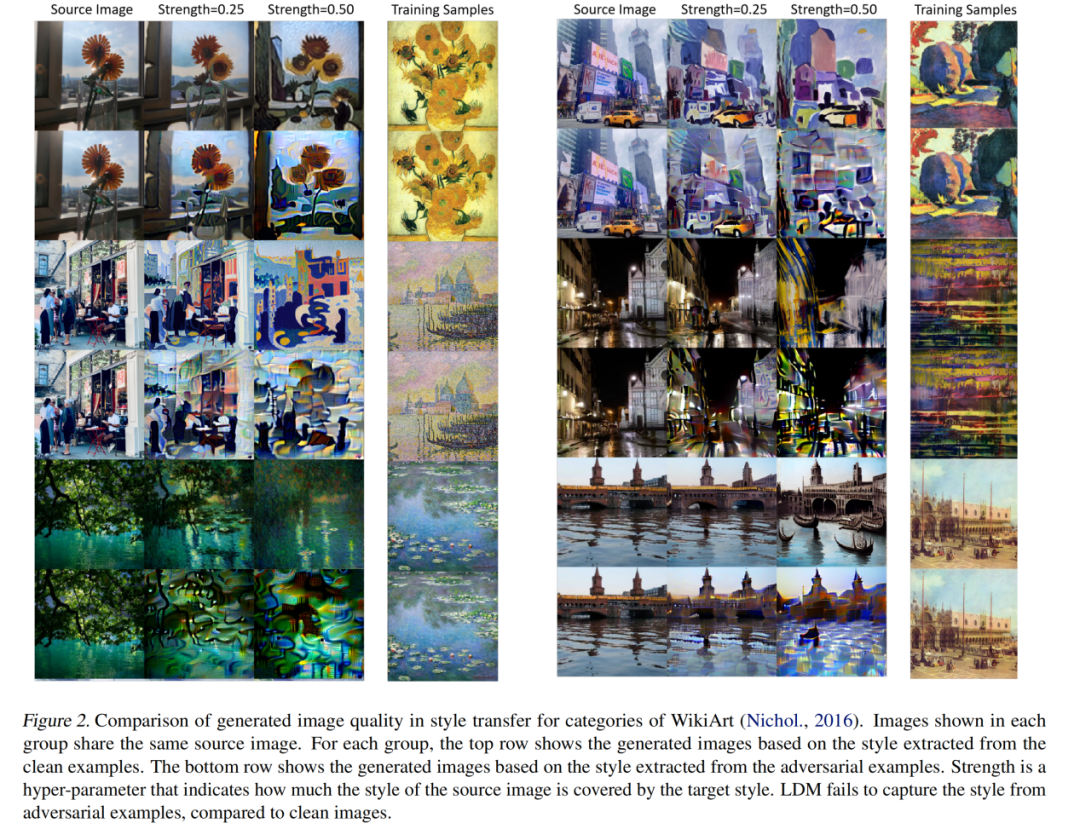

针对风格迁移的保护

另外一个受到广泛关注的重要微调场景是扩散模型支持的的艺术风格迁移。该场景通过在少量属于相同或相似艺术风格的画作图片上微调扩散模型,能够从图片数据中归纳出其共同风格的概念 S*,并基于这一概念生成具有类似风格的新图片。

针对该场景,作者在 WikiArt 数据集中选择 10 位个人风格鲜明的艺术家的画作。作者使用 AdvDM 处理这些画作,并在处理前、后的画作上分别微调扩散模型。在微调结束后,作者再通过模型学习的风格概念生成新的画作。生成对比结果如下图所示。可以观察到 AdvDM 处理后生成的图片普遍图像质量较低,具有混乱的纹理,丧失了作为艺术作品的可用性。这表明 AdvDM 可有效对抗基于扩散模型的艺术风格迁移。

近期,作者已将该工作扩展为开源应用 Mist。Mist 针对更多的微调技术和更为复杂的场景均具有较好的效果,并对去噪有一定鲁棒性。相关工作已更新在 GitHub 仓库中。

关注公众号【机器学习与AI生成创作】,更多精彩等你来读

深入浅出stable diffusion:AI作画技术背后的潜在扩散模型论文解读

深入浅出ControlNet,一种可控生成的AIGC绘画生成算法!

最新最全100篇汇总!生成扩散模型Diffusion Models

附下载 |《TensorFlow 2.0 深度学习算法实战》

《礼记·学记》有云:独学而无友,则孤陋而寡闻

点击一杯奶茶,成为AIGC+CV视觉的前沿弄潮儿!,加入 AI生成创作与计算机视觉 知识星球!