RuntimeError: CUDA runtime implicit initialization on GPU:0 failed. Status: out of memory

当我想使用多GPU进行训练模型时,出现如下报错信息:

RuntimeError: CUDA runtime implicit initialization on GPU:0 failed. Status: out of memory

step1:

import tensorflow as tf

print(tf.__version__)

print(tf.test.is_built_with_cuda())

# print(tf.test.is_gpu_available()) # 提示说tf2以后不会用这个命令来检测GPU是否可用了

# 所以使用下面的命令来查看GPU

print(tf.config.list_physical_devices('GPU'))

虽然上面代码可以正常运行,而且也说有两张显卡可以使用,但是训练模型就会报错

step2:

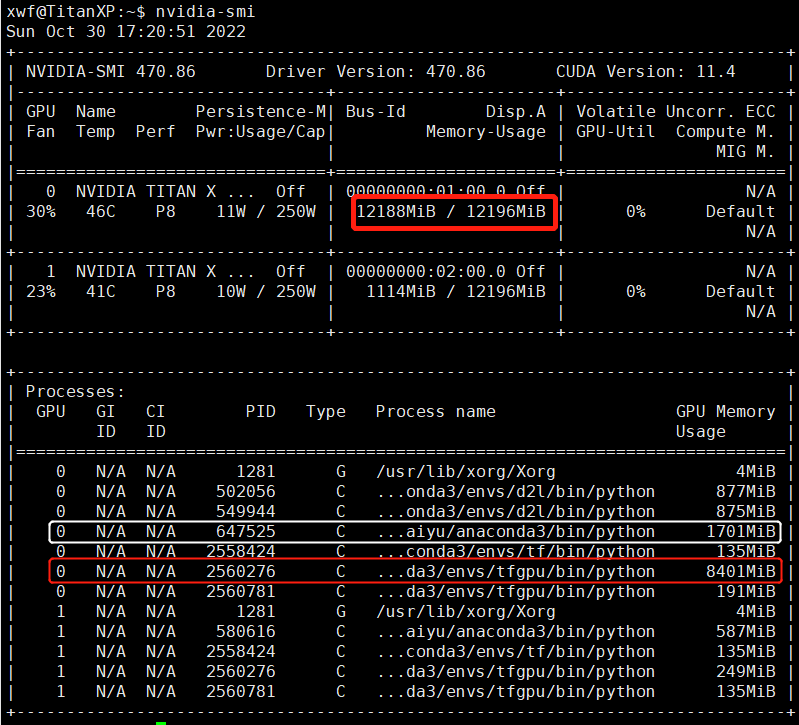

nvidia-smi

GPU-0的12G显存几乎全被占用了,并且占用最多的PID是2560276, 647525

**step3: **

kill -9 2560276 # -9是信号变量SIGKILL的代号,代表立即终止的信号

杀死占用显存多的进程即可释放显存了(注意:可用杀死自己的进程,最好不要动实验室其他人的进程!!!)