在安装过程中,可能会出现一些问题,总结一下:

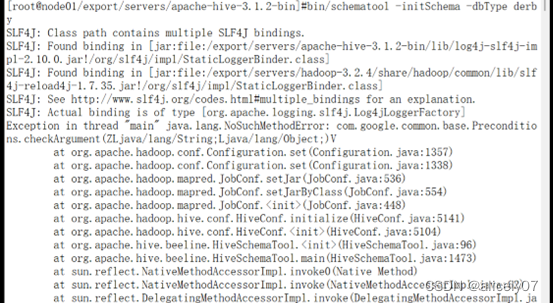

1.若Hive部署模式选择为嵌入式,初始化Derby报错:

hadoop和hive的两个guava.jar版本不一致,解决方案:

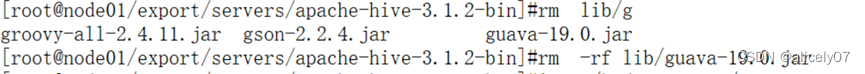

首先,删除hive里的guava.jar

然后,把hadoop中的guava-27.0-jre.jar的复制到hive

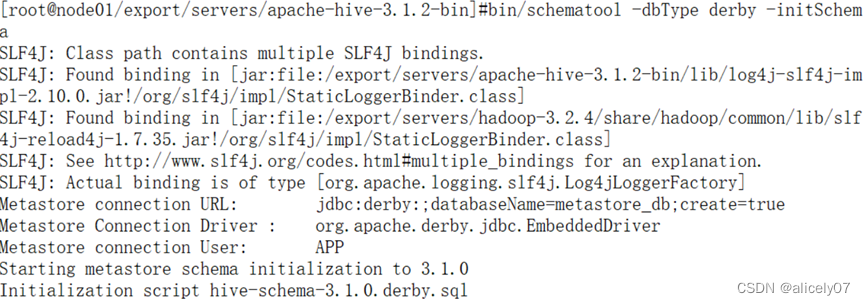

![]() 最后再回到hive, 再次初始化

最后再回到hive, 再次初始化

![]()

completed !

2.Hadoop集群:/export/servers/hadoop-3.2.4

在sbin/start-dfs.sh,stop-dfs.sh, start-yarn.sh,stop-yarn.sh头部加上几句话:

start/stop-dfs中加入:

HDFS_ZKFC_USER=root

HDFS_JOURNALNODE_USER=root

HDFS_DATANODE_USER=root

HDFS_DATANODE_SECURE_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=rootstart/stop-yarn中加入:

YARN_RESOURCEMANAGER_USER=root

HDFS_DATANODE_SECURE_USER=root

YARN_NODEMANAGER_USER=root3. sqoop

(1)sqoop import 数据至hive,利用hcatalog-database/table 报错找不到QueryResult,解决方法:将 /tmp/sqoop-root/compile/下最新返回的文件夹中的QueryResult.jar复制到 sqoop/lib

(2)sqoop export 数据至hive,报错,解决方法:与import类似,找到/tmp/sqoop-root/compile/下最新产生的文件夹,将文件夹中 *.jar、*.class、*.java 复制到sqoop/lib

一个问题待解决:若每次sqoop import数据,有QueryResults的报错,那么都需要到 /tmp/sqoop-root/compile/下找到最新产生的文件夹,然后将QueryResult.jar复制到sqoop/lib中?

是否有方法避免这个问题?欢迎各位同仁交流讨论,帮助我们解决这个问题,谢谢~~