什么是Dataflow?

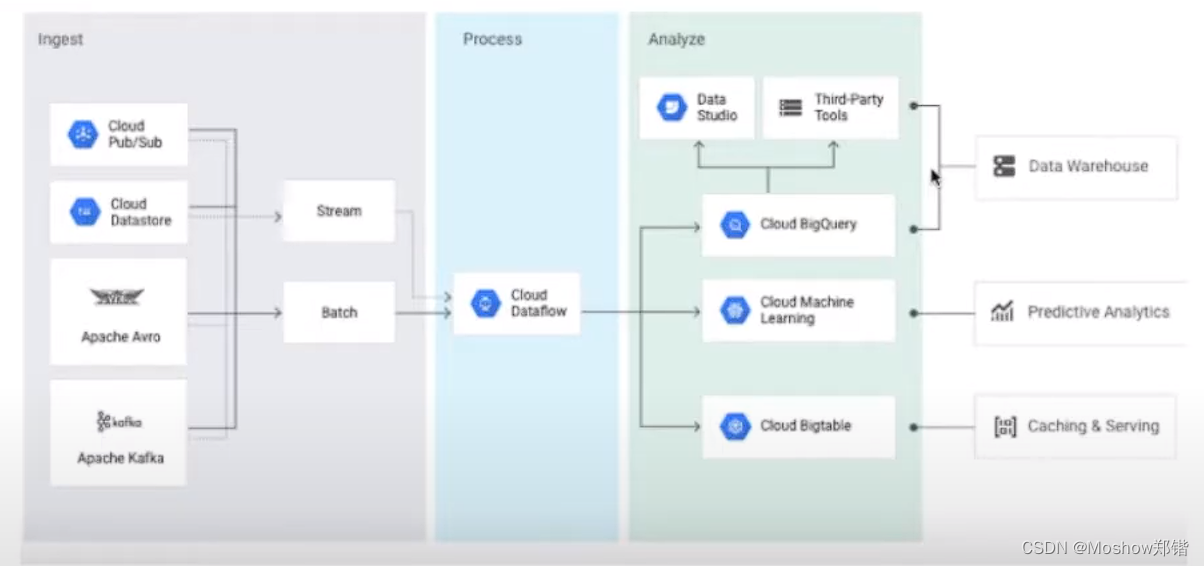

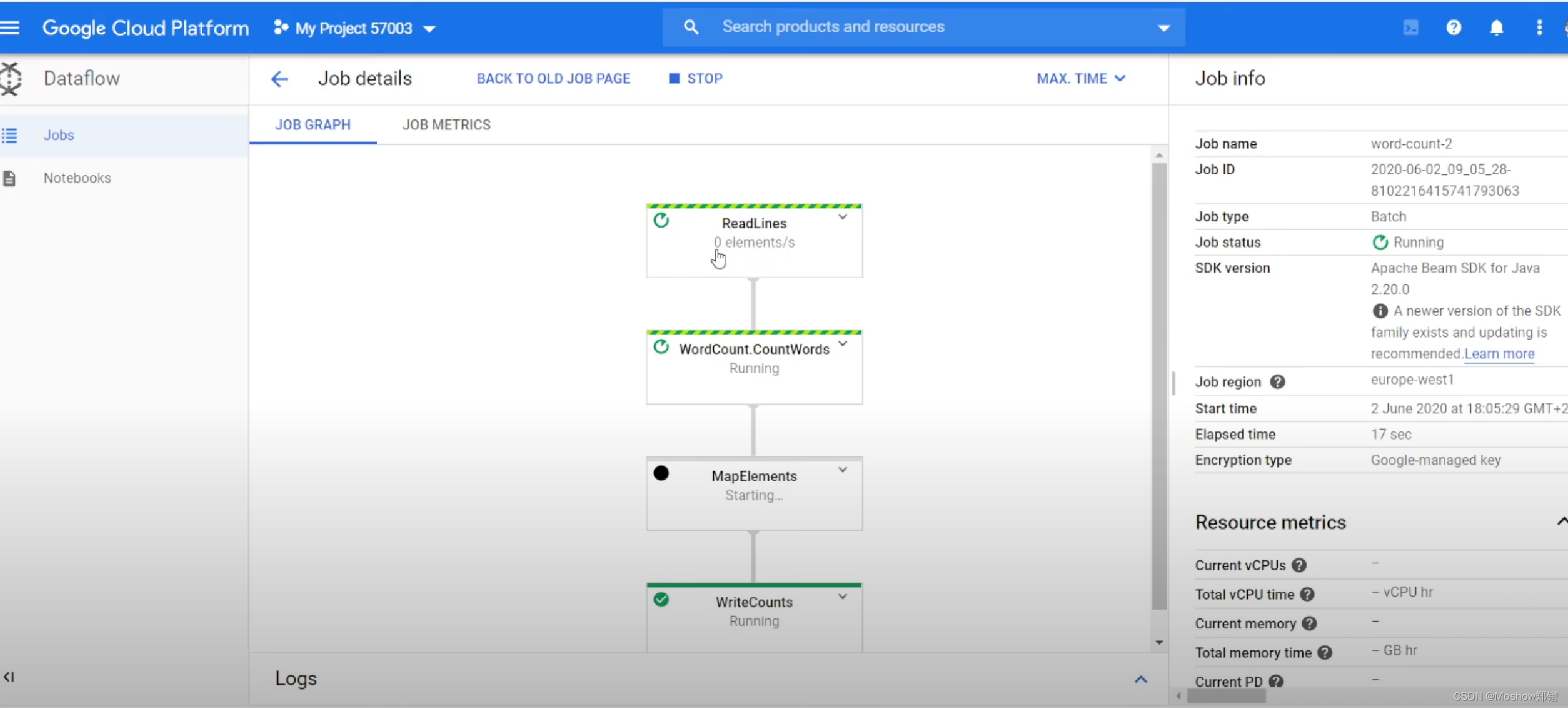

Dataflow 是一种全代管式服务,用于以流式传输(实时)和批量模式对数据进行转换并丰富数据内容。它提供了一个简化的流水线开发环境,该环境使用 Apache Beam SDK 转换传入的数据,然后输出转换后的数据。

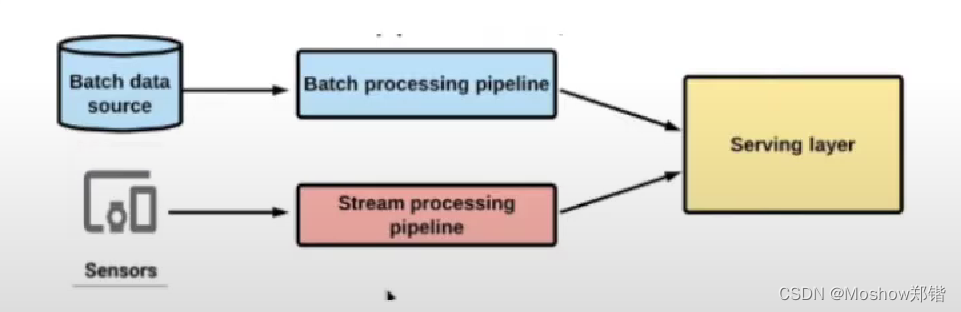

数据处理流程

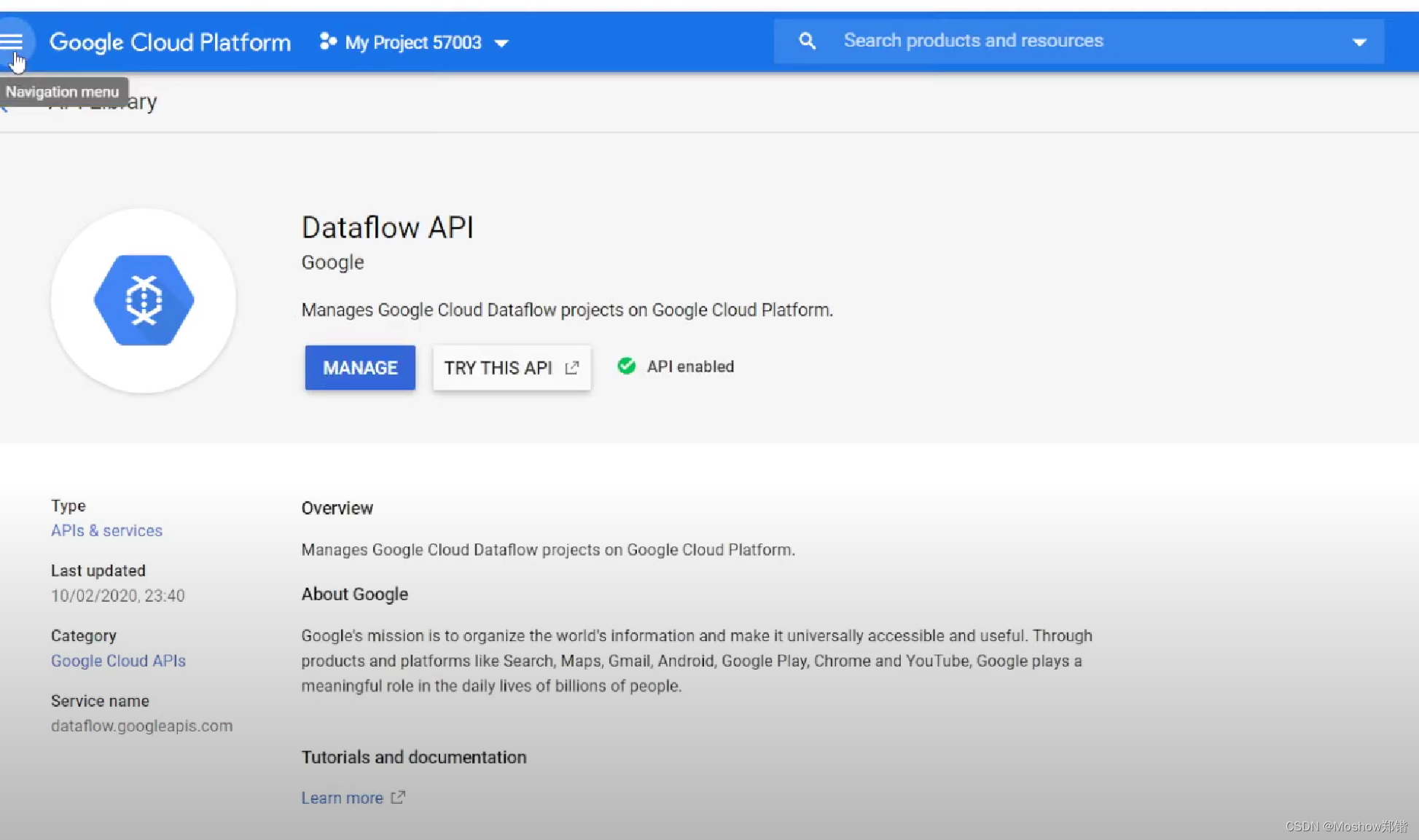

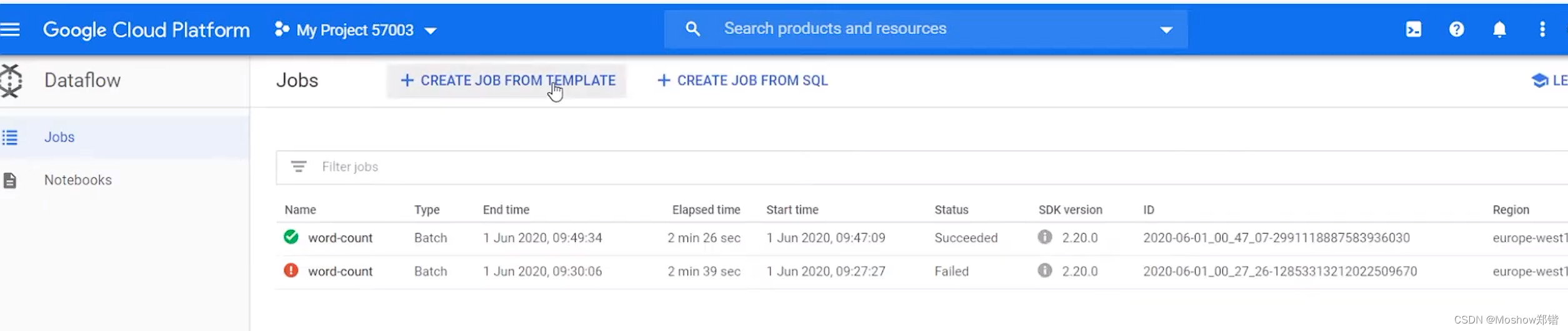

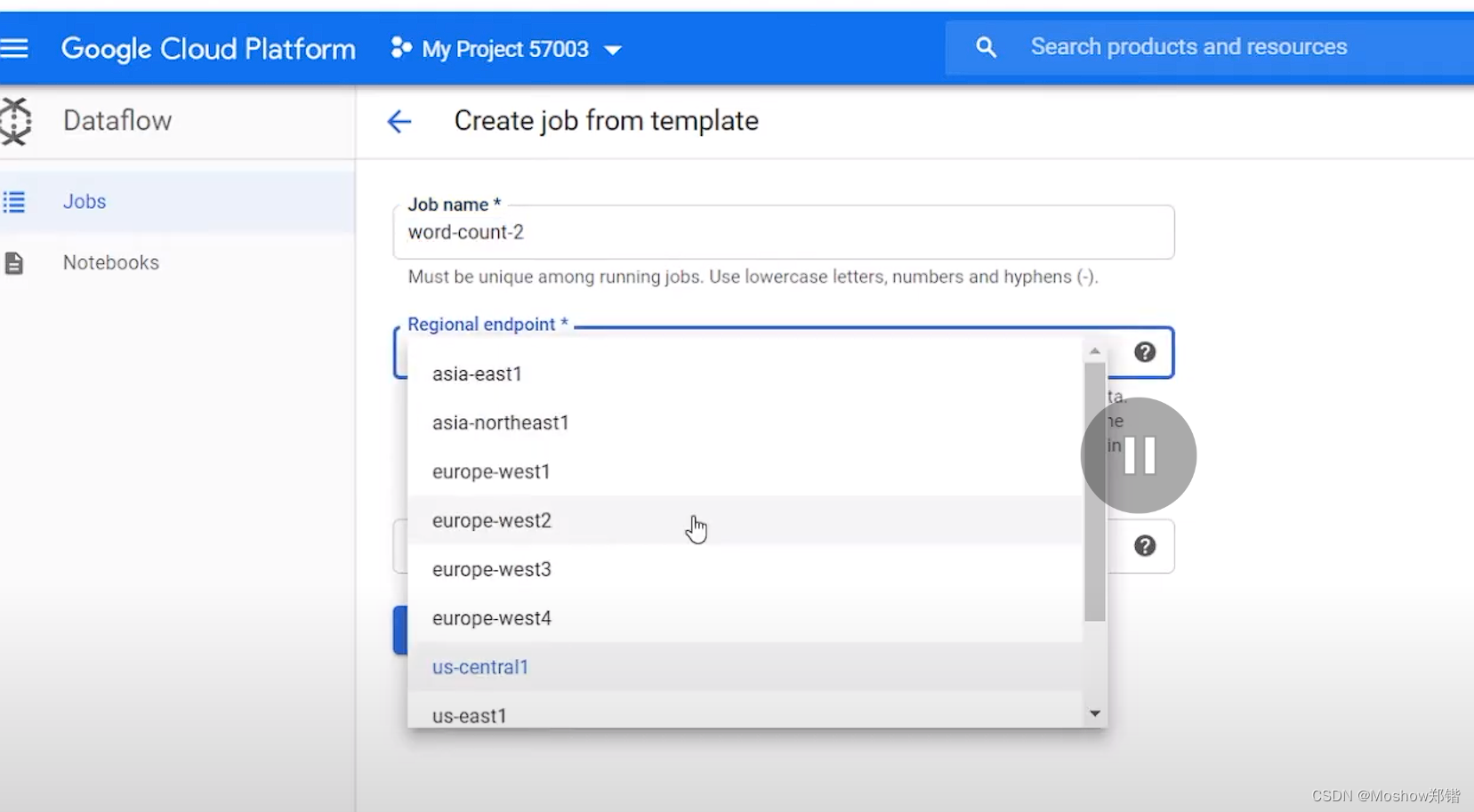

创建DataFlow

有用的URL

dataflow 官方文档

实验之Stream Processing with Cloud Pub/Sub and Dataflow

从 Pub/Sub 流式传输到 BigQuery***

从 Pub/Sub 流式传输到 BigQuery本教程使用 Pub/Sub Topic to BigQuery 模板,通过 Google Cloud 控制台或 Google Cloud CLI 创建并运行 Dataflow 模板作业。本教程将指导您完成一个流式处理流水线示例,该示例从 Pub/Sub 读取 JSON 编码的消息,使用 Apache Beam SDK 转换消息数据,然后将结果写入 BigQuery 表。

流式分析和数据集成流水线使用 Pub/Sub 提取和分发数据。通过 Pub/Sub,您可以创建事件提供方和使用方的系统,称为发布者和订阅者。发布者将事件异步发送到 Pub/Sub 服务,Pub/Sub 将事件传递给需要响应事件的所有服务。

如果您要将消息直接写入 BigQuery,而不是通过配置 Dataflow 来提供数据转换,那么请使用 Pub/Sub BigQuery 订阅。

目标

- 创建 Pub/Sub 主题。

- 使用表和架构创建 BigQuery 数据集。

- 使用 Google 提供的流式处理模板,通过 Dataflow 将数据从 Pub/Sub 主题流式传输到 BigQuery。

- 创建用户定义的函数 (UDF) 以扩展 Google 提供的流处理模板。