点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

转载自:机器之心

ChatGPT 引发了语言大模型狂潮,AI 另一个重大领域 —— 视觉 —— 的 GPT 时刻何时到来?

前两天,机器之心介绍了 Meta 最新研究成果 Segment Anything Model (SAM)。该研究引起了AI社区广泛讨论。

而据我们所知,几乎同一时间,智源研究院视觉团队也推出通用分割模型 SegGPT(Segment Everything In Context)—— 利用视觉提示(prompt)完成任意分割任务的通用视觉模型。

SegGPT: Segmenting Everything In Context

论文地址:https://arxiv.org/abs/2304.03284

代码地址:https://github.com/baaivision/Painter

Demo:https://huggingface.co/spaces/BAAI/SegGPT

SegGPT 与 Meta AI 图像分割基础模型 SAM 同时发布,两者的差异在于 :

SegGPT “一通百通”:给出一个或几个示例图像和意图掩码,模型就能 get 用户意图,“有样学样” 地完成类似分割任务。用户在画面上标注识别一类物体,即可批量化识别分割同类物体,无论是在当前画面还是其他画面或视频环境中。

SAM “一触即通”:通过一个点或边界框,在待预测图片上给出交互提示,识别分割画面上的指定物体。

无论是 “一触即通” 还是 “一通百通”,都意味着视觉模型已经 “理解” 了图像结构。SAM 精细标注能力与 SegGPT 的通用分割标注能力相结合,能把任意图像从像素阵列解析为视觉结构单元,像生物视觉那样理解任意场景,通用视觉 GPT 曙光乍现。

SegGPT 是智源通用视觉模型 Painter(CVPR 2023)的衍生模型,针对分割一切物体的目标做出优化。SegGPT 训练完成后无需微调,只需提供示例即可自动推理并完成对应分割任务,包括图像和视频中的实例、类别、零部件、轮廓、文本、人脸等等。

该模型具有以下优势能力:

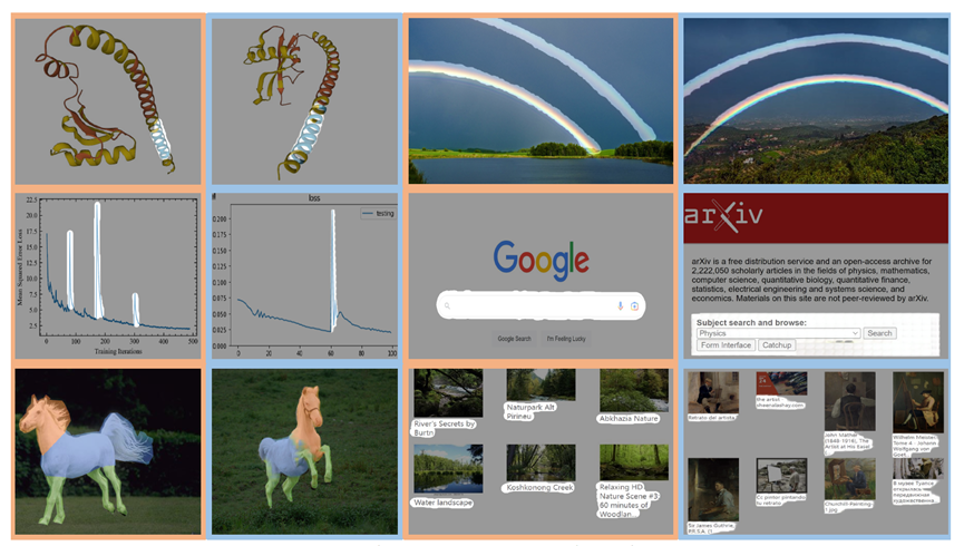

1. 通用能力:SegGPT 具有上下文推理能力,模型能够根据提供的分割示例(prompt),对预测进行自适应的调整,实现对 “everything” 的分割,包括实例、类别、零部件、轮廓、文本、人脸、医学图像、遥感图像等。

2. 灵活推理能力:支持任意数量的 prompt;支持针对特定场景的 tuned prompt;可以用不同颜色的 mask 表示不同目标,实现并行分割推理。

3. 自动视频分割和追踪能力:以第一帧图像和对应的物体掩码作为上下文示例,SegGPT 能够自动对后续视频帧进行分割,并且可以用掩码的颜色作为物体的 ID,实现自动追踪。

案例展示

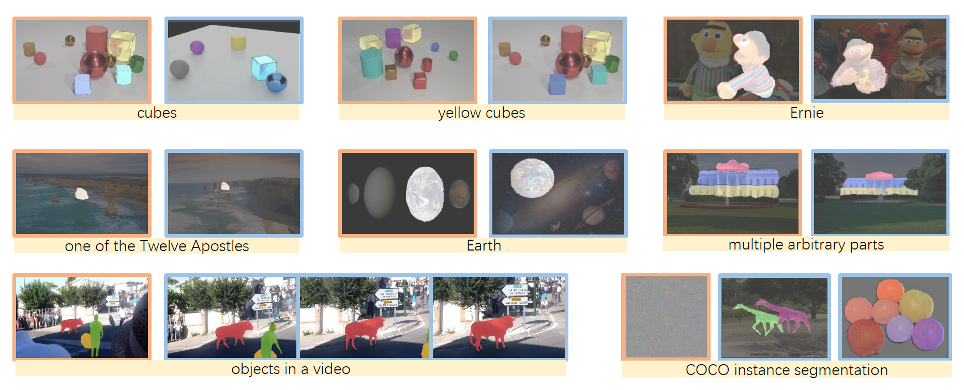

1. 作者在广泛的任务上对 SegGPT 进行了评估,包括少样本语义分割、视频对象分割、语义分割和全景分割。下图中具体展示了 SegGPT 在实例、类别、零部件、轮廓、文本和任意形状物体上的分割结果。

2. 标注出一个画面中的彩虹(上图),可批量化分割其他画面中的彩虹(下图)

3. 用画笔大致圈出行星环带(上图),在预测图中准确输出目标图像中的行星环带(下图)。

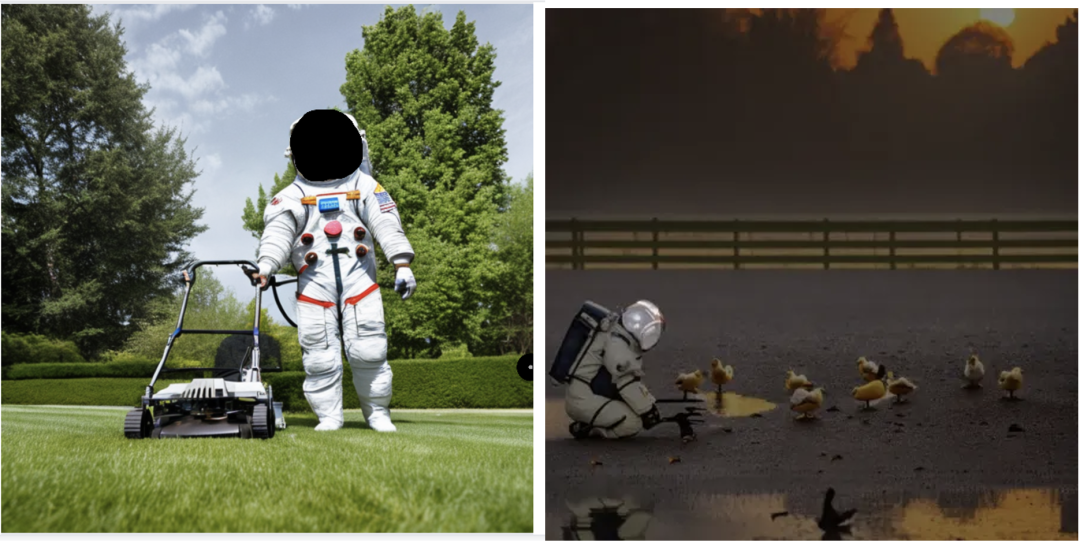

4. SegGPT 能够根据用户提供的宇航员头盔掩码这一上下文(左图),在新的图片中预测出对应的宇航员头盔区域(右图)。

训练方法

SegGPT 将不同的分割任务统一到一个通用的上下文学习框架中,通过将各类分割数据转换为相同格式的图像来统一各式各样的数据形式。

具体来说,SegGPT 的训练被定义为一个上下文着色问题,对于每个数据样本都有随机的颜色映射。目标是根据上下文完成各种任务,而不是依赖于特定的颜色。训练后,SegGPT 可以通过上下文推理在图像或视频中执行任意分割任务,例如实例、类别、零部件、轮廓、文本等。

Test-time techniques

如何通过 test-time techniques 解锁各种能力是通用模型的一大亮点。SegGPT 论文中提出了多个技术来解锁和增强各类分割能力,比如下图所示的不同的 context ensemble 方法。所提出的 Feature Ensemble 方法可以支持任意数量的 prompt 示例,实现丰俭由人的推理效果。

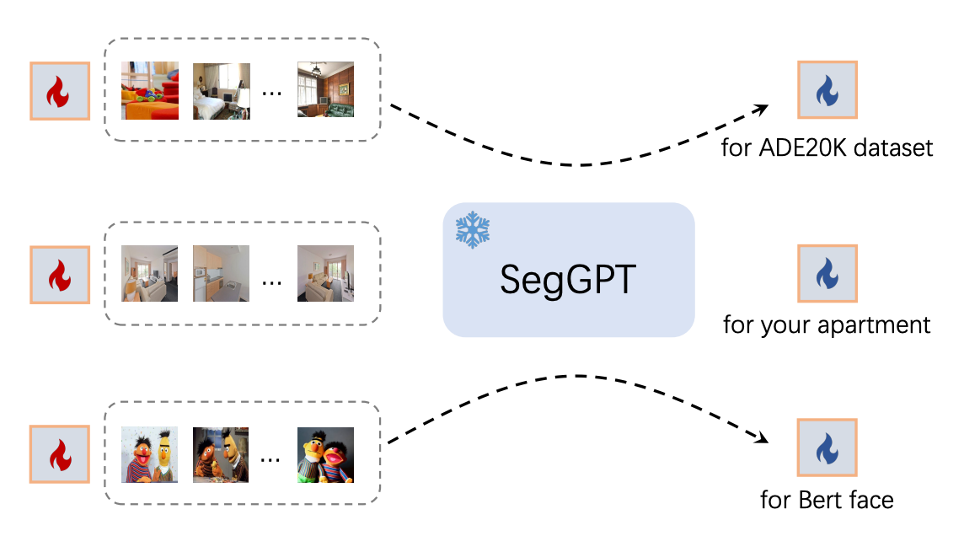

此外,SegGPT 还支持对特定场景优化专用 prompt 提示。对于针对性的使用场景,SegGPT 可以通过 prompt tuning 得到对应 prompt,无需更新模型参数来适用于特定场景。比如,针对某一数据集自动构建一个对应的 prompt,或者针对一个房间来构建专用 prompt。如下图所示:

结果展示

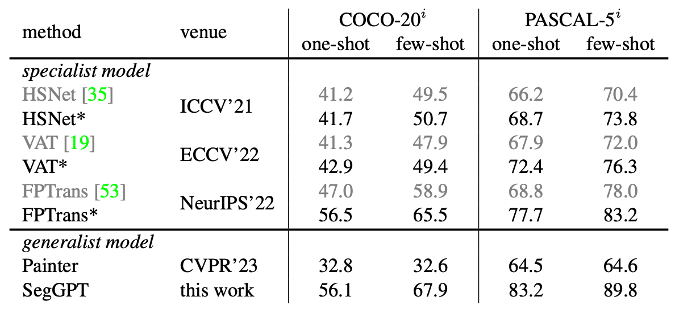

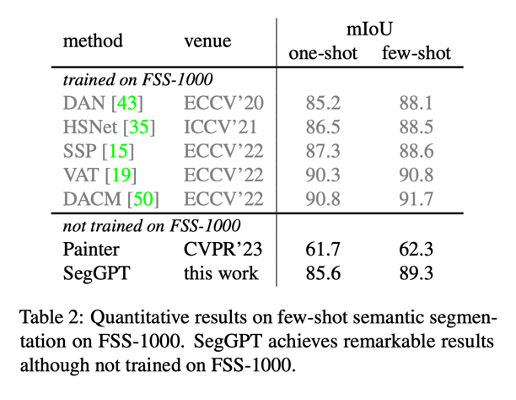

模型只需少数 prompt 示例,在 COCO 和 PASCAL 数据集上取得最优性能。SegGPT 显示出强大的零样本场景迁移能力,比如在少样本语义分割测试集 FSS-1000 上,在无需训练的情况下取得 state-of-the-art 性能。

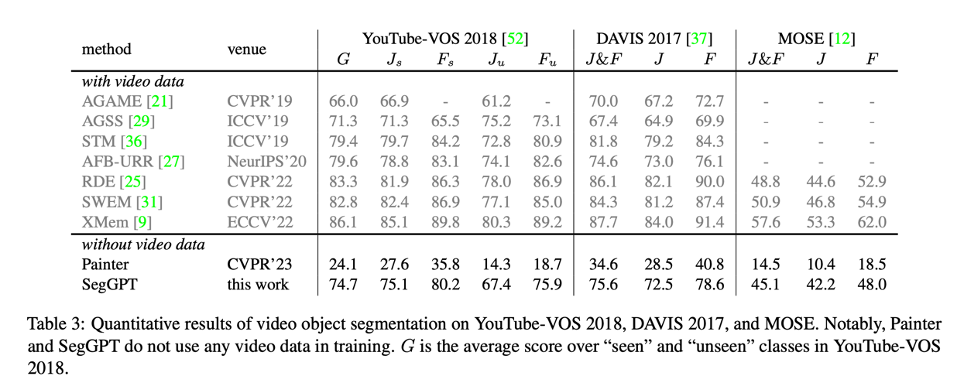

无需视频训练数据,SegGPT 可直接进行视频物体分割,并取得和针对视频物体分割专门优化的模型相当的性能。

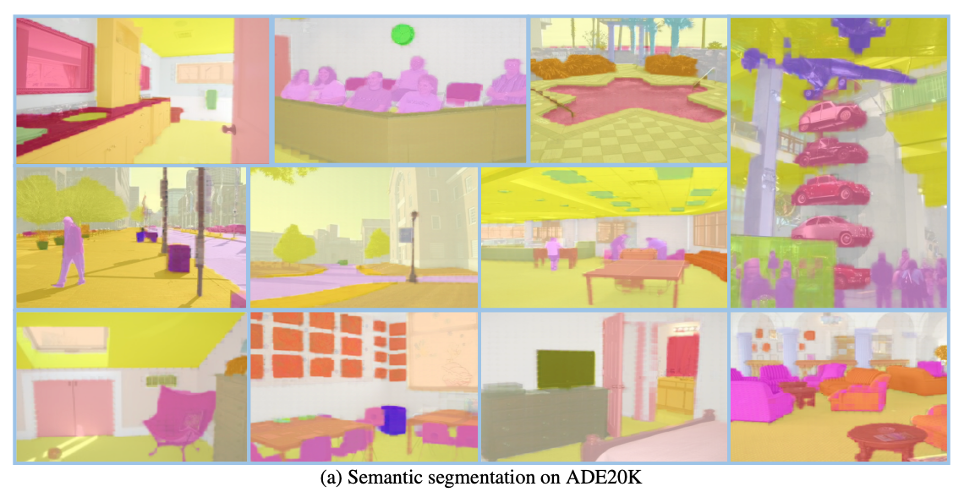

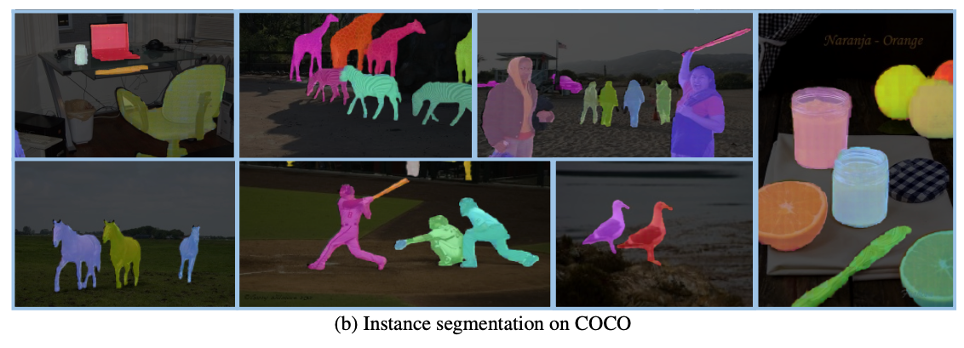

以下是基于 tuned prompt 在语义分割和实例分割任务上的效果展示:

最新CVPP 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

图像分割和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-图像分割或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如图像分割或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看