目录

1.算法仿真效果

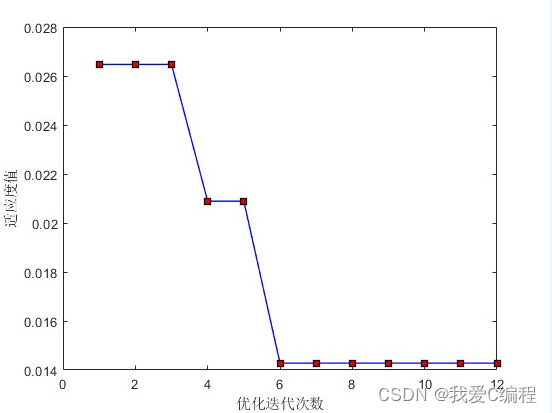

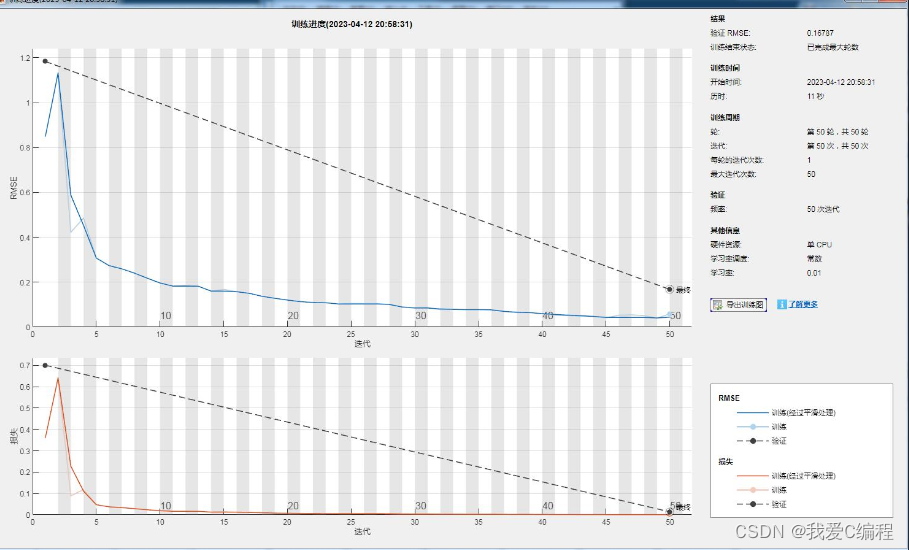

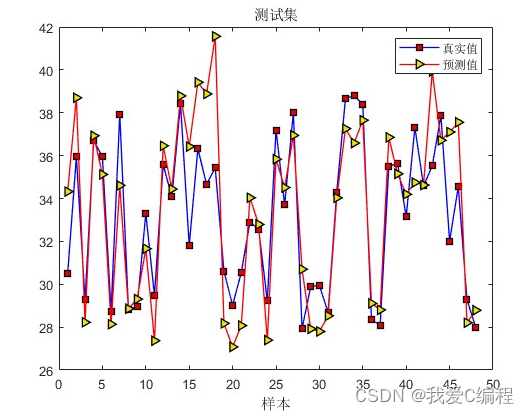

matlab2022a仿真结果如下:

2.算法涉及理论知识概要

在PSO中,群中的每个粒子表示为向量。在投资组合优化的背景下,这是一个权重向量,表示每个资产的分配资本。矢量转换为多维搜索空间中的位置。每个粒子也会记住它最好的历史位置。对于PSO的每次迭代,找到全局最优位置。这是群体中最好的最优位置。一旦找到全局最优位置,每个粒子都会更接近其局部最优位置和全局最优位置。当在多次迭代中执行时,该过程产生一个解决该问题的良好解决方案,因为粒子会聚在近似最优解上。

Ray等人通过将PSO算法和Pareto排序机制想结合起来。采用Pareto排序法来选择一组精英解,全局最优粒子的选择则是采用轮盘赌方式从中选择。实际运行时,只有少量的个体选择概率大,种群多样性保持不好。Coello等在PSO算法中选择群体最佳位置则是通过引入Pareto竞争机制和微粒知识库。该知识库用于存储微粒在每次飞行循环后的飞行经验,知识库的更新是通过考虑一个基于地理学的系统,该系统是就每个微粒的目标函数值而言来定义的。这个知识库被微粒用来确定一个指导搜索的领导者。同时非劣解的确定是通过将候选个体与从种群中随机选出的比较集进行比较,因此比较集的参数对算法成功与否有着至关重要的影响。若参数过大,则容易发生早熟收敛的现象,而参数过小,则种群中选出的非劣解的数量可能过少。

PSO模拟的是鸟群的捕食行为。设想场景:一群鸟在随机搜索食物。在这个区域里只有一块食物。所有鸟都不知道食物在哪里。但是他们知道当前的位置距离食物还有多远。那么找到食物的最优策略是什么?最简单有效的就是搜寻目前离食物最近的鸟的周围区域。

鸟群在整个搜寻过程中,通过相互传递各自的信息,让其他鸟知道自己当前的位置,通过这样的协作来判断自己找到的是不是最优解,同时也将最优解的信息传递给整个鸟群,最终整个鸟群都能聚集在食物源的周围,即找到了最优解。

PSO中,每个优化问题的解都是搜索空间的一只鸟,我们称之为“粒子”。所有的粒子都有一个被优化的函数决定的适应值,每个粒子还有一个速度决定他们飞翔的方向和距离。然后粒子们就追随当前的最优粒子在解空间中搜索。

PSO初始化为一群随机粒子(随机解)。然后通过迭代找到最优解,在每一次迭代中,粒子通过跟踪两个“极值”来更新自己。第一个就是粒子本身所找到的最优解,这个解叫做个体极值。另一个极值是整个种群目前找到的最优解,这个极值是全局机制。另外也可以不用整个种群而只是用其中一部分作为粒子的邻居,那么在所有邻居中的极值就是局部极值。

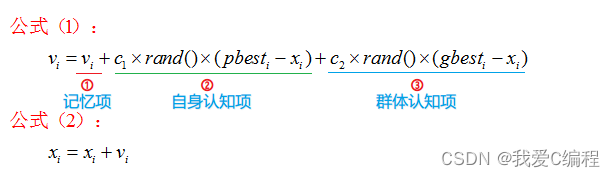

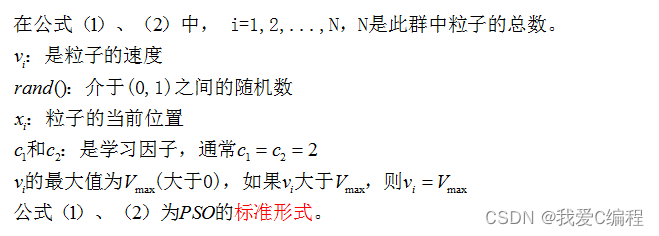

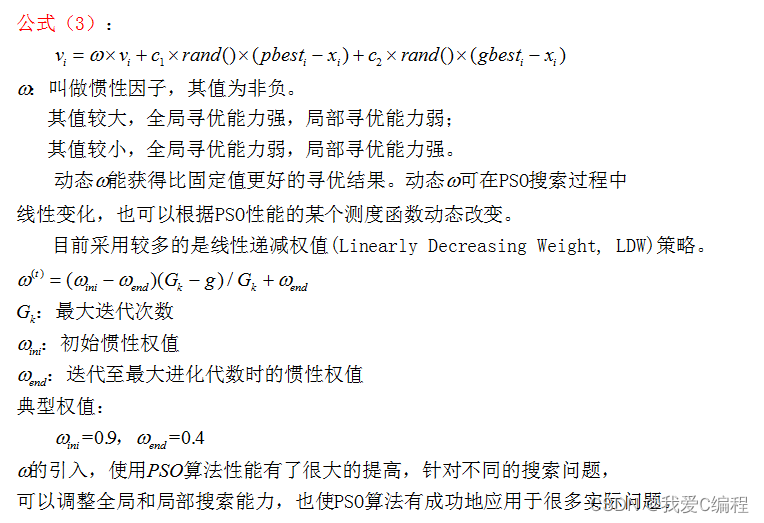

PSO初始化为一群随机粒子(随机解)。然后通过迭代找到最优解。在每一次迭代中,粒子通过跟踪两个“极值(pbest和gbest)”来更新自己。在找到这两个最优值后,粒子通过下面的公式来更新自己的速度和位置。

公式(1)中的第一部分称为记忆项,表示上次速度大小和方向的影响;

公式(1)中的第二部分称为自身认知项,是从当前点指向粒子自身最好点的一个矢量,表示粒子的动作来源于自己经验的部分;

公式(1)中的第三部分称为群体认知项,是一个从当前点指向种群最好点的矢量,反映了粒子间的协调合作和知识共享。粒子就是通过自己的经验和同伴中最好的经验来决定下一步的运动。

————————————————

长短期记忆网络(LSTM,Long Short-Term Memory)是一种时间循环神经网络,是为了解决一般的RNN(循环神经网络)存在的长期依赖问题而专门设计出来的,所有的RNN都具有一种重复神经网络模块的链式形式。在标准RNN中,这个重复的结构模块只有一个非常简单的结构,例如一个tanh层。

长短期记忆网络(Long-Short Term Memory,LSTM)论文首次发表于1997年。由于独特的设计结构,LSTM适合于处理和预测时间序列中间隔和延迟非常长的重要事件。LSTM的表现通常比时间递归神经网络及隐马尔科夫模型(HMM)更好,比如用在不分段连续手写识别上。2009年,用LSTM构建的人工神经网络模型赢得过ICDAR手写识别比赛冠军。LSTM还普遍用于自主语音识别,2013年运用TIMIT自然演讲数据库达成17.7%错误率的纪录。作为非线性模型,LSTM可作为复杂的非线性单元用于构造更大型深度神经网络。

LSTM是一种含有LSTM区块(blocks)或其他的一种类神经网络,文献或其他资料中LSTM区块可能被描述成智能网络单元,因为它可以记忆不定时间长度的数值,区块中有一个gate能够决定input是否重要到能被记住及能不能被输出output。图1底下是四个S函数单元,最左边函数依情况可能成为区块的input,右边三个会经过gate决定input是否能传入区块,左边第二个为input gate,如果这里产出近似于零,将把这里的值挡住,不会进到下一层。左边第三个是forget gate,当这产生值近似于零,将把区块里记住的值忘掉。第四个也就是最右边的input为output gate,他可以决定在区块记忆中的input是否能输出 。LSTM有很多个版本,其中一个重要的版本是GRU(Gated Recurrent Unit),根据谷歌的测试表明,LSTM中最重要的是Forget gate,其次是Input gate,最次是Output gate。

3.MATLAB核心程序

.........................................................

for i=1:Iter

i

for j=1:Npeop

if fitness(x1(j,:))<pbest1(j)

p1(j,:) = x1(j,:);%变量

pbest1(j) = fitness(x1(j,:));

end

if pbest1(j)<gbest1

g1 = p1(j,:);%变量

gbest1 = pbest1(j);

end

v1(j,:) = v1(j,:)+c1*rand*(p1(j,:)-x1(j,:))+c2*rand*(g1-x1(j,:));

x1(j,:) = x1(j,:)+v1(j,:);

end

gb1(i)=gbest1;

end

figure;

plot(gb1,'-bs',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.0,0.0]);

xlabel('优化迭代次数');

ylabel('适应度值');

zhongjian1_num = round(g1(1));

xue = g1(2);

%模型训练

layers = [ ...

sequenceInputLayer(shuru_num)

lstmLayer(zhongjian1_num)

fullyConnectedLayer(shuchu_num)

regressionLayer];

.................................................................

figure

plot(output_train,'-bs',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.0,0.0]);

hold on

plot(test_simu,'-r>',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.9,0.0]);

hold off

legend(["真实值" "预测值"])

xlabel("样本")

title("训练集")

figure

plot(YValidationy,'-bs',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.0,0.0]);

hold on

plot(test_simuy,'-r>',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.9,0.0]);

hold off

legend(["真实值" "预测值"])

xlabel("样本")

title("验证集")

figure

plot(output_test,'-bs',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.0,0.0]);

hold on

plot(test_simu1,'-r>',...

'LineWidth',1,...

'MarkerSize',6,...

'MarkerEdgeColor','k',...

'MarkerFaceColor',[0.9,0.9,0.0]);

hold off

legend(["真实值" "预测值"])

xlabel("样本")

title("测试集")

A9834.完整算法代码文件

V