作者,中国移动咪咕,李琳,灯塔

作为顶尖的足球联赛,欧洲五大联赛在全球掀起了足球观赛热潮。为了让比赛“看得懂”咪咕贴心上线了智能字幕功能,詹俊、张路、黄健翔、徐阳、娄一晨、刘越、张力等组成的咪咕嘉宾天团的精彩解说不仅能被听到,更能通过智能字幕“被看到”,让更多人感受到了“同频共振”的足球赛事狂欢。智能双语字幕在英超、西甲等五大联赛的常态化商用,通过在屏幕上实时准确呈现赛场解说字幕,帮助观众更准确理解赛事的同时,也将陪伴球迷共同见证联赛冠军的诞生时刻。

在冬奥的智能字幕之后,团队继续攻关。

1、在赛前就依托图谱热词、智能纠错、语义分析、垂直领域优化等多种手段,提升了直播字幕转写效果,能够精准转写专业运动员姓名、球队名、动作战术解说等专业领域词汇,为观众提供高准确率中文字幕。

2、智能字幕通过**构建翻译记忆库,**大幅提升字幕英文翻译水平,助力跨国沟通和赛事的广泛传播。

3、在智能字幕功能的加持下,球迷们不仅可以任意切换中英文字幕,还能根据自身需求,实时调节字幕的高度,避免遮住重要信息,从而打造专属观看模式。即便是在噪杂的环境下,也能及时捕捉赛事关键信息,第一时间直击精彩瞬间。

4、解决处于静音或噪杂环境下“听不见、听不清、听不准”的难题。赛事直播字幕,让听力特殊人群也能无障碍观看比赛,为全球超4亿的听力受损群体打开了绿茵场观赛的“新窗口”。

此前,在北京冬奥会期间,咪咕视频就上线“为了听不到的你”智能字幕功能,覆盖花样滑冰、短道速滑、单板滑雪、自由式滑雪等数百个场次,和咪咕的“豪华解说天团”一同为云上观赛的用户提供全程暖心陪伴。值得一提的是,这一有温度的黑科技还得到了中国聋协的频频“点赞”。

图1 “为了听不到的你”智能字幕

背景

全球有超4亿人听力受损,忍受着“听不清、听不真”的困扰;听力正常的人们,也常常因为各种原因不得不处于“静音”状态或忍受着周围嘈杂的噪音而错过精彩细节;即使听力正常人群在正常情况下,一些专业直播场景,也因不够了解专业术语显得“一头雾水”,此时字幕对视频内容的理解非常重要。

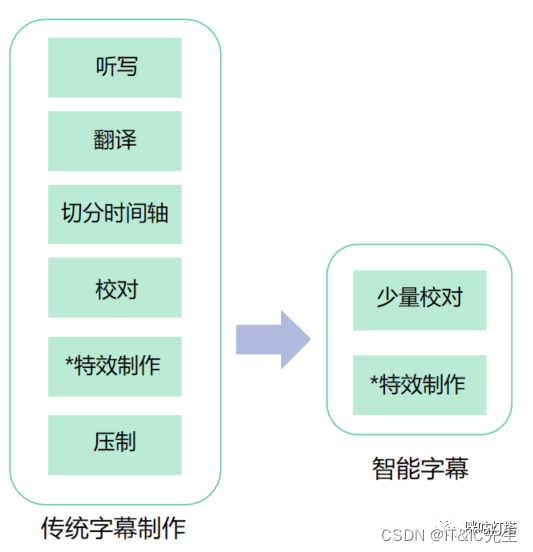

传统音视频字幕制作的流程(如图1),需要人工听写原文字幕、翻译、切分时间轴、校对、特效制作以及压制等一系列步骤,每一步都需要人工操作完成,存在效率低下、人工成本高的等问题,无法大批量生产,因而不能满足当前最受欢迎的直播和爆炸式量增的短视频加字幕的需求。

智能字幕运用AI技术实现语音听写、翻译、切分时间轴等相对固定的工作流程。较高准确率的智能字幕可直接应用到通常情况下的网络直播、视频日志等场景。对字幕有100%准确率的应用场景,也只需要做少量的人工校准,大大提升了生产效率,使重大赛事直播实时输出字幕成为可能。

图2 传统字幕和智能字幕的对比

关键技术

实时智能字幕是实时处理输入音视频中的人声,自动转成字幕的技术。实时智能字幕根据语种数量不同,可分为单语种字幕及多语种字幕,其中最常见的有英文字幕、中文字幕及中英双语字幕等。

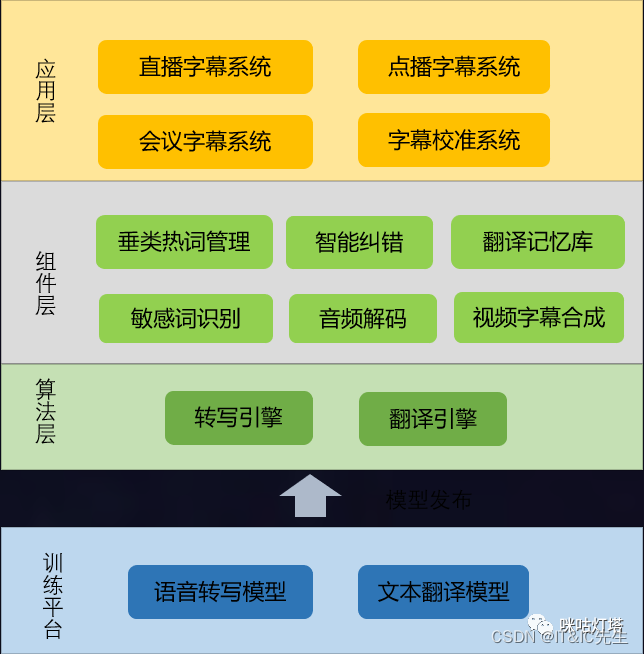

先介绍一下智能字幕系统通用架构,可以总结为“一台三层”。“一台”代表模型训练平台,主要负责智能字幕所依托的基本算法模型的训练。“三层”分别为应用层、组件层与算法层。

图3 “一台三层”架构示意图

字幕的质量主要取决于智能语音识别转写文字、自动解析语音并即时切分时间轴、NMT神经网络机器翻译三项核心技术的准确率,最终呈现可以通过字幕校准系统人工干预达到最佳效果。

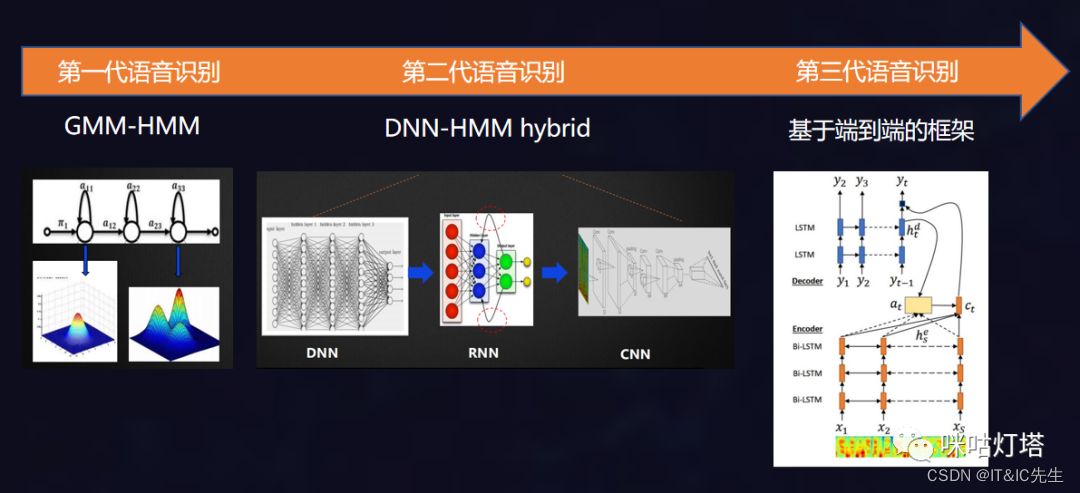

**语音是如何从直播流中被识别出来的?**语音识别需要依托信号处理和特征提取、声学模型、语言模型、编码器。声学模型用于判断每帧语音属于各发音单元的概率。语言模型用于判断词串在语言中出现的概率。解码器就是基于Viterbi算法在HMM模型上搜索生成给定观测值序列(待识别语音的声学特征)概率最大的HMM状态序列,再由HMM状态序列获取对应的词序列,得到结果。

第一代语音识别框架是基于HMM-GMM框架。第二代语音识别框架是基于HMM-DNN框架。对传统语音识别框架中的声学模型算法进行改进。相对GMM,训练音素A时,不仅用A的数据,还要用A的反例数据,更具有区分性。**第三代语音识别框架是一种基于端到端的框架。突破了“传统框架”的限制,去除所有中间步骤和独立子任务,充分利用深层神经网络和并行计算的优势,取得最优结果。**第三代的语音转写技术识别率已经很高,在普通话情况下基本可以识别准确。

图4 语音识别系统发展历程

为了在各类复杂场景下确保语音转写的准确率,我们团队还尝试了以下几个优化和提升,来确保赛事直播专业场景下的字幕的正确率,并积累了多篇优质专利。

**垂直领域专业术语系统:**在智能字幕实际使用时,一般会同时获取业务场景标签和直播流。我们可以根据不同的业务场景通过知识图谱获取当前视频涉及的专业词汇,增加该类业务场景相关词汇在同音词中的权重,提升字幕识别正确率;这样,在同音词出现的情况下,系统可以更好地定位“选择”哪个。同时,知识图谱的数据会持续更新,比如运动员转会导致俱乐部变更,参加预赛决赛的运动员名单变更等。

音频降噪:各类比赛场景较为复杂,背景音、广播音、场内音如球员和观众的呐喊声等,都会对解说音造成干扰,通过引入降噪技术,可以有效降低噪音对语音转写的干扰。

**智能纠错:**智能纠错系统可对因外部因素(如噪音,两个人同时说话等)造成的字幕错误瞬时智能纠错。一般包含:同音词纠错、模糊音纠错、多字少字纠错等多种纠错策略,整体提升字幕的质量。例如:乒乓球比赛中的“正手威胁线”->”正手位斜线“。

**敏感词屏蔽:**一般场景下需要实现对色情、暴恐涉政、辱骂等敏感信息的有效识别,对敏感音频内容消音处理,保障业务安全。

自动解析语音并即时切分时间轴:通过对语音的自动解析,实现对讲话者停顿、上下文关系的实时判断并完成断句。同时,依据断句对时间轴智能切分,最终实现字幕逐句、完整显示在对应的时间戳。

**语音分割是识别自然语言中的单词,音节或音素之间的边界的过程。**语音分割是一般语音感知的一个子领域,也是语音识别技术领域的一个重要子问题。正如大多数自然语言处理问题一样,进行语音分割必须考虑语境,语法和语义。

基于神经网络机器翻译的翻译

神经网络机器翻译通过技术降低内容翻译的成本,提高翻译行业的生产效率。翻译模块最通常以翻译引擎为主,但为了确保较高的翻译准确率,通常需结合翻译记忆库。

NMT神经网络机器翻译:神经网络机器翻译(Neural Machine Translation,简称 NMT),也称为神经机器翻译。其基本思想是将源语言句子序列,通过神经网络结构映射为目标语言句子序列。在神经网络结构中,使用连续的向量表示来建模翻译过程,因此具有较好的泛化性能,同时避免了传统的机器翻译独立性假设过强的问题。统计机器翻译是采用离散符号到离散符号的转换,而神经网络机器翻译是将离散符号先转成连续向量,然后再转换成离散符号,这是统计机器翻译和神经机器翻译的本质区别。相比于短句翻译,NMT可以利用云语言与目标语言所有信息,使整个翻译决策过程连续化全局化,使得译文更流畅和可读。

基于以上基本能力,针对各类比赛运营积累的解说文本翻译句对,我们经过人工清洗修正构建翻译记忆库,进一步提升应用场景上下文翻译效果,从而提升跨语种字幕效果。

产业应用情况

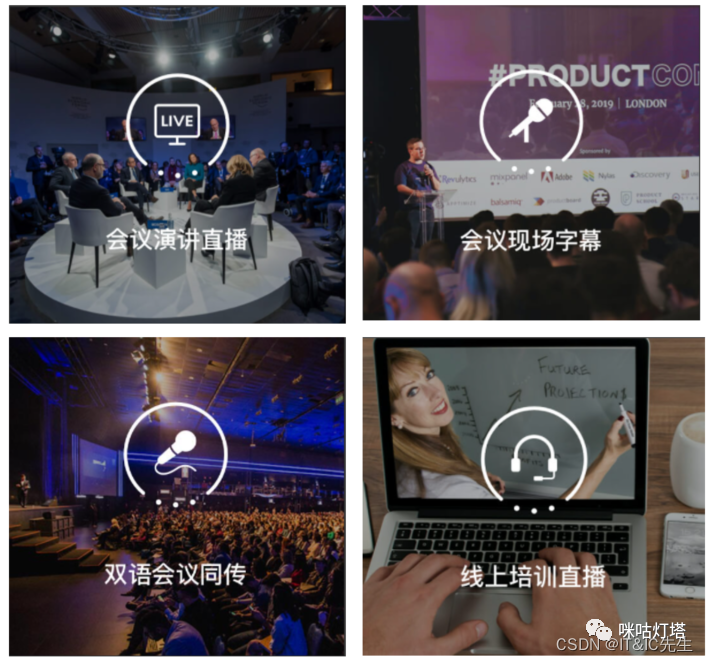

目前实时智能字幕技术已经相对成熟,行业内已有很多应用。如国外的YouTube、Google,国内的阿里云、百度云、咪咕、网易见外等都实现了对智能字幕的研发及应用。主要功能是实现实时语音识别,将说话内容实时转成字幕,双语同传翻译等。应用场景主要是于会议现场/直播字幕、会议同传、课程培训字幕等。

图5 应用场景

当前正式商用多为上述的通用场景,缺少垂直领域的优化,专业应用场景效果欠佳,此前在赛事直播场景的应用尚为空白。我们凭借体育垂直行业的积累和领先的实时智能字幕技术,在冬奥会首次实现智能双语字幕在重大赛事直播场景中的应用。经过垂直领域优化、场景降噪、纠错后,将智能字幕准确率提升至93%~98%,得到观众们的广泛好评。

图6 双语字幕自由切换

展望

行业内各主流厂商在相关领域(NLP、语音识别合成等)投入巨大,人才储备充足,技术发展速度快,覆盖的领域和业务场景也越来越广。当前实时智能字幕的业务领域,通用准确率已经达到了较高的水平。但是主流相关能力主要用于通用领域,面向垂直领域的应用场景仍存在很大的优化空间。我们持续针对自身的重点业务场景不断优化“视频直播智能字幕”,进一步提升观赛体验。

随着元宇宙的到来,音视频领域将会迎来巨大变革,智能字幕也面临很大的机遇和挑战。

1、是基于音视频内容辅助用户理解的字幕,让视频/音频可读;

2、是做有感情的字幕,基于场景气氛视频内容角色的情绪输出不同风格的字幕,提升内容表现力。

3、面向VR/AR场景的内容,字幕也要做维度升级。VR/AR 场景的内容叙事一直是难题,同传统2D视频采用的上帝视角的体验不同,VR是千人前面的个性化视角,内容过于丰富以及更高自由度的情况下,反而会导致用户忽略重要的细节导致叙事不完整。解决这个难题的有效方式之一就是通过智能字幕的个性化引导和补充表达信息来实现叙事的完整性,这对未来基于空间的智能字幕是个很大的挑战。