0. abstract

- 噪声是任何传感器的固有组成部分,并且在不同程度上存在于在现实生活环境中捕获的任何内容中。在成像应用中,已经提出了几种预处理和后处理解决方案来处理捕获图像中的噪声。最近,基于学习的解决方案在图像增强,特别是图像去噪方面显示了令人印象深刻的结果。在这篇论文中,我们回顾了在压缩域图像去噪的多种新解决方案,通过将去噪操作集成到基于学习的压缩方法的解码器中。本文首先从不同的角度解释了这种方法的优点。然后,我们描述了提出的解决方案,包括盲和非盲方法,并将它们与现有的方法进行比较。最后,根据得到的结果得出结论,总结了每种方法的优缺点。

1. introduction

- 最近,通过智能手机、平板电脑或相机等数字设备捕捉图像已成为一种普遍做法,导致每年对存储数万亿张图片的需求不断增长。海量的存储数据促使人们研究更新颖、更有效的压缩方法,从而减少对存储空间的巨大需求。虽然过去已经提出了许多传统的标准,但最近的研究工作主要集中在基于学习的压缩方法上[1]。例如,JPEG委员会最近组织了一项活动,其目标是标准化一种新的基于学习的压缩算法,也称为JPEG AI。该小组首次报道了基于学习的方法优于传统图像压缩的领先性能,在呼吁证据[2]中,并在呼吁建议中先后比较了不同的新兴技术。

- 最近的趋势表明,如今的图像不仅是为了人类消费,而且也用于计算机视觉应用。因此,压缩后的内容既要使其与原始版本的感知相似性最大化,又要保证对计算机视觉和图像处理任务的良好性能。在这种背景下,JPEG AI在“JPEG AI的用例和需求”文档[4]中提出了一个框架,该框架允许图像处理和计算机视觉任务直接应用于基于学习的图像压缩的潜在空间,因此不需要标准解码。特别是,压缩流不仅应该允许用专门针对人类视觉的标准解码器进行重建,还应该允许将计算机视觉任务应用到压缩域或非规范解码器,用于图像处理操作,如去噪或超分辨率。该框架的优点是它不需要关于目标应用程序的初步信息,而且非规范的解码器或计算机视觉网络可以更新到最新的技术,而不需要转码或重新捕获内容。

- 噪声是图像中常见的干扰因素,影响着图像的视觉质量和多种计算机视觉方法的性能,包括人脸检测和识别 [5]。噪声通常是由内部因素(如相机传感器)和外部因素(如环境光)造成的,在许多情况下可能无法避免。这使得图像去噪是必要的和可取的,是一个经典和深入研究的问题在目前的技术水平。通常,图像去噪的目标是根据图像的噪声观测 y = x + n y=x+n y=x+n 重构出图像的 x ^ \hat x x^。噪声 n 在文献中常被近似为加性高斯白噪声(AWGN),它是信号无关的,均值为零,标准差为σ。真实噪声可以用高斯-泊松模型[6]更接近,其中噪声由泊松信号相关的 η p \eta_p ηp 和高斯信号无关的 η g \eta_g ηg 近似。

- 在这篇论文中,我们提出并评估了不同的非规范解码器,能够联合重建和降噪由学习编码器产生的压缩流。值得注意的是,不同的盲和非盲解决方案被实现和比较,并使用一些客观的质量指标来评估结果。此外,还讨论了加入额外信息(如噪声σ的标准差)的好处。与锚方法(包括级联压缩和去噪)相比,所有提出的解决方案在感知视觉质量和计算复杂度方面都允许提高性能。

- 本文其余部分的结构如下:第2节总结了基于学习的图像压缩、图像去噪以及直接应用于图像压缩潜在空间的计算机视觉和图像处理方法的技术现状。第3节回顾了组合压缩和去噪的不同建议方法。结果将在第4节中报告和讨论,而总结将在第5节中得出。

2. relatied work

- 随着数字设备拍摄和存储的图像总数的不断增长,新的和更有效的图像压缩解决方案不断被研究。最近,许多基于自动编码器的图像压缩解决方案已经被研究[7-12],报道了在压缩效率和感知视觉质量[13]方面的高性能。特别是,Ball’e等人首先提出了一种使用级联到线性卷积[7]的非线性变换的自编码器解决方案,然后通过引入超先验形式的边信息进行扩展,该超先验捕获潜在表示[8]中的空间依赖性,并包括一个自回归模型以减少边信息[9]的数量。最近,生成模型被提出,首先综合图像的细节来提高最低比特率的性能[11],然后依次最大化感知相似度量来生成视觉质量改进的图像[12]。

- 在传统场景中,图像压缩之后会进行预处理或后处理操作,目的是限制捕获、压缩和其他因素带来的失真。在这种情况下,图像去噪被用作预处理和后处理操作。目前已有多种传统去噪方法被提出。例如,小波阈值[14]依赖小波变换对图像进行降噪。最近,基于神经网络的去噪方法[15,16]能够以额外的计算成本为代价获得更好的性能。值得注意的是,Zhang等人提出了一种基于深度卷积神经网络(CNN)的去噪解决方案,称为DnCNN[15],通过训练来估计来自有噪声观测的残留噪声,并不断改进该方法,将均匀的噪声级别映射集成到FFDNet的网络[16]中作为输入。这些额外的信息使网络能够处理广泛的噪声级别,并在降噪和细节保存之间做出妥协。最近,郭等人[17]。提出了一种基于学习的方法,将噪声水平估计网络和非盲去噪网络结合为一种统一的盲方法,称为CBDNet,以实际噪声为训练对象,重点是减轻噪声水平低估。最后,Yue等人[18]基于变分推理,提出了一种创新的基于深度学习的贝叶斯框架,用于盲图像去噪和噪声建模。

- 近年来,由于大量的图像被用于机器消费,图像压缩领域的研究人员试图设计能够编码图像的压缩方法,这些压缩方法不仅在传统解码器重构后具有视觉上的愉悦性,而且还能优化计算机视觉和图像处理任务[4,19]。少数方法试图将计算机视觉和图像处理方法直接应用于图像压缩的潜在空间。Torfason等人[20]给出了早期结果。该研究提出在基于学习的图像压缩方法的潜在表示中应用图像分类和语义分割,显示出在运行时间、内存使用、鲁棒性和协同性方面的改进,并仅在最低比特率下牺牲性能。近年来,超分辨率算法已被应用于图像压缩的潜在空间[21],在视觉质量方面显示出良好的效果。压缩域图像去噪领域的初步工作提出了一种非规范解码器解决方案,能够将解码和去噪操作结合起来,同时降低了管道[22]的计算复杂度。Alvar等人[23]提出了一种不同的潜在空间去噪方法,其中基于可伸缩潜在空间的联合压缩和去噪网络允许实现bd率节约,同时提高图像质量。通过对基于学习的压缩算法的编码器和解码器进行训练,提出了一种针对卫星图像的联合压缩和去噪方法。最虽然最后这些方法证明了性能的提高,但它们只适用于有限的应用程序,而不是所有的应用程序;例如,不去噪地重建原始图像是保存艺术意图的理想方法。将去噪操作集中在解码器端,可以更灵活地选择所需的解码器,而不需要存储相同内容的多个版本。最后,Cheng等人[25]最近提出了一种联合压缩和去噪的管道,其目标是通过最小化用于存储噪声信息的分配位来减少存储空间。虽然最后这些方法证明了性能的提高,但它们只适用于有限的应用程序,而不是所有的应用程序;例如,不去噪地重建原始图像是保存艺术意图的理想方法。将去噪操作集中在解码器端,可以更灵活地选择所需的解码器,而不需要存储相同内容的多个版本。

- 然而,基于学习的计算机视觉和图像处理技术应用于图像压缩潜在空间的研究仍处于早期阶段,需要更多的努力设计出既适合机器视觉又适合人类视觉的鲁棒编码方法。值得注意的是,在图像压缩的潜在空间中,不同的架构对降噪方法性能的影响还没有得到充分的研究。

3. combined compression and denoising

- 在本节中,提出了不同的组合解码和去噪的管道。值得注意的是,提出了六种不同的方法,包括盲法和非盲法。在实验中,使用具有尺度超先验模型的变分自编码器[8],特别是经过均方误差(MSE)预训练的CompressAI实现[26]作为基线,并使用新的训练策略和损失函数实现非规范解码器。在所有的实验中,编码器被冻结,只允许对解码器进行微调。提出的训练策略可以应用于几乎任何基于学习的压缩方法,因此,在未来,它可以在即将到来的基于学习的图像压缩标准上进行测试,例如JPEG AI兼容编码。所有的实验都考虑了合成高斯-泊松噪声[6],并使用为JPEG AI CfP[27]设计的实用噪声发生器对图像进行了应用。

3.1 blind combined decoding and denoising

- 第一种盲方案能够同时盲重建和降噪图像,即不使用噪声 σ \sigma σ 的标准差信息,也不使用生成高斯-泊松噪声[6]的 a , b a,b a,b 参数的信息。损失函数是通过删除速率计算和只优化失真来编辑的,因为冻结编码器允许速率固定。失真D在重构图像和原始无噪声图像之间计算,允许解码器在解码的同时学习去噪。因此,拟议的损失如下: L ( x , x ^ ) = D ( x , x ^ n ) (1) \mathcal{L}(x,\widehat x)=D(x,\widehat x_n)\tag{1} L(x,x )=D(x,x n)(1)

- 其中 x x x 为原始无噪声图像, x ^ \hat x x^ 为重构后去噪图像。在这种情况下,由于训练过程中对每批图像都应用了合成的随机泊松-高斯噪声,网络可以同时获得原始图像和噪声图像。失真度量 D D D 是在原始压缩模型中使用的,在本例中即 MSE。因此,利用损失函数1 或通过计算重构图像与原始无噪声图像之间的失真度量对解码器进行微调。所提出的盲联合解码去噪方法的流程如图1所示。我们把这个模型称为盲模型。

3.2 non-blind combined denoising and decoing

- 提出了两种非盲降噪和解码组合策略的解决方案。值得注意的是,该解码器体系结构被扩展为以连接到图像潜在噪声映射作为输入,特别是在基于学习的解码器的第一卷积层中添加了 n n n 个输入通道和相应的滤波器,即由 n n n 个通道组成的噪声映射。解码器其他层的体系结构保持不变。用作解码器输入的噪声映射是原始RGB空间中真实点噪声级映射的低分辨率版本,由泊松-高斯模型的参数和原始图像给出。对于通道 i i i 中的原始RGB图像 x x x,在2d位置p处,局部噪声水平(标准差) σ i ( p ) \sigma_i(p) σi(p)为: σ i ( p ) = a i x i ( p ) + b i (2) \sigma_i(p)=\sqrt{a_i x_i(p) + b_i}\tag{2} σi(p)=aixi(p)+bi(2)其中 a i a_i ai 和 b i b_i bi 为通道 i i i 中的泊松-高斯噪声[6,27]的参数。

- 用式2计算原RGB空间的真实逐点噪声映射。通过连续的2x2平均池化阶段传递点级噪声图,可以获得分辨率较低的噪声图,这将导致加权平均,其中局部噪声水平的变化具有更高的贡献,同时与16x16平均池化或16x16下采样相比,增加了接受野。然后,它被重塑为具有与潜在图像相同的高度和宽度,以便连接。

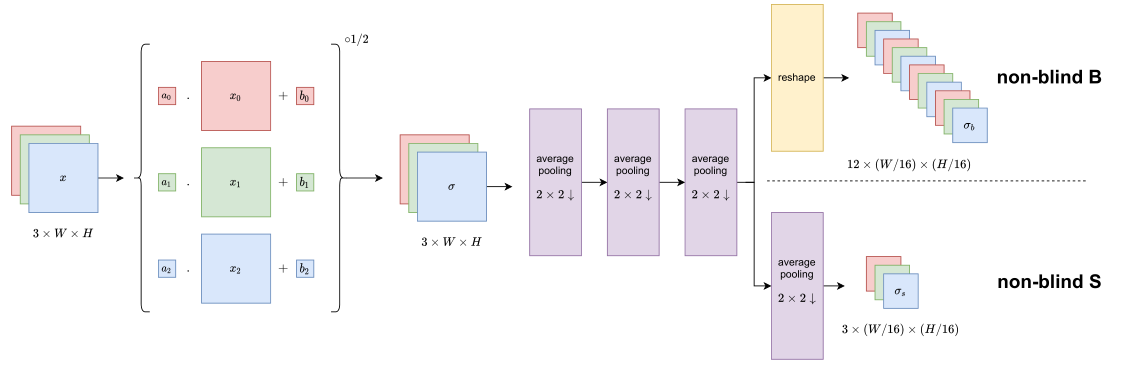

- 通过回顾不同分辨率的噪声映射,提出了两种模型的变体。特别地,研究了输入噪声映射的不同通道大小,噪声映射使用3通道或12通道,分别对应4和3个平均池化阶段。我们将使用3个通道的噪声映射的模型称为非盲S,将使用12个通道的模型称为非盲B。获取这两个噪声映射的管道如图2所示。

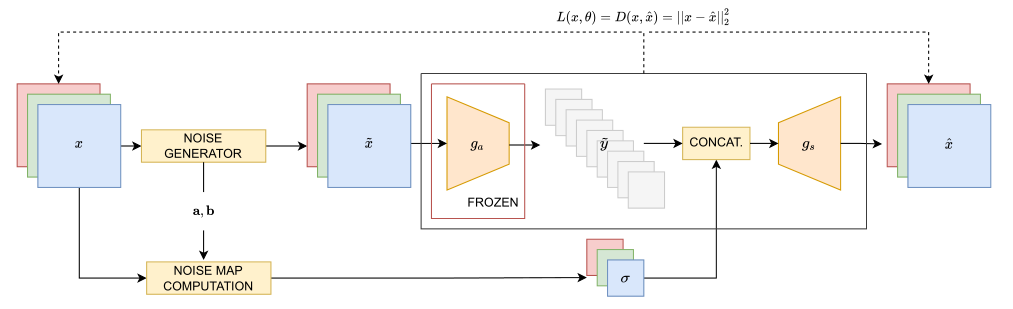

- 在训练过程中,使用MSE作为原始无噪声图像和解码图像之间的失真度量。这相当于只考虑基线压缩模型中来自率失真权衡的失真项,而不对图像进行感知转换。非盲架构如图3所示。

- 由于在实际应用中获取真实空间变化噪声级图并不总是可行的,提出了一种非盲S模型的松弛方法。仅在推断过程中,使用包含图像经验噪声水平的均匀噪声图 σ u \sigma_u σu 代替真实值空间变噪声图。我们把这条管道称为非盲U。

3.3 blind combined decoing and denoising with noise map estimation

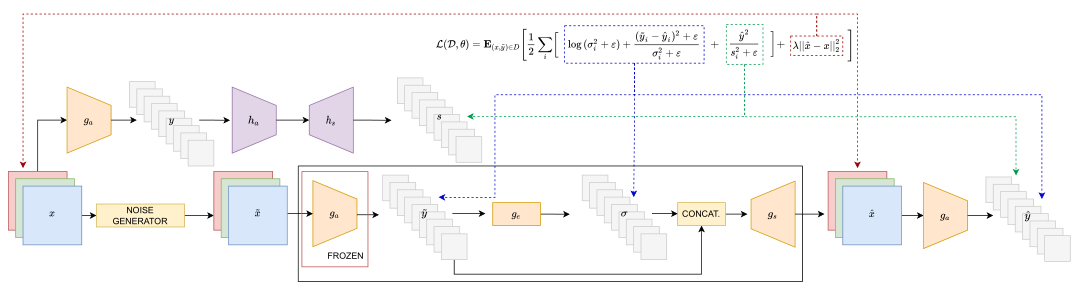

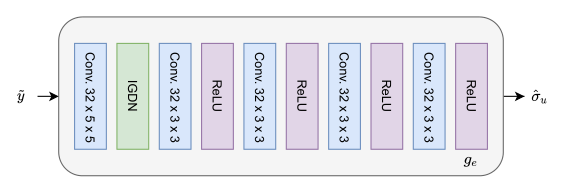

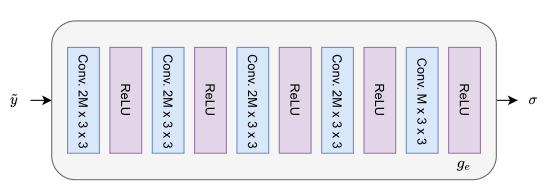

- 提出了一种附加盲解,称为盲解E,利用额外的学习模型估计噪声映射。与CBDNet类似[17],管道由一个用于估计噪声水平的子网(这里表示为ge)和一个非盲去噪子网组成。估计网络与解码器分开训练,以均匀的真实噪声水平图与输出噪声水平图之间的均方误差为目标。所采用的去噪网络是3.2节中介绍的非盲去噪解码器 g s g_s gs。更具体地说,根据基线压缩网络中潜在空间的维数来选择解码器。图像潜由192个或384个通道组成,分别使用非盲S解码器和非盲B解码器。

- 盲E方法的流程如图4所示。

3.4 blind combined decoding and denoising with noise modeling in the latent space

- 提出了一种直接从潜在空间推断点级潜在噪声水平的附加方法,即盲L,而不是估计原始RGB空间中的噪声水平信息。值得注意的是,我们将潜在噪声定义为噪声图像的潜在量化 y ~ \tilde y y~ 与干净图像的反向量化潜在y之间的差值。潜在噪声与应用于原始图像的噪声之间的关系是未知的,因为潜在噪声受到编码和量化操作的影响。我们将潜伏图像中的这种噪声近似为应用于干净潜伏图像的零均值、点向独立高斯噪声,因为在文献中对应用于RGB图像的具有未知属性的噪声通常是这样做的[17,18]。训练该网络,以推断潜在噪声水平映射σ,并同时对噪声潜伏 y ~ \tilde y y~进行联合去噪和解码,使用以下损失函数: L ( D ; θ ) = E ( x , y ~ ) ∼ D [ 1 2 ∑ i [ l o g ( σ 2 + ϵ ) + ( y ~ i − y ^ i ) 2 + ϵ σ i 2 + ϵ + y ^ 2 s i 2 + ϵ ] + λ ∥ x ^ − x ∥ 2 2 ] L(\mathcal{D;\theta})=E_{(x,\tilde y)\sim \mathcal{D}}[\frac{1}{2}\sum_{i}[log(\sigma^2+\epsilon)+\frac{(\tilde y_i - \hat y_i)^2+\epsilon}{\sigma_i^2+\epsilon}+\frac{\hat y^2}{s_i^2+\epsilon}]+\lambda\Vert\hat x-x\Vert_2^2] L(D;θ)=E(x,y~)∼D[21i∑[log(σ2+ϵ)+σi2+ϵ(y~i−y^i)2+ϵ+si2+ϵy^2]+λ∥x^−x∥22]

- 其中θ表示学过的 g s g_s gs 和 g e g_e ge 的参数。D是构成训练数据集的干净图像和噪声潜对 ( x , y ~ ) (x, \tilde y) (x,y~)的集合。λ > 0, ε > 0是超参数。损耗函数的详细推导见附录a。在我们的实现中,我们选择 ϵ = 1 e − 3 \epsilon =1e^{−3} ϵ=1e−3,并使用与基线压缩模型的率失真权衡中相同的λ值。类似于3.2节中介绍的非盲方法,在解码之前,译码器的第一卷积层的输出通道数翻倍, σ σ σ 与 y ~ \tilde y y~ 相连。

L o b j L_{obj} Lobj

[图1:提出的盲解码降噪联合方法的训练流程。在这里, x x x 代表原始的无噪声图像, x ~ \tilde x x~ 是有噪声的输入图像, g a g_a ga 是编码器, g s g_s gs 是解码器, y ~ \tilde y y~ 是潜在表示,而 x ^ \hat x x^ 是重构的无噪声图像。]

[图2:噪声图计算过程。非盲B方法采用12通道 σ b σ_b σb的噪声映射,非盲S方法采用3通道 σ s σ_s σs的噪声映射。]

[图2:噪声图计算过程。非盲B方法采用12通道 σ b σ_b σb的噪声映射,非盲S方法采用3通道 σ s σ_s σs的噪声映射。]

[图3:提出的非盲去噪和解码方法的训练管道。这里σ指的是低分辨率噪声图,对于非盲S有3通道 σ s σ_s σs,对于非盲B有12通道 σ b σ_b σb。]

[图3:提出的非盲去噪和解码方法的训练管道。这里σ指的是低分辨率噪声图,对于非盲S有3通道 σ s σ_s σs,对于非盲B有12通道 σ b σ_b σb。]

[图4:所提出的盲E去噪解码方法的训练管道。该结构建立在非盲方法的基础上, g s g_s gs 指的是非盲去噪解码器。 g e g_e ge 为噪声水平估计网络。真实均匀噪声水平图 σ u \sigma_u σu 包含噪声图像 x ~ \tilde x x~ 的整体噪声水平,即对所有像素的标准差的估计 x ~ − x \tilde x − x x~−x ]

[图5:盲L方法的训练管道。]

[图5:盲L方法的训练管道。]

[图6:基于CBDNet CNN_E的架构,盲E用于估计均匀噪声级映射 σ u σ_u σu 的 g e g_e ge 架构。]

[图7:盲L中使用 g e g_e ge体系结构来估计点级潜在噪声水平映射 σ σ σ,基于CBDNet中的CNN_E的体系结构。M是潜在噪声 y ~ \tilde y y~的通道数。]