多尺度分析

最近对多尺度特征不大了解网上找了一篇2022ECCV的论文《Feature Pyramid Transformer》,看了里面的背景介绍。便对多尺度分析有了一定的了解。

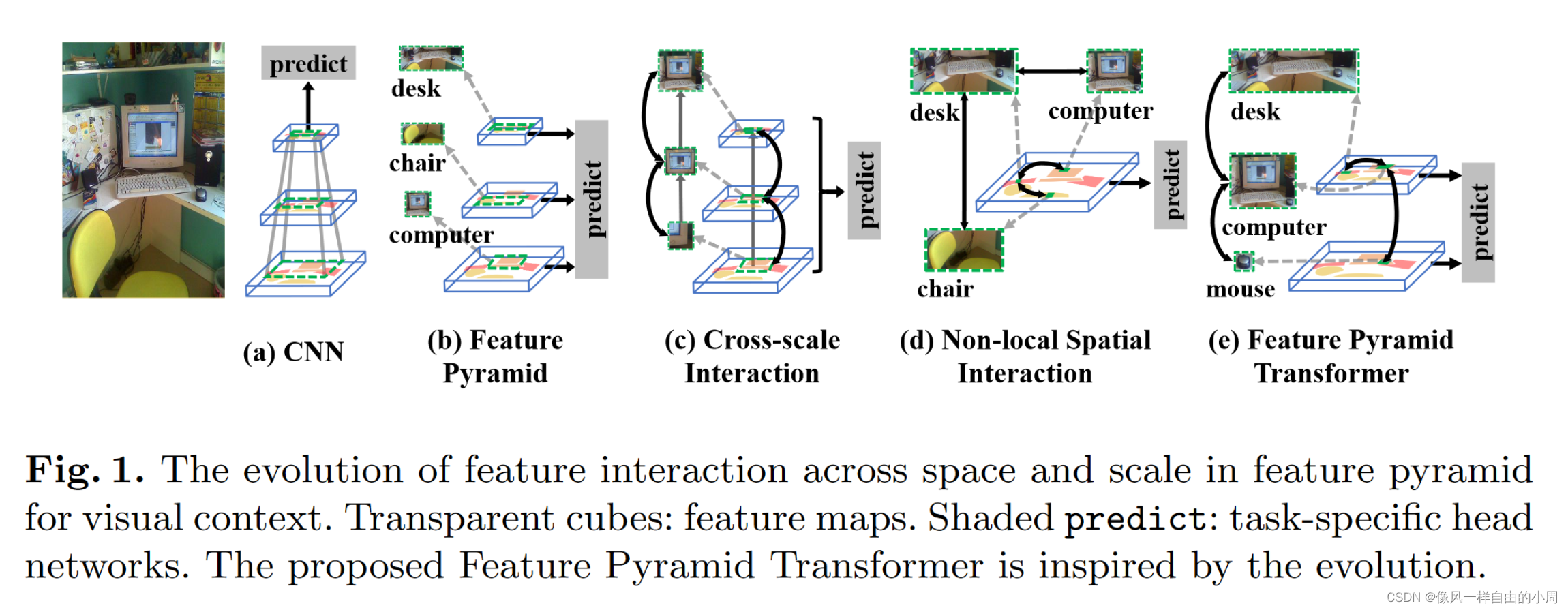

首先我们看一下上述图例中的a,也就是我们常用的卷积神经网络。随着网络越来越深,卷积网络提取到的特征语义越丰富,但是对于上图桌子上的鼠标,往往在对应于网络中的最后一个卷积网络层提取到的特征中的某一个数值(这样往往是不够的,一个数值表达的东西也太少了)。对于某些不太关注这些微小物体的任务而言,比如图像分类,标签只有电脑和椅子这些大物体。往往这样做对于网络性能影响不大。但是有不少像素级任务,比如语义分割需要给每一个像素进行分类,故这些微小物体便需要格外注意。

为了提高对这些小物体的特征提取能力,一个简单的做法是,最后的特征尺度太小了,我们直接给不同尺度的图像进行特征提取或者直接选取不同尺度的特征,这样大尺度的图像提取到的特征便可以更聚焦于微小物体(上图中的b)。下图是常见的FPN架构。

但是图b的做法明显浪费了同一物体不同尺度特征的交互,图c便考虑到了这一点。这样做也是不够的,既然不同尺度的特征要进行交互,那么同一尺度上的特征内部是否需要进行交互?答案是显然的,需要。举个例子,上述的电脑显示器如果单拎出来没有其它的参照物,我们可以把它认为是一个电视机。如果有了其它参照物,如键盘和鼠标,我们便可以更加确定这个东西是电脑显示器而不是电视机。故我们便需要对同一尺度上的特征进行交互也就是图d要干的事情。这里的交互实现方法有很多,常见的有基于Attention的方法。结合图c和图d的做法,便有了作者提出的图e的思路。当然,这里作者为了进行特征交互,设计了三种不同的Transformer结构。感兴趣的读者可以自行阅读。