事务的概述

Kafka事务特性是指一系列的生产者生产消息和消费者提交偏移量的操作在一个事务中,或者说是一个原子操作,生产消息和提交偏移量同时成功或者失败。

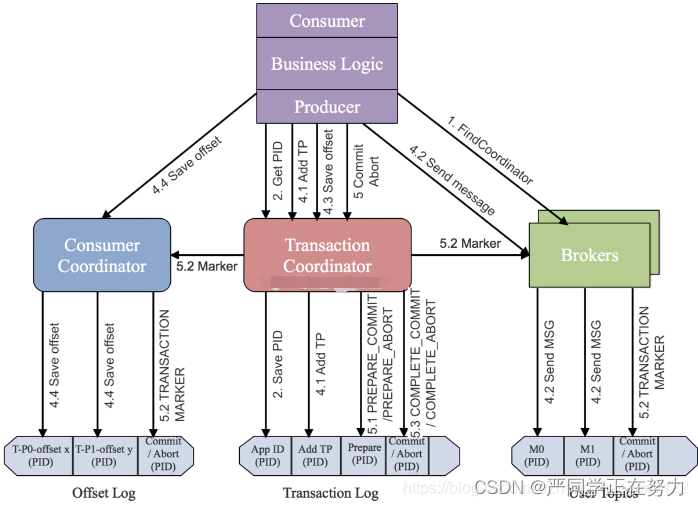

事务的原理

Kafka为了支持事务特性,引入一个新的组件:Transaction Coordinator。主要负责分配pid,记录事务状态等操作。下面时Kafka开启一个事务到提交一个事务的流程图:

事务编程

创建两个topic主题

插入数据

在BD2_old_user主题中添加数据,我们需要编写程序,将用户的性别转换为男、女(1-男,0-女),转换后将数据写入到topic:BD2_new_user中。要求使用事务保障,要么消费了数据同时写入数据到 topic,提交offset。要么全部失败。

张三,1,1980-10-09

李四,0,1985-11-01

编程代码

package org.example;

import org.apache.kafka.clients.consumer.*;

import org.apache.kafka.clients.producer.KafkaProducer;

import org.apache.kafka.clients.producer.Producer;

import org.apache.kafka.clients.producer.ProducerRecord;

import org.apache.kafka.common.TopicPartition;

import java.util.Arrays;

import java.util.HashMap;

import java.util.Map;

import java.util.Properties;

public class TransUse {

public static void main(String[] args) {

Consumer<String, String> consumer = createConsumer();

Producer<String, String> producer = createProduceer();

// 初始化事务

producer.initTransactions();

while(true) {

try {

// 1. 开启事务

producer.beginTransaction();

// 2. 定义Map结构,用于保存分区对应的offset

Map<TopicPartition, OffsetAndMetadata> offsetCommits = new HashMap<>();

// 2. 拉取消息

ConsumerRecords<String, String> records = consumer.poll(2000);

for (ConsumerRecord<String, String> record : records) {

// 3. 保存偏移量

offsetCommits.put(new TopicPartition(record.topic(), record.partition()),

new OffsetAndMetadata(record.offset() + 1));

// 4. 进行转换处理

String[] fields = record.value().split(",");

fields[1] = fields[1].equalsIgnoreCase("1") ? "男":"女";

String message = fields[0] + "," + fields[1] + "," + fields[2];

// 5. 生产消息到dwd_user

producer.send(new ProducerRecord<>("BD2_new_user", message));

}

// 6. 提交偏移量到事务

producer.sendOffsetsToTransaction(offsetCommits, "BD2_old_user");

// 7. 提交事务

producer.commitTransaction();

} catch (Exception e) {

// 8. 放弃事务

producer.abortTransaction();

}

}

}

// 1. 创建消费者

public static Consumer<String, String> createConsumer() {

// 1. 创建Kafka消费者配置

Properties props = new Properties();

props.setProperty("bootstrap.servers", "node1:9092");

props.setProperty("group.id", "BD2_old_user");

props.put("isolation.level","read_committed");

props.setProperty("enable.auto.commit", "false");

props.setProperty("key.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

props.setProperty("value.deserializer", "org.apache.kafka.common.serialization.StringDeserializer");

// 2. 创建Kafka消费者

KafkaConsumer<String, String> consumer = new KafkaConsumer<>(props);

// 3. 订阅要消费的主题

consumer.subscribe(Arrays.asList("BD2_old_user"));

return consumer;

}

// 2. 创建生产者

public static Producer<String, String> createProduceer() {

// 1. 创建生产者配置

Properties props = new Properties();

props.put("bootstrap.servers", "node1:9092");

props.put("transactional.id", "BD2_new_user");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

// 2. 创建生产者

Producer<String, String> producer = new KafkaProducer<String, String>(props);

return producer;

}

}

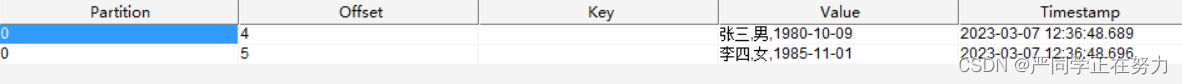

实现的结果

我们发现,可以消费到消息,但如果中间出现异常的话,offset是不会被提交的,除非消费、生产消息都成功,才会提交事务。