提示:文章写完后,目录可以自动生成,如何生成可参考右边的帮助文档

文章目录

- 前言

- 四、centerpoint maskrcnn等的学习

- 四、自我介绍

- 一、岗位信息

- 二、使用步骤

- 三、相关论文解析

-

-

- 1.A Comprehensive Overhaul of Feature Distillation

- 2.MONODISTILL: LEARNING SPATIAL FEATURES FOR MONOCULAR 3D OBJECT DETECTION

- 3.LiDAR Distillation: Bridging the Beam-Induced Domain Gap for 3D Object Detection

- 4.SparseKD

- 5.Masked Generative Distillation

- 6.PointPillars:点云目标检测的快速编码器

- 7.SiamRPN++:深层网络连体视觉跟踪的演变

-

- 总结

前言

提示:这里可以添加本文要记录的大概内容:

例如:随着人工智能的不断发展,机器学习这门技术也越来越重要,很多人都开启了学习机器学习,本文就介绍了机器学习的基础内容。

四、centerpoint maskrcnn等的学习

四、自我介绍

各位老师好,我叫胡子聪,本科就读于哈尔滨工程大学,本科期间参加了青年科普大赛获得了国家二等奖,参加了全国电赛获得了省一等奖、全国“工训赛”省特等奖,2021年保研至北京大学软件与微电子学院集成电路,目前研一在读,主要的研究方向是模型压缩与模型加速,主要是知识蒸馏方向,同时对剪枝、量化也有所了解。主要是参与过基于知识蒸馏的图像分类、实例分割、目标跟踪、点云3D目标检测的相关模型压缩研究与应用,也对知识蒸馏方向的前沿论文进行了跟踪的前沿阅读。我投递的岗位是自动驾驶感知算法实习生,之前学习过点云3D目标检测的相关内容,主要是基于基于openmmmlab的开源框架OpenPCDet学习了PointPillars、CenterPoint、Second等算法的训练、测试、可视化。同时学习了3D目标检测算法中的知识蒸馏算法LiDAR-Distillation、SparseKD、MonoDistill等知识蒸馏算法。利用SparseKD算法将CenterPoint(Voxel Pillars)在KITTI数据集上进行移植,改变模型的结构、以及Voxel Size,使得其模型大小大幅下降同时算法性能变化不大。针对咱们的岗位的话目前我认为我是对目标检测与分割的相关内容有所了解,同时由于之前也主要是负责模型压缩这一块的内容,如果有模型压缩相关的需求的话也可以做。

一、岗位信息

1.旷视 自动驾驶感知算法实习生职位

工作职责

1.跟踪、复现国内外学术界和产业界的前沿研究成果

2.参与环境感知算法的研究,包括视觉和Lidar的2D/3D检测、分割、多相机BEV感知、多传感器融合等领域

职位要求

1.熟悉检测、分割领域的常见方法

2.具有扎实的C++/python基础、算法和数据结构基础,有良好代码风格和代码质量意识,熟悉Linux环境下的程序开发

二、使用步骤

项目名称:《基于知识蒸馏的实例分割模型压缩研究与应用》

项目内容:基于openmmmlab的开源框架mmdetection实现了Mask-RCNN-R101在自用数据集下的训练、测

试、demo可视化。利用知识蒸馏算法MGD实现对Mask-RCNN-R101的蒸馏,通过将Mask-RCNN-R101蒸馏到

学生网络Mask-RCNN-R18/MV2,在保持检测和分割精度下降不大的同时使得模型的体积为原先的6.5%,1.4%。

项目名称:《基于知识蒸馏的目标跟踪模型压缩研究与应用》

项目内容:本项目提出了基于层关联权重的知识蒸馏算法(LAWKD),融合了OFD算法,引入了软注意力机制

计算教师、学生网络之间特征层的权重。同时,本文选择了5种师生架构,并与11种经典的知识蒸馏算法对比,

将训练得到的学生网络ResNet18、MobileNetV2作为新的SiamRPN++主干完成训练、测试、评估以及搜索超

参等操作,最后在Success和Precision下降不大的情况下,学生网络的模型大小只有教师网络的0.29、0.09,但是

在速度上分别快了2.1倍和3.0倍,最后将新的SiamRPN++模型在OTB100数据集上定性与定量分析。

项目名称:《基于知识蒸馏的点云3D目标检测模型压缩研究与应用》

项目内容:基于openmmmlab的开源框架OpenPCDet学习了PointPillars、CenterPoint、Second等算法的训练、测试、可视化。同时学习了3D目标检测算法中的知识蒸馏算法LiDAR-Distillation、SparseKD、MonoDistill等知识蒸馏算法。利用SparseKD算法将CenterPoint(Voxel Pillars)在KITTI数据集上进行移植,改变模型的结构、以及Voxel Size,使得其模型大小大幅下降同时算法性能变化不大。

项目名称:《生活垃圾智能分类装置》

项目内容:通过Huskylens(AI视觉传感器)学习不同种类的垃圾,Huskylens对采集到的垃圾信息进行特征提

取与存贮、计算对比结果等过程后得到识别结果。再利用IIC通信协议将Huskylens传感器处理后的垃圾信息

传给主控芯片树莓派,树莓派控制舵机将垃圾智能投放到对应的四类垃圾桶中。树莓派与HDMI显示屏相连,

显示屏显示投放的垃圾序号、垃圾类别、数量、是否成功投放等。垃圾桶中安装光电检测传感器进行满载

检测,当垃圾达到阈值时通过蜂鸣器进行报警提醒。

能力:

◆不浮躁,能静下心来专注的做科研和项目,善于理智分析和解决问题,性格豁达乐观、抗压能力强。

◆参与大量竞赛与科研使我具有很强的组织领导、执行、学习力以及团队合作时的协调问题能力。

三、相关论文解析

1.A Comprehensive Overhaul of Feature Distillation

为了实现网络模型压缩,本文提出了一个新的特征蒸馏方法,该方法设计了新的蒸馏损失函数,可以使得教师网络转移(teacher transform),学生网络转移(student transform),特征蒸馏位置(distillation feature position)以及距离函数(distance function)协同作用。具体来说,蒸馏损失包括一个新设计的边缘ReLU的特征变换,一个新的特征蒸馏位置,和一个部分L2距离函数来跳过冗余信息,防止对学生网络的压缩产生不利影响。在ImageNet数据集上,基于ResNet50,本文提出的方法top-1 error为21.65%,超越了教师网络ResNet152的性能。实验证明,本文提出的方法在诸如图像分类,目标检测,语义分割等视觉任务上都有提升。

作者还是聚焦在提升特征蒸馏的表现上,通过对教师网络迁移,学生网络迁移,特征蒸馏位置,距离度量方式等的协同考虑,提出了一种新的特征蒸馏损失函数。本文方法旨在从教师网络的特征中转移两个因素:第一个是经过ReLU激活之后的特征响应的大小,因为它包含了大部分的特征信息,第二个是每个神经元的激活状态。近来的研究表明,神经元的激活状态与网络的表达具有非常强的关联系性,应该被纳入到蒸馏的范围中来。因此,本文提出了一个margin ReLU激活函数,并且利用一个局部的L2正则化进行距离度量,以此来跳过对非必要信息的蒸馏。新提出的蒸馏损失函数显著提升了特征蒸馏表现。

2.MONODISTILL: LEARNING SPATIAL FEATURES FOR MONOCULAR 3D OBJECT DETECTION

ICLR 2022 文章,仅使用单目图像进行 3D 目标检测因为缺乏 spatial cues 的原因一般效果不好,提出了一种在训练阶段引入 LiDAR 信号蒸馏的方法,在测试阶段不增加耗时,并在 KITTI 上取得了 SOTA 效果。

本文提出了一种在训练阶段引入 LiDAR 信号监督的方法,在测试阶段不增加耗时,并在 KITTI 上取得了 SOTA 效果,将 LiDAR 点云投影到图像平面,基于该深度信息训练一个 LiDAR模型,该模型与 RGB 图像训练的模型结构一样,基于训练好的 LiDAR 模型对 rgb 输入的模型进行蒸馏。

仅使用单目图像进行 3D 目标检测因为缺乏 spatial cues 的原因一般效果不好,比如下图中的 (a),当前已有的利用 depth 来提升 spatial cues 的方法有使用单目深度模型估计出 depth,然后通过以下方式:

(b):基于depth 对 rgb 数据进行增强

©:将 depth 转换为伪雷达数据后进行 3d 检测

(d):改为预测 depth 分布,基于分布与图像域特征做外积,然后进行 3d 检测

3.LiDAR Distillation: Bridging the Beam-Induced Domain Gap for 3D Object Detection

之前的一些算法大部分都是为了通用域适应问题设计的(例如ST3D),但面对训练集是高线数点云,测试集是低线数点云的场景,这些算法不能很好地处理。为了解决这个问题,我们提出了LiDAR Distillation。我们方法的**核心是对源域高线数数据进行下采样得到伪低线数点云,与目标域线数对齐。以在高线数点云数据集上训练得到的三维目标检测器作为教师网络,在伪低线数点云数据集上训练得到的三维目标检测器作为学生网络,进行离线知识蒸馏算法,提升学生网络精度。**由于下采样过程是逐步进行的,整个框架是迭代框架。在Waymo->nuScenes上的实验结果表明,我们的方法超过了当前最好方法的性能,并且我们的方法可以很好地与其它通用域适应方法进行结合,在推理过程中不增加任何计算量。

4.SparseKD

我们探讨了知识蒸馏(KD)在开发高效3D对象检测器方面的潜力,重点关注流行的基于pillar和voxel的检测器。在缺乏完善的师生对的情况下,我们首先从模型压缩和输入分辨率降低的角度研究如何获得在准确性和效率之间取得良好平衡的学生模型。然后,我们建立了一个基准,以评估现有的KD方法在2D领域开发的3D对象检测基于6个良好的师生对。进一步,我们提出了一种改进的KD管道,其中包含了一种增强的logit KD方法,只对由教师分类响应确定的几个关键位置进行KD,以及一个教师引导的学生模型初始化,以便通过权重继承将教师模型的特征提取能力转移到学生身上。最后,我们在Waymo和KITTI数据集上进行了广泛的实验。我们表现最好的模型达到了65.75%的LEVEL 2 mAPH,超过了它的教师模型,只需要44%的教师在Waymo上的flops。

5.Masked Generative Distillation

知识蒸馏已成功应用于各种任务。当前的蒸馏算法通常通过模仿教师的输出来提高学生的表现。本文表明,教师还可以通过指导学生的特征恢复来提高学生的表征能力。从这个角度来看,我们提出了掩蔽生成蒸馏(MGD),它很简单:我们屏蔽学生特征的随机像素,并迫使它通过一个简单的块生成教师的完整特征。MGD是一种真正通用的基于特征的蒸馏方法,可用于各种任务,包括图像分类、目标检测、语义分割和实例分割。我们在具有广泛数据集的不同模型上进行了实验,结果表明所有学生都取得了出色的改进。值得注意的是,我们将 ResNet-18 从 69.90% 提高到 71.69% ImageNet top-1 准确率,ResNet-50 主干的 RetinaNet 从 37.4 提高到 41.0 边界框 mAP,SOLO 基于 ResNet-50 从 33.1 提高到 36.2 Mask mAP,DeepLabV3 基于 ResNet-18 从 73.20 提高到 76.02 mIoU。

主要贡献:

1.引入了一种新的基于特征的知识蒸馏方法,它使学生通过其掩码特征生成教师的特征,而不是直接模仿它。

2.提出了一种新的基于特征的蒸馏方法——掩蔽生成蒸馏,它简单且易于使用两个超参数。

3.我们通过对不同数据集的大量实验来验证我们的方法在各种模型上的有效性。对于图像分类和密集预测任务,学生使用 MGD 取得了显着的改进。

6.PointPillars:点云目标检测的快速编码器

PointPillars:一种用于3D目标检测的方法,它仅使用2D卷积层即可实现端到端学习。PointPillars使用一种新颖的编码器来学习点云柱(垂直列)上的特征来预测目标的3D方向框。这种方法有几个优点。首先,通过学习特征而不是依赖固定编码器,PointPillars可以利用点云表示的全部信息。此外,通过对柱体而不是体素进行操作,无需手动调整垂直方向的分箱。最后,柱体是高效的,因为所有关键操作都可以表示为2D卷积,这在GPU上计算非常有效。学习功能的另一个好处是PointPillars无需手动调整即可使用不同的点云配置。例如,它可以轻松合并多个激光雷达扫描,甚至雷达点云。

7.SiamRPN++:深层网络连体视觉跟踪的演变

引入了一种采样策略来打破孪生跟踪器的空间不变性限制。我们成功地训练了一个基于SiamRPN的跟踪器,使用ResNet作为主干网络。利用ResNet结构,提出了一种基于层的互相关运算特征聚合结构(a layer-wise feature aggravation structure),该结构有助于跟踪器从多个层次的特征中预判出相似度图。通过对孪生网络结构的交叉相关分析,发现其两个网络分支在参数个数上存在高度不平衡,因此我们进一步提出了一种深度可分离的相关结构,它不仅大大减少了目标模板分支中的参数个数,而且使模型的训练过程更加稳定。此外,还观察到一个有趣的现象,即相同类别的对象在相同通道上具有较高的响应,而其余通道的响应则被抑制。正交特性也可以提高跟踪性能。

综上所述,本文的主要贡献如下:

1.我们对Siam进行了深入的分析,并证明在使用深网络时,精度的降低是由于绝对平移不变性的破坏。

2.我们提出了一种采样策略以打破空间不变性限制,成功训练了基于ResNet架构的孪生跟踪器。

3.提出了一种基于层次的互相关操作特征聚集结构,该结构有助于跟踪器根据多层次学习的特征预测相似度图。

我们提出了一个深度可分离的相关结构来增强互相关,从而产生与不同语义相关的多重相似度图。

1.cnn的优势相比于mlp是什么?

pointnet++点云采样处理方式

resnet50为什么work,残差结构的介绍

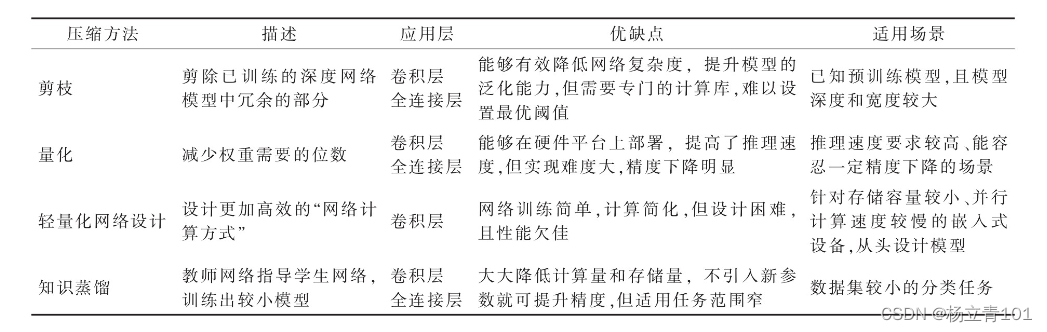

剪枝量化蒸馏的优缺点

压缩的方法主要看两个方面,第一个是部署的硬件,第二个是具体任务的要求。像大多数cpu只支持float32你用量化就没有效果,而移动端效果就很好;剪枝是个通用有效方法,在准确率和性能之间找平衡;蒸馏是大模型教小模型,适用于任务较复杂且部署模型偏小。

3D目标检测的流程

voxel、pillar、point的理解和处理方式

PointPillars、CenterPoint、Second的区别以及网络的理解

MGD、LiDAR-Distillation、SparseKD、MonoDistill等算法的介绍

什么剪枝用的比较多,细粒度还是什么?

pytorch 多卡运行、DataLoader的构成、model.train()和model.eval()用法和区别,以及model.eval()和torch.no_grad()的区别、 Batch Normalization的意思、感受野、过拟合、知识蒸馏教师网络特征处理

python深拷贝和浅拷贝的区别、python 中为什么不需要重载

普通卷积与深度可分离卷积的区别

空洞卷积详解(输入输出大小分析)

【评价标准】目标检测AP

标准化层(BN,LN,IN,GN)介绍及代码实现

知识蒸馏 logits 基于关系的蒸馏 知识蒸馏维度不匹配如何降维 蒸馏前沿论文和技术难点

论文阅读:Knowledge Distillation: A Survey 知识蒸馏综述(2021)

torch.jit (Just-In-Time 即时编译器) (动态图转为静态图)(将模型转成TorchScript)

TensorFlow2.0如何轻松地输出中间层结果

keras学习之:获取神经网络中间层的输出结果、keras、TensorFlow输出中间层结果的4种方法

TensorFlow的自定义算子实现

快速排序的时间复杂度与空间复杂度

快速排序算法——C/C++

C++ static静态成员函数详解

vector动态扩容

C++类继承:派生类的构造函数

C++虚函数与虚表

C++知识积累:如何获取虚函数表以及虚函数地址

Linux常用命令:chmod修改文件权限 777和754

如何查看Linux中 GPU 的占用情况

ubuntu 查看服务器的GPU 谁(用户)在使用

Python中值传递和引用传递区别

Python函数参数:按值传递和按引用传递

Pybind11使用总结(实现C++与Python互相调用)

pytorch Conv 卷积层源码

【架构分析】TensorFlow 自定义算子实现原理分析

Pytorch 模型 查看网络参数的梯度以及参数更新是否正确,优化器学习率设置固定的学习率,分层设置学习率

pytorch的权重/梯度值查看,梯度清零model.zero_grad()

NMS(non_max_suppression)

NMS技术总结(NMS原理、多类别NMS、NMS的缺陷、NMS的改进思路、各种NMS方法)

深度学习常见的优化方法(Optimizer)总结:Adam,SGD,Momentum,AdaGard等

【卷积神经网络】1*1卷积的作用、深度可分离卷积原理及实现

pytorch 量化中的 conv+bn 折叠

transformer中: self-attention部分是否需要进行mask?

从训练和预测角度来理解Transformer中Masked Self-Attention的原理

注意力机制到底是什么——基于常识的基本结构介绍

图像分割之U-Net和maskrcnn的区别

什么是感受野(Receptive Field)? 感受野(Receptive Field)的理解与计算

EfficientNet网络详解

卷积中add与concat操作区别及作用

谈一谈ResNet和DenseNet ResNet网络 残差块的作用

VoxelNet->SECOND->PointPillars

https://github.com/MiaoRain/lund/issues/4

**技术面中90%是根据自己的项目内容进行提问,因此项目准备很重要,对项目中的每一个细节要清楚,对算法的实现也要熟悉。因为简历中涉及传统的图像识别的内容,也涉及基于深度学习方法的目标检测内容,因此要对两者的区别有所理解。面试介绍自己的项目时,应该说明项目的难点,使用了哪些算法进行对比,或者选择该方案的原因,并适当带出自己了解到的最新论文,给面试官留下好印象。

第一 代码能力非常重要,多刷题,这是根本。最好是能独自复现paper上的算法,面试经常面试官问道能不能在没有源码的情况下,复现paper上的模型;

第二 做CV算法机器学习也需要懂,线性回归,逻辑回归,SVM,EM等等,也要花时间尽量弄懂;

第三 虽然我们找工作是偏向深度学习一点,但是传统的图像处理知识会让你在找工作中比只懂深度学习的更有优势

- 回答问题的时候,千万别问什么就回答什么,比如问resnet,最好从vgg开始讲,然后是resnet,inception;densenet可以稍微提下,算法产生的背景,解决策略,最近新的成果,以及同类的其他解决办法,异同点。从横向和纵向两个角度来讲效果会比较好,这也是自己学习的时候路径,当然还有个程度维度,因为自己不可能一次性学到位。

- 可以适当提下最新的研究成果,不用答得很细,比如问优化方法,可以提下RAdam,所以适当阅读一些论文也是有必要的,虽然不是重点,但无论对自己知识的更新还是对面试都有帮助。

- 有问题多找老师,助教,就业辅导,他们人都很nice。多和学员交流。

展示项目。用PPT介绍项目或者视频展示,这样比只靠嘴巴说,更生动也更有说服力。

项目最重要!简历上项目写不好没有面试机会,面试项目问题不好好准备也很难通过。 项目涉及的各种技术及其关联扩展的详解、为什么要用这种方法思考过程是怎样的、有哪些难点、遇到哪些困难、后期做了哪些优化等问题,都要准备好再去面试。我在这方面也有一定的怠惰和心存侥幸。举个我回答失败的例子,面试官问我为什么用triplet,我在详细说triplet是如何做的,甚至说出triplet是一种常见的方法这样naive的话。正确的方法应该是从面临的问题出发、从高屋建瓴的技术宏观视角出发,要解决什么问题,有哪些可行方法,互相对比一下,再看这种方法有什么优势。

面试官问了很多项目某个过程遇到什么困难、难点在哪里、为什么要用这种方法你是如何思考和选择的等问题,这些问题很常见,但是也并不好回答,

面试过程也是聊了聊我的经历和项目,然后重点都在聊他们的case我会怎么做,数据将怎么处理、网络不收敛怎么办、类别不平衡怎么办、数据和模型都跟别人用的一样的,怎么做出比别人更好的结果呢?等等这些具体的问题。技术面之后等了会儿领导来面了下,也就各方面再了解了下。

CV就业2课程里的内容好好的学习,别在面试的时候自己把学的东西写进去,但是又答不上来,一定一定要做笔记,我个人是以写CSDN博客的方式来进行记录自己的学习路径,也可以写知乎或者博客园,这样在面试的时候,面试官也会看你的blog;

对于课程安排的实践项目中,一定要动手实践,对于结果也要做仔细的分析,不要抛出结果结算了,代码算法的实现也要理清楚,不然写进简历,面试官极有可能会问你,某一层的输出维度是多少?还有就是其中某个部分的原理是什么?(后面附具体的问题);

虽然个人找的是深度学习和计算机视觉算法方面的东西,但是机器学习的经典算法也要理解到位,尤其SVM和K-Means、KNN(几乎我每场都被问了),还有就是对于自然语言处理的一些东西也要了解,视野不可以太窄,具体内容,课程上的课程就够了;

还有就是对于算法的应用场景也要有所思考,别只了解一些理论的东西,课程中老师闲扯的东西,尽量自己在做深入的思考(比如,车辆ReID的内容,可以不可以延伸到行人ReID(CV就业班的内容),然后到姿态估计(机器学习集训营第9期有这个好像),然后两者结合增加模型的精确度,再进一步能不能对于视频的内容进行动态识别,等等);

多面试,然后记住当时不会的问题,回去之后多和老师讨论,然后自己进一步学习和复盘,还有就是一定一定不能怂,不会就是不会,会的就是会,真实很重要,这点特别感谢这个秋招一来就业邢老师的陪伴,期间心态都快崩了,邢老师不断地鼓励,感激!!!**

2、SENet的原理说一下,和Attention机制的区别?

3、EfficientNet的原理?基于什么模型的搜索?

4、剪枝和量化有了解吗?具体在实现的时候是基于什么剪枝的,是channel还是weight?

5、int8量化的原理?

6、模型的融合模型准确率有点大,为什么还要选择融合?(这个是简历中的问题,被揪出来了!!!没考虑到的)

2、对于pytorch框架和tensorflow他们的区别是什么?

3、对于SENet的效果提升,有什么看法?

4、讲一下K-Means的原理以及步骤?

5、讲一下决策树的三要素?

6、怎么解决过拟合的问题?

7、对于图像拼接,基于什么特征?为什么选择这个特征?

1、对于EfficientNet,说明一下原理?

2、SENet的原理,以及画出block的图?

3、ReID项目中,Triplet loss的原理?

4、说明一下怎么解决的困难样本的问题?

5、对于ReID模型,模型的FLOPS是多少?可以到达多少帧?

讲讲svm的核函数

svm经过核函数变换后,最重要的是做什么

讲讲RandomForest,决策树,ID3,C4.5 ,CART

numpy中的数组和list有什么区别

k-means

PCA,KPCA

GDBT,XGBoost,LightGBM以及与RandomForest的区别(这个自己完全没掌握)

讲讲resNet

说说bn的作用

说一下word2vec

RNN,LSTM

目标检测中,boundingbox是如何调整的

目标检测算法中有哪些分类,分别讲讲

现在让你提高模型的精度,你有哪些办法,提高模型的召回率,你有哪些办法

有哪些优化方法

你是做图像的,现在让你去做一个nlp或者语音的项目,你准备怎么做

给定一个网络结构和loss,现场推导反向传播算法。

1x1的卷积核有什么作用

全程主要问项目的情况,主要用了什么算法,

为什么用了这个算法效果就要好?

滤波算法有哪些?

研究生学习了哪些课程?

项目陈述,主要用了什么算法,解决了什么问题,算法细节实现?

项目数据集是多少?

为何使用这个算法比另一个算法要好?最后训练结果是多少?

CTO面试,简单介绍了自己所做的项目,选择自己最熟悉的模型介绍一下,所以就介绍了一下FasterRCNN网络,并比较了FasterRCNN在RCNN系列中的改进点,

说明RPN网络的作用,实现细节?

anchor初始化的实现细节?

Faster RCNN如何训练?

NMS实现细节?

自己的项目使用了什么评价方法?含义是什么?

为什么想转行?怎么选择的方向?

未来5年的职业规划是什么?

了解哪些anchor free的网络,

了解哪些最新的模型?

是否会CUDA编程?

one-stage和two-stage目标检测方法的区别和优缺点?

SLIC算法介绍?

是否了解图像拼接,使用了什么特征描述子?

你网络输入的tensor是什么样的,最终输出是多少

为什么要选用这个网络,网络结构是什么样的,网络中64,48是什么意思

有多少照片,最多的类别是多少张,最少的类别是是多少张

如何处理数据不平衡问题,对应的api是什么,在什么地方加入数据不平衡处理

最好的结果是多少,你的结果排名多少

学习率多少,采用什么的衰减策略,为什么用这个衰减策略

激活函数至少写三种以及优劣势

L1和L2的总用及区别

怎么防止过拟合

最近读过的新的paper

特征图尺寸计算

目标检测中map的是怎么计算的。

然后就是面试官问简历上的项目。我简历上主要写了一个fasterRNN的项目,问各种tircks的原理。

残差网络的原理

fasterRCNN的原理

YOLOV3的原理

C++及python方面的语法题

相关部门的技术leader给我面试,上来就拿白纸让我写NMS的实现算法,我写完,又聊了其他的关于检测和跟踪的技术细节,还有过往项目中关于CV算法的实现细节.这部分需要好好准备,简历上所有写的东西都要有十足的把握说服面试官.

3、focal loss 为什么可以解决正负样本不平衡的问题?

4、你是怎么对两个模型进行集成的?

5、样本不平衡有哪些解决办法?

模型的评价指标

解释一下反向传播算法,Pooling层的作用

解释ResNet 和 Inception的结构

解释一个你熟悉的机器学习算法

模型训练的优化方法

介绍项目经历,Faster R-CNN 的原理,YOLOV3的原理。由于编程题是用Java写的所以问是不是不会C++。我就回答,不会。

决策树的剪枝

逻辑回归的损失函数

3、 数据降维有哪些方法

4、 KNN与K-means的区别

5、 数据集中,特征怎么选择?

6、 如何解决数据不平衡问题?

7、 模型的评价指标有哪些?

8、 什么是梯度爆炸和梯度消失?

9、 深度学习的损失函数有哪些?

介绍项目,RetinaNet怎么处理正负样本分布不平衡的问题?

YOLOv3的原理?

segNet,FCN,U-Net有什么区别?转置卷积的原理?

空洞卷积?

训练时梯度爆炸,怎么解决?

小物体检测效果不好,怎么优化?

Batch size的大小对模型训练有什么影响?

如何改善训练模型的效果?

为什么要做数据归一化?

总结

提示:这里对文章进行总结:

例如:以上就是今天要讲的内容,本文仅仅简单介绍了pandas的使用,而pandas提供了大量能使我们快速便捷地处理数据的函数和方法。