总章节:并行编程

计算模型

GPU编程

分布式计算框架

1、概念性问题

为什么需要高性能计算?

什么是高性能计算?

为什么需要并行计算?

什么是并行计算?

高性能计算与并行计算、分布式计算及云计算的联系和区别?

1.1为什么需要高性能计算

除了科学计算之外还在其他领域有计算需求:

商业、医药、工程、人工智能(数据挖掘、深度学习)

例如:天气预报、动漫与影视创作、商业高性能计算(决策支持、风险监测、数据挖掘、供应链优化)

渲染农场:分布式并行集群计算系统

三种提高性能的方法:努力工作、工作得更有效率、团队协作

1.2什么是高性能计算

高性能计算是指使用很多处理器(作为单个机器的一部分)或者某一集群中组织的几台计算机(作为单个计算资源操作)的计算系统和环境。致力于开发超级计算机,研究并行算法和开发相关软件

特点:高速运算、大内存、海量存储

CPU扩展的瓶颈:①晶体管密度的增加不能带来计算性能的增加

②能耗和时钟频率的限制

AMD在2006年第一个推出了双核处理器,其计算单元相互独立,但是它们共享CPU的一、二级缓存

1.3为什么需要并行计算

双核的运算速度不一定会比单核的CPU快,如果不针对多核进行软件开发,双核的运算速度就很可能不如单核的。要想发挥多核功能,设计的软件就首先要能做并行计算

1.3.1并行计算的趋势

①单核时代

驱动力:摩尔定律、晶体管制造技术

局限:能耗、复杂性

如:Assembly----c/c+±------java

②多核时代

驱动力:摩尔定律的限制、SMP技术的发展

局限、能耗、扩展性受限

如:Pthread-----OpenMP

③分布式计算时代

驱动力:网络技术的发展

局限:同步控制、通信负载

如:MPI------MapReduce

④异构计算系统

驱动力:大量数据计算、并行性需求、低功耗GPUs

局限:编程模型、通信负载

如:Shader-----CUDA-----OpenCL

1.3.2为什么需要并行计算

①节省时间

②使用更多的计算资源以获得更短的执行时间

1.4什么是并行计算

1.4.1串行计算

常规软件是串行的

①设计运行于同一个中央处理器上

②通过离散的指令序列完成一个问题的解决

③一条一条指令的执行

④同时只有一条指令在执行

1.4.2并行计算

是同时应用多个计算资源解决一个计算问题

①设计多个计算资源或者处理器

②问题被分解为多个离散的部分,可以同时处理

③每个部分可以由一系列指令完成

每个部分的指令在不同的处理器上执行

1.5并行计算与分布式计算的区别

1.5.1并行计算

不同的活动同时发生

将单个应用程序分散到多个核心/处理器/进程上,使其更快完成更大的计算任务

主要用于科学计算

1.5.2分布式计算

跨系统或远程服务器的活动

更关注并发性和资源共享

2、并行计算机分类

2.1Flynn经典分类法

从处理器的角度:基于指令和数据两个独立维度的计算机体系结构分类

2.2.1单指令单数据SISD

一个串行的计算机系统

单指令:在一个时钟周期内,CPU只对一个指令流进行操作

单数据:在一个时钟周期内,只有一个数据流用作输入

如:单核处理器

2.2.2单指令多数据SIMD

单指令:所有处理单元在任何给定的时钟周期执行相同的指令

多数据:每个处理器可以对不同的数据进行处理

如:GPU,向量处理器(X86 AVX instruction)

2.2.3多指令单数据MISD

多指令:每个处理单元通过单独的指令流独立地处理数据

单数据:单个数据流被送入多个处理单元

如:在CMU实验室测试,可用于容错

2.2.4多指令多数据MIMD

多指令:每个处理器执行不同地指令

多数据:每个处理器处理不同的数据流

如:现在大部分的计算机,如多核CPU

2.2内存结构分类

共享内存与分布式内存

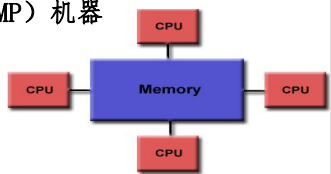

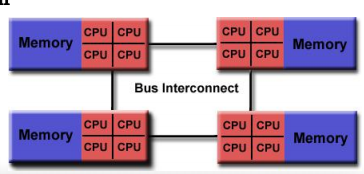

2.2.1共享内存的多处理器系统

具有多个内部多核处理器的单台计算机

分为一致性内存访问UMA和非一致性内存访问NUMA

2.2.1.1一致性内存访问UMA

最常用的是对称多处理器SMP机器

相同的处理器、相同的内存访问时间,如商用服务器

2.2.1.2非一致性内存访问NUMA

通常通过物理连接的方式连接多个SMP

一个SMP可以直接访问另一个SMP、跨链接的内存访问相对较慢

如:HPC服务器

2.2.2多计算节点的分布式内存

连接多台计算机形成一个不共享内存的计算平台

可以让内存和CPU处于同一个Node,也可以处于不同node

①需要通信网络来连接处理器间存储器

②处理器有自己的内存和地址空间

③处理器所作的内存读写对其他处理器的内存没有影响

④不同处理器之间内存中数据的交换方式由程序员和编程模型定义

3、并行编程模型的分类

并行编程模型作为对硬件和内存结构的抽象而存在。

一般来说,编程模型的设计与计算机体系结构相匹配:

①共享内存编程模型对应共享内存模型

②消息传递编程模型对应分布式内存模型

但是编程模型并没有严格对应内存模型

①共享内存计算机上也可以支持消息传递模型,如单个服务器上可以使用MPI

②分布式内存的机器上也可以使用共享内存的编程模型,如分区全局地址空间

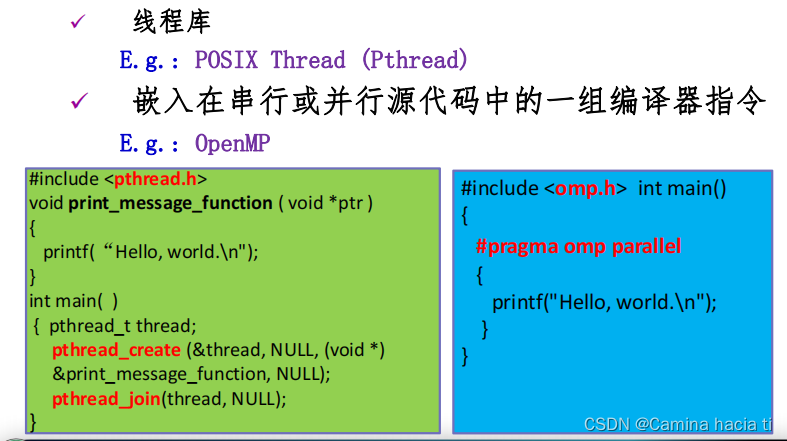

3.1共享内存编程模型

一个进程可以由多个并发执行路径;

线程具有局部数据,但也共享资源;

线程通过全局内存互相通信;

线程生产或者结束,但是主程序仍然提供必要的共享资源,直到应用程序完成

实现:

#

3.2消息传递编程模型

在计算过程中使用本地内存的一组任务集

①多个任务可以驻留在同一物理计算机上和跨任意数量的计算机

②任务通过发送和接收消息通信交换数据

3.3比较

①共享内存

优点:可共享数据、与串行代码相似

缺点:缺少局部控制,不可扩展

②消息传递

优点:可扩展性、局部可控、通信过程在代码中可见

缺点:需要从全局考虑数据的结构和完整的应用、send和receive的对应问题

编程模型的设计和流行程度与并行系统是相互影响

OpenMP、MPI、Pthreads、CUDA只是用户进行并行编程的一部分编程语言

4、思考