这个实验是使用MapReduce分布式编程调试WordCount程序,主要做以下两个问题:

一、所需系统及工具

HDFS 分布式存储系统

MapReduce 分布式计算系统

YARN hadoop 的资源调度系统

Common 以上三大组件的底层支撑组件,提供基础工具包和 RPC 框架等

二、了解一下HDFS中的常用的命令

-mkdir 在HDFS创建目录 hdfs dfs -mkdir /data

-ls 查看当前目录 hdfs dfs -ls /

-ls -R 查看目录与子目录

-put 上传一个文件 hdfs dfs -put data.txt /data/input

-moveFromLocal 上传一个文件,会删除本地文件:ctrl + X

-copyFromLocal 上传一个文件,与put一样

-copyToLocal 下载文件 hdfs dfs -copyToLocal /data/input/data.txt

-get 下载文件 hdfs dfs -get /data/input/data.txt

-rm 删除文件 hdfs dfs -rm /data/input/data.txt

-getmerge 将目录所有的文件先合并,再下载

-cp 拷贝: hdfs dfs -cp /data/input/data.txt /data/input/data01.txt

-mv 移动: hdfs dfs -mv /data/input/data.txt /data/input/data02.txt

-count 统计目录下的文件个数

-text、-cat 查看文件的内容 hdfs dfs -cat /data/input/data.txt

三、Mapreduce简介

3.1 Mapreduce编程模型

MapReduce采用”分而治之”的思想,把对大规模数据集的操作,分发给一个主节点管理下的各个分节点共同完成,然后通过整合各个节点的中间结果,得到最终结果。简单地说,MapReduce就是”任务的分解与结果的汇总”。

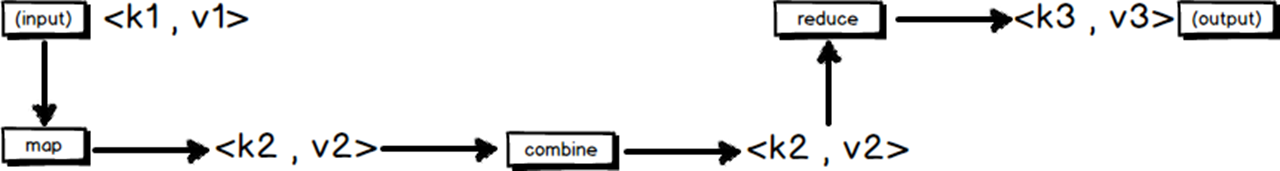

3.2 MapReduce工作原理

1.Mapper负责“分”

分解计算任务,规模大大缩小;

“计算向数据靠近” ;

这些小任务可以并行计算。

2.Reducer负责“汇总” map阶段的结果

3.MapReduce的输入输出

<key,value>键值对

4.从启动和资源调度来看MapReduce过程

客户端(Client)

编写mapreduce程序,配置作业,提交作业,这就是程序员完成的工作。

JobTracker

JobTracker是一个后台服务进程,启动之后,会一直监听并接收来自各个TaskTracker发送的心跳信息,包括资源使用情况和任务运行情况等信息。

TaskTracker

TaskTracker是JobTracker和Task之间的桥梁。TaskTracker与JobTracker和Task之间采用了RPC协议进行通信。

HDFS

保存作业的数据、配置信息等等,最后的结果也是保存在hdfs上面

四、运行以下四个程序

4.1 在下图中没有报错的基础上在HDFSFilefExist.java程序上进行jar打包。

4.2 拖动生成default.package包

把HDFSFilefExist.java从hdfs.files包中拖出来,它会自动形成另一个包default.package。

4.3 生成jar包

4.3.1 选中default.package右击,选择导出——JAVA——JAR file——next

4.3.2 选择存放的路径,最后选择Finish,打包完成

五、传输和解压包(在SecureCRT中运行)

(1)将包传输到SecureCRT里,SecureCRT 【File】→【Connect SFTP Session】开启sftp操作

运行命令put C:mp,jar

(2)解压tar -zxvf mp.jar -C /home/shui

六、运行Wordcount程序

(1)运行cd /home/shui/hadoop-2.7.3/share/hadoop/mapreduce 转入wordcount所在路径。

(2)运行wordcount

hadoop jar mp.jar HDFSFileIfExist

运行成功之后,会出现文件已存在,说明架包成功,无错误,实验成功。