安装配置Hive、MySQL及其JDBC驱动,前提条件:已经安装了Zookeeper、Hadoop、HDFS

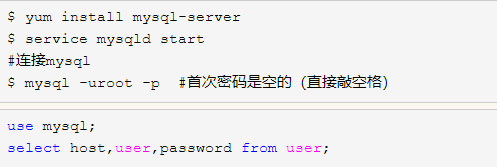

一、安装Mysql

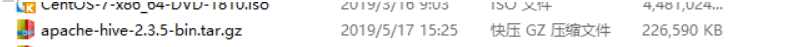

1.1 在Windows下进行下载Mysql

因为使用量多的是单用户数据库模式,并且数据库使用最多的是mysql 所以在这里选择mysql数据库;

1.2 将压缩包从Windows传输到Linux当前目录下:

put D:\大数据软件\mysql-community-release-el7-5.noarch.rpm

1.3 解压:

rpm -ivh mysql-community-release-el7-5.noarch.rpm

1.4 安装:

yum install mysql-community-server

1.5 重启mysql服务:

service mysqld restart (以后开机不需启动mysql)

进入mysql:mysql -u root

1.6 配置文件

/etc/my.cnf

加上编码配置:

[mysql] default-character-set =utf8

远程连接设置:

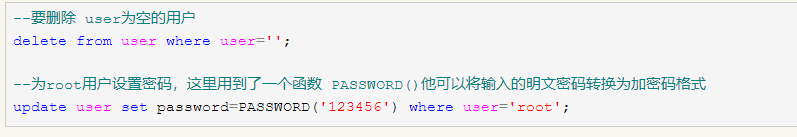

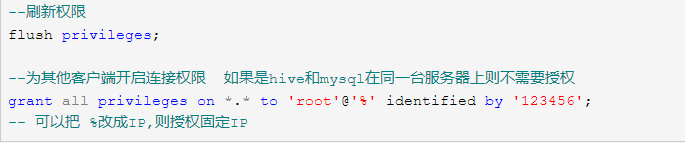

把在所有数据库的所有表的所有权限赋值给位于所有IP地址的root用户:

mysql> grant all privileges on . to root@’ %‘identified by ‘root’;

mysql>flush privileges; 刷新权限

如果是新用户而不是root,则要先新建用户:

mysql>create user ‘username’@’ %’ identified by ‘password’;

二、Hive安装与配置

2.1 在Windows下载压缩包

#启动Zookeeper

$ zkServer.sh start

#启动Hadoop

$ start-all.sh

Hive安装包下载地址:http://www.apache.org/dyn/closer.cgi/hive/

2.2将压缩包从Windows传输到Linux当前目录下

SecureCRT 【File】→【Connect SFTP Session】开启sftp操作

put F:\大数据软件\apache-hive-2.3.5-bin.tar.gz

2.3解压

解压安装到指定目录下/home/shui(/home是系统自带目录,之下的/shui是自己创建的)

tar -zxvf apache-hive-2.3.5-bin.tar.gz -C /home/shui

修改解压目录名为hive。

mv apache-hive-2.3.5-bin.tar hive

2.4 修改环境变量

配置环境变量,将HIVE_HOME写入:

#重新加载配置文件

$ source /root/.bash_profile

Source命令更新etc/profile文件,使其生效。

运行:hive --version

出现版本号及安装成功

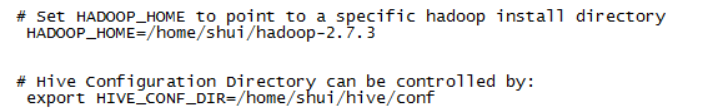

2.5 配置hive-env.sh

进入/home/shui/hive/conf目录,修改hive-env.sh.template的文件名为hive-env.sh。(可以使用cp或者mv命令)

修改Hadoop的安装路径

HADOOP_HOME=/home/shui /hadoop-2.7.3

修改Hive的conf目录的路径

export HIVE_CONF_DIR=/home/shui/hive/conf

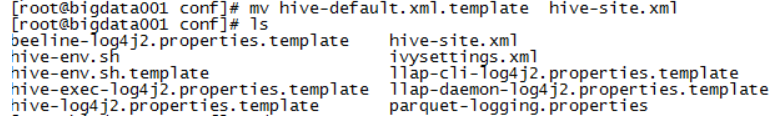

2.6 配置hive-site.xml

进入/home/shui/hive/conf目录,修改default.xml.template的文件名为hive-site.xml。(可以使用cp或者mv命令)

mv hive- default.xml.template hive-site.xml

在最后添加以下属性:

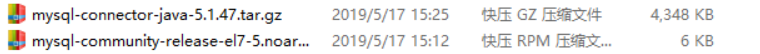

三、MySQL Connector-java安装

3.1 官网下载

3.2将压缩包从Windows传输到Linux当前目录下

SecureCRT 【File】→【Connect SFTP Session】开启sftp操作

put F:\大数据软件\mysql-connector-java-5.1.47.tar.gz

3.3 解压

解压到指定目录下/home/shui(/home是系统自带目录,之下的/yong是自己创建的)

tar -zxvf mysql-connector-java-5.1.47.tar.gz -C /home/yong

3.4 拷贝驱动包

将驱动包mysql-connector-java-5.1.47-bin.jar复制到/home/shui/hive/lib目录中。

四、启动hive

4.1、启动Hadoop:

start-all.sh

4.2、初始化Metastore架构:

schematool -dbType mysql -initSchema

4.3启动Hive:

[root@node4 ~]# hive

19/05/20 13:14:01 WARN conf.Hi

Logging initialized using conf.hive>

如果能正常的显示登录到hive的命令行下,就表示安装成功了