KVM高级功能包括半虚拟化驱动、VT-d、SR-IOV、热插拔、动态迁移、KSM、AVX、cgroups、从物理机或虚拟机中迁移到KVM,以及QEMU监控器和qemu-kvm命令行的各种选项的使用。

1、半虚拟化驱动

1. virtio概述

KVM是必须使用硬件虚拟化辅助技术(如Intel VT-x、AMD-V)的Hypervisor,在CPU运行效率方面有硬件支持,其效率是比较高的;在有Intel EPT特性支持的平台上,内存虚拟化的效率也较高。QEMU/KVM提供了全虚拟化环境,可以让客户机不经过任何修改就能运行在KVM环境中。不过,KVM在I/O虚拟化方面,传统的方式是使用QEMU纯软件的方式来模拟I/O设备(如网卡、磁盘、显卡等),其效率并不非常高。在KVM中,可以在客户机中使用半虚拟化驱动(Paravirtualized Drivers,PV Drivers)来提高客户机的性能(特别是I/O性能)。目前,KVM中实现半虚拟化驱动的方式是采用virtio这个Linux上的设备驱动标准框架。

QEMU模拟I/O设备的基本原理和优缺点:

QEMU以纯软件方式模拟现实世界中的I/O设备的基本过程模型。

QEMU模拟I/O设备:

在使用QEMU模拟I/O的情况下,当客户机中的设备驱动程序(Device Driver)发起I/O操作请求之时,KVM模块(Module)中的I/O操作捕获代码会拦截这次I/O请求,然后在经过处理后将本次I/O请求的信息存放到I/O共享页(sharing page),并通知用户控件的QEMU程序。

QEMU模拟程序获得I/O操作的具体信息之后,交由硬件模拟代码(Emulation Code)来模拟出本次的I/O操作,完成之后,将结果放回到I/O共享页,并通知KVM模块中的I/O操作捕获代码。最后,由KVM模块中的捕获代码读取I/O共享页中的操作结果,并把结果返回到客户机中。当然,在这个操作过程中客户机作为一个QEMU进程在等待I/O时也可能被阻塞。

另外,当客户机通过DMA(Direct Memory Access)访问大块I/O之时,QEMU模拟程序将不会把操作结果放到I/O共享页中,而是通过内存映射的方式将结果直接写到客户机的内存中去,然后通过KVM模块告诉客户机DMA操作已经完成。

QEMU模拟I/O设备的方式,其优点是可以通过软件模拟出各种各样的硬件设备,包括一些不常用的或很老很经典的设备,而且该方式不用修改客户机操作系统,就可以实现模拟设备在客户机中正常工作。在KVM客户机中使用这种方式,对于解决手上没有足够设备的软件开发及调试有非常大的好处。而QEMU模拟I/O设备的方式的缺点是,每次I/O操作的路径比较长,有较多的VMEntry、VMExit发生,需要多次上下文切换(context switch),也需要多次数据复制,所以它的性能较差。

2. virtio的基本原理和优缺点

virtio最初由澳大利亚的一个天才级程序员Rusty Russell编写,是一个在Hypervisor之上的抽象API接口,让客户机知道自己运行在虚拟化环境中,进而根据virtio标准与Hypervisor协作,从而在客户机中达到更好的性能(特别是I/O性能)。目前,有不少虚拟机都采用了virtio半虚拟化驱动来提高性能,如KVM和Lguest。

在QEMU/KVM中,virtio的基本结构框架:

其中前端驱动(frondend,如virtio-blk、virtio-net等)是在客户机中存在的驱动程序模块,而后端处理程序(backend)是在QEMU中实现的[2]。在前后端驱动之间,还定义了两层来支持客户机与QEMU之间的通信。其中,"virtio"这一层是虚拟队列接口,它在概念上将前端驱动程序附加到后端处理程序。一个前端驱动程序可以使用0个或多个队列,具体数量取决于需求。

例如,virtio-net网络驱动程序使用两个虚拟队列(一个用于接收,另一个用于发送),而virtio-blk块驱动程序仅使用一个虚拟队列。虚拟队列实际上被实现为跨越客户机操作系统和Hypervisor的衔接点,但该衔接点可以通过任意方式实现,前提是客户机操作系统和virtio后端程序都遵循一定的标准,以相互匹配的方式实现它。而virtio-ring实现了环形缓冲区(ring buffer),用于保存前端驱动和后端处理程序执行的信息,并且该环形缓冲区可以一次性保存前端驱动的多次I/O请求,并且交由后端驱动去批量处理,最后实际调用宿主机中设备驱动实现物理上的I/O操作,这样做就可以根据约定实现批量处理而不是客户机中每次I/O请求都需要处理一次,从而提高客户机与Hypervisor信息交换的效率。

virtio半虚拟化驱动的方式,可以获得很好的I/O性能,其性能几乎可以达到和native(即非虚拟化环境中的原生系统)差不多的I/O性能。所以,在使用KVM之时,如果宿主机内核和客户机都支持virtio,一般推荐使用virtio达到更好的性能。

当然,virtio也是有缺点的,它需要客户机必须安装特定的virtio驱动使其知道是运行在虚拟化环境中,并且按照virtio的规定格式进行数据传输,不过客户机中可能有一些老的Linux系统不支持virtio,还有一些主流的Windows系统需要安装特定的驱动才支持virtio。不过,较新的一些Linux发行版(如RHEL 6.3、Fedora 17等)默认都将virtio相关驱动编译为模块,可直接作为客户机使用,而主流Windows系统都有对应的virtio驱动程序可供下载使用。

3. 安装virtio驱动

virtio已经是一个比较稳定成熟的技术了,宿主机中比较新的KVM中都支持它,Linux 2.6.24及以上的Linux内核版本都是支持virtio的。由于virtio的后端处理程序是在位于用户空间的QEMU中实现的,所以,在宿主机中只需要比较新的内核即可,不需要特别地编译与virtio相关的驱动。

客户机需要有特定的virtio驱动的支持,以便客户机处理I/O操作请求时调用virtio驱动而不是其原生的设备驱动程序。下面分别介绍Linux和Windows中virtio相关驱动的安装和使用。

1)Linux中的virtio驱动

在一些流行的Linux发行版(如RHEL 6.x、Ubuntu、Fedora)中,其自带的内核一般都将virtio相关的驱动编译为模块,可以根据需要动态地加载相应的模块。其中,对于RHEL系列来说,RHEL 4.8及以上版本、RHEL 5.3及以上版本、RHEL 6.x的所有版本都默认自动安装有virtio相关的半虚拟化驱动。可以查看内核的配置文件来确定某发行版是否支持virtio驱动。

以RHEL 6.3中的内核配置文件为例,其中与virtio相关的配置有如下几项:

CONFIG_VIRTIO=m

CONFIG_VIRTIO_RING=m

CONFIG_VIRTIO_PCI=m

CONFIG_VIRTIO_BALLOON=m

CONFIG_VIRTIO_BLK=m

CONFIG_SCSI_VIRTIO=m

CONFIG_VIRTIO_NET=m

CONFIG_VIRTIO_CONSOLE=m

CONFIG_HW_RANDOM_VIRTIO=m

CONFIG_NET_9P_VIRTIO=m

根据这样的配置选项,在编译安装好内核之后,在内核模块中就可以看到virtio.ko、virtio_ring.ko、virtio_net.ko这样的驱动,如下所示:

[root@kvm-guest ~]# find /lib/modules/2.6.32-279.el6.x86_64/ -name "virtio*.ko"

/lib/modules/2.6.32-279.e16.x86_64/kernel/drivers/net/virtio_net,ko

/lib/modules/2.6.32-279.e16.x86_64/kernel/drivers/virtio/virtio_pci.ko

/lib/modules/2.6.32-279.e16.x86_64/kernel/drivers/virtio/virtio.ko

/lib/modules/2.6.32-279.el6.x86_64/kernel/drivers/virtio/virtio_balloon.ko /lib/modules/2.6.32-279.el6.x86_64/kernel/drivers/virtio/virtio_ring.ko

/lib/modules/2.6.32-279.e16.x86_64/kernel/drivers/scsi/virtio_scsi.ko

/lib/modules/2.6.32-279.el6.x86_64/kernel/drivers/char/hw_random/virtio-rng.ko /lib/modules/2.6.32-279.el6.x86_64/kernel/drivers/char/virtio_console.ko

在一个正在使用virtio_net网络前端驱动的KVM客户机中,已自动加载的virtio相关模块如下:

[root@kvm-guest ~]# 1smod | grep virtio

virtio_net 16760 0

virtio_pci 7113 0

virtio_ring 7729 2 virtio_net,virtio_pc

virtio 4890 2 virtio_net,virtio_pc其中virtio、virtio_ring、virtio_pci等驱动程序提供了对virtio API的基本支持,是使用任何virtio前端驱动都必需使用的,而且它们的加载还有一定的顺序,应该按照virtio、virtio_ring、virtio_pci的顺序加载,而virtio_net、virtio_blk这样的驱动可以根据实际需要进行选择性的编译和加载。

2)Windows中的virtio驱动

由于Windows这样的操作系统不是开源操作系统,而且微软也并没有在其操作系统中默认提供virtio相关的驱动,因此需要另外安装特定的驱动程序以便支持virtio。可以通过Linux系统发行版自带软件包安装(如果有该软件包),也可以到网上下载Windows virtio驱动自行安装。

(1)以RHEL 6.3为例,它有一个名为virtio-win的RPM软件包,能为如下版本的Windows提供virtio相关的驱动:

- Windows XP(仅32位版本);

- Windows Server 2003(32位和64位版本);

- Windows Server 2008(32位和64位版本);

- Windows 7(32位和64位版本);

可以通过yum来安装virtio-win这个软件包,代码如下:

[root@jay-linux kvm_demo]# yum install virto-win

[root@jay-linux kvm_demo]# rpm -q virtio-win

virtio-win-1.5.2-1.el6.noarch

[root@jay-linux kvm_demo]# 1s /usr/share/virtio-win/

drivers virtio-win-1.5.2.iso virtio-win-1.5.2.vfd virtio-win.iso

对于RHEL注册用户,也可以到如下的链接下载:

https://rhn.redhat.com/rhn/software/packages/details/Overview.do?pid=602010

在virtio-win软件包安装完成后,可以看到/usr/share/virtio-win/目录下有一个virtio-win.iso文件,其中包含了所需要的驱动程序。可以将virtio-win.iso文件通过网络共享到Windows客户机中使用,或者通过qemu-kvm命令行的"-cdrom"参数将virtio-win.iso文件作为客户机的光驱。下面以Windows 7客户机为例来介绍在Windows中如何安装virtio驱动。

启动Windows 7客户机,将virio-win.iso作为客户机的光驱,命令行操作如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 win7.img -smp 2 -m 2048 -cdrom /usr/share/virtio-win/virtio-win.iso -vnc :0 -usbdevice tablet

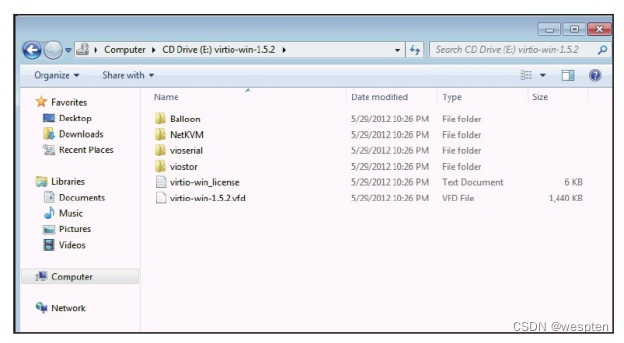

在Windows 7客户机中打开CD-ROM(virtio-win.iso)可看到其中的目录,如图所示,其中有4个子目录分别表示Windows的4个驱动:Balloon目录是内存气球相关的virtio_balloon驱动,NetKVM目录是网络相关的virtio_net驱动,vioserial目录是控制台相关的virtio_serial驱动,viostor是磁盘块设备存储相关的virtio_scsi驱动。

以NetKVM目录为例,其中又包含了各个Windows版本各自的驱动,分别对应Windows XP、Windows 2003、Windows 7、Windows 2008等4个不同的Windows版本。每个Windows版本的目录下又包含"amd64"和"x86"两个版本,分别对应Intel/AMD的x86-64架构和x86-32架构,即64位的Windows系统应该选择amd64中的驱动,而32位Windows选择x86中的驱动。

在安装驱动前,在Windows(此处示例为英文版)客户机中通过"Computer"右键单击选择"Manage",在选中的Device Manager(设备管理器)中查看磁盘和网卡驱动。

如图所示,磁盘驱动是QEMU模拟的IDE硬盘,网卡是QEMU模拟的rtl8139系列网卡。

(2)在启动客户机时,向其分配一些virtio相关的设备,在Windows中根据设备安装驱动。

这一步安装的驱动包括virtio_balloon、virtio_net、virtio_serial这3个驱动,而virtio_scsi是磁盘相关的驱动,相关内容将在步骤3)中单独介绍。

qemu-kvm命令行中有如下的参数分别对应这3个驱动:

- "-balloon virtio"提供了virtio_balloon相关的设备;

- "-net nic,model=virtio"提供了virtio_net相关的设备;

- "-device virtio-serial-pci"提供了virtio_serial相关的设备;

启动客户机的命令行如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 win7.img -smp 2 -m

2048 -cdrom /usr/share/virtio-win/virtio-win.iso -vne:0 -usbdevice tablet -net nic,model=virtio -net tap -balloon virtio -device virtio-serial-pci

在启动后,在Windows客户机的"Device Manager"的"Other devices"项目中会有3个设备没有找到合适的驱动,如图所示,而且网卡处于不可用状态,这是因为使用virtio模型的网卡,没有驱动可用。

在这3个设备中,"Ethernet Controller"是使用virtio的网卡、"PCI Device"是内存balloon的virtio设备、"PCI Simple Communication Controller"是使用virtio的控制台设备。

在未安装virtio驱动的设备上,右键单击,选择"update driver software"更新驱动程序,然后选择"Browser my computer for driver software",选择在virtio-win.iso中相对应的virtio驱动目录,单击"Next"按钮,就安装对应的virtio驱动了。安装或更新完驱动后,系统会提示"Windows has successfully updated your driver software"。

以virtio的网卡为例,选择驱动程序的操作,如图所示。

在依次安装完这3个virtio驱动程序后,在"Device Manager"中的"Network adapter"项目中有了"Red Hat VirtIO Ethernet Adapter"设备,在"System devices"项目中增加了"VirtIO Balloon Driver"和"VirtIO-Serial Driver"这两个设备。网卡驱动安装好后即可生效,网络连接已经正常,而内存的balloon驱动和控制台驱动需要在重启客户机Windows系统后才能生效。

(3)安装磁盘virtio驱动程序,其过程与之前的驱动安装略有不同,因为系统中没有virtio_scsi驱动就不能识别硬盘,系统就不能启动,所以可以通过两种方式来安装。其中一种是,在系统启动前从带有virtio驱动的可启动的光盘或软盘将驱动安装好,然后再重启系统从virtio的硬盘进系统。另一种方法是,使用一个非启动硬盘,将其指定为使用virtio驱动,在Windows客户机系统中会发现该非启动硬盘没有合适的驱动,像前面安装其他驱动那样安装即可,然后重启系统将启动硬盘的镜像文件也设置为virtio方式即可使用virtio驱动启动客户机系统。

这里选择第二种方式来演示磁盘virtio驱动的安装,代码如下,其目的是建立一个伪镜像文件,然后将其作为Windows客户机的一个非启动硬盘。

[root@jay-linux kvm_demo]# qemu-img create -f qcow2 fake.qcow2 10M

Formatting 'fake.qcow2',fmt=qcow2 size=10485760 encryption=off cluster size=65536

[root@jay-linux kvm demo]# qemu-system-x86_64 win7.img -drive file=fake.qcow2,if=virtio -smp 2 -m 2048 -cdrom

/usr/share/virtio-win/virtio-win.iso-vnc :0-usbdevice taSle@vespten

在Windows客户机的"Device Manager"中会看到"Other devices"项目下有一个没有驱动程序的"SCSI Controller",如图所示。

同前面步骤2)中更新驱动程序一样,选择virtio-win中的viostor目录下的对应驱动进行安装即可。安装完成后,用如下命令重启系统,使用virtio驱动的磁盘镜像。

[root@jay-linux kym demo]# qemu-system-x86_64 -drive file=win7.img,if=virtio -smp 2 -m 2048 -vnc :0 -usbdevice tablete

启动系统后,在Windows客户机的"Device Manager"的"Disk drives"项目下可看到"Red Hat VirtIO SCSI Disk Device","Storage Controller"项目下有"Red Hat VirtIO SCSI Controller"即表明正在使用virtio_scsi驱动。

(4)在安装好了这4个virtio驱动后,用下面的命令行重新启动这个客户机,使这4个virtio驱动全部处于使用状态。

[root@jay-linux kym_demo]# qemu-system-x86_64 -drive file=win7.img,if=virtio -smp 2 -m 2048 -net nic,model=virtio -net tap -balloon virtio -device virtio-serial-pci -vnc :0 -usbdevice tablet

可以在"Device Manager"中查看已经安装并使用的virtio驱动。

除了RHEL提供的virtio-win ISO文件之外,在github中也有最新KVM中Windows客户机的virtio驱动源代码仓库。访问https://github.com/YanVugenfirer/kvm-guest-drivers-windows,可以通过下载、编译得到所需要的驱动。当然编译过程可能比较复杂,可进行阅读代码仓库中的一些编译说明进行学习。

在64位的Windows系统中,从Windows Vista开始(如Windows 7、Windows 2008等),所安装的驱动就要求有数字签名。如果使用的发行版并没有提供Windows virtio驱动的二进制文件,或者没有对应的数字签名,则可以选择从Fedora项目中下载二进制ISO文件,它们都进行了数字签名,并且通过了在Windows系统上的测试。从http://alt.fedoraproject.org/pub/alt/virtio-win/latest/images/bin/可以下载Fedora项目提供的Windows virtio驱动,之后的安装过程与前面讲述的过程完全一致。

4. 使用virtio_balloon

1)ballooning简介

通常来说,要改变客户机占用的宿主机内存,要先关闭客户机,修改启动时的内存配置,然后重启客户机才能实现。而内存的ballooning(气球)技术可以在客户机运行时动态地调整它所占用的宿主机内存资源,而不需要关闭客户机。

ballooning技术形象地在客户机占用的内存中引入气球(balloon)的概念。气球中的内存是可以供宿主机使用的(但不能被客户机访问或使用),所以,当宿主机内存紧张,空余内存不多时,可以请求客户机回收利用已分配给客户机的部分内存,客户机就会释放其空闲的内存,此时若客户机空闲内存不足,可能还会回收部分使用中的内存,可能会将部分内存换出到客户机的交换分区(swap)中,从而使内存气球充气膨胀,进而使宿主机回收气球中的内存用于其他进程(或其他客户机)。反之,当客户机中内存不足时,也可以让客户机的内存气球压缩,释放出内存气球中的部分内存,让客户机使用更多的内存。

目前很多虚拟机,如KVM、Xen、VMware等,都对ballooning技术提供支持。

关于内存balloon的概念,其示意图如图所示:

2)KVM中ballooning的原理及优劣势

KVM中ballooning的工作过程主要有如下几步:

- Hypervisor(即KVM)发送请求到客户机操作系统让其归还一定数量的内存给Hypervisor。

- 客户机操作系统中的virtio_balloon驱动接收到Hypervisor的请求。

- virtio_balloon驱动使客户机的内存气球膨胀,气球中的内存就不能被客户机访问。如果此时客户机中内存剩余量不多(如某应用程序绑定/申请了大量的内存),并且不能让内存气球膨胀到足够大以满足Hypervisor的请求,那么virtio_balloon驱动也会尽可能多地提供内存使气球膨胀,尽量去满足Hypervisor的请求中的内存数量(即使不一定能完全满足)。

- 客户机操作系统归还气球中的内存给Hypervisor。

- Hypervisor可以将从气球中得来的内存分配到任何需要的地方。

- 即使从气球中得到的内存没有处于使用中,Hypervisor也可以将内存返还到客户机中,这个过程为:Hypervisor发请求到客户机的virtio_balloon驱动;这个请求使客户机操作系统压缩内存气球;在气球中的内存被释放出来,重新由客户机访问和使用。

ballooning在节约内存和灵活分配内存方面有明显的优势,其好处有如下3点。

- 因为ballooning能够被控制和监控,所以能够潜在地节约大量的内存。它不同于内存页共享技术(KSM是内核自发完成的,不可控),客户机系统的内存只有在通过命令行调整balloon时才会随之改变,所以能够监控系统内存并验证ballooning引起的变化。

- ballooning对内存的调节很灵活,既可以精细地请求少量内存,又可以粗犷地请求大量的内存。

- Hypervisor使用ballooning让客户机归还部分内存,从而缓解其内存压力。而且从气球中回收的内存也不要求一定要被分配给另外某个进程(或另外的客户机)。

从另一方面来说,KVM中ballooning的使用不方便、不完善的地方也是存在的,其缺点如下。

- ballooning需要客户机操作系统加载virtio_balloon驱动,然而并非每个客户机系统都有该驱动(如Windows需要自己安装该驱动)。

- 如果有大量内存需要从客户机系统中回收,那么ballooning可能会降低客户机操作系统运行的性能。一方面,内存的减少可能会让客户机中作为磁盘数据缓存的内存被放到气球中,从而使客户机中的磁盘I/O访问增加;另一方面,如果处理机制不够好,也可能让客户机中正在运行的进程由于内存不足而执行失败。

- 目前没有比较方便的、自动化的机制来管理ballooning,一般都采用在QEMU monitor中执行balloon命令来实现ballooning。没有对客户机的有效监控,没有自动化的ballooning机制,这可能会使在生产环境中实现大规模自动化部署不是很方便。

- 内存的动态增加或减少,可能会使内存被过度碎片化,从而降低内存使用时的性能。另外,内存的变化会影响到客户机内核对内存使用的优化,比如,内核起初根据目前状态对内存的分配采取了某个策略,而后突然由于balloon的原因使可用内存减少了很多,这时起初的内存策略就可能不是太优化了。

3)KVM中ballooning使用示例

KVM中的ballooning是通过宿主机和客户机协同实现的,在宿主机中应该使用Linux 2.6.27及以上版本的Linux内核(包括KVM模块),使用较新的qemu-kvm(如0.13版本以上),在客户机中也使用Linux 2.6.27及以上版本的Linux内核且将"CONFIG_VIRTIO_BALLOON"配置为模块或编译到内核。在很多Linux发行版中都已经配置有"CONFIG_VIRTIO_BALLOON=m",所以用较新的Linux作为客户机系统,一般不需要额外配置virtio_balloon驱动,使用默认内核配置即可。

在QEMU命令行中可用"-balloon virtio"参数来分配balloon设备给客户机使其调用virtio_balloon驱动来工作,而默认值为没有分配balloon设备(与"-balloon none"效果相同)。

-balloon virtio[,addr=addr]#使用virtio balloon设备,addr可配置客户机中该设备的PCI地址

在QEMU monitor中,有两个命令用于查看和设置客户机内存的大小。

#查看客户机内存占用量(balloon信息)

(qemu) info balloon

#设置客户机内存占用量为numMB CSDN@wespten

(qemu) balloon num

下面介绍在KVM中使用ballooning的操作步骤。

(1)QEMU启动客户机时分配balloon设备,命令行如下。也可以使用较新的"-device"的统一参数来分配balloon设备,如"-device virtio-balloon-pci,id=balloon0,bus=pci.0,addr=0x4"。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -smp 2 -m 2048 -balloon virtio

(2)在启动后的客户机中查看balloon设备及内存使用情况,命令行如下:

[root@kvm-guest ~]# 1spci

00:00.0 Host bridge:Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02)00:01.0 ISA bridge:Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II]00:01.1 IDE interface:Intel Corporation 82371SB PIIX3 IDE [Natoma/Triton II 00:01.3 Bridge:Intel Corporation 82371AB/EB/MB PIIX4 ACPI(rev 03)00:02.0 VGA compatible controller: Cirrus Logic GD 5446 00:03.0 Ethernet controller: Realtek Semiconductor Co., Ltd. RTL-8139/8139C/8139C+(rev 20)

00:04.0 Unclassified device [00ff]:Red Hat,Inc Virtio memory balloon

[root@kvm-guest~]# grep VIRTIO_BALLOON /boot/config-2.6.32-279.el6.x86_64 CONFIG_VIRTIO_BALLOON=m

[root@kvm-guest~]# lsmod | grep virtio

virtio_balloon 4856 0

virtio_pci 7113 0

virtio_ring 7729 2 virtio_balloon,virtio_pci

virtio 4890 2 virtio_balloon,virtio_pci

[root@kvm-guest~]# 1spci -s 00:04.0 -v

00:04.0 Unclassified device [00ff]: Red Hat, Inc Virtio memory balloon

Subsystem:Red Hat,Inc Device 0005

Physical Slot: 4

Flags: fast devsel,IRQ 10 I/O ports at cl00 [size=32]

Kernel driver in use: virtio-pci

Kernel modules:virtio_pci

[root@kvm-guest ~]# free -m

根据上面输出可知,客户机中已经加载virtio_balloon模块,有一个名为"Red Hat,Inc Virtio memory balloon"的PCI设备,它使用了virtio_pci驱动。如果是Windows客户机,则可以在“设备管理器”看到使用virtio balloon设备。

(3)在QEMU monitor中查看和改变客户机占用的内存,命令如下:

(qemu) info balloon

balloon: actual=2048

(qemu) balloon 512

(qemu) info balloon

balloon: actual=512

如果没有使用balloon设备,则在monitor中使用"info balloon"命令查看会得到"Device 'balloon' has not been activated"的警告提示。而"balloon 512"命令将客户机内存设置为512MB。

(4)设置了客户机内存为512 MB后,再到客户机中检查,检查命令:

[root@kvm-guest ~]# free -m对于Windows客户机(如Windows 7),当balloon使其可用内存从2GB降低到512MB时,在其“任务管理器”中看到的内存总数依然是2GB,但是看到它的内存已使用量会增大1536MB(例如从原来使用量350MB变为1886MB),这里占用的1536MB内存正是balloon设备占用的,Windows客户机系统的其他程序已不能使用这1536 MB内存,这时宿主机系统可以再次分配这里的1536MB内存用于其他用途。

另外,值得注意的是,当通过"balloon"命令使客户机内存增加时,其最大值不能超过QEMU命令行启动时设置的内存,例如在命令行中将内存设置为2048MB,如果在Monitor中执行"balloon 4096",则设置的4096MB内存不会生效,该值将会被设置为启动命令行中的最大值(即2048MB)。

4)通过ballooning过载使用内存

在“内存过载使用”中提到,内存过载使用主要有三种方式:swapping、ballooning和page sharing。在多个客户机运行时动态地调整其内存容量,ballooning是一种让内存过载使用得非常有效的机制,使用ballooning可以根据宿主机中对内存的需求,通过"balloon"命令调整客户机内存占用量,从而实现内存的过载使用。

在实际环境中,客户机系统的资源的平均使用率一般并不高,通常是一段时间负载较重,一段时间负载较轻。可以在一个物理宿主机上启动多个客户机,通过ballooning的支持,在某些客户机负载较轻时减少其内存使用,将内存分配给此时负载较重的客户机。

例如,在一个物理内存为8GB的宿主机上,可以在一开始就分别启动6个内存为2GB的客户机(A、B、C、D、E、F等6个),根据平时对各个客户机中资源使用情况的统计可知,在当前一段时间内,A、B、C的负载很轻,就可以通过ballooning降低其内存为512 MB,而D、E、F的内存保持2 GB不变。

内存分配的简单计算为:

512MB×3+2GB×3+512MB(用于宿主机中其他进程)=8GB而在某些其他时间段,当A、B、C等客户机负载较大时,也可以增加它们的内存量(同时减少D、E、F的内存量)。这样就在8GB物理内存上运行了看似需要大于12GB内存才能运行的6个2GB内存的客户机,从而较好地实现了内存的过载使用。

如果客户机中有virtio_balloon驱动,则使用ballooning来实现内存过载使用是非常方便的。而前面提到“在QEMU monitor中使用balloon命令改变内存的操作执行起来不方便”的问题,如果使用libvirt工具来使用KVM,则对ballooning的操作会比较方便,在libvirt工具的"virsh"管理程序中就有"setmem"这个命令来动态更改客户机的可用内存容量,该方式的完整命令为:

virsh setmem<domain-id or domain-name><Amount of memory in KB>5. 使用virtio_net

1)配置和使用virtio_net

在选择KVM中的网络设备时,一般来说优先选择半虚拟化的网络设备而不是纯软件模拟的设备。使用virtio_net半虚拟化驱动,可以提高网络吞吐量(thoughput)和降低网络延迟(latency),从而让客户机中网络达到几乎和非虚拟化系统中使用原生网卡的网络差不多的性能。

要使用virtio_net,需要两部分的支持,宿主机中的QEMU工具的支持和客户机中virtio_net驱动的支持。较新的qemu-kvm都对virtio网卡设备提供支持,且较新的流行Linux发行版中都已经将virtio_net作为模块编译到系统之中了,所以使用起来还是比较方便的。

可以通过如下步骤来使用virtio_net。

(1)检查QEMU是否支持virtio类型的网卡。

[root@jay-linux kvm_demo]# qemu-system-x86_64-net nic,model=?

qemu: Supported NIC models: ne2k pci,i82551,i82557b,i82559er,rtl8139,e1000,pcnet,virtio

从输出信息中支持网卡类型可知,当前qemu-kvm支持virtio网卡模型。

(2)启动客户机时,指定分配virtio网卡设备。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -smp 2 -m 1024 -net nic,model=virtio,macaddr=00:16:3e:22:22 -net tap

VNC server running on '::1:5900'

(3)在客户机中查看virtio网卡的使用情况。

[root]kvm-guest ~]# grep VIRTIO_/boot/config-2.6.32-279.e16.x86_64

CONFIG_VIRTIO_BLK=m

CONFIG_VIRTIO_NET=m

CONFIG_VIRTIO_CONSOLE=m

CONFIG_VIRTIO_RING=m

CONFIG_VIRTIO_PCI=m

CONFIG_VIRTIO_BALLOON=m

[root@kvm-guest ~]# 1spci

00:00.0 Host bridge:Intel Corporation 440FX - 82441FX PMC [Natoma] (rev 02)

00:01.0 ISA bridge:Intel Corporation 82371SB PIIX3 ISA [Natoma/Triton II]

00:01.1 IDE interface:Intel Corporation 82371SB PIIX3 IDE

[root@kvm-guest ~]# 1spci -vv -s 00:03.0

00:03.0 Ethernet controller:Red Hat,Inc Virtio network device

Subsystem:Red Hat,Inc Device 0001

Physical Slot: 3

Control:I/O+ Mem+ BusMaster- SpecCycle- MemWINV-VGASnoop- ParErr- Stepping- SERR- FastB2B- DisINTx+

[root@kvm-guest~]#lsmod | grep virtio

virtio_net 16760 0

virtio_pci 7113 0

virtio_ring 7729 2 virtio_net,virtio_pci

virtio 4890 2 virtio_net,virtio_pci

[root@kvm-guest~]# ethtool -i eth1

driver: virtio_net

version:

firmware-version:

bus-info: virtio0

[root@kvm-guest ~]# ifconfig eth1

[root@kvm-guest ~]# ping 192.168.199.98 -c 1

根据上面的输出信息可知,网络接口eth1使用了virtio_net驱动,并且当前网络连接正常工作。如果启动Windows客户机使用virtio类型的网卡,则在Windows客户机的“设备管理器”中看到的一个名为"Red Hat VirtIO Ethernet Adapter"的设备即是客户机中的网卡。

2)宿主机中TSO和GSO的设置

据Redhat文档[3]的介绍,如果在使用半虚拟化网络驱动(即virtio_net)时得到的依然是较低的性能,可以检查宿主机系统中对GSO和TSO[4]特性的设置。关闭GSO和TSO可以使半虚拟化网络驱动的性能更加优化。

通过如下命令可以检查宿主机中GSO和TSO的设置,其中eth0是建立bridge供客户机使用的网络接口。

[root@jay-linux ~]# brctl show

bridge name bridge id STP enabled interfaces

br0 8000.001320fb4fa8 yes eth0

tap0

[root@jay-linux ~]# ethtool -k eth0

Offload parameters for eth0:

rx-checksumming: on

tx-checksumming: on

scatter-gather: on

#这个就是Tso的状态

tcp-segmentation-offload: on

udp-fragmentation-offload: off

#这是Gso的状态

generic-segmentation-offload: on

generic-receive-offload: on

large-receive-offload: off

通过如下命令可以关闭宿主机的GSO和TSO功能:

[root@jay-linux ~]# ethtool -K eth0 gso off

[root@jay-linux ~]# ethtool -K eth0 tso off

[root@jay-linux ~]## ethtool -k eth0

Offload parameters for eth0:

rx-checksumming: on

tx-checksumming: on

scatter-gather: on

tcp-segmentation-offload: off

udp-fragmentation-offload: off

generic-segmentation-offload: off

generic-receive-offload: on

large-receive-offload: off3)用vhost_net后端驱动

前面提到virtio在宿主机中的后端处理程序(backend)一般是由用户空间的QEMU提供的,然而,如果对于网络IO请求的后端处理能够在在内核空间来完成,则效率会更高,会提高网络吞吐量和减少网络延迟。在比较新的内核中有一个叫做"vhost-net"的驱动模块,它作为一个内核级别的后端处理程序,将virtio-net的后端处理任务放到内核空间中执行,从而提高效率。

在“使用网桥模式”介绍网络配置时,提到有几个选项和virtio相关的,这里也介绍一下。

![]()

vnet_hdr=on|off,设置是否打开TAP设备的"IFF_VNET_HDR"标识:"vnet_hdr=off"表示关闭这个标识,而"vnet_hdr=on"表示强制开启这个标识,如果没有这个标识的支持,则会触发错误。IFF_VNET_HDR是tun/tap的一个标识,打开这个标识则允许发送或接受大数据包时仅做部分的校验和检查。打开这个标识,还可以提高virtio_net驱动的吞吐量。

vhost=on|off,设置是否开启vhost-net这个内核空间的后端处理驱动,它只对使用MIS-X[5]中断方式的virtio客户机有效。

vhostforce=on|off,设置是否强制使用vhost作为非MSI-X中断方式的virtio客户机的后端处理程序。

vhostfs=h,设置去连接一个已经打开的vhost网络设备。

用如下命令行启动一个客户机,就可以在客户机中使用virtio-net作为前端驱动程序,而在后端处理程序时使用vhost-net(当然需要当前宿主机内核支持vhost-net模块)。

[root@jay-linux kvm demo]# qemu-system-x86_64 rhel6u3.img -smp 2 -m 1024 -net nic,model=virtio,macaddr=00:16:3e:22:22 -net tap,vnet_hdr=on,vhost=on

VNC server running on '::1:5900'

启动客户机后,检查客户机网络,应该是可以正常连接的。

而在宿主机中可以查看vhost-net的使用情况,如下:

[root@jay-linux kym_demo]# grep VHOST /boot/config-3.5.0

CONFIG_VHOST_NET=m

[root@jay-linux kvm_demo]# 1smod | grep vhost

vhost_net 17161 1

tun 13220 3 vhost_net

[root@jay-linux kvm demo]# rmmod vhost-net

ERROR: Module vhost net is in use

可见,宿主机中内核将vhost-net编译为module,此时vhost-net模块处于使用中状态(试图删除它时会报告“在使用中”的错误)。

一般来说,使用vhost-net作为后端处理驱动可以提高网络的性能。不过,对于一些使用vhost-net作为后端的网络负载类型,可能使其性能不升反降。特别是从宿主机到其客户机之间的UDP流量,如果客户机处理接受数据的速度比宿主机发送的速度要慢,这时就容易出现性能下降。

在这种情况下,使用vhost-net将会使UDP socket的接受缓冲区更快地溢出,从而导致更多的数据包丢失。因此在这种情况下不使用vhost-net,让传输速度稍微慢一点,反而会提高整体的性能。

使用qemu-kvm命令行时,加上"vhost=off"(或不添加任何vhost选项)就会不使用vhost-net作为后端驱动,而在使用libvirt时,如果要选QEMU作为后端驱动,则需要对客户机的XML配置文件中的网络配置部分进行如下的配置,指定后端驱动的名称为"qemu"(而不是"vhost")。

<interface type="network">

...

<model type="virtio"/>

<driver name="qemu"/>

...

</interface>

6. 使用virtio_blk

virtio_blk驱动使用virtio API为客户机提供了一个高效访问块设备I/O的方法。在QEMU/KVM中对块设备使用virtio,需要在两方面进行配置:客户机中的前端驱动模块virtio_blk和宿主机中的QEMU提供后端处理程序。目前比较流行的Linux发行版都将virtio_blk编译为内核模块,可以作为客户机直接使用virtio_blk,而Windows中的virtio驱动的安装方法已介绍。并且较新的qemu-kvm都是支持virtio block设备的后端处理程序的。

启动一个使用virtio_blk作为磁盘驱动的客户机,其qemu-kvm命令行如下:

[root@jay-linux kym demo]# qemu-system-x86 64-smp 2 -m 1024 -net nic-net tap-drive file=rhel6u3.img,if=virtio

VNC server running on ':1:5900'

在客户机中,查看virtio_blk生效的情况如下所示:

[root@kvm-guest ~]# grep VIRTIO_BLK /boot/config-2.6.32-279.e16.x86_64

CONFIG_VIRTIO_BLK=m

[root@kvm-guest~]# lsmod | grep virtio

virtio_blk 7292 3

virtio_pci 7113 0

virtio_ring 7729 2 virtio_blk,virtio_pci

virtio 4890 2 virtio_blk,virtio_pci

[root@kvm-guest~]# lspci | grep -i block

00:04.0 SCSI storage controller:Red Hat,Inc Virtio block device

[root@kvm-guest~]# lspci -vv -s 00:04.0

00:04.0 SCSI storage controller:Red Hat,Inc Virtio block device

Subsystem: Red Hat, Inc Device 0002

Physical Slot: 4

Control: I/O+ Mem+ BusMaster- SpecCycle- MemWINV-VGASnoop- ParErr- Stepping- SERR- FastB2B- DisINTx+

Status: Cap+ 66MHz- UDF- FastB2B- ParErr- DEVSEL=fast>TAbort-<TAbort-<MAbort->SERR-<PERR-INTx-

Interrupt: pin A routed to IRQ 11

可知客户机中已经加载了virtio_blk等驱动,QEMU提供的virtio块设备使用virtio_blk驱动(以上查询结果中显示为virtio_pci,因为它是任意virtio的PCI设备的一个基础的、必备的驱动)。使用virtio_blk驱动的磁盘显示为"/dev/vda",这不同于IDE硬盘的"/dev/hda"或SATA硬盘的"/dev/sda"这样的显示标识。

而"/dev/vd*"这样的磁盘设备名称可能会导致从前分配在磁盘上的swap分区失效,因为有些客户机系统中记录文件系统信息的"/etc/fstab"文件中有类似如下的对swap分区的写法。

/dev/sda2 swap swap default 0 0

或:

/dev/hda2 swap swap default 0 0

原因就是"/dev/vda2"这样的磁盘分区名称未被正确识别,解决这个问题的方法就很简单了,只需要修改它为如下形式并保存"/etc/fstab"文件,然后重启客户机系统即可。

/dev/vda2 swap swap default 0 0

如果启动的是已安装virtio驱动的Windows客户机,那么在客户机的“设备管理器”中的“存储控制器”中看到的是正在使用"Red Hat VirtIO SCSI Controller"设备作为磁盘。

7. kvm_clock配置

在保持时间的准确性方面,虚拟化环境似乎天生就面临几个难题和挑战。由于在虚拟机中的中断并非真正的中断,而是通过宿主机向客户机注入的虚拟中断,因此中断并不总是能同时且立即传递给一个客户机的所有虚拟CPU(vCPU)。在需要向客户机注入中断时,宿主机的物理CPU可能正在执行其他客户机的vCPU或在运行其他一些非QEMU进程,这就是说中断需要的时间精确性有可能得不到保障。

而在现实使用场景中,如果客户机中时间不准确,就可能导致一些程序和一些用户场景在正确性上遇到麻烦。这类程序或场景,一般是Web应用程序或基于网络的应用场景,如Web应用中的Cookie或Session有效期计算、虚拟机的动态迁移(Live Migration),以及其他一些依赖于时间戳的应用等。

而QEMU/KVM通过提供一个半虚拟化的时钟,即kvm_clock,为客户机提供精确的System time和Wall time,从而避免客户机中时间不准确的问题。kvm_clock使用较新的硬件(如Intel SandyBridge平台)提供的支持,如不变的时钟计数器(Constant Time Stamp Counter)。Constant TSC的计数的频率,即使当前CPU核心改变频率(如使用了一些省电策略),也能保持恒定不变。CPU有一个不变的constant TSC频率是将TSC作为KVM客户机时钟的必要条件。

物理CPU对constant TSC的支持,可以查看宿主机中CPU信息的标识,有"constant_tsc"的即是支持constant TSC的,如下所示(信息来源于运行在SandyBridge硬件平台的系统)。

[root@jay-linux kvm_demo]# grep constant_tsc /proc/cpuinfo

flags : fpu vme de pse tsc msr pae mce cx8 apic sep mtrr

pge mca cmov pat pse36 clflush dts acpi mmx fxsr sse sse2 ss ht

tm pbe syscall nx pdpelgb rdtscp lm constant_tsc arch_perfmon pebs

bts rep good nopl xtopology nonstop tsc aperfmperf pni pclmulqdq

dtes64 monitor ds_cpl vmx smx est tm2 ssse3 cx16 xtpr pdcm pcid

dca sse4_1 sse4_2 ×2apic popcnt tsc_deadline_timer aes xsave avx

lahf_lm ida arat epb xsaveopt pln pts dtherm tpr_shadow vnmi flexpriority ept vpid

一般来说,在较新的Linux发行版的内核中都已经将kvm_clock相关的支持编译进去了,可以查看如下的内核配置选项:

[root@kvm-guest ~]# grep PARAVIRT_GUEST /boot/config-2.6.32-279.el6.x86_64

CONFIG_PARAVIRT_GUEST=y

[root@kvm-guest ~]# grep KVM_CLOCK /boot/config-2.6.32-279.el6.x86_64

CONFIG_KVM_CLOCK=y

而在用QEMU命令行启动客户机时,已经会默认让其使用kvm_clock作为时钟来源。用最普通的命令启动一个Linux客户机,然后查看客户机中与时钟相关的信息如下,可知使用了kvm_clock和硬件的TSC支持。

[root@kvm-guest~]# dmesg | grep -i clock

kvm-clock: Using msrs 4b564d01 and 4b564d00

kvm-clock:cpu 0,msr 0:lclf601,boot clock

kvm-clock:cpu 0,msr 0:2216601,primary cpu clock hpet clockevent registered

kvm-clock: cpu 1, msr 0:2316601, secondary cpu clock Switching to clocksource kvm-clock

rtc_cmos 00:01: setting system clock to 2012-09-17 03:27:16 UTC(1347852436)Refined TSC clocksource calibration:3292.523 MHz.另外,Intel的一些较新的硬件还向时钟提供了更高级的硬件支持,即TSC Deadline Timer,在前面查看一个SandyBridge平台的CPU信息时已经有"tsc_deadline_timer"的标识了。TSC deadline模式,不是使用CPU外部总线的频率去定时减少计数器的值,而是软件设置了一个"deadline"(最后期限)的阀值,当CPU的时间戳计数器的值大于或等于这个"deadline"时,本地的高级可编程中断控制器(Local APIC)就产生一个时钟中断请求(IRQ)。正是由于这个特点(CPU的时钟计数器运行于CPU的内部频率而不依赖于外部总线频率),TSC Deadline Timer可以提供更精确的时间,也可以更容易避免或处理竞态条件(race condition[6])。

KVM模块对TSC Deadline Timer的支持开始于Linux 3.6版本,QEMU对TSC Deadline Timer的支持开始于qeum-kvm 0.12版本。而且在启动客户机时,在qemu-kvm命令行使用"-cpu host"参数才能将这个特性传递给客户机,使其可以使用TSC Deadline Timer。

2、设备直接分配(VT-d)

1. VT-d 概述

在QEMU/KVM中,客户机可以使用的设备大致可分为如下3种类型。

- Emulated device:QEMU纯软件模拟的设备。

- Virtio device:实现VIRTIO API的半虚拟化驱动的设备。

- PCI device assignment:PCI设备直接分配。

其中,前两种类型都已经进行了比较详细的介绍,这里再简单回顾一下它们的优缺点和适用场景。

模拟I/O设备方式的优点是对硬件平台依赖性较低、可以方便模拟一些流行的和较老久的设备、不需要宿主机和客户机的额外支持,因此兼容性高;而其缺点是I/O路径较长、VM-Exit次数很多,因此性能较差。一般适用于对I/O性能要求不高的场景,或者模拟一些老旧遗留(legacy)设备(如RTL8139的网卡)。

virtio半虚拟化设备方式的优点是实现了VIRTIO API,减少了VM-Exit次数,提高了客户机I/O执行效率,比普通模拟I/O的效率高很多;而其缺点是需要客户机中与virtio相关驱动的支持(较老的系统默认没有自带这些驱动,Windows系统中需要额外安装virtio驱动),因此兼容性较差,而且I/O频繁时的CPU使用率较高。

而第三种方式叫做PCI设备直接分配(Device Assignment,或PCI pass-through),它允许将宿主机中的物理PCI(或PCI-E)设备直接分配给客户机完全使用,正是要介绍的重点内容。较新的x86架构的主要硬件平台(包括服务器级、桌面级)都已经支持设备直接分配,其中Intel定义的I/O虚拟化技术规范为"Intel(R)Virtualization Technology for Directed I/O"(VT-d),而AMD的I/O虚拟化技术规范为"AMD-Vi"(也叫做IOMMU)。以在KVM中使用Intel VT-d技术为例来进行介绍(当然AMD IOMMU也是类似的)。

KVM虚拟机支持将宿主机中的PCI、PCI-E设备附加到虚拟化的客户机中,从而让客户机以独占方式访问这个PCI(或PCI-E)设备。通过硬件支持的VT-d技术将设备分配给客户机后,在客户机看来,设备是物理上连接在其PCI(或PCI-E)总线上的,客户机对该设备的I/O交互操作和实际的物理设备操作完全一样,不需要(或者很少需要)Hypervisor(即KVM)的参与。

在KVM中通过VT-d技术使用一个PCI-E网卡的系统架构示例,如图所示。

运行在支持VT-d平台上的QEMU/KVM,可以分配网卡、磁盘控制器、USB控制器、VGA显卡等供客户机直接使用。而为了设备分配的安全性,还需要中断重映射(interrupt remapping)的支持。尽管在使用QEMU命令行进行设备分配时并不直接检查中断重映射功能是否开启,但是在通过一些工具使用KVM时(如RHEL 6.3中的libvirt)默认需要有中断重映射的功能支持,才能使用VT-d分配设备供客户机使用。

设备直接分配让客户机完全占有PCI设备,这样在执行I/O操作时大量地减少甚至避免了VM-Exit陷入到Hypervisor中,极大地提高了I/O性能,可以达到几乎和Native系统中一样的性能。尽管virtio的性能也不错,但VT-d克服了其兼容性不够好和CPU使用率较高的问题。不过,VT-d也有自己的缺点,一台服务器主板上的空间比较有限,允许添加的PCI和PCI-E设备是有限的,如果一台宿主机上有较多数量的客户机,则很难向每台客户机都独立分配VT-d的设备。

另外,大量使用VT-d独立分配设备给客户机,让硬件设备数量增加,这会增加硬件投资成本。为了避免这两个缺点,可以考虑采用如下两个方案:一是,在一台物理宿主机上,仅少数的对I/O(如网络)性能要求较高的客户机使用VT-d直接分配设备(如网卡),而其余的客户机使用纯模拟(emulated)或使用virtio以达到多个客户机共享同一个设备的目的;二是,对于网络I/O的解决方法,可以选择SR-IOV使一个网卡产生多个独立的虚拟网卡,将每个虚拟网卡分别分配给一个客户机使用,这也正是后面“SR-IOV技术”要介绍的内容。另外,设备直接分配还有一个缺点是,对于使用VT-d直接分配了设备的客户机,其动态迁移功能将会受限,不过也可以用热插拔或libvirt工具等方式来缓解这个问题。

2. VT-d环境配置

在KVM中使用VT-d技术进行设备直接分配,需要以下几方面的环境配置。

1)硬件支持和BIOS设置

目前市面上有很多的x86硬件平台都有VT-d的支持,以使用过的几台机器为例,其中服务器平台Intel Xeon X5670、Xeon E5-2680、Xeon E5-4650等和SandyBridge、IvyBridge平台的桌面台式机都是支持VT-d的。

除了在硬件平台层面对VT-d支持之外,还需要在BIOS将VT-d功能打开使其处于"Enabled"状态。由于各个BIOS和硬件厂商的标识的区别,VT-d在BIOS中设置选项的名称也有所不同。BIOS中VT-d设置选项一般为"Intel(R)VT for Directed I/O"或"Intel VT-d"等,已经演示了在BIOS设置中打开VT-d选项的情况。

2)宿主机内核的配置

在宿主机系统中,内核也需要配置相应的选项。在较新的Linux内核(如3.5、3.6)中,应该配置如下几个VT-d相关的配置选项。在Fedora 17(使用3.3或3.4内核)中,也都已经使这些类似的配置处于打开状态,不需要重新编译内核即可直接使用VT-d。

CONFIG_IOMMU_SUPPORT=y

# CONFIG_AMD_IOMMU is not set #AMD平台的IOMMU设置

CONFIG_DMAR_TABLE=y

#Intel平台的VT-d设置

CONFIG_INTEL_IOMMU=y

CONFIG_INTEL_IOMMU_DEFAULT_ON=y

CONFIG_INTEL_IOMMU_FLOPPY_WA=y

CONFIG_IRQ_REMAP=y

而在较旧的Linux内核(3.0及以下,如2.6.32)中,应该配置如下几个VT-d相关的配置选项。与上面较新内核的配置有些不同,大约在发布Linux内核3.0、3.1时进行了一次比较大的选项调整,名称和代码结构有所改变。以RHEL 6.3的内核为例,默认就已经配置了如下的选项,其内核已经支持VT-d技术的使用。

CONFIG_DMAR=y

# CONFIG DMAR_DEFAULT_ON is not set

#本选项可设置为y,也可不设置

CONFIG_DMAR_FLOPPY_WA=y

CONFIG_INTR_REMAP=y

另外,为了配合接下来的第3步设置(用于隐藏设备),还需要配置pci-stub这个内核模块,相关的内核配置选项如下。在RHEL 6.3和Fedora 17系统的默认内核中,都将PCI_STUB配置为y(直接编译到内核),不作为模块来加载。

#如果配置为y(编译进内核),则不需作为模块来加载

CONFIG_PCI_STUB=m

在启动宿主机系统后,可以通过内核的打印信息来检查VT-d是否处于打开可用状态,如下所示。

[root@jay-linux kvm_demo]# dmesg | grep DMAR -i

ACPI:DMAR 0000000bdf96c98 00210 (v01 INTEL S4600LH 06222004 INTL 20090903)

DMAR: Host address width 46

DMAR: DRHD base: 0x00000ebffe000 flags: 0x0

DMAR:DRHD base:Ox00000f7ffe000flags:0x0

DMAR:DRHD base:0x00000fbffe000flags:0x0

DMAR:DRHD base:0x00000dfffc000flags:0x1

DMAR: RMRR base: 0x00000bdd07000 end: 0x000000bddldff

DMAR:ATSR flags:0x0

[root@jay-linux kvm_demo]# dmesg | grep IOMMU -i

IOMMU O: reg base addr ebffe000 ver 1:0 cap d2078c1061062 ecap f020fe

IOMMU 1: reg_base_addr f7ffe000 ver 1:0 cap d2078c106f0462 ecap f020fe

IOMMU 2: reg base addr fbffe000 ver 1:0 cap d2078c106f0462 ecap f020fe

IOMMU 3:reg_base_addr dfffc000 ver 1:0 cap d2078c10660462 ecap f020fe

IOAPIC id 4 under DRHD base Oxfbffe000 IOMMU 2

IOAPIC id 3 under DRHD base 0xf7ffe000 IOMMU 1

IOAPIC id 2 under DRHD base 0xebffe000 IOMMU 0

IOAPIC id 0 under DRHD base Oxdfffc000 IOMMU 3

IOAPIC id 1 under DRHD base 0xdfffc000 IOMMU 3

IOMMU 2 0xfbffe000: using Queued invalidation

IOMMU 1 0xf7ffe000: using Queued invalidation

IOMMU 0 0xebffe000: using Queued invalidation

IOMMU 3 0xdfffc000: using Queued invalidation

IOMMU: Setting RMRR:

IOMMU: Setting identity map for device 0000:00:1d.0 [0xbdd07000 - 0xbddldfff]

IOMMU: Setting identity map for device 0000:00:la.0 [0xbdd07000 - 0xbddldfff]

IOMMU:Prepare 0-16MiB unity mapping for LPC

IOMMU: Setting identity map for device0000:00:1f.0 [0x0 - 0xfffffff]

如果内核的IOMMU默认没有打开,也可以在GRUB的kernel行中加入"intel_iommu=on"这个内核启动选项。

3)在宿主机中隐藏设备

使用pci_stub这个内核模块来对需要分配给客户机的设备进行隐藏,从而让宿主机和未被分配该设备的客户机都无法使用该设备,达到隔离和安全使用的目的,需要通过如下三步来隐藏一个设备。

(1)加载pci_stub驱动(前面“2.宿主机内核的配置”中已提及将"CONFIG_PCI_STUB=m"作为内核编译的配置选项),如下所示。

[root@jay-linux kvm_demo]# modprobe pci_stub

[root@jay-linux kvm_demo]# 1smod | grep stub

pci_stub 1253 0

[root@jay-linux kvm_demo]# 1s /sys/bus/pci/drivers/pci-stub/

0000:06:00.1 bind module new_id remove_id

如果pci_stub已被编译到内核而不是作为module,则仅需最后一个命令来检查/sys/bus/pci/drivers/pci-stub/目录存在即可。

(2)查看设备的vendor ID和device ID,如下所示(假设此设备的BDF为08:00.0)。

[root@jay-linux kvm demo]# lspci -Dn -s 08:00.0

0000:08:00.0 0200: 8086:10b9 (rev 06)

在上面lspci命令行中,-D选项表示在输出信息中显示设备的domain,-n选项表示用数字的方式显示设备的vendor ID和device ID,-s选项表示仅显示后面指定的一个设备的信息。

在该命令的输出信息中,“0000:08:00.0”表示设备在PCI/PCI-E总线中的具体位置,依次是设备的domain(0000)、bus(08)、slot(00)、function(0),其中domain的值一般为0(当机器有多个host bridge时,其取值范围是0~0xffff),bus的取值范围是0~0xff,slot取值范围是0~0x1f,function取值范围是0~0x7,其中后面3个值一般用BDF(即bus:device:function)来简称。在输出信息中,设备的vendor ID是“8086”(“8086”ID代表Intel Corporation),device ID是"10b9"(代表82572网卡)。

(3)绑定设备到pci_stub驱动,命令行操作如下所示。

echo -n "8086 10b9" > /sys/bus/pci/drivers/pci-stub/new_id

echo0000:08:00.0 > /sys/bus/pci/devices/0000:08:00.0/driver/unbind

echo 0000:08:00.0 > /sys/bus/pci/drivers/pci-stub/bind在绑定前,用lspci命令查看BDF为08:00.0的设备使用的驱动是Intel的e1000e驱动,而绑定到pci_stub后,通过如下命令可以可查看到它目前使用的驱动是pci_stub而不是e1000e了,其中lspci的-k选项表示输出信息中显示正在使用的驱动和内核中可以支持该设备的模块。

[root@vt-nhm9 ~]# 1spci -k -s 08:00.0

08:00.0 Ethernet controller: Intel Corporation 82572EI Gigabit \

Ethernet Controller (Copper) (rev 06)

Subsystem: Intel Corporation PRO/1000 PT Desktop Adapter

Kernel driver in use: pci-stub

Kernel modules: el000e

而在客户机不需要使用该设备后,让宿主机使用该设备,则需要将其恢复到使用原本的驱动。

隐藏和恢复设备,手动操作起来还是有点效率低和容易出错,利用如下一个Shell脚本(命名为pcistub.sh脚本)可以方便地实现该功能,并且使用起来非常简单,仅供大家参考。

#!/bin/bash

# A script to hide/unhide PCI/PCIe device for KVM.(using 'pci stub' driver)

hide_dev=0

unhide_dev=0

driver=0

# check if the device exists

function dev_exist()

{

local line_num=$(lspci -s "$1" 2>/dev/null | wc -1)

if [ $line_num = 0 ]; then

echo "Device Spcidev doesn't exists. Please check your system or your command line."

exit 1

else

return 0

fi

}

# output a format "<domain>:<bus>:<slot>.<func>"(e.g.0000:01:10.0) of device

function canon()

{

f='expr "$1" : '.*\.\(.\)''

d='expr "$1" : ".*:\(.*\).$f"'

b='expr "$1" : "\(.*\):$d\.$f"'

if [ 'expr "$d" : '..'' == 0 ]

then

d=0$d

fi

if [ 'expr "$b" : '.*:'' != 0 ]

then

if [ 'expr "$b" : '.*:'' != 0 ]

then

p='expr "$b" : '\(.*\):''

b='expr "$b" : '.*:\(.*\)''

else

p=0000

fi

if [ 'expr "$b" : '..'' == 0 ]

then

b=0$b

fi

echo $p:$b:$d.$f

}

# output the device ID and vendor ID

function show_id()

{

1spci -Dn -s "$1" | awk '{print $3}' | sed "s/:/ /" > /dev/nu11 2>&1

if [ $? -eq 0 ]; then

lspci -Dn -s "$1" | awk '{print $3}' | sed "s/:/ /"

else

echo "Can't find device id and vendor id for device $1"

exit 1

fi

}

#hide a device using 'pci_stub' driver/module

function hide_pci(){

local pre_driver=NULL

local pcidev=$(canon $1)

local pciid=$(show_id $pcidev)

dev_exist $pcidev

if [ -h /sys/bus/pci/devices/"$pcidev"/driver ]; then

pre_driver=$(basename $(readlink /sys/bus/pci/devices/"$pcidev"/driver))

echo "Unbinding $pcidev from $pre_driver"

echo-n "$pciid" > /sys/bus/pci/drivers/pci-stub/new_id

echo -n "$pcidev" > /sys/bus/pci/devices/"$pcidev"/driver/unbind

fi

echo "Binding $pcidev to pci-stub"

echo -n "$pcidev" > /sys/bus/pci/drivers/pci-stub/bind

return $?

}

# unhide a device from 'pci_stub' driver and bind to a new driver

function unhide_pci(){

local driver=$2

local pcidev=$(canon $1)

local pciid=$(show_id $pcidev)

local pre_driver=NULL

dev_exist $pcidev

if [ $driver != 0 -a ! -d /sys/bus/pci/drivers/$driver ]; then

echo "No $driver interface under sys, return fail"

exit 1

fi

if [ -h /sys/bus/pci/devices/"$pcidev"/driver ]; then

pre_driver=$(basename $(readlink /sys/bus/pci/devices/"$pcidev"/driver))

if [ "$pre_driver" = "$driver" ]; then

echo "$1 has been already bind with $driver,no need to unhide and bind."

exit 1

elif [ "$pre_driver" != "pci-stub"]; then

echo "$1 is not bind with pci-stub,it is bind with $pre_driver,no need to unhide"

exit 1

else

echo "Unbinding $pcidev from $pre_driver"

if [ $driver != 0 ]; then

echo -n "$pciid" > /sys/bus/pci/drivers/$driver/new_id

fi

echo -n "$pcidev" > /sys/bus/pci/drivers/pci-stub/unbind

if [ $? -ne 0 ]; then

return $?

fi

fi

fi

if [ $driver != 0 ]; then

echo "Binding $pcidev to $driver"

echo-n "$pcidev" > /sys/bus/pci/drivers/$driver/bind

fi

return $?

}

# show the usage of this script

function usage(){

echo "Usage: pcistub -h pcidev [-u pcidev] [-d driver]"

echo "-h pcidev: <pcidev> is BDF number of the device you want to hide"

echo "-u pcidev: Optional. <pcidev> is BDF number of the device you want to unhide."

echo "-d driver: Optional. When unhiding the device, bind the device with <driver>. The option should be used together with '-u' option"

echo ""

echo "Examplel: sh pcistub.sh -h 06:10.0 # Hide device 01:10.0 to 'pci_stub' driver"

echo "Example2:sh pcistub.sh-u 08:00.0 -d e1000e # Unhide device 08:00.0 and bind the device with 'e1000e' driver"

exit 1

}

if [ $#-eq 0 ] ; then

usage

fi

# parse the options in the command line

OPTIND=1

while getopts ":h:u:d:" Option

do

case $option in

h ) hide_dev=$0PTARG;;

u ) unhide_dev-$OPTARG;;

d ) driver=$OPTARG;;

* ) usage;;

esac

done

if [ ! -d /sys/bus/pci/drivers/pci-stub ]; then

modprobe pci_stub

if [ ! -d /sys/bus/pci/drivers/pci-stub ]; then

echo "There's no 'pci-atub' module? Please check your kernel config."

exit 1

fi

fi

if [ $hide_dev != 0 -a $unhide_dev != 0 ]; then

echo "Do not use -h and -u option together."

exit 1

fi

if [ Sunhide_dev = 0 -a $driver != 0 ]; then

echo "You should set -u option if you want to use -d option to unhide a device and bind it with a specific driver"

exit 1

fi

if [ $hide_dev != 0 ]; then

hide_pci $hide_dev

elif [ $unhide_dev!= 0 ]; then

unhide_pci $unhide_dev $driver

fi

exit $?后面的VT-d/SR-IOV的操作实例就是使用这个脚本对设备进行隐藏和恢复的。

4)通过QEMU命令行分配设备给客户机

利用qemu-kvm命令行中"-device"选项可以为客户机分配一个设备,配合其中的"pci-assign"作为子选项可以实现设备直接分配。

![]()

其中driver是设备使用的驱动,有很多种类,如pci-assign表示PCI设备直接分配、virtio-balloon-pci(又为virtio-balloon)表示ballooning设备(这与前面提到的"-balloonvirtio"的意义相同)。prop[=value]是设置驱动的各个属性值。

"-device?"可以查看有哪些可用的驱动,"-device driver,?"可查看某个驱动的各个属性值,如下面命令行所示。

[root@jay-linux kvm_demo]# qemu-system-x86_64 -device ?

name "usb-kbd",bus USB

name "virtio-serial-pci",bus PCI,alias "virtio-serial"

name "sysbus-ohci", bus System, desc "OHCI USB Controller"

<! -此处省略数十行输出信息 -->

name "virtio-balloon-pci",bus PCI,alias "virtio-balloon"

name "pci-assign",bus PCI

[root@jay-linux kym_demo]# qemu-system-x86_64 -device pci-assign,?

kvm-pci-assign.host=pci-host-devaddr #qemu-kvm 1.1.0没这行

host 属性输出,算是个小bug(qemu-kvm1.2中已经fix了),但功能上正常

pci-assign.prefer_msi=on/off

pci-assign.share_intx=on/off

pci-assign.bootindex=int32

pci-assign.configfd=string

pci-assign.addr=pci-devfn

pci-assign.romfile=string

pci-assign.rombar=uint32

pci-assign.multifunction=on/off

pci-assign.command_serr_enable=on/off

pci-assign.id=string # qemu-kvm 1.1.0中也没有这行提示,但可正常使用espten

在-device pci-assign的属性中,host属性指定分配的PCI设备在宿主机中的地址(BDF号),addr属性表示设备在客户机中的PCI的slot编号(即BDF中的D-device的值),id属性表示该设备的唯一标识(可以在QEMU monitor中用"info pci"命令查看到)。

qemu-kvm命令行工具在启动时分配一个设备给客户机,命令行如下所示。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -device pci-assign,host=08:00.0,id=mydev0,addr=0X6

如果要一次性分配多个设备给客户机,只需在qemu-kvm命令行中重复多次"-device pci-assign,host=$BDF"这样的选项即可。

由于设备直接分配是客户机独占该设备,因此一旦将一个设备分配给客户机使用,就不能再将其分配给另外的客户机使用了,否则在通过命令行启动另一个客户机也分配这个设备时,会遇到如下的错误:

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u2.img -m 1024 -device pci-assign,host=08:00.0

qemu-system-x86 64: -device pci-assign,host=08:00.0: Failed to assign device "(null)" : Device or resource busy

qemu-system-x86_64:-device pci-assign,host=08:00.0: **** The driver 'pci-stub' is occupying your device 0000:08:00.0.

qemu-system-x86_64:-device pci-assign,host=08:00.0: ***

qemu-system-x86_64:-device pci-assign,host=08:00.0: ***

除了在客户机启动时就直接分配设备之外,QEUM/KVM还支持设备的热插拔(hot-plug)在客户机运行时添加所需的直接分配的设备,这需要在QEMU monitor中运行相应的命令。

3. VT-d 操作示例

1)网卡直接分配

在如今的网络时代,有很多服务器对网卡性能要求较高,在虚拟客户机中也不例外。通过VT-d技术将网卡直接分配给客户机使用,会让客户机得到和native环境中使用网卡几乎一样的性能。通过示例来演示将一个Intel 82572型号的PCI-E网卡分配给一个RHEL 6.3客户机使用的过程,这里省略BIOS配置、宿主机内核检查等操作步骤。

(1)选择需要直接分配的网卡

[root@jay-linux kvm_demo]# 1spci -s 08:00.0

08:00.0 Ethernet controller: Intel Corporation 82572EI Gigabit

Ethernet Controller (Copper) (rev 06)

Subsystem:Intel Corporation PRO/1000 PT Desktop Adapter

Kernel driver in use: el000e

Kernel modules: el000e(2)隐藏该网卡(使用了前面介绍的pcistub.sh脚本)

[root@jay-linux kym demo]#./pcistub.sh-h 08:00.0

Unbinding 0000:08:00.0 from e1000e

Binding 0000:08:00.0 to pci-stub

[root@jay-linux kvm_demo]# 1spci -k -s 08:00.0

08:00.0 Ethernet controller: Intel Corporation 82572EI Gigabit

Ethernet Controller (Copper) (rev 06)

Subsystem: Intel Corporation PRO/1000 PT Desktop Adapter

Kernel driver in use:pci-stub

Kernel modules:e1000e(3)启动客户机时分配网卡。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -smp 2 -m 1024 -device pci-assign,host=08:00.0,id=mynic -net none

VNC server running on '::1:5900'

命令行中的"-net none"表示不使其他的网卡设备(除了直接分配的网卡之外),否则在客户机中将会出现一个直接分配的网卡和另一个emulated的网卡。

在QEMU monitor中,可以用"info pci"命令查看分配给客户机的PCI设备的情况。

(qemu) info pci

<! -此处省略PCI设备的信息 -->(4)在客户机中查看网卡的工作情况。

[root@kvm-guest ~]#lspci -s 00:06.0

00:06.0 Ethernet controller: Intel Corporation 82572EI Gigabit

[root@kvm-guest ~]# ethtool -i eth2

driver: el000e

version: 1.9.5-k

firmware-version:5.11-10

bus-info:0000:00:06.0

[root@kvm-guest ~]# ping 192.168.199.98 -I eth2 -c 1

PING 192.168.199.98(192.168.199.98) from 192.168.199.69 eth2:

56(84) bytes of data.

64 bytes from 192.168.199.98: icmp_seq=1 ttl=64 time=0.367 ms

--- 192.168.199.98 ping statistics ---

1 packets transmitted, 1 received, 0% packet loss, time Oms

rtt min/avg/max/mdev = 0.367/0.367/0.367/0.000 ms

由上面输出信息可知,在客户机中看到的网卡是使用e1000e驱动的Intel 82572网卡(和宿主机隐藏它之前看到的是一样的),eth2就是该网卡的网络接口,通过ping命令查看其网络是畅通的。

(5)关闭客户机后,在宿主机中恢复前面被隐藏的网卡。

在客户机关闭或网卡从客户机中虚拟地“拔出”来之后,如果想让宿主机继续使用该网卡,则可以使用pcistub.sh脚本来恢复其在宿主机中的驱动绑定情况,操作过程如下所示。

[root@jay-linux kvm_demo]# ./pcistub.sh -u 08:00.0 -d e1000e

Unbinding 0000:08:00.0 from pci-stub

Binding 0000:08:00.0 to e1000e

[root@jay-linux kvm_demo]# 1spci -k -s 08:00.0

08:00.0 Ethernet controller: Intel Corporation 82572EI Gigabit

Ethernet Controller (Copper) (rev 06)

Subsystem: Intel Corporation PRO/1000 PT Desktop Adapter

Kernel driver in use: el000e

Kernel modules: el000e

[root@jay-linux kvm_demo]# ethtool -i eth6

driver: e1000e

version: 2.0.0-k

firmware-version:5.11-10

bus-info:0000:08:00.0

其中,在pcistub.sh脚本中,"-u$BDF"是指定需要取消隐藏(unhide)的设备,"-d$driver"是指将从pci_stub的绑定中取消隐藏的设备绑定到另外一个新的驱动(driver)中。由上面的输出信息可知,08:00.0设备使用的驱动从pci_stub变回了e1000e,而且以太网络接口eth6正是该设备。

2)硬盘直接分配

在现代计算机系统中,一般SATA或SAS等类型硬盘的控制器(Controller)都是接入到PCI(或PCIe)总线上的,所以也可以将硬盘作为普通PCI设备直接分配给客户机使用。不过当SATA或SAS设备作为PCI设备直接分配时,实际上将其控制器作为一个整体分配到客户机中,如果宿主机使用的硬盘也连接在同一个SATA或SAS控制器上,则不能将该控制器直接分配给客户机,而是需要硬件平台中至少有两个或以上的SATA或SAS控制器。宿主机系统使用其中一个,然后将另外的一个或多个SATA/SAS控制器完全分配给客户机使用。

下面以一个SATA硬盘为实例介绍对硬盘的直接分配过程。

(1)先在宿主机中查看硬盘设备,然后隐藏需要直接分配的硬盘,其命令行操作如下所示。

[root@jay-linux kvm_demo]# ll

/dev/disk/by-path/pci-00000\:16\:00.0-sas-0x12210000000000-1un-0

lrwxrwxrwx 1 root root 9 Sep 24 11:17

/dev/disk/by-path/pci-00000:16:00.0-sas-0x122100000000000-lun-0->../../sda

[root@jay-linux kvm_demo]# 11

/dev/disk/by-path/pci-0000\:00\:1f.2-scsi-0\:0\:0\:0

lrwxrwxrwx 1 root root 9 Sep 24 11:17

/dev/disk/by-path/pci-0000:00:1f.2-scsi-0:0:0 -> .././sdb

[root@jay-linux kvm_demo]# lspci -k -s 16:00.0

16:00.0 SCSI storage controller:LSI Logic / Symbios Logic SAS1078

PCI-Express Fusion-MPT SAS(rev 04)

Subsystem:Intel Corporation Device 3505

Kernel driver in use:mptsas

Kernel modules:mptsas

[rootejay-linux kvm_demo]# lspci -k -s 00:1f.2

00:1f.2 SATA controller:Intel Corporation 82801JI (ICH10 Family)

SATA AHCI Controller

Subsystem:Intel Corporation Device 34f8

Kernel driver in use:ahci

Kernel modules: ahci

[root@jay-linux kvm_demo]# fdisk -l /dev/sdb

[root@jay-linux kvm_demo]# df -h

[rootθjay-linux kvm_demo]# ./pcistub.ah -h 00:1f.2

[rootθjay-linux kvm_demo]# lspci -k -s 00:1f.2

00:1f.2 SATA controller:Intel Corporation 82801JI (ICH10 Family)

SATA AHCI Controller

Subsystem:Intel Corporation Device 34f8

Kernel driver in use: pci-stub

Kernel modules: ahci

由上面的命令行输出可知,在宿主机中有两块硬盘sda和sdb,分别对应一个SAS Controller(16:00.0)和一个SATA Controller(00:1f.2),其中sdb大小为160GB,而宿主机系统安装在sda的第一个分区(sda1)上。在用pcistub.sh脚本隐藏SATA Controller之前,它使用的驱动是ahci驱动,之后,将其绑定到pci-stub驱动,为设备直接分配做准备。

(2)用如下命令行将STAT硬盘分配(实际是分配STAT Controller)给客户机使用。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -device pci-assign,host=00:1f.2,addr=0x6 -net nic -net tap

VNC server running on '::1:5900'

(3)在客户机启动后,在客户机中查看直接分配得到的SATA硬盘,命令行如下所示。

[root@jay-linux kvm_demo]# fdisk -l /dev/sdb

[rootθjay-linux kvm_demo]# lspci -k -s 00:06.0由客户机中的以上命令行输出可知,宿主机中的sdb硬盘(BDF为00:06.0)就是设备直接分配的那个160GB大小的SATA硬盘。在SATA硬盘成功直接分配到客户机后,客户机中的程序就可以像普通硬盘一样对其进行读写操作(也包括磁盘分区等管理操作)。

3)USB直接分配

与SATA和SAS控制器类似,在很多现代计算机系统中,USB主机控制器(USB Host Controller)也是接入到PCI总线中去的,所以也可以对USB设备做设备直接分配。同样,这里的USB直接分配,也是指对整个USB Host Controller的直接分配,而并不一定仅分配一个USB设备。常见的USB设备,如U盘、键盘、鼠标等都可以作为设备直接分配到客户机中使用。这里以U盘为例来介绍USB直接分配,而USB键盘、鼠标的直接分配也与此类似。

VGA直接分配的示例时,也会将鼠标、键盘直接分配到客户机中。

(1)在宿主机中查看U盘设备,并将其隐藏起来以供直接分配,命令行操作如下所示。

[root@jay-linux kvm_demo]# fdisk -l /dev/sdb

[rootθjay-linux kvm_demo]# ls -l

[rootθjay-linux kvm_demo]# lspci -k -s 00:1d.0

[rootθjay-linux kvm_demo]# ./pcistub.ah -h 00:1d.0

[rootθjay-linux kvm_demo]# lspci -k -s 00:1d.0由宿主机中的命令行输出可知,sdb就是那个使用USB 2.0协议的U盘,它的大小为16GB,其PCI的ID为00:1d.0,在pci-stub隐藏之前使用的是ehci-hcd驱动,然后被绑定到pci-stub驱动隐藏起来以供后面直接分配给客户机使用。

(2)将U盘直接分配给客户机使用的命令行如下所示,与普通PCI设备直接分配的操作完全一样。

(3)在客户机中,查看通过直接分配得到的U盘,命令行如下。

[rootθjay-linux kvm_demo]# df -h

[root@jay-linux kvm_demo]# fdisk -l /dev/sdb

[rootθjay-linux kvm_demo]# lspci -k -s 00:05.0由客户机中的命令行输出可知,sdb就是那个16GB的U盘(BDF为00:05.0),目前使用ehci_hcd驱动。在U盘直接分配成功后,客户机就可以像普通系统使用U盘一样直接使用它了。

另外,对于USB2.0设备,也有其他的命令行参数(-usbdevice)来支持USB设备的分配。不同于前面介绍的对USB Host Controller的直接分配,-usbdevice参数用于分配单个USB设备。

在宿主机中不要对USB Host Controller进行隐藏(如果前面已经隐藏了,可以用"pcistub.sh-u 00:1d.0-d ehci_hcd"命令将其释放出来),用"lsusb"命令查看需要分配的USB设备的信息,然后在要启动客户机的命令行中使用"-usbdevice host:xx"这样的参数启动客户机即可,其操作过程如下。

[root@jay-linux kvm demo]# 1susb

Bus 001 Device 002:ID 8087:0024 Intel Corp. Integrated Rate Matching Hub

Bus 001 Device 001:ID 1d6b:0002 Linux Foundation 2.0 root hub

Bus 001 Device 003:ID 0781:5567 SanDisk Corp.Cruzer Blade

#用于分配的 SandDisk 的 u 盘设备

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -usbdevice host:0781:5667 -net nic -net tap

VNC server running on '::1:5900'

4)VGA显卡直接分配

在计算机系统中,显卡也是作为一个PCI或PCIe设备接入到系统总线之中的。在KVM虚拟化环境中,如果有在客户机中看一些高清视频和玩一些高清游戏的需求,也可以将显卡像普通PCI设备一样完全分配给某个客户机使用。目前,市面上显卡的品牌很多,有Nvidia、ATI等独立显卡品牌,也包括Intel等公司在较新的CPU中集成的GPU模块(具有3D显卡功能)。

显卡也有多种的接口类型,如VGA(Video Graphics Array)、DVI(Digital Visual Interface)、HDMI(High-Definition Multimedia Interface)等多种标准的接口。下面以一台服务器上的集成VGA显卡为例,介绍显卡设备的直接分配过程,在此过程中也将USB鼠标和键盘一起分配给客户机,以方便用服务器上直接连接的物理鼠标、键盘操作客户机。

(1)查看USB键盘和鼠标的PCI的BDF,查看VGA显卡的BDF,命令行操作如下所示。

[root@jay-linux ~]# dmesg | grep -e Keyboard -e Mouse

hid-generic 0003:0557:2217.0001:input:USB HID v1.10 Keyboard [ATEN ATEN CS-1716/08/04] on usb-0000:00:1a.0-1.5/input0

hid-generic 0003:0557:2217.0002:input:USB HID v1.10 Mouse [ATEN ATEN CS-1716/08/04] on usb-0000:00:la.0-1.5/input1

input: American Megatrends Inc.Virtual Keyboard and Mouse as /devices/pci000:00/000:00:1d.0/usb2/2-1/2-1.4/2-1.4:1.0/input/input2

hid-generic 0003:046B:FF10.0003: input:USB HID v1.10 Keyboard [American Megatrends Inc.Virtual Keyboard and Mouse] on usb-0000:00:1d.0-1.4/input0

input: American Megatrends Inc.Virtual Keyboard and Mouse as

/devices/pci000:00/000:00:1d.0/usb2/2-1/2-1.4/2-1.4:1.1/input/input3 hid-generic 0003:046B:FF10.0004:input:USB HID v1.10 Mouse [American Megatrends Inc.Virtual Keyboard and Mouse] on usb-0000:00:1d.0-1.4/input1

[root@jay-linux kvm_demo]# 1susb

Bus 003 Device 002:ID 046b;ff10 American Megatrends,Inc.Virtual Keyboard and Mouse

Bus 005 Device 002: ID 0557:2217 ATEN International Co., Ltd Bus 008 Device 002:ID 05e3:0719 Genesys Logic,Inc.SATA adapter

Bus 001 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 002 Device 001:ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 003 Device 001: ID ld6b:0001 Linux Foundation 1.1 root hub

Bus 004 Device 001: ID 1d6b:0001 Linux Foundation 1,1 root hub

Bus 005 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 006 Device 001:ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 007 Device 001:ID 1d6b:0002 Linux Foundation 2.0 root hub

Bus 008 Device 001: ID ld6b:0002 Linux Foundation 2.0 root hub

[root@jay-linux kvm_demo]# 1spci -k -s 00:1a.0

00:la.0 USB controller: Intel Corporation C600/X79 series chipset USB2 Enhanced Host Controller #2(rev 06)

Subsystem:Intel Corporation Device 35a0

Kernel driver in use:ehci_hcd

Kernel modules: ehci-hcd

[root@jay-linux-]# 1spci | grep-iVGA

09:00.0 VGA compatible controller: Matrox Electronics Systems Ltd. MGA G200e [Pilot] ServerEngines(SEP1)(rev 05)

[root@jay-linux~]# 1spci -k -s 09:00.0

09:00.0 VGA compatible controller: Matrox Electronics Systems Ltd. MGA G200e [Pilot]

ServerEngines (SEP1)(rev 05)

Subsystem:Intel Corporation Device 0103

由上面命令行的输出信息可知,USB鼠标和键盘的USB控制器的PCI设备BDF为00:1a.0(实验是用的一个USB转接器,然后在它上面接了一个键盘和一个鼠标,所以宿主机只能看到一个USB设备),宿主机VGA显卡是Matrox公司的G200e型号显卡,其BDF为09:00.0。

(2)分别将鼠标、键盘和VGA显卡隐藏起来,以便分配给客户机,命令行操作如下所示。

[root@jay-linux kvm_demo]# ./pcistub.sh -h 00:1a.0

Unbinding 0000:00:la.0 from ehci hcd

Binding 0000:00:la.0 to pci-stub

[root@jay-linux kvm_demo]# 1spci -k -s 00:la.0

00:la.0 USB controller: Intel Corporation C600/X79 series chipset

USB2 Enhanced Host Controller #2(rev 06)

Subsystem: Intel Corporation Device 35a0

Kernel driver in use:pci-stub

Kernel modules: ehci-hcd

[root@jay-linux kvm_demo]# ./pcistub.sh -h 09:00.0

0000:09:00.0 wasn't bound to any drirver

Binding 0000:09:00.0 to pci-stub

[root@jay-linux kvm_demo]# 1spci -k -s 09:00.0

09:00.0 VGA compatible controller: Matrox Electronics Systems Ltd. MGA G200e [Pilot] ServerEngines (SEP1)(rev 05)

Subsystem:Intel Corporation Device 0103

Kernel driver in use:pci-stub

(3)qemu-kvm命令行启动一个客户机,将USB鼠标键盘和VGA显卡都分配给它,其命令行操作如下所示。

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhe16u3.img -m 1024 -device pci-assign,host=09:00.0 -device pci-assign,host=00:la.0 -net nic -net tap

VNC server running on'::1:5900'

(4)在客户机中查看分配的VGA显卡和USB键盘鼠标,命令行操作如下所示。

[root@kvm-guest~]# lspci | grep USB

00:05.0 USB controller:Intel Corporation 82801JI (ICH10 Family)

USB UHCI Controller#2

[root@kvm-guest ~]# 1susb

Bus 001 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 001 Device 002: ID 0557:2217 ATEN International Co., Ltd

[root@kvm-guest ~]# 1spci | grep VGA

00:02.0 VGA compatible controller:Cirrus Logic GD 5446

00:04.0 VGA compatible controller: Matrox Electronics Systems Ltd. MGA G200e [Pilot] ServerEngines (SEP1)(rev 05)

[root@kvm-guest ~]# dmesg | grep -i VGA

Console: colour VGA+ 80x25

vgaarb: device added:

PCI:0000:00:02.0,decodes=io+mem,owns=io+mem,locks=none

vgaarb: device added:

PCI:0000:00:04.0,decodes=io+mem,owns=io+mem,locks=none

vgaarb: loaded

vgaarb: bridge control possible 0000:00:04.0

vgaarb: no bridge control possible 0000:00:02.0

由上面输出可以看出,客户机中这个USB设备与宿主机中的是一样的,客户机有两个VGA显卡,其中BDF 00:02.0是提到的QEMU纯软件模拟的Cirrus显卡,而另外的BDF 00:04.0就是设备直接分配得到的GMA G200e显卡,它的信息和在宿主机中查看到的是一样的。从dmesg信息可以看到系统启动后,00:04.0显卡才是最后真正使用的显卡,而00:02.0是不可用的(处于"no bridge control possible"状态)。

另外,在客户机中也启动了图形界面,对使用的显卡进行检查还可以在客户机中查看Xorg的日志文件:/var/log/Xorg.0.log,其中部分内容如下:

[ 29.220]

X.Org X Server 1.10.6

Release Date:2012-02-10

[ 29.221] X Protocol Version 11,Revision 0 L

[ 29.221] Build Operating System:x86-007 2.6.18-308.1.1.e15 一

[ 29.221 Current Operating System:Linux kvm-guest V

2.6.32-279.e16,x86_64 #1 SMP Wed Jun 13 18:24:36 EDT 2012 ×86_64

<!-- 省略数十行输出信息 -->

(--) PCI:(0:0:2:0)1013:00b8:1af4:1100 Cirrus Logic GD 5446 rev 0, Mem @ Oxfa00000/33554432, 0xfe834000/4096, BIOS @ 0x???????76536

(--) PCI:*(0:0:4:0)102b:0522:8086:0101 Matrox Graphics,Inc. MGA G200e [Pilot] ServerEngines(SEP1) rev 2,Mem @ 0xfc000000/

16777216,0xfe830000/16384,0xfe0000000/8388608,BIOS@0x???????/65536

(==) Using default built-in configuration(30 lines)

<!-- 省略数十行输出信息 -->

(II) MGA: driver for Matrox chipsets: mga2064w, mga1064sg, mga2164w,

mga2164w AGP, mgag100, mgag100 PCI, mgag200, mgag200 PCI,

mgag200 SE A PCI,mgag200 SE B PCI,mgag200 EV Maxim,

mgag200 ER SH7757, mgag200 eW Nuvoton, mgag200eH, mgag400, mgag50

(II) VESA: driver for VESA chipsets: vesa

(II) FBDEV:driver for framebuffer:fbdev

(II) Primary Device is:PCI 00@00:04:0

<!-- 省略后面的其他输出信息-->

由上面Xorg.0.log中的日志信息可知,X窗口程序检测到两个VGA显卡,最后使用的是BDF为00:04.0的显卡,使用了VESA程序来驱动该显卡。

在客户机内核的配置中,对VESA的配置已经变异到内核中去了,因此可以直接使用。

[root@rhel6u3-ga ~]# grep VESA

/boot/config-2.6.32-279.el6.x86_64

CONFIG_FB_BOOT_VESA_SUPPORT=y

# CONFIG_FB_UVESA is not set

CONFIG_FB_VESA=y

在本示例中,在RHEL 6.3客户机启动的前期默认使用的是QEMU模拟的Cirrus显卡,而在系统启动完成后打开用户登录界面(启动了X-window图形界面),客户机就自动切换到使用直接分配的设备GMA G200e显卡了,在连接物理显卡的显示器上就出现了客户机的界面。

对于不同品牌的显卡及不同类型的客户机系统,KVM对它们的支持有所不同,其中也存在部分bug,在使用显卡设备直接分配时,可能有的显卡在某些客户机中并不能正常工作,这就需要根据实际情况来操作。

另外,在Windows客户机中,如果在“设备管理器”中看到了分配给它的显卡,但是并没有使用和生效,可能需要下载合适的显卡驱动,并且在“设备管理器”中关闭纯软件模拟的那个显卡,而且需要开启设置直接分配得到的显卡,这样才能让接VGA显卡的显示器能显示Windows客户机中的内容。

3、SR-IOV技术

1. SR-IOV概述

前面介绍的普通VT-d技术实现了设备直接分配,尽管其性能非常好,但是它的一个物理设备只能分配给一个客户机使用。为了实现多个虚拟机能够共享同一个物理设备的资源,并且达到设备直接分配的性能,PCI-SIG[8]组织发布了SR-IOV(Single Root I/O Virtualization and Sharing)规范,该规范定义了一个标准化的机制用以原生地支持实现多个共享的设备(不一定是网卡设备)。不过,目前SR-IOV(单根I/O虚拟化)最广泛的应用还是在以太网卡设备的虚拟化方面。QEMU/KVM在2009年实现了对SR-IOV技术的支持,其他一些虚拟化方案(如Xen、VMware、Hyper-V等)也都支持SR-IOV了。

在详细介绍SR-IOV之前,先介绍一下SR-IOV中引入的两个新的功能(function)类型。

- Physical Function(PF,物理功能):拥有包含SR-IOV扩展能力在内的所有完整的PCI-e功能,其中SR-IOV能力使PF可以配置和管理SR-IOV功能。简言之,PF就是一个普通的PCI-e设备(带有SR-IOV功能),可以放在宿主机中配置和管理其他VF,它本身也可以作为一个完整独立的功能使用。

- Virtual Function(VF,虚拟功能):由PF衍生而来的“轻量级”的PCI-e功能,包含数据传送所必需的资源,但是仅谨慎地拥有最小化的配置资源。简言之,VF通过PF的配置之后,可以分配到客户机中作为独立功能使用。

SR-IOV为客户机中使用的VF提供了独立的内存空间、中断、DMA流,从而不需要Hypervisor介入数据的传送过程。SR-IOV架构设计的目的是允许一个设备支持多个VF,同时也尽量减小每个VF的硬件成本。Intel有不少高级网卡可以提供SR-IOV的支持。

下图展示了Intel以太网卡中的SR-IOV的总体架构:

一个具有SR-IOV功能的设备能够被配置为在PCI配置空间(configuration space)中呈现出多个Function(包括一个PF和多个VF),每个VF都有自己独立的配置空间和完整的BAR(Base Address Register,基址寄存器)。Hypervisor通过将VF实际的配置空间映射到客户机看到的配置空间的方式实现将一个或多个VF分配给一个客户机。

通过Intel VT-x和VT-d等硬件辅助虚拟化技术提供的内存转换技术,允许直接的DMA传输去往或来自一个客户机,从而绕过了Hypervisor中的软件交换机(software switch)。每个VF在同一个时刻只能被分配到一个客户机中,因为VF需要真正的硬件资源(不同于emulated类型的设备)。在客户机中的VF,表现给客户机操作系统的就是一个完整的普通的设备。

在KVM中,可以将一个或多个VF分配给一个客户机,客户机通过自身的VF驱动程序直接操作设备的VF而不需要Hypervisor(即KVM)的参与,其总体架构示意图如图所示。

为了让SR-IOV工作起来,需要硬件平台支持Intel VT-x和VT-d(或AMD的SVM和IOMMU)硬件辅助虚拟化特性,还需要有支持SR-IOV规范的设备,当然也需要QEMU/KVM的支持。支持SR-IOV的设备较多,其中Intel有很多中高端网卡支持SR-IOV特性,如Intel 82576网卡(代号"Kawella",使用igb驱动)、I350网卡(igb驱动)、82599网卡(代号"Niantic",使用ixgbe驱动)、X540(使用ixgbe驱动)等。

在宿主机Linux环境中,可以通过"lspci-v-s$BDF"的命令来查看网卡PCI信息的"Capabilities"项目,以确定设备是否具备SR-IOV的能力,如下命令行:

lspci -v -s 10:00.0

Capabilities:[160] Single Root I/O Virtualization (SR-IOV)

一个设备可支持多个VF,PCI-SIG的SR-IOV规范指出每个PF最多能拥有256个VF,而实际支持的VF数量是由设备的硬件设计及其驱动程序共同决定的。前面举例的几个网卡,其中使用"igb"驱动的82576、I350等千兆(1G)以太网卡的每个PF支持最多7个VF,而使用"ixgbe"驱动的82599、X540等万兆(10G)以太网卡的每个PF支持最多63个VF。

在宿主机系统中可以用"modinfo"命令来查看某个驱动的信息,其中包括驱动模块的可用参数,如下命令行演示了常用igb和ixgbe驱动的信息。

[root@jay-linux kvm_demo]# modinfo igb

filename: /lib/modules/3.5.0/kernel/drivers/net/ethernet/intel/igb/igb.ko

version: 3.4.7-k

license: GPL

description: Intel(R) Gigabit Ethernet Network Driver

author: Intel Corporation,<[email protected]>

srcversion: B905A7E217BFBA4F95FAEA8

alias: pci:v00008086d000010D6sv*sd*bc*sc*i*

<!-- 这里省略了数十行输出信息 -->

alias: pci:v00008086d00001539sv*sd*bc*sc*i*

depends:

intree: Y

vermagic: 3.5.0 SMP mod_unload modversions

parm: max_vfs:Maximum number of virtual functions to allocate per physical function(uint)

parm: debug:Debug level(0=none,...,16=all)(int)

[root@jay-linux kvm_demo]# modinfo ixgbe

filename: /lib/modules/3.5.0/kernel/drivers/net/ethernet/intel/ixgbe/ixgbe.ko

parm: allocate per physical function - default is zero and maximum value is 63(uint)

parm: allow_unsupported_sfp:Allow unsupported and untested SFP+ modules on 82599-based adapters(uint)

parm: debug:Debug level(O=none,...,16=all)(int)在宿主机中,在加载支持SR-IOV的PCI设备的驱动时,一般还需要加上相应的参数来指定启用多少个VF,比如利用上面"modinfo"命令查看的igb和ixgbe驱动,其关于启用的VF个数的参数为"max_vfs"。如果当前系统还没有启用VF,则需要卸载掉驱动后重新加载驱动(加上VF个数的参数)来开启VF。

如下命令行演示了开启igb驱动中VF个数的参数的过程及在开启VF之前和之后的系统中网卡的状态。

[root@jay-linux kvm_demo]# 1spci | grep Eth

0d:00.0 Ethernet controller:Intel Corporation 82576 Gigabit

Network Connection (rev 01)

0d:00.1 Ethernet controller: Intel Corporation 82576 Gigabit

Network Connection (rev 01)

#(或rmmod igb)

[root@jay-linux kvm_demo]# modprobe -r igb

[root@jay-linux kvm_demo]# modprobe igb max_vfs=7

[root@jay-linux kvm_demo]# 1spci | grep Eth

0d:00.0 Ethernet controller:Intel Corporation 82576 Gigabit

Network Connection(rev 01)

0d:00.1 Ethernet controller:Intel Corporation 82576 Gigabit

Network Connection(rev 01)

0e:10.0 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

Oe:10.1 Ethernet controller:Intel Corporation 82576 Virtual Function (rev 01)

0e:10.2 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:10.3 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:10.4 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:10.5 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:10.6 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:10.7 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:11.0 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:11.1 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

0e:11.2 Ethernet controller:Intel Corporation 82576 Virtual Function(rev 01)

由上面的演示可知,BDF 0d:00.0和0d:00.1是PF,而在通过加了"max_vfs=7"的参数重新加载igb驱动后,对应的VF被启用了,每个PF启用了7个VF。为了让宿主机在启动时就能够默认自动开启VF,可以修改modprobe命令的配置文件,对于igb和ixgbe驱动,示例如下所示。

[root@jay-linux kvm_demo]# vim /etc/modprobe.d/igb.conf

option igb max_vfs=7

option ixgbe max_vfs=63

而通过如下的命令行可以查看到PF和VF的对应关系,以便清楚哪个VF是由哪个PF衍生而来的。

[root@jay-linux kvm_demo]# 1s -1/sy=/bus/pci/devices/0000\:0d\:00.0/virtfn*

lrwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn0->../0000:0e:10.0 1rwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn1->../0000:0e:10.2 lrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn2->../0000:0e:10.4 lrwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn3->../0000:0e:10.6 lrwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn4->../0000:0e:11.0 lrwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn5->../0000:0e:11.2 1rwxrwxrwx 1 root root 0 Sep 26 17:13

/sys/bus/pci/devices/0000:0d:00.0/virtfn6->../0000:0e:11.4

[root@jay-linux kvm_demo]# 1s -1 /sys/bus/pci/devices/0000\:0e\:10.0/physfn

lrwxrwxrwx 1 root root 0 Sep 26 17:14

/sys/bus/pci/devices/0000:0e:10.0/physfn->../0000:0d:00.0

其中,0d:00.0的VF为0e:10.0~0e:11.4之间的7个Function号为偶数的Virtual Function(还记得前面提及过的BDF的function位取值范围是0~7)。

另外,值得注意的是,由于VF还是共享和使用对应PF上的部分资源,因此要使SR-IOV的VF能够在客户机中工作,必须保证其对应的PF在宿主机中处于正常工作状态。

使用SR-IOV主要有如下3个优势:

- 真正实现了设备的共享(多个客户机共享一个SR-IOV设备的物理端口);

- 接近于原生系统的高性能(比纯软件模拟和Virtio设备的性能都要好);

- 相比于VT-d,SR-IOV可以用更少的设备支持更多的客户机,可以提高数据中心的空间利用率;

而SR-IOV的不足之处有如下两点:

- 对设备有依赖,只有部分PCI-E设备支持SR-IOV(如前面提到的Intel 82576、82599网卡)。

- 使用SR-IOV时,不方便动态迁移客户机。

2. SR-IOV操作示例

在了解了SR-IOV的基本原理及优劣势之后,将以一个完整的示例来介绍在KVM中使用SR-IOV的各个步骤。这给例子是这样的,在一个SandyBridge平台上,有一个两口的Intel 10G以太网卡(X540系列,使用ixgbe驱动),使用SR-IOV技术将其中的一个VF分配给一个RHEL 6.3的客户机使用。

1)重新加载ixgbe驱动,产生一定数量的VF,命令行操作如下:

[root@jay-linux kvm_demo]# modprobe -r ixgbe、

[root@jay-linux kvm_demo]# modprobe ixgbe max_vf=3

[root@jay-linux kvm_demo]# ifconfig eth1

[root@jay-linux kvm_demo]# 1spci | grep Eth

06:00.0 Ethernet controller: Intel Corporation Ethernet

Controller 10-Gigabit X540-AT2(rev 01)

06:00.1 Ethernet controller: Intel Corporation Ethernet

Controller 10-Gigabit X540-AT2(rev 01)

06:10.0 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

06:10.1 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

06:10.2 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

06:10.3 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

06:10.4 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

06:10.5 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

[root@jay-linux kvm demo]# 1s -1 /sys/bus/pci/devices/0000\:06\:00.1/virtfn*

lrwxrwxrwx 1 root root 0 Sep 27 17:22

/sys/bus/pci/devices/0000:06:00.1/virtfn0->../0000:06:10.1 lrwxrwxrwx 1 root root 0 Sep 27 17:22

/sys/bus/pci/devices/0000:06:00.1/virtfn1->../0000:06:10.3 lrwxrwxrwx 1 root root 0 Sep 27 17:22

/sys/bus/pci/devices/0000:06:00.1/virtfn2->../0000:06:10.5

由以上输出信息可知,两个PF分别为06:00.0和06:00.1,它们对应的VF分别为06:10.0、06:10.2、06:10.4和06:10.1、06:10.3、06:10.5。06:00.1这个PF在宿主机中是正常工作的,可以看到它有对应的IP地址。

2)将其中一个VF(06:10.1)隐藏,以供客户机使用,命令行操作如下:

[root@jay-linux kvm_demo]# 1spci -k -s 06:10.1

06:10.1 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

Subsystem:Intel Corporation Device 35a0

[root@jay-linux kvm_demo]# ./pcistub.sh -h 06:10.1

0000:06:10.1 wasn't bound to any drirver

Binding 0000:06:10.1 to pci-stub

[root@jay-linux kvm_demo]# 1spci -k -s 06:10.1

06:10.1 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function (rev 01)

Subsystem:Intel Corporation Device 35a0

Kernel driver in use:pci-stub

这里隐藏的06:10.1这个VF对应的PF是06:00.1,该PF处于可用状态,才能让VF能在客户机中正常工作。其实这里的06:10.1 VF在使用pcistub.sh脚本前也没有在系统中加载ixgbevf驱动,它没有处于使用中状态(lspci-k-s$BDF命令的输出中没有"Kernel driver in use"这一行),这时不需要用pci_stub模块去隐藏它,也是可以直接将它分配给客户机使用的。而依然使用pci_stub去隐藏它,其中一个好处是标识它处于隐藏中,可能已被分配给客户机使用,另一个好处是宿主机加载ixgbevf驱动也对这个已被隐藏的VF没有影响。

3)在命令行启动客户机时分配一个VF网卡,命令行操作如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -smp 2 -m 1024 -device pci-assign,host=08:00.0 -net none

VNC server running on ':1:5900'

4)在客户机中,查看VF的工作情况,命令行操作如下:

[root@kvm-guest ~]# lspci -k -s 00:03.0

00:03.0 Ethernet controller: Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

Subsystem: Intel Corporation Device 35a0

Kernel driver in use:ixgbevf

Kernel modules:ixgbevf

[root@kvm-guest~]#1smod | grep ixgbevf

ixgbevf 37948 0

[root@kvm-guest~]# ethtool -i eth2

driver: ixgbevf

version: 2.2.0-k

firmware-version:

bus-info: 0000:00:03.0

[root@kvm-guest ~]# ifconfig eth2

[root@kvm-guest~]# ping 192.168.199.98-c 1

PING 192.168.199.98(192.168.199.98)56(84)bytes of data.

64 bytes from 192.168.199.98: icmp_seq=1 ttl=64 time=0.589 ms

--- 192.168.199.98 ping statistics ---

l packets transmitted, 1 received, 0% packet loss, time 676ms

rtt min/avg/max/mdev=1.794/1.794/1.794/0.000 ms

由上面的输出信息可知,00:03.0就是那个VF,它的PCI信息与在宿主机中看到的是一致的(X540 Ethernet Controller Virtual Function),使用的是ixgbevf驱动,而且它获得了IP地址,网络连接也是畅通的。不过,有时可能遇到客户机中VF的网络并没有连通的情况,可能需要重新加载对应的驱动程序(如igbvf、ixgbevf等)。

3. SR-IOV使用问题解析

在使用SR-IOV时,可能也会遇到各种小问题,根据经验来介绍一些可能会遇到的问题及其解决方法。

(1)VF在客户机中MAC地址全为零

如果使用Linux 3.9及之后的版本作为宿主机的内核,则可能会在使用igb或ixgbe驱动的网卡(如Intel 82576、I350、82599等)的VF进行SR-IOV时,在客户机中看到igbvf或ixgbevf网卡的MAC地址全为零(即00:00:00:00:00:00),从而导致VF不能正常工作。比如,在一个Linux客户机的dmesg命令的输出信息中,可能会看到如下的错误信息:

igbvf 0000:00:03.0:irq 26 for MSI/MSI-X

igbvf 0000:00:03.0:Invalid MAC Address:00:00:00:00:00:00

igbvf: probe of 0000:00:03.0 failed with error -5

关于这个问题,曾向Linux/KVM社区报过一个bug,其网页链接为:https://bugzilla.kernel.org/show_bug.cgi?id=55421。

这个问题的原因是,从Linux 3.9开始内核代码中的igb或ixgbe驱动程序在进行SR-IOV时,会将VF的MAC地址设置为全是零,而不是像之前那样使用一个随机生成的MAC地址。这样调整主要也是为了解决两个问题:一是随机的MAC地址对Linux内核中的设备管理器udev很不友好,多次使用VF可能会导致VF在客户机中的以太网络接口名称持续变化(如可能变为eth100);二是随机生成的MAC地址并不能完全保证其唯一性,有很小的概率可能与其他网卡的MAC地址重复而产生冲突。

对于VF的MAC地址全为零的问题,可以通过如下两种方法之一来解决。

在分配VF给客户机之前,在宿主机中用ip命令来设置需要使用的VF的MAC地址,命令行操作实例如下:

[root@jay-linux~]# ip link set eth0 vf 0 mac 0:1E:608

在上面的命令中,eth0为宿主机中PF对应的以太网接口名称,0代表设置的VF是该PF的编号为0的VF(即第一个VF)。那么,如何确定这个VF编号对应的PCI-E设备的BDF编号呢?可以使用如下的两个命令来查看PF和VF的关系。

[root@jay-linux ~]# ethtool -i eth0

driver: igb

version: 4.1.2-k

firmware-version: 1.64,0x800006fc

bus-info:0000: 0a:00.0

supports-statistics: yes

supports-test: yes

supports-eeprom-access: yes

supports-register-dump: yes

supports-priv-flags: no

[rootejay-linux-]# 1s -1 /sys/bus/pci/devices/0000:0a:00.0/virtfn*

lrwxrwx 1 root root 0 Apr 23 15:09 /sys/bus/pci/devices/0000:0a:00.0/virtfn0 -> ../0000:0b:10.0

1rwxrwxrwx 1 root root 0 Apr 23 15:09 /sys/bus/pci/devices/0000:0a:00.0/virtfn1 -> ../0000:0b:10.4

<!--此处省略其余VF的对应关系 -->可以升级客户机系统的内核或VF驱动程序,比如可以将Linux客户机升级到使用Linux 3.9之后的内核及其对应的igbvf驱动程序。最新的igbvf驱动程序可以处理VF的MAC地址为零的情况。

(2)Windows客户机中关于VF的驱动程序

对于Linux系统,宿主机中PF使用的驱动(如igb、ixgbe等)与客户机中VF使用的驱动(如igbvf、ixgbevf等)是不同的。当前流行的Linux发行版(如RHEL、Fedora、Ubuntu等)中都默认带有这些驱动模块。而对于Windows客户机系统,Intel网卡(如82576、82599等)的PF和VF驱动是同一个,只是分为32位和64位系统两个版本。有少数的最新Windows系统(如Windows 8、Windows 2012 Server等)默认带有这些网卡驱动,而多数的Windows系统(如Windows 7、Windows 2008 Server等)都没有默认带有相关的驱动,需要自行下载安装,例如前面提及的Intel网卡驱动可以到其官方网站(http://downloadcenter.intel.com/Default.aspx)下载。

(3)少数网卡的VF在少数Windows客户机中不工作

在进行SR-IOV的实验时,可能遇到VF在某些Windows客户机中不工作的情况。就遇到这样的情况,在用默认的qemu-kvm命令行(如步骤3所示)启动客户机后,Intel的82576、82599网卡的VF在32位Windows 2008Server版的客户机中不能正常工作,而在64位客户机中的工作正常。该问题的原因不在于Intel的驱动程序也不在于KVM中SR-IOV的逻辑不正确,而是在于默认的CPU模型是qemu64,它不支持MSI-X这种中断方式,而32位的Windows 2008 Server版本中的82576、82599网卡的VF只能用MSI-X中断方式来工作。

所以,需要在通过命令行启动客户机时指定QEMU模拟的CPU的类型,从而可以绕过这个问题。可以用"-cpu SandyBridge"、"-cpu Westmere"等参数来指定CPU类型,也可以用"-cpu host"参数来尽可能多地将物理CPU信息暴露给客户机,还可以用"-cpu qemu64,model=13"这样来改变qemu64类型CPU的默认模型。通过命令行启动一个32位Windows 2008 Server客户机,并分配一个VF给它使用,命令行操作如下:

[root@jay-linux kym demol# qemu-system-x86_64 32bit-win2k8.img -smp 2 -cpu SandyBridge -m 1024 -device pci-assign,host=08:00.0 -net none

在客户机中,网卡设备正常显示,网络连通状态正常。

4、热插拔

热插拔(hot plugging)即“带电插拔”,指可以在电脑运行时(不关闭电源)插上或拔除硬件。热插拔最早出现在服务器领域,是为了提高服务器扩展性、灵活性和对灾难的及时恢复能力。实现热插拔需要有几方面支持:总线电气特性、主板BIOS、操作系统和设备驱动。目前,在服务器硬件中,可实现热插拔的部件主要有SATA硬盘(IDE不支持热插拔)、CPU、内存、风扇、USB、网卡等。在KVM虚拟化环境中,在不关闭客户机的情况下,也可以对客户机的设备进行热插拔。目前,KVM对热插拔的支持还不够完善,主要支持PCI设备和CPU的热插拔,也可以通过ballooning间接实现内存的热插拔。

1. PCI 设备热插拔

前面5.2中介绍的VT-d设备直接分配和SR-IOV技术时都是在客户机启动时就分配相应的设备,将介绍可以通过热插拔来添加或删除这些PCI设备。QEMU/KVM不仅支持动态添加和动态移除设备,而且在启动客户机的qemu-kvm命令行中分配的普通VT-d设备或SR-IOV的VF设备也可以被动态移除。

PCI设备的热插拔,主要需要如下几个方面的支持。

(1)BIOS

QEMU/KVM默认使用SeaBIOS[9]作为客户机的BIOS,该BIOS文件路径一般为/usr/local/share/qemu/bios.bin,目前默认的BIOS已经可以支持PCI设备的热插拔。

(2)PCI总线

物理硬件中必须有VT-d的支持,且现在的PCI、PCIe总线都支持设备的热插拔。

(3)客户机操作系统

多数流行的Linux和Windows操作系统都支持设备的热插拔。可以在客户机的Linux系统的内核配置文件中看到一些相关的配置,如下是RHEL 6.3系统中的部分相关配置。

CONFIG_HOTPLUG=y

CONFIG_HOTPLUG_PCI_PCIE=y

CONFIG_HOTPLUG_PCI=y

CONFIG_HOTPLUG_PCI_FAKE=m

CONFIG_HOTPLUG_PCI_ACPI=y

CONFIG_HOTPLUG_PCI_ACPI_IBM=m

(4)客户机中的驱动程序

一些网卡驱动(如Intel的e1000e、igb、ixgbe、igbvf、ixgbevf等)、SATA或SAS磁盘驱动、USB2.0、USB3.0驱动都支持设备的热插拔。注意,在一些较旧的Linux系统(如RHEL 5.5)中需要加载"acpiphp"(使用"modprobe acpiphp"命令)这个模块后才支持设备的热插拔,否则热插拔完全不会对客户机系统生效;而较新内核的Linux系统(如RHEL 6.3、Fedora 17等)中已经没有该模块,不需要加载该模块,默认启动的系统就支持设备热插拔。

有了BIOS、PCI总线、客户机操作系统和驱动程序的支持后,热插拔功能只需要在QEMU monitor中的两个命令即可完成热插拔功能。

将一个BDF为02:00.0的PCI设备动态添加到客户机中(设置id为mydevice),在monitor中的命令如下:

device_add pci-assign,host=02:00.0,id=mydevice

将一个设备(id为mydevice)从客户机中动态移除,在monitor中的命令如下:

device_del mydevice

这里的mydevice是在添加设备时设置的唯一标识,可以通过"info pci"命令在QEMU monitor中查看到当前的客户机中的PCI设备及其id值。已经提及,在命令行启动客户机时分配设备也可以设置这个id值,如果这样,那么也就可以用"device_del id"命令将该PCI设备动态移除。

如果在动态添加PCI设备后,在客户机中用"lspci"命令可以查看到该设备,但是该设备实际并不可以使用,这有可能会是宿主机内核的一个bug。这需要在客户机卸载驱动后重新加载该设备的驱动才能让设备正常工作,就曾经遇到个这样的一个bug(https://bugzilla.kernel.org/show_bug.cgi?id=47451)。

2. PCI设备热插拔示例

在介绍了PCI设备热插拔所需的必要条件和操作命令之后,分别以网卡、U盘、SATA硬盘的热插拔为例来演示具体的操作过程。

1)网卡的热插拔

启动一个客户机,不向它分配任何网络设备,命令行如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -smp 2 -net none

VNC server running on '::1:5900'选择并用pci-stub隐藏一个网卡设备供热插拔使用,命令行如下:

[root@jay-linux kvm_demo]# 1spci -s 06:10.1

06:10.1 Ethernet controller: Intel Corporation X540 Ethernet Controller Virtual Function(rev 01)

[root@jay-linux kym demo]# ./pcistub.sh-h 06:10.1

Unbinding 0000:06:10.1 from ixgbevf

Binding 0000:06:10.1 to pci-stub

这里选取了Intel X540网卡的一个SR-IOV VF作为热插拔的设备。

切换到QEMU monitor中,将网卡动态添加到客户机中,命令如下所示。一般可以用"Alt+Ctrl+2"快捷键进入到monitor中,也可以在启动时添加参数"-monitor stdio"将monitor定向到当前终端的标准输入输出中直接进行操作。

(qemu) device_add pci-assign,host=06:10.1,id=mynic在QEMU monitor中查看客户机的PCI设备信息,命令如下:

(qemu) info pci

Bus 0,device 0,function 0:

Host bridge:PCI device 8086:1237

id ""

<!-- 此处省略多行其他PCI设备的信息输出 -->

Bus 0, device 3, function 0:

Ethernet controller:PCI device 8086:1515

BAR0: 32 bit memory at 0x400000000 [0x40003fff].

BAR3: 32 bit memory at 0x40004000 [0x40007fff].

id "mynic"

由以上信息可知,"Bus 0,device 3,function 0"的设备就是动态添加的网卡设备。

在客户机中检查动态添加和网卡工作情况,命令行如下:

[root@kvm-guest~]# lspci | grep Eth

00:03.0 Ethernet controller:Intel Corporation X540 Ethernet

Controller Virtual Function(rev 01)

[root@kvm-guest ~]# ethtool -i eth2

driver: ixgbevf

version: 2.2.0-k

firmware-version:

bus-info: 0000:00:03.0

[root@kvm-guest ~]# ifconfig eth2

[root@kvm-guest~]# ping 192.168.199.103 -c 1 -I eth2

由以上输出信息可知,动态添加的网卡是客户机中唯一的网卡设备,其网络接口名称为"eth2",它的网络连接是通畅的。

将刚添加的网卡动态地从客户机中移除,命令行如下:

(qemu) device_del mynic

将网卡动态移除后,在monitor中用"info pci"命令将没有刚才的PCI网卡设备信息,在客户机中"lspci"命令也不能看到客户机中有网卡设备的信息。

2)USB设备的热插拔

USB设备是现代计算机系统中比较重要的一类设备,包括USB的键盘和鼠标、U盘,还有现在网上银行经常可能用到的USB认证设备(如工商银行的“U盾”)。如前面讲到的那样,USB设备也可以像普通PCI设备那样进行VT-d设备直接分配,而在热插拔方面也是类似的。下面以U盘的热插拔为例来介绍一下操作过程。

U盘的热插拔操作步骤和前面介绍网卡热插拔的步骤基本是一致的,只是需要注意:qemu-kvm默认没有向客户机提供USB总线,需要在启动客户机的qemu-kvm命令行中添加"-usb"参数(或"-device piix3-usb-uhci"参数)来提供客户机中的USB总线。另外,对于USB设备,在QEMU monitor中除了可以用"device_add"和"device_del"命令之外,也有两个专门的命令(usb_add和usb_del)用于对USB进行热插拔操作。

查看宿主机中的USB设备情况,然后启动一个带有USB总线控制器的客户机,命令行如下:

[root@jay-linux kvm_demo]# 1susb

Bus 002 Device 002:ID 8087:0024 Intel Corp. Integrated Rate Matching Hub

Bus 002 Device 001: ID 1d6b:0002 Linux Foundation 2.0 root hub 、

Bus 002 Device 004:ID 0781:5567 SanDisk Corp.Cruzer Blade

Bus 002 Device 003: ID 046b:ff10 American Megatrends, Inc. Virtual

Keyboard and Mouse

[root@jay-linux kym demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -smp 2 -net none

VNC server running on ':1:5900'

切换到QEMU monitor窗口,动态添加SanDisk的U盘给客户机,使用"usb_add"命令行如下:

(qemu) usb_add host:002.004

或者:

(qemu) usb_add host:0781:5567

在“VT-d操作示例”中那样查找到宿主机中USB controller对应的PCI BDF,对其进行隐藏,然后使用device_add命令动态添加设备的命令如下:

(qemu) device_add pci-assign,host=00:1d.0,id=myusb

解释一下"usb_add"这个用于动态添加一个USB设备的命令,在monitor中命令格式如下:

usb_add devname

其中devname是对该USB设备的唯一标识,该命令支持两种devname的格式:一种是USB hub中的Bus和Device号码的组合,一种是USB的vendor ID和device ID的组合。

举个例子,对于该宿主机中的一个SanDisk的U盘设备(前一步的lsusb命令),devname可以设置为“002.004”和“0781:5567”两种格式。另外,需要像上面命令行操作的那样,用"host:002.004"或"host:0781:5567"来指定分配宿主机中的USB设备给客户机。

在客户机中,查看动态添加的USB设备,命令行如下:

[root@kvm-guest~]# lsusb

Bus 001 Device 001: ID 1d6b:0001 Linux Foundation 1.1 root hub

Bus 001 Device 002:ID 0781:5567 SanDisk Corp.Cruzer Blade

[root@kvm-guest~]# fdisk -1 /dev/sdb

Disk /dev/sdb:16.0 GB,16008609792 bytes 21 heads, 14 sectors/track, 106349 cylinders

Units = cylinders of 294 * 512 = 150528 bytes

Sector size(logical/physical):512bytes / 512 bytes

I/O size(minimum/optimal):512bytes / 512 bytes

Disk identifier: 0xcad4ebea

可见,USB设备已经添加成功了,在客户机中可以正常使用该U盘了。

在QEMU monitor中查看USB设备,然后动态移除USB设备命令行操作如下:

(qemu) info usb

Device 0.2,Port 1,Speed 480 Mb/s,Product Cruzer Blade

(qemu) usb_del 0.2

(qemu) info usb

由上面的输出信息可知,移除前,"info usb"命令可以看到USB设备,在用"usb_del"命令移除后,"info usb"就没有查看到任何USB设备了。注意,usb_del命令后的参数是"info usb"命令查询出来的"Device"后的地址标识,这里为“0.2”。

发现在qemu-kvm 1.1版本中有个bug,在"usb_del 0.2"命令执行后,客户机qemu-kvm进程发生core dumped的错误,然后客户机进程被杀掉,换用较新的qemu-kvm1.2版本就正常操作了。

当然,如果使用device_add命令动态添加的USB设备,则使用如下device_del命令将其移除:

(qemu) device_del myusb

3. SATA硬盘的热插拔

与5“VT-d操作示例”类似,宿主机从一台机器上的SAS硬盘启动,然后将SATA硬盘动态添加给客户机使用,接着动态移除该硬盘。

检查宿主机系统,得到需要动态热插拔的SATA硬盘(实际上用的是整个SATA控制器),并将其用pci-stub模块隐藏起来以供热插拔使用,命令行操作如下:

[root@jay-linux kvm_demo]# 1spci | grep SATA

00:1f.2 SATA controller:Intel Corporation 82801JI

SATA AHCI Controller

[root@jay-linux kvm_demo]# 1spci | grep SAS

16:00.0 SCSI storage controller:LSI Logic / Symbios Logic SAS1078

PCI-Express Fusion-MPT SAS (rev 04)

[root@jay-linux kvm_demo]# df -h

Filesystem Size Used Avail Use% Mounted on

/dev/sdal 197G 76G 112G 41% /

tmpfs 12G 76K 12G 1% /dev/shm

[root@jay-linux kvm_demo]# 11

/dev/disk/by-path/pci-00000\:16\:00.0-sas-0x12210000000000-1un-0

1rwxrwx 1 root root 9 Oct 29 15:28

/dev/disk/by-path/pci-00000:16:00.0-sas-0x122100000000000-lun-0 -> ../../sda

[root@jay-linux kvm_demo]# 11

/dev/disk/by-path/pci-0000\:00\:1f.2-scsi-0\:0\:0\:0\:0

lrwxrwxrwx 1 root root 9 Oct 29 15:28

/dev/disk/by-path/pci-0000:00:1f.2-scsi-0:0:0:0->././sdb

[root@jay-linux kvm_demo]# 1spci -k -s 00:1f.2

00:1f.2 SATA controller:Intel Corporation 82801JI (ICH10 Family)

SATA AHCI Controller

Subsystem:Intel Corporation Device 34f8

Kernel driver in use: ahci

Kernel modules: ahci

[root@jay-linux kvm_demo]#./pcistub.sh -h 00:1f.2

Unbinding 0000:00:1f.2 from ahci

Binding 0000:00:1f.2 to pci-stub

[root@jay-linux kvm_demo]# 1spci -k -s 00:1f.2

00:1f.2 SATA controller:Intel Corporation 82801JI(ICH10 Family)

SATA AHCI Controller

Subsystem:Intel Corporation Device 34f8

Kernel driver in use:pci-stub

Kernel modules:ahci启动一个客户机,命令行如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -smp 2 -net nic -net tap

VNC server running on ':1:5900'

在QEMU monitor中,动态添加该SATA硬盘,命令行如下:

(qemu) device_add pci-assign,host=00:1f.2,id=sata,addr=0x06

(qemu) info pci #查看客户机中pci设备,可以看到动态添加的SATA控制器

Bus 0,device 6,function 0:

SATA controller:PCI device 8086:3a22

IRQ 9.

BAR0: I/O at 0x1020 [0x1027].

BAR1: I/O at 0x1030 [0x1033].

BAR2:I/O at 0x1028 [0x102f].

BAR3:I/O at 0x1034 [0x1037].

BAR4:I/O at 0x1000 [0x101f].

BAR5:32 bit memory at 0x40000000 [0x400007ff].

id "sata"

在客户机中查看动态添加的SATA硬盘,命令行如下:

[root@kvm-guest ~]# fdisk -1 /dev/sdb

[root@kvm-guest~]# lspci -k -s 00:06.0

00:06.0 SATA controller:Intel Corporation 82801JI(ICH10 Family)

SATA AHCI Controller

Subsystem:Intel Corporation Device 34f8

Kernel driver in use: ahci

Kernel modules: ahci

由以上信息可知,客户已经能够获取到SATA硬盘(/dev/sdb)的信息,然后就可以正常使用动态添加的该硬盘了。

在客户机中使用完SATA硬盘后,可以动态移除SATA硬盘,在QEMU monitor中命令行如下:

(qemu) device_del sata

在动态移除SATA硬盘后,客户机中将没有SATA硬盘的设备,宿主机又可以控制SATA硬盘,将其用于其他用途(包括分配给另外的客户机使用)。

4. CPU和内存的热插拔

CPU和内存的热插拔是RAS(Reliability、Availability和Serviceability)的一个重要特性,在非虚拟化环境中,只有较少的x86服务器硬件支持CPU和内存的热插拔(曾在Intel的Westmere-EX平台上做过物理CPU和内存的热插拔)。在操作系统方面,拥有较新内核的Linux系统(如RHEL6.3)等已经支持CPU和内存的热插拔,在其内核配置文件中可以看到类似如的下选项。

CONFIG_HOTPLUG=y

CONFIG_MEMORY_HOTPLUG=y

CONFIG_HOTPLUG_CPU=y

CONFIG_ARCH_ENABLE_MEMORY_HOTPLUG=y

CONFIG_ARCH_ENABLE MEMORY HOTREMOVE=y

CONFIG_ACPI_HOTPLUG_CPU=y

CONFIG_ACPI_HOTPLUG_MEMORY=y而在QEMU/KVM虚拟化环境中,对CPU和内存的热插拔支持也不完善。CPU的热插拔功能有一段时间在QEMU/KVM中是可以工作的,下面简单介绍一下CPU热插拔的操作步骤。

在qemu-kvm命令行中启动客户机时,使用"-smp n,maxvcpus=N"的参数,如下:

[root@jay-linux kvm_demo]# qemu-system-x86_64 rhel6u3.img -m 1024 -smp 2,maxvcpus=8 -net nic -net tap

VNC server running on '::1:5900'

这就是在客户机启动时使用的两个vCPU,而最多支持客户机动态添加到8个vCPU。

在客户机中检查CPU的状态,如下:

[root@kvm-guest ~]# 1s /sys/devices/system/cpu/

cpu0 cpul cpufreq cpuidle kernel_max offline online

通过QEMU monitor中的"cpu_set n online"命令为客户机添加n个vCPU,如下:

(qemu) cpu_set 4 online

而动态移除n个vCPU的命令为"cpu_set n offline"。

检查客户机中vCPU的数量是否与预期的相符,如果看到"/sys/devices/system/cpu/"目录下CPU的数量增加(或减少)了n个,则表示操作成功了。另外,如果是动态添加CPU,客户机中新增的CPU没有自动上线工作,可以用"echo 1>/sys/devices/system/cpu/cpu2/online"命令使其进入可用状态。

也是可以动态改变客户机中可用的内存大小,可以算是间接地实现内存热插拔功能。

另外,据了解,QEMU/KVM社区也考虑将CPU和内存的热插拔做成普通PCI/PCI-e设备热插拔的形式,但没有具体的时间点实现该功能,目前也没有太多的补丁去实现这个功能。

5、动态迁移

迁移(migration)包括系统整体的迁移和某个工作负载的迁移。系统整体迁移,是将系统上的所有软件(也包括操作系统)完全复制到另一台物理硬件机器之上。而工作负载的迁移,是将系统上的某个工作负载转移到另一台物理机器上继续运行。服务器系统迁移的作用在于简化了系统维护管理,提高了系统负载均衡,增强了系统容错性并优化了系统电源管理。

虚拟化的概念和技术的出现,给迁移带来了更丰富的含义和实践。在传统应用环境中,没有虚拟化技术的支持,系统整体的迁移主要都是静态迁移。这种迁移主要依靠系统备份和恢复技术,将系统的软件完全复制到另一台机器上,可以通过先做出系统的镜像文件,然后复制到其他机器上,或者通过直接的硬盘相互复制来实现迁移的目的。在非虚拟化环境中也有动态迁移的概念,但都是对某个(或某一组)工作负载的迁移,需要特殊系统的支持才能实现,而且技术也不够成熟,如哥伦比亚大学的Zap[11]系统,它通过在操作系统上提供了一个很薄虚拟化层(这和现在主流的虚拟化技术不一样),可以实现将工作负载迁移到另一台机器上。

在虚拟化环境中的迁移,又分为静态迁移(static migration)和动态迁移(live migration),也有少部分人称之为冷迁移(cold migration)和热迁移(hot migration),或者离线迁移(offline migration)和在线迁移(online migration)。静态迁移和动态迁移最大的区别就是,静态迁移有明显一段时间客户机中的服务不可用,而动态迁移则没有明显的服务暂停时间。虚拟化环境中的静态迁移,也可以分为两种,一种是关闭客户机后,将其硬盘镜像复制到另一台宿主机上然后恢复启动起来,这种迁移不能保留客户机中运行的工作负载;另一种是两台宿主机共享存储系统,只需要在暂停(而不是完全关闭)客户机后,复制其内存镜像到另一台宿主机中恢复启动,这种迁移可以保持客户机迁移前的内存状态和系统运行的工作负载。

动态迁移,是指在保证客户机上应用服务正常运行的同时,让客户机在不同的宿主机之间进行迁移,其逻辑步骤与前面静态迁移几乎一致,有硬盘存储和内存都复制的动态迁移,也有仅复制内存镜像的动态迁移。不同的是,为了保证迁移过程中客户机服务的可用性,迁移过程仅有非常短暂的停机时间。动态迁移允许系统管理员将客户机在不同物理机上迁移,同时不会断开访问客户机中服务的客户端或应用程序的连接。一个成功的动态迁移,需要保证客户机的内存、硬盘存储、网络连接在迁移到目的主机后依然保持不变,而且迁移过程的服务暂停时间较短。

另外,对于虚拟化环境的迁移,不仅包括相同Hypervisor之间的客户机迁移(如KVM迁移到KVM、Xen迁移到Xen),还包括不同Hypervisor之间的客户机迁移。

1. 动态迁移的效率和应用场景