卷积神经网络通俗理解

。

卷积神经网络(ConvolutionalNeuralNetworks,CNN)是一类包含卷积计算且具有深度结构的前馈神经网络(FeedforwardNeuralNetworks),是深度学习(deeplearning)的代表算法之一。

卷积神经网络具有表征学习(representationlearning)能力,能够按其阶层结构对输入信息进行平移不变分类(shift-invariantclassification),因此也被称为“平移不变人工神经网络。

卷积神经网络算法是什么?

一维构筑、二维构筑、全卷积构筑AI爱发猫 www.aifamao.com。

卷积神经网络(ConvolutionalNeuralNetworks,CNN)是一类包含卷积计算且具有深度结构的前馈神经网络(FeedforwardNeuralNetworks),是深度学习(deeplearning)的代表算法之一。

卷积神经网络具有表征学习(representationlearning)能力,能够按其阶层结构对输入信息进行平移不变分类(shift-invariantclassification),因此也被称为“平移不变人工神经网络(Shift-InvariantArtificialNeuralNetworks,SIANN)”。

卷积神经网络的连接性:卷积神经网络中卷积层间的连接被称为稀疏连接(sparseconnection),即相比于前馈神经网络中的全连接,卷积层中的神经元仅与其相邻层的部分,而非全部神经元相连。

具体地,卷积神经网络第l层特征图中的任意一个像素(神经元)都仅是l-1层中卷积核所定义的感受野内的像素的线性组合。

卷积神经网络的稀疏连接具有正则化的效果,提高了网络结构的稳定性和泛化能力,避免过度拟合,同时,稀疏连接减少了权重参数的总量,有利于神经网络的快速学习,和在计算时减少内存开销。

卷积神经网络中特征图同一通道内的所有像素共享一组卷积核权重系数,该性质被称为权重共享(weightsharing)。

权重共享将卷积神经网络和其它包含局部连接结构的神经网络相区分,后者虽然使用了稀疏连接,但不同连接的权重是不同的。权重共享和稀疏连接一样,减少了卷积神经网络的参数总量,并具有正则化的效果。

在全连接网络视角下,卷积神经网络的稀疏连接和权重共享可以被视为两个无限强的先验(pirior),即一个隐含层神经元在其感受野之外的所有权重系数恒为0(但感受野可以在空间移动);且在一个通道内,所有神经元的权重系数相同。

cnn全称是什么?

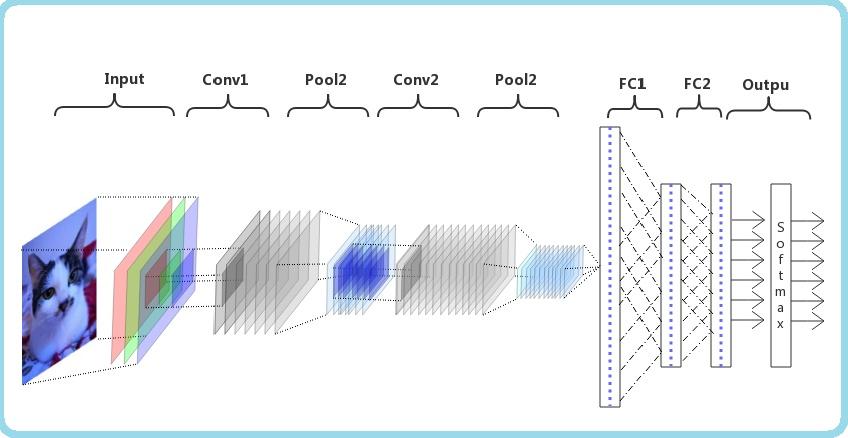

CNN的全称是ConvolutionalNeuralNetwork,是一种前馈神经网络。由一个或多个卷积层、池化层以及顶部的全连接层组成,在图像处理领域表现出色。

本文主要讲解CNN如何在自然语言处理方面的运用。

卷积神经网络主要用于提取卷积对象的局部特征,当卷积对象是自然语言文本时,比如一个句子,此时其局部特征是特定的关键词或关键短语,所以利用卷积神经网络作为特征提取器时相当于词袋模型,表示一个句子中是否出现过特定的关键词或关键短语。

用在分类任务上,相当于提取出对于分类最有用的特征信息。

cnn简介:现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。

在图像处理中,往往把图像表示为像素的向量,比如一个1000×1000的图像,可以表示为一个1000000的向量。在上一节中提到的神经网络中,如果隐含层数目与输入层一样,即也是1000000时。

以上内容参考:百度百科-卷积神经网络。

卷积神经网络工作原理直观的解释?

其实道理很简单,因为卷积运算,从频域角度看,是频谱相乘所以图像跟卷积核做卷积时,两者频谱不重叠的部分相乘,自然是0,那图像这部分频率的信息就被卷积核过滤了。

而图像,本质上就是二维离散的信号,像素点值的大小代表该位置的振幅,所以图像包含了一系列频率的特征。比如图像边缘部分,像素值差别大,属于高频信号,背景部分,像素值差别小,是低频信号。

所以如果卷积核具有『高通』性质,就能起到提取图像边缘的作用,低通则有模糊的效果。所以,卷积神经网络的牛逼之处在于通过卷积层的不同卷积核,提取图像不同频段的特征;以及通过池化层,提取不同粒度的特征。

什么是卷积神经网络?为什么它们很重要

卷积神经网络(ConvolutionalNeuralNetwork,CNN)是一种前馈神经网络,它的人工神经元可以响应一部分覆盖范围内的周围单元,对于大型图像处理有出色表现。

[1] 它包括卷积层(alternatingconvolutionallayer)和池层(poolinglayer)。卷积神经网络是近年发展起来,并引起广泛重视的一种高效识别方法。

20世纪60年代,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络(ConvolutionalNeuralNetworks-简称CNN)。

现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。

K.Fukushima在1980年提出的新识别机是卷积神经网络的第一个实现网络。随后,更多的科研工作者对该网络进行了改进。

其中,具有代表性的研究成果是Alexander和Taylor提出的“改进认知机”,该方法综合了各种改进方法的优点并避免了耗时的误差反向传播。

卷积神经网络主要做什么用的?

卷积网络的特点主要是卷积核参数共享,池化操作。

参数共享的话的话是因为像图片等结构化的数据在不同的区域可能会存在相同的特征,那么就可以把卷积核作为detector,每一层detect不同的特征,但是同层的核是在图片的不同地方找相同的特征。

然后把底层的特征组合传给后层,再在后层对特征整合(一般深度网络是说不清楚后面的网络层得到了什么特征的)。而池化主要是因为在某些任务中降采样并不会影响结果。

所以可以大大减少参数量,另外,池化后在之前同样大小的区域就可以包含更多的信息了。综上,所有有这种特征的数据都可以用卷积网络来处理。

有卷积做视频的,有卷积做文本处理的(当然这两者由于是序列信号,天然更适合用lstm处理)另外,卷积网络只是个工具,看你怎么使用它,有必要的话你可以随意组合池化和卷积的顺序,可以改变网络结构来达到自己所需目的的,不必太被既定框架束缚。

请问卷积神经网络的概念谁最早在学术界提出的?

福岛邦彦。2021年4月29日,福岛邦彦(KunihikoFukushima)获得2021年鲍尔科学成就奖。

他为深度学习做出了杰出贡献,其最有影响力的工作当属「Neocognitron」卷积神经网络架构。

其实,熟悉这位JürgenSchmidhuber人都知道,他此前一直对自己在深度学习领域的早期原创性成果未能得到业界广泛承认而耿耿于怀。

1979年,福岛博士在STRL开发了一种用于模式识别的神经网络模型:Neocognitron。很陌生对吧?

但这个Neocognitron用今天的话来说,叫卷积神经网络(CNN),是深度神经网络基本结构的最伟大发明之一,也是当前人工智能的核心技术。什么?

卷积神经网络不是一个叫YannLeCun的大佬发明的吗?怎么又换成了福岛邦彦(KunihikoFukushima)了?

严格意义上讲,LeCun是第一个使用误差反向传播训练卷积神经网络(CNN)架构的人,但他并不是第一个发明这个结构的人。

而福岛博士引入的Neocognitron,是第一个使用卷积和下采样的神经网络,也是卷积神经网络的雏形。

福岛邦彦(KunihikoFukushima)设计的具有学习能力的人工多层神经网络,可以模仿大脑的视觉网络,这种「洞察力」成为现代人工智能技术的基础。

福岛博士的工作带来了一系列实际应用,从自动驾驶汽车到面部识别,从癌症检测到洪水预测,还会有越来越多的应用。

怎样通俗易懂地解释卷积?

对卷积的意义的理解:从“积”的过程可以看到,我们得到的叠加值,是个全局的概念。

以信号分析为例,卷积的结果是不仅跟当前时刻输入信号的响应值有关,也跟过去所有时刻输入信号的响应都有关系,考虑了对过去的所有输入的效果的累积。

在图像处理的中,卷积处理的结果,其实就是把每个像素周边的,甚至是整个图像的像素都考虑进来,对当前像素进行某种加权处理。

所以说,“积”是全局概念,或者说是一种“混合”,把两个函数在时间或者空间上进行混合。那为什么要进行“卷”?直接相乘不好吗?

我的理解,进行“卷”(翻转)的目的其实是施加一种约束,它指定了在“积”的时候以什么为参照。

在信号分析的场景,它指定了在哪个特定时间点的前后进行“积”,在空间分析的场景,它指定了在哪个位置的周边进行累积处理。例1:信号分析如下图所示,输入信号是f(t),是随时间变化的。

系统响应函数是g(t),图中的响应函数是随时间指数下降的,它的物理意义是说:如果在t=0的时刻有一个输入,那么随着时间的流逝,这个输入将不断衰减。

换言之,到了t=T时刻,原来在t=0时刻的输入f(0)的值将衰减为f(0)g(T)。