5 Experiment

5.1 Settings

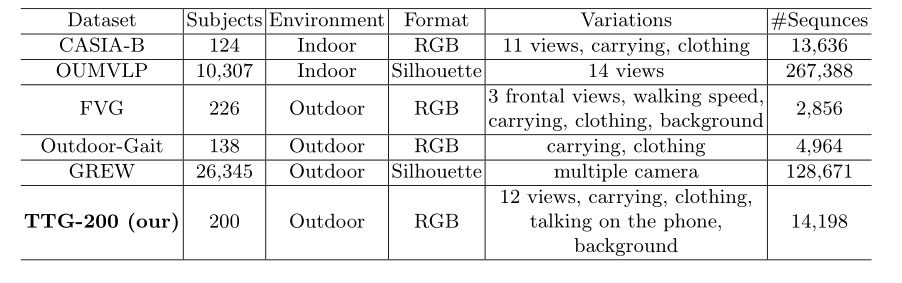

数据集。有一些可用的步态识别数据集,例如,CASIAB [26]、OUMVLP [21]、Outdoor-Gait [20]、FVG [30]、GREW [32] 等。但是,并非所有数据集都是对于基于端到端的步态识别方法很有用。例如,提出的工作不能应用两个世界上最大的步态数据集 OUMVLP [21] 和 GREW [32],因为它们都没有提供 RGB 视频。简而言之,我们理想的步态数据集拥有几个重要属性:可用的 RGB 视频、丰富的相机视角和多种步行条件。

CASIA-B [26] 似乎是一个不错的选择。尽管如此,仍然需要另一个类似的数据集来适应我们的跨域设置。因此,我们收集了一个名为万步态 200 (TTG-200) 的私有数据集,并将其统计数据显示在表 1 中。

表 1. 现有步态数据集和我们收集的 TTG-200 的统计数据

CASIA-B。 CASIA-B 中有 124 名受试者在室内行走。它可能是最流行的数据集,由 11 个视角 ( [ 0 ∘ − 18 0 ∘ ] \left[0^{\circ}-180^{\circ}\right] [0∘−180∘]) 和三种步行条件组成,即正常步行 (NM#01-06)、背包步行 (BG#01-02) 和换衣行走 (CL#01-02)。我们严格遵循之前的研究,将前 74 名受试者分组到训练集中,将其他受试者分组到测试集中。此外,对于测试阶段,前4个序列(NM#01-04)被视为gallery集,而剩下的6个序列被分为3个probe集,即NM#05-06,BG#01-02 , CL#01-02。此外,由于CASIA-B的轮廓是通过过时的背景减法获得的,因此存在很多由背景和衣服引起的噪声。因此,我们重新注释了 CASIA-B 的轮廓并将其表示为 CASIA-B*。我们所有的实验都是在这个新注释的实验上进行的。

TTG-200。该数据集包含 200 个在野外行走的受试者,每个受试者需要在 6 种不同的条件下行走,即携带、衣服、接电话等。对于每个行走过程,受试者将被位于不同视角(未标记)周围的 12 个摄像头捕获,这意味着每个受试者理想地拥有 6 × 12 = 72 个步态序列。在接下来的实验中,我们将前 120 个受试者用于训练,最后 80 个受试者进行测试。另外,第一个序列(#1)被认为是gallery集,剩下的5个序列(#2-6)被认为是probe集。

如图 5 所示,与 CASIA-B 相比,TTG-200 主要有以下三个区别:(1)TTG-200 的背景更加复杂多样(采集于多个不同的户外场景中); (2)TTG-200数据多为鸟瞰图,CASIA-B数据多为水平图; (3) TTG200 具有更好的图像质量。因此,我们可以将这两个数据集视为不同的域。

图 5. CASIA-B 和 TTG-200 示例。左侧(CASIA-B)由一个序列的六个视角组成。右边(TTG-200)由六个不同视角的受试者组成

实验细节

数据预处理。我们首先使用 ByteTrack [27] 从 CASIA-B [26] 和 TTG-200 的原始 RGB 视频中检测和跟踪行人,然后进行行人分割和轮廓对齐 [9] 以提取步态序列。获得的轮廓被调整为 64 × 44,可以作为这些两阶段步态识别方法的输入,也可以作为这些端到端方法中行人分割网络的ground-truth。

行人分割。我们使用流行的 U-Net [18] 作为我们的分割网络,由 Binary Cross-Entropy [10] loss L s e g L_{s e g} Lseg 监督。我们将输入大小设置为 128 × 128 × 3,将 U-Net 的通道设置为 {3, 16, 32, 64, 128, 64, 32, 16, 1} 并通过 SGD [19] 进行训练(批量大小= 960,动量=0.9,初始学习率=0.1,权重衰减=5×10−4)。对于每个数据集,我们以每 10000 次迭代两次缩放到 1/10 的学习率训练网络,直到收敛。

步态识别。我们使用最新的 GaitGL [16] 作为我们的识别网络,并严格遵循原始论文的设置。

联合训练细节。在这一步中,训练数据采样器和批量大小与步态识别网络相似。我们用联合损失 L joint = λ L seg + L r e c L_{\text {joint }}=\lambda L_{\text {seg }}+L_{r e c} Ljoint =λLseg +Lrec联合微调分割和识别网络,其中 L r e c L_{r e c} Lrec表示识别网络的损失。 λ \lambda λ表示分割网络的损失权重,设置为 10。此外,为了使联合训练过程收敛更快,我们使用训练好的分割和识别网络参数来初始化端到端模型,并相应地,它们的初始学习率分别设置为 1 0 − 5 10^{-5} 10−5和 1 0 − 4 10^{-4} 10−4。此外,我们固定了分割网络的前半部分,即 U-Net,以保持分割结果为人形。我们共同训练端到端网络总共 20,000 次迭代,并在第 10,000 次迭代时将学习率降低 1/10。

5.2 Performance Comparison

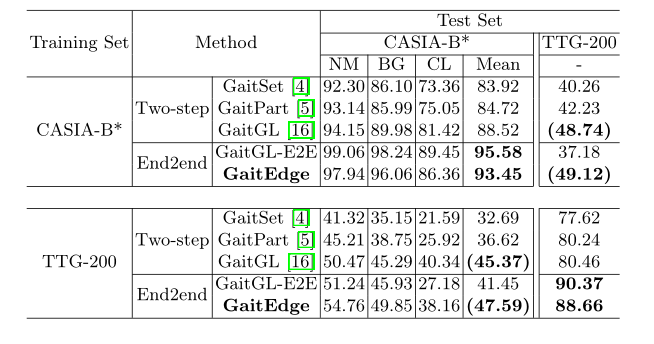

为了展示 GaitEdge 可靠的跨域能力,我们对 CASIA-B* 和 TTG-200 进行了单域和跨域评估,如表 2 所示。

表2. CASIA-B和TTG-200的rank-1准确性(%)。不包括CASIA-B中的相同视角的情况。粗体和(黑体)数字分别代表单域和跨域的两个最高准确率

单域评价。从表2的对角线结果中,我们观察到,传统的两步步态识别方法的性能远远不如两个端到端的方法。例如,GaitGL-E2E在CASIA-B和TTG-200上分别超过GaitSet[4]11.66%和12.75%。另一方面,我们提出的GaitEdge的准确度略低于GaitGL-E2E,即对CASIA-B来说是-2.13%,对TTG-200来说是-1.71%。然而,我们认为GaitGL-E2E在步态不相关的噪声中拥有较高的过拟合风险,因为它直接将分割网络产生的浮动掩码作为识别网络的输入。因此,我们进一步进行了跨域评估,以支持这一概念的实验。

跨域评估。如果一些不相关的噪音主导了用于人体识别的步态表征,即纹理和颜色,那么在跨域设置的情况下,识别精度会急剧下降,因为提取的特征无力地代表了相对稳健的步态模式。表2中的反对角线结果显示,由于CASIA-B和TTG-200之间的明显差异,所有这些方法与单域相比都有明显的性能下降。我们注意到,尽管GaitGL-E2E在单域中具有最高的准确性,但它在从CASIA-B到TTG-200的跨域中取得了最差的性能。相比之下,我们的GaitEdge在跨域评估中达到了比其他公布的方法最好的性能,尽管它比GaitGL-E2E在单域中低2%左右。

因此,这一跨域评估不仅表明GaitEdge的鲁棒性远远优于GaitGL-E2E,而且还表明GaitEdge是一个用于端到端步态识别任务的实用而先进的框架。

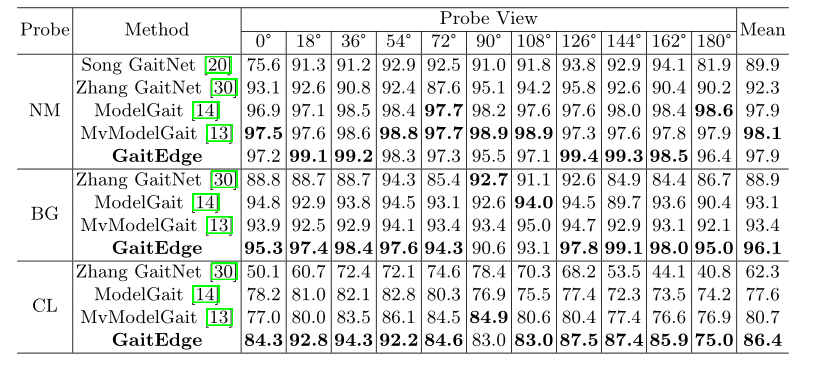

与其他端到端方法的比较。最后但并非最不重要的是,提出的GaitEdge与以前的三种端到端步态识别方法在CASIA-B*的不同视图上进行了比较。表3显示,GaitEdge在各种行走条件下几乎达到了最高的准确率,尤其是CL(比MvModelGait+5.7%),这表明GaitEdge对颜色和纹理(大衣的变化)具有明显的鲁棒性。

表 3. CASIA-B* 在不同视图上的 rank-1 准确度 (%),不包括相同视角的情况。评估时,将前 4 个序列(NM#01-04)视为gallery集,而将左侧 6 个序列分为 3 个probe集,即 NM#05-06、BG#01-02、CL#01 -02。 Song GaitNet [20] 的原始论文没有提到 BG 和 CL 的结果

5.3 Ablation Study

边缘的影响。表 4 显示了身体边缘尺寸的影响。我们通过几种尺寸的结构元素提取边缘——结构元素越大,边缘区域越大。根据表4的结果,随着结构元素尺寸的增加,单域的性能相应提高,但跨域的性能几乎同时下降。该结果表明,占据中间合成轮廓的浮动蒙版区域与 GaitEdge 的跨域性能呈负相关。因此,我们可以说 GaitGLE2E 在跨域评估中失败的原因是它在无限制结构元素的情况下等效于 GaitEdge。此外,轮廓的那些非边缘区域,即人体和背景,不适用于端到端步态识别框架的浮点编码。

表 4 结构元素尺寸的消融研究。较大的边缘区域的尺寸越大。粗体和(粗体)数字分别表示单域和跨域的最高精度

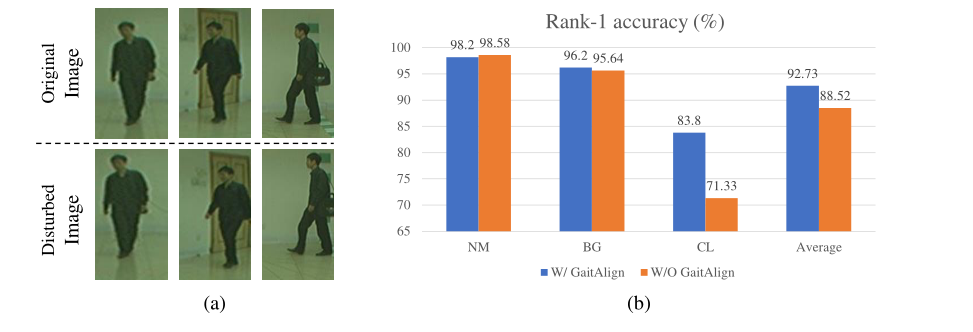

GaitAlign 的影响。值得注意的是,我们观察到自然场景中行人检测(上游任务)的结果通常比受控环境(即 CASIA-B* 和 TTG-200)差得多。为了模拟这种复杂情况,我们首先对 CASIA-B* 的视频应用目标检测,然后以 0.5 的概率执行随机像素偏移以及垂直和水平坐标。如图6(a)所示,底部图像受到干扰,旨在模拟自然情况。图 6 (b) 显示对齐显著提高了平均精度。此外,我们还注意到正常行走 (NM) 的准确率略有下降,即 -0.38%。但是,我们认为这是因为 NM 的准确度正在接近上限。

图 6. (a) 原始图像(上)与受干扰的图像(下)。我们对被干扰的图像进行随机像素偏移,包括垂直和水平方向。(b) GaitAlign 模块的消融研究。干扰后的结果在 CASIAB* 上报告

5.4 Visualization

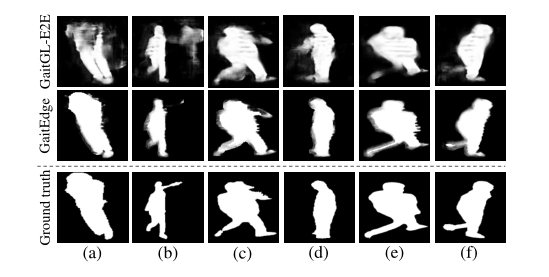

为了更好地理解 GaitGL-E2E 的性能下降和 GaitEdge 的有效性,我们分别说明了 GaitGLE2E 和 GaitEdge 生成的中间结果以及同一帧对应的 ground truth,如图 7 所示。具体来说,对于 GaitGL- E2E,(a)、(b)、(c)和(d)中的中间结果捕获了更多的背景和纹理信息,并且一些身体部位被消除了,例如(e)和(f)中的腿。而对于 GaitEdge,中间结果更加稳定和合理,使其更加稳健。

图 7. 中间结果与 ground truth 的比较,即前两行 vs.第三行

6 Conclusion

本文提出了一种新颖的端到端步态识别框架,称为 GaitEdge,可以解决跨域情况下的性能下降问题。具体来说,我们设计了一个步态合成模块,用通过形态学操作获得的可调边缘来掩盖固定体。此外,提出了一种名为 GaitAlign 的可微对齐模块来解决上游行人检测任务引起的身体位置抖动。我们还对两个数据集进行了广泛而全面的实验,包括 CASIA-B* 和我们新建的 TTG-200。实验结果表明,GaitEdge 明显优于之前的方法,表明 GaitEdge 是一种更实用的端到端范式,可以有效阻挡 RGB 噪声。此外,这项工作暴露了以往研究忽视的跨领域问题,为未来的研究提供了新的视角。