超现实的虚拟世界被誉为自动驾驶汽车 ( autonomous vehicles ,AV) 的最佳驾驶学校,因为它们已被证明是安全地尝试危险驾驶场景的卓有成效的测试平台。特斯拉、Waymo 和其他自动驾驶公司都严重依赖数据来启用昂贵且专有的逼真模拟器,因为测试和收集细微的几乎崩溃的数据通常不是最容易或最理想的重建方式。

为此,麻省理工学院计算机科学与人工智能实验室 (CSAIL) 的科学家创建了“ VISTA 2.0 ”,这是一种数据驱动的模拟引擎,车辆可以在其中学习在现实世界中驾驶并从接近碰撞的场景中恢复。更重要的是,所有代码都向公众开放源代码。

“如今,只有公司拥有类似于 VISTA 2.0 的模拟环境和功能的软件,而且该软件是专有的。有了这个版本,研究界将能够使用一个强大的新工具来加速自动驾驶自适应鲁棒控制的研发,”麻省理工学院教授和 CSAIL 主任 Daniela Rus 说,他是一篇关于该研究的论文的资深作者。

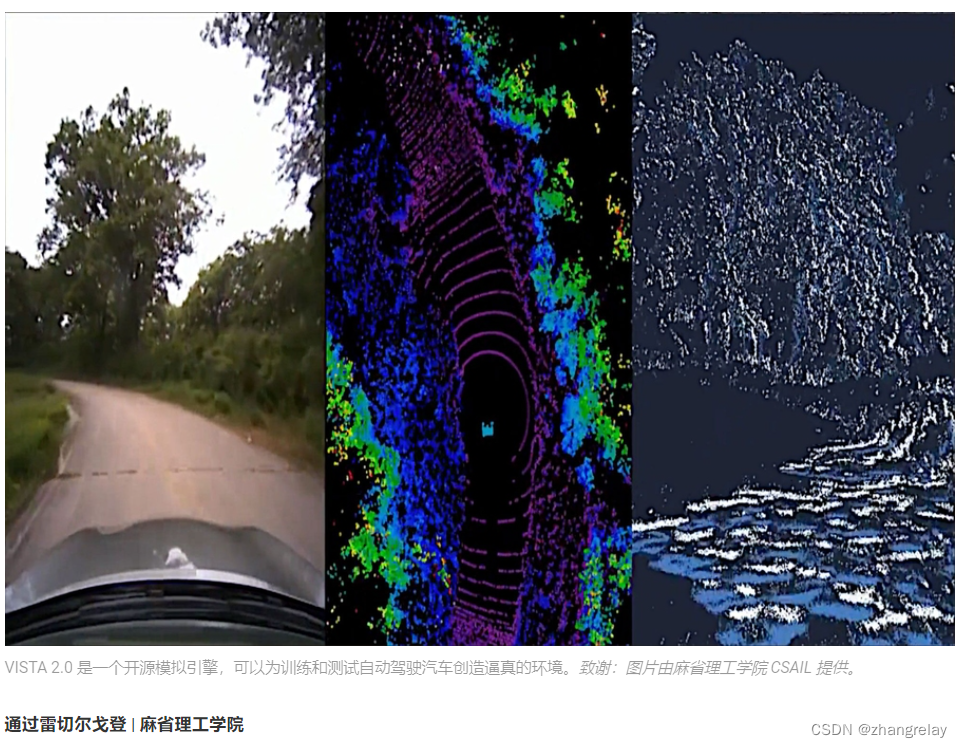

VISTA 是一款数据驱动的、逼真的自动驾驶模拟器。它不仅可以模拟实时视频,还可以模拟 LiDAR 数据和事件摄像头,还可以结合其他模拟车辆来模拟复杂的驾驶情况。VISTA 是开源的,代码可以在这里找到。

VISTA 2.0 建立在团队之前的模型 VISTA 的基础上,它与现有的 AV 模拟器有着根本的不同,因为它是数据驱动的——这意味着它是根据真实世界的数据构建和逼真渲染的——从而可以直接转移到现实中。虽然最初的迭代仅支持使用一个摄像头传感器进行单车道跟踪,但实现高保真数据驱动模拟需要重新思考如何合成不同传感器和行为交互的基础。

进入 VISTA 2.0:一个数据驱动的系统,可以模拟复杂的传感器类型和大规模交互场景和交叉路口。使用比以前的模型少得多的数据,该团队能够训练自动驾驶汽车,这可能比那些在大量真实世界数据上训练的自动驾驶汽车更加强大。

“这是自动驾驶汽车数据驱动模拟能力的巨大飞跃,以及处理更大驾驶复杂性的规模和能力的增加,”CSAIL 博士生、两篇新论文的共同主要作者 Alexander Amini 说,与博士生Tsun-Hsuan Wang一起。“VISTA 2.0 展示了模拟传感器数据的能力,远远超出了 2D RGB 摄像头,还展示了具有数百万点的超高维 3D 激光雷达、不规则定时的基于事件的摄像头,甚至还可以与其他车辆进行交互和动态场景。”

该团队能够扩展交互式驾驶任务的复杂性,例如超车、跟随和谈判,包括高度逼真的环境中的多智能体场景。

为自动驾驶汽车训练 AI 模型涉及难以保护的各种边缘情况和奇怪、危险的场景,因为我们的大部分数据(谢天谢地)只是普通的日常驾驶。从逻辑上讲,我们不能仅仅为了教神经网络如何不撞到其他汽车而撞上其他汽车。

最近,人们已经从更经典的、人工设计的模拟环境转向基于真实世界数据的模拟环境。后者具有巨大的真实感,但前者可以轻松模拟虚拟相机和激光雷达。随着这种范式转变,一个关键问题出现了:能否准确合成自动驾驶汽车所需的所有传感器的丰富性和复杂性,例如更稀疏的激光雷达和基于事件的摄像头?

在数据驱动的世界中,激光雷达传感器数据更难解释——您实际上是在尝试仅从稀疏的世界视图中生成具有数百万点的全新 3D 点云。为了合成 3D 激光雷达点云,该团队使用汽车收集的数据,将其投影到来自激光雷达数据的 3D 空间中,然后让一辆新的虚拟车辆在原车所在的地方行驶。最后,他们在神经网络的帮助下,将所有感官信息投射回这个新虚拟车辆的视野中。

再加上基于事件的摄像机(其运行速度超过每秒数千个事件)的模拟,该模拟器不仅能够模拟这种多模态信息,而且还能够实时完成所有这些——使得训练神经网络成为可能离线,还可以在增强现实设置中在汽车上进行在线测试,以进行安全评估。“在数据驱动的模拟领域,这种复杂程度和逼真度的多传感器模拟是否可能是一个悬而未决的问题,”Amini 说。

这样,驾校就变成了聚会。在模拟中,您可以四处走动,拥有不同类型的控制器,模拟不同类型的事件,创建交互式场景,并且只需放入原始数据中没有的全新车辆。他们测试了车道跟随、车道转弯、汽车跟随以及更多冒险场景,如静态和动态超车(看到障碍物并四处移动,以免发生碰撞)。借助多代理,真实代理和模拟代理都可以交互,并且可以将新代理放入场景并以任何方式进行控制。

将他们的全尺寸汽车带到“野外”——又名马萨诸塞州德文斯——团队看到了结果的直接可转移性,有失败也有成功。他们还能够展示自动驾驶汽车模型的大胆而神奇的词:“稳健”。他们表明,完全在 VISTA 2.0 中训练的 AV 在现实世界中非常强大,以至于它们可以处理那些难以捉摸的具有挑战性的失败的尾巴。

现在,人类依赖的一个尚无法模拟的护栏是人类情感。这是确认的友好挥手、点头或眨眼开关,这是团队希望在未来工作中实现的细微差别类型。

“这项研究的核心算法是我们如何获取数据集并为学习和自主构建一个完全合成的世界,”Amini 说。“这是一个平台,我相信有一天它可以在机器人技术的许多不同轴上扩展。不仅仅是自动驾驶,还有许多依赖视觉和复杂行为的领域。我们很高兴发布 VISTA 2.0,以帮助社区收集他们自己的数据集并将其转换为虚拟世界,在那里他们可以直接模拟自己的虚拟自动驾驶汽车,在这些虚拟地形周围行驶,在这些世界中训练自动驾驶汽车,然后可以直接将它们转移到全尺寸、真正的自动驾驶汽车上。”

Amini 和 Wang 与 MIT CSAIL 博士生刘志健一起撰写了这篇论文;Igor Gilitschenski,多伦多大学计算机科学助理教授;Wilko Schwarting,人工智能研究科学家和麻省理工学院 CSAIL 博士 '20;麻省理工学院电气工程与计算机科学系副教授宋涵;Sertac Karaman,麻省理工学院航空航天学副教授;麻省理工学院教授兼 CSAIL 主任 Daniela Rus。研究人员在费城举行的 IEEE 国际机器人与自动化会议 (ICRA) 上介绍了这项工作。

这项工作得到了美国国家科学基金会和丰田研究所的支持。该团队通过捐赠 Drive AGX Pegasus 来感谢 NVIDIA 的支持。

论文 – VISTA 2.0:用于自动驾驶汽车多模式传感和策略学习的开放式数据驱动模拟器Alexander Amini、Tsun-Hsuan Wang、Igor Gilitschenski、Wilko Schwarting、Zhijian Liu、Song Han、Sertac Karaman 和 Daniela Rus。