点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

点击进入—> CV 微信技术交流群

转载自:大淘宝技术

阿里巴巴大淘宝技术的研究人员和中科院计算所提出了一种允许用户自由编辑神经辐射场几何内容的方法,以论文《NeRF-Editing: Geometry Editing of Neural Radiance Fields》发表于领域内顶级会议IEEE CVPR 2022。

基于图像的3D场景建模与渲染是计算机视觉和计算机图形学中一个被广泛研究的课题。传统的方法依赖基于网格的场景表征,通过可微分光栅化程序或路径追踪的方法根据真实图像以优化网格表征。然而,基于二维图像监督的网格优化往往易于陷入局部最优,并且在优化过程中无法改变网格的拓扑结构。

神经辐射场 (NeRF) [1]是目前解决这一问题的一个有力工具,它使用全连接网络(MLP)隐式建模场景的几何和外观,并结合体渲染 (volume rendering)的方法得到高真实感的渲染图。然而,作为一种隐式建模方法,神经辐射场网络很难让用户交互式地编辑或修改场景对象。因此,基于神经辐射场等隐式表示的新视角合成能力,进一步研究如何编辑隐式表征已成为一个新的探索方向。对NeRF进行几何编辑是一种有效的几何建模方法。

针对这些问题,来自中科院计算所和阿里巴巴淘系技术部的研究人员提出了一种允许用户自由编辑神经辐射场几何内容的方法,将以论文《NeRF-Editing: Geometry Editing of Neural Radiance Fields》发表于领域内顶级会议IEEE CVPR 2022。

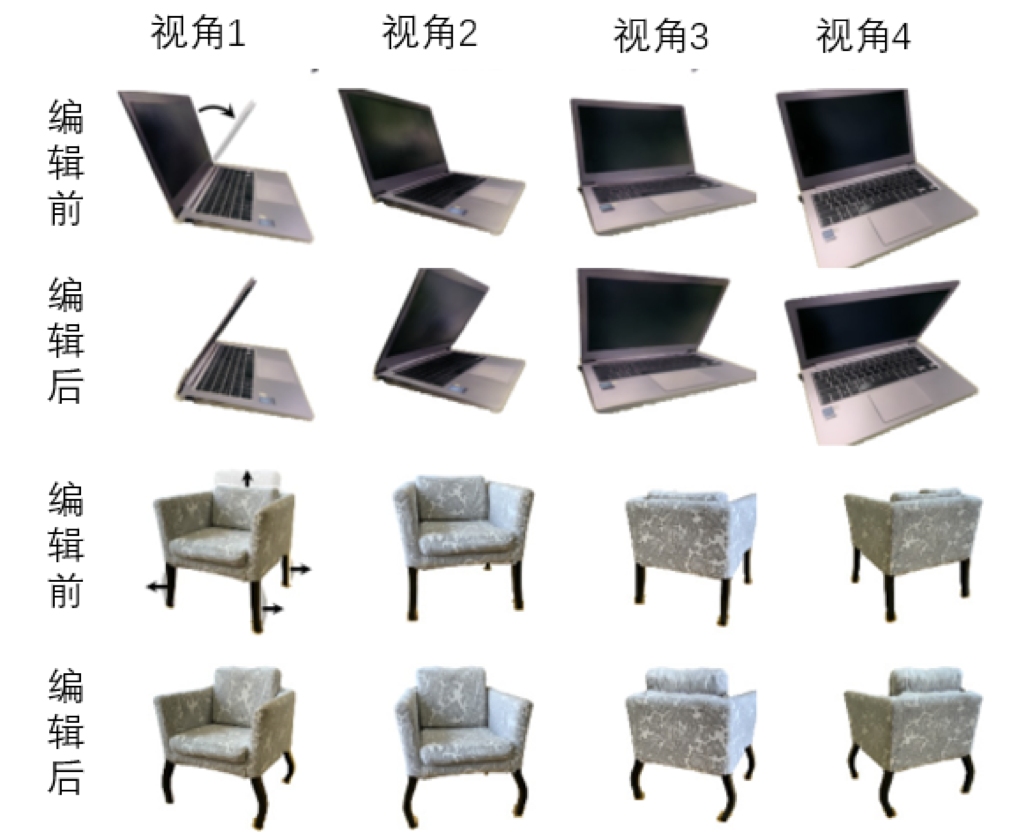

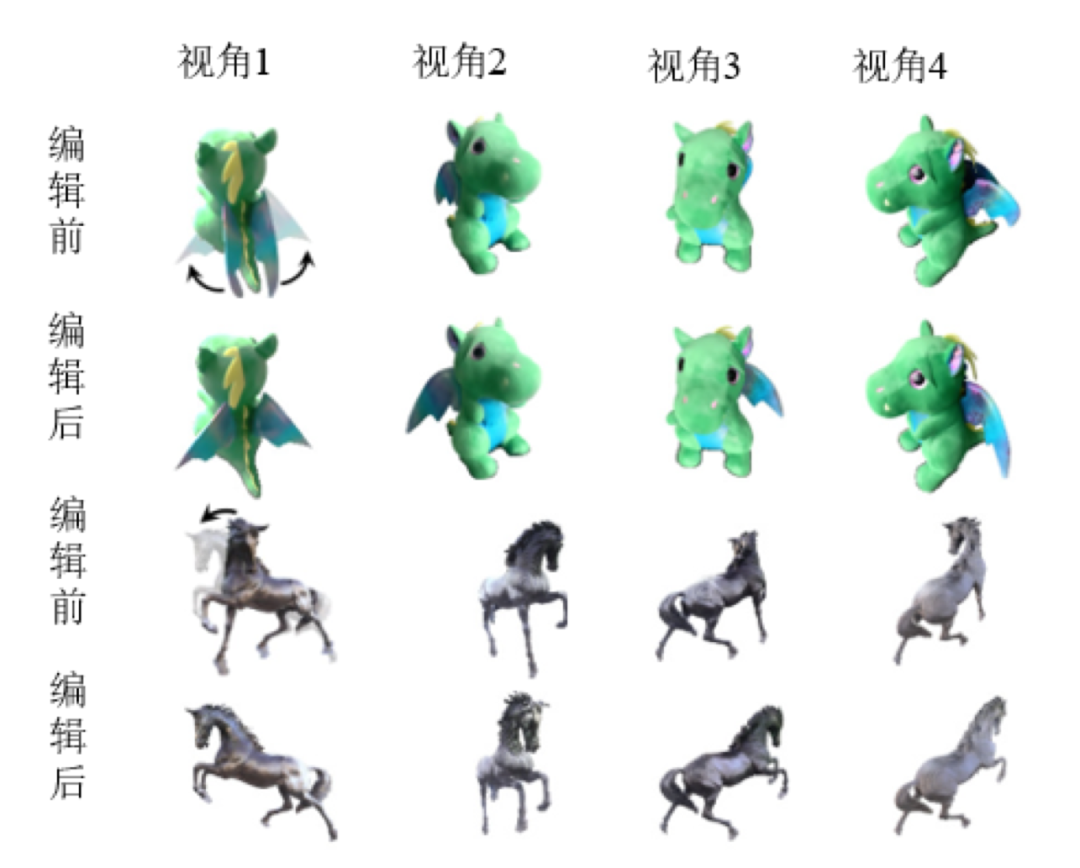

图1: 神经辐射场几何编辑结果示意图

技术路线

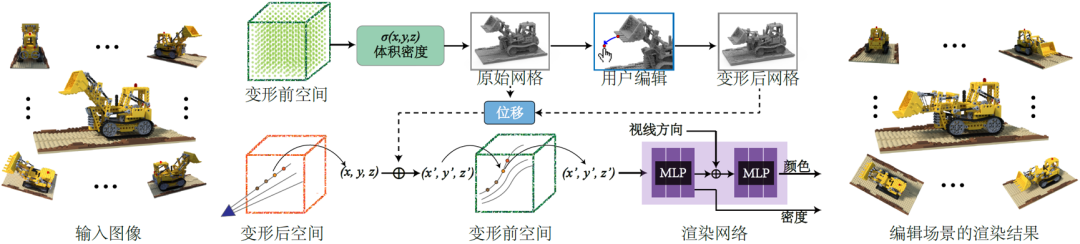

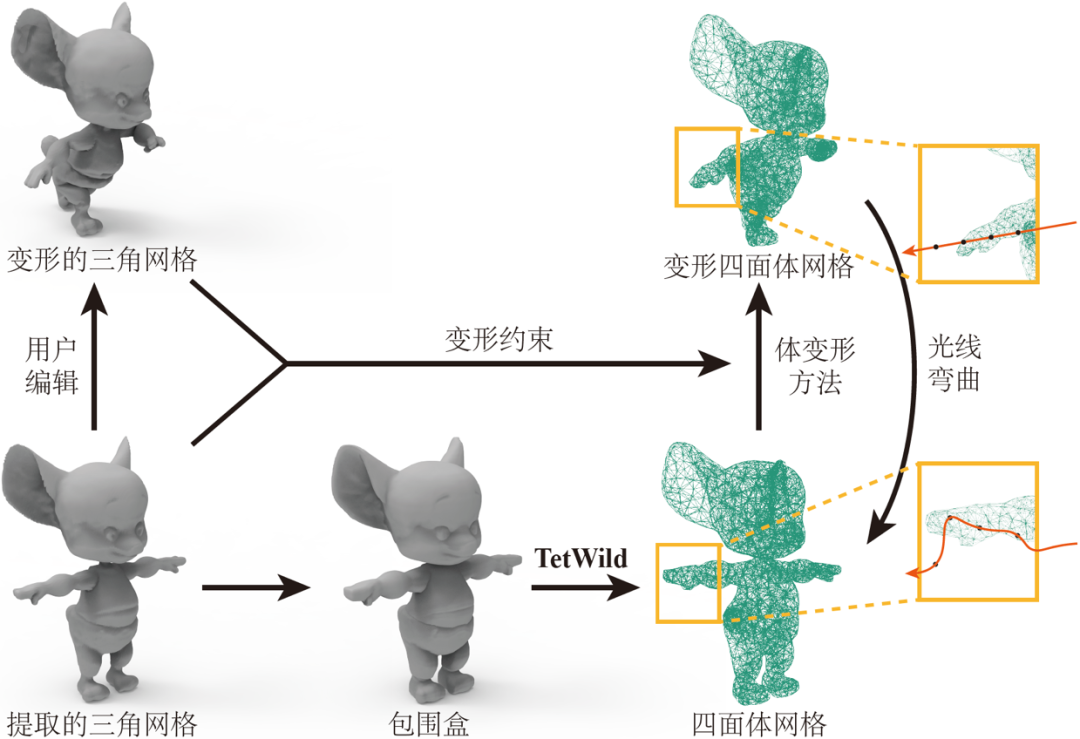

该研究旨在提出一种使用户能够自定义变形约束,并利用施加的变形约束编辑神经辐射场以生成变形后场景图像的方法。算法框架如图2所示。该研究首先从训练好的神经辐射场表示中提取显式的三角网格表示。用户在显式三角网格表示上指定控制点,并通过拖动控制点进行直观的变形编辑。根据变形前后的网格,该研究提出一种将离散的网格顶点变形传播到整个连续空间的方法。通过弯曲体渲染过程中行进的光线,神经辐射场可以渲染出满足用户编辑预期的结果。

图2: 神经辐射场变形方法示意图

该研究的核心在于将离散的网格顶点变形传播到整个连续空间。为实现这一过程,研究者提出以空间四面体作为代理,通过最小化ARAP(as-rigid-as-possible)[2]变形能量项来求解空间四面体的变形,进而插值出空间中任意点的变形位移值,对光线实现弯曲,如图3所示。具体而言,首先用户需要拍摄物体对象的多视角图片,并利用神经辐射场网络重建该物体。在得到场景的显式表征之后,用户可使用已有的网格编辑方法对提取的显式表征进行变形编辑。为了将网格顶点的偏移传播到整个空间,研究者构建了一个包裹三角形网格的四面体网格,通过优化变形前后的三角形网格重心坐标以及四面体网格的局部刚性来求解变形前后四面体网格顶点的偏移。记变形前后的三角形网格顶点为,变形前后的四面体网格顶点为 ,变形后的四面体

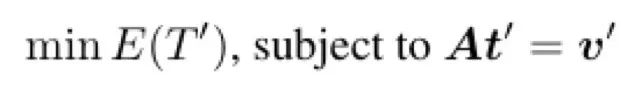

,变形后的四面体 可通过优化以下能量式求解

可通过优化以下能量式求解

其中, 表示约束四面体局部刚性的ARAP能量。更多细节请参考论文。

表示约束四面体局部刚性的ARAP能量。更多细节请参考论文。

图3: 离散的网格顶点变形到连续空间的传播

结果展示

图4展示了在合成场景上的编辑结果。其中第一组结果(前两行)是一个乐高推土机模型。用户可以编辑推土机使其放下铲子,实现了复杂合成数据的编辑。第二组结果(后两行)是一个椅子模型。用户可以拉伸椅子的背部和腿部,实现物体的局部组成部件编辑。

图4: 合成数据上编辑结果

图5展示了真实场景上的编辑结果。用户可以编辑长颈鹿使其具有不同姿态,或者缩放局部区域。

图5: 真实数据上编辑结果

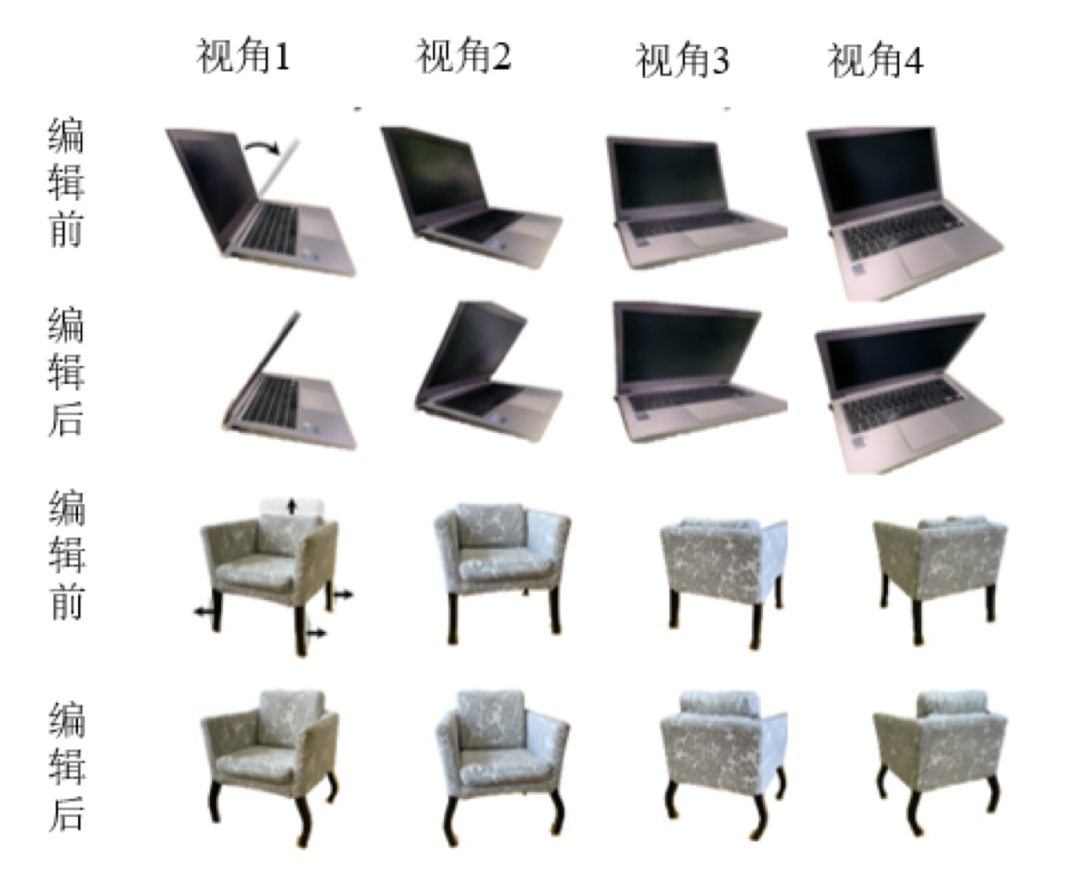

图6展示了更多在真实场景上编辑的结果。用户可以扇动小恐龙的翅膀,或者合上笔记本的盖子。

图6: 更多真实数据上编辑结果

图7展示了对模型进行编辑后,插值变形序列得到的动画渲染结果。

图7: 编辑前后模型插值序列结果

简单总结,该研究提出了第一种支持用户控制的神经辐射场网络几何变形的方法。通过建立显式网格表示和隐式体表示之间的对应关系,该方法可以使用网格变形方法来指导神经辐射场进行变形,从而合成满足编辑需求的新视角渲染图。

论文信息

Yu-Jie Yuan#, Yang-Tian Sun#, Yu-Kun Lai, Yuewen Ma, Rongfei Jia, Lin Gao*. NeRF-Editing: Geometry Editing of Neural Radiance Fields,IEEE CVPR 2022.

技术详见

http://geometrylearning.com/NeRFEditing/

参考文献

Ben Mildenhall, Pratul P Srinivasan, Matthew Tancik, Jonathan T Barron, Ravi Ramamoorthi, and Ren Ng, NeRF: Representing scenes as neural radiance fields for view synthesis, ECCV, 2020, 405-421.

Olga Sorkine-Hornung and Marc Alexa, As-rigid-as-possible surface modeling, Symposium on Geometry Processing, 2007.

项目信息

Object Drawer(官网:https://objectdrawer.alibaba.com)低成本高质量建模产品。业内首个基于神经渲染的三维建模产品,在NeRF神经渲染技术的基础上,创造性提出了显式+隐式的三维模型新范式,突破了建模鲁棒性、细节分辨率、推理速度、光照迁移等NeRF神经渲染技术局限,实现了低成本高质量的自动化商品三维建模,建模还原度大大超出同类产品水平,欢迎大家体验、交流。

团队介绍

商品三维建模&AI设计团队立足于先进的AI技术和XR新硬件、新引擎,为消费者打造全新的沉浸式购物体验,让用户在购前充分地体验商品和服务带来的享受,同时为商家提供更具竞争力的商品场景化表现力。团队目前已经有3D建模—描物坊(Object Drawer)、3D动态和静态场景生成—3D神笔等产品。在建模及设计产品研发的同时,团队在学术方面积极贡献,在ICCV、NeurIPS、KDD、CVPR等顶级学术会议上发表多篇论文,为研究者开放3D-FRONT数据集,获ChinaGraph首届数据奖。为了打造团队的全栈研发能力,我们不断吸引3D/XR引擎、视觉/图形算法等领域的优秀专业人才加入,一起奔向XR新时代。

作者|孙阳天 编辑|橙子君

点击进入—> CV 微信技术交流群

ICCV和CVPR 2021论文和代码下载

后台回复:CVPR2021,即可下载CVPR 2021论文和代码开源的论文合集

后台回复:ICCV2021,即可下载ICCV 2021论文和代码开源的论文合集

后台回复:Transformer综述,即可下载最新的3篇Transformer综述PDF

目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer6666,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信: CVer6666,进交流群

CVer学术交流群(知识星球)来了!想要了解最新最快最好的CV/DL/ML论文速递、优质开源项目、学习教程和实战训练等资料,欢迎扫描下方二维码,加入CVer学术交流群,已汇集数千人!

▲扫码进群

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看![]()