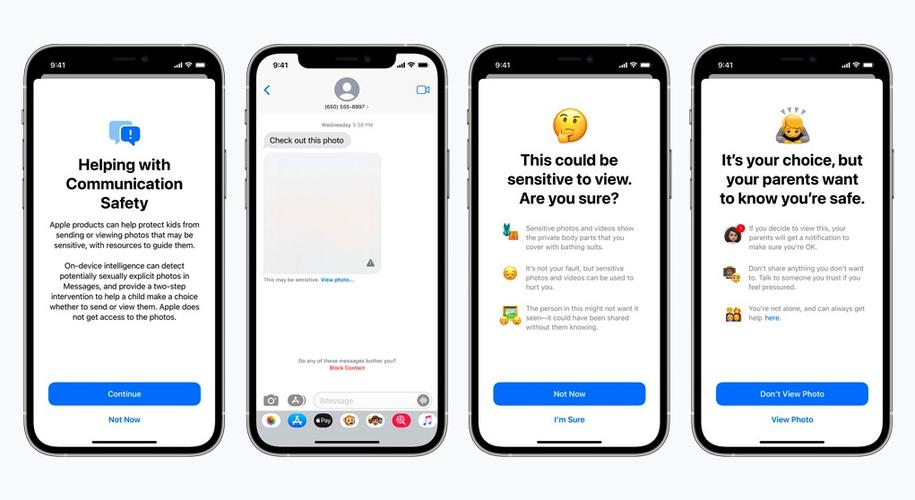

近期,苹果在官网正式发布“扩大儿童保护”公告。为了让儿童能够更加安全地上网,他们决定在iOS 15、iPadOS 15、macOS Monterey系统中推出三项新功能:Messages通信安全、Siri搜索拓展和iCloud照片检测。

苹果“儿童安全”新功能预览

图片来源:网络

根据美国国家失踪和受剥削儿童中心(NCMEC)资料库中的已知信息,苹果将扫描用户的iCloud照片库。一旦发现虐待儿童和色情的图片,neuralMatch系统将主动提醒审查人员。如果材料能够得到验证,他们将封禁相应账号,并与执法部门联系。

消息一出,舆论迅速两极分化。支持者认为此举在青少年保护上迈出了重要一步,而反对者则警告:苹果“毫无征兆地将价值1万亿美元的设备变成了监控设施”。

01

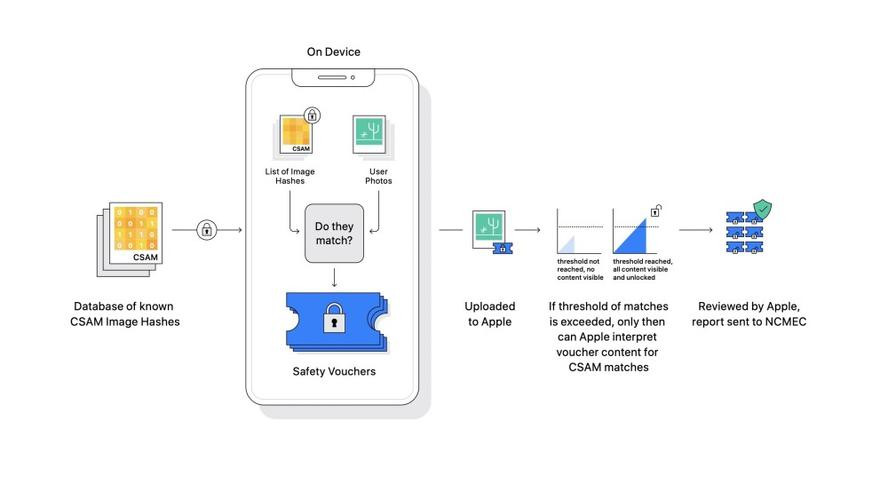

怎么进行CSAM 检测?

支持苹果开展新功能的系统名为neuralMatch,该系统将使用一种名为“哈希”(Hashing,把任意长度的输入通过散列算法变换成固定长度的输出)的进程,对“儿童性虐待材料”(Child Sexual Abuse Material,简称“CSAM”)图片进行监测,把图片转换为与其对应的唯一数字。与美国NCMEC提供的数据库进行对比后,当系统认为匹配的图片达到阈值时,将会启动人工干预。

neuralMatch系统运转流程示意图

图片来源:网络

这一系列过程并不在云端进行,而都在用户本地设备上完成。苹果公司表示,neuralMatch系统不会对实际图片进行扫描,只会扫描“哈希”。换言之,苹果无法看到具体的照片,而是只能看到一组哈希值,也只有在用户打开iCloud照片后才能启用新功能。

02

内容安全VS隐私保护

即便如此,苹果的“儿童安全”新功能还是引起了公众的担忧——因为向来以隐私保护为傲的苹果开始“干涉”用户的相册了。

苹果公司关于隐私的立场

图片来源:Apple(中国)官网

同样属于内容安全,人们对互联网内容安全监测的态度则恰恰相反。自2011年全国启动“净网行动”起,互联网内容安全日益成为关系下一代身心健康的重要社会问题。但内容安全和隐私保护并未在这一问题上产生剧烈碰撞,很大一部分原因在于:人们被保留了一份边界式的安全感。

不同于苹果“儿童安全”功能对纯属私密的本地设备的干预,互联网内容安全监测在更为“公”的领域运行,需要具备一定的交互和传播条件——理论上来说,你的本地相册是不受干预的。这份边界感也恰是平衡内容安全和隐私保护的关键。

03

民意当前,安全监测如何不越界?

苹果将推出“儿童安全”新功能的消息发出后,超过4000个组织和个人签署了一份公开信来反对此项举措。不论出于怎样的善意,苹果此举确实让许多人感到了边界的丧失。

苹果广告语

图片来源:网络

2019年国际消费类电子产品展览会(CES)会场对面大楼的墙上,苹果贴上了一句振奋人心的广告语:“What happens on your iPhone, stays on your iPhone. ”这正道出了民众的心声。推行内容安全监测,事关千千万万个终端设备。干净、有序的网络内容环境离不开有效的监测,但在具体落点上,正当的“人情”诉求应该得到重视。相比下沉本地的全员监测,溯源治理可能更具有长远意义,也更受民众理解,毕竟隐私是每个人的所有物,是“国王和军队不能进”的那间“小屋”。