前提:java环境,hadoop环境,scala环境均已安装且版本没有问题

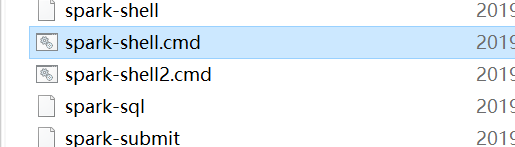

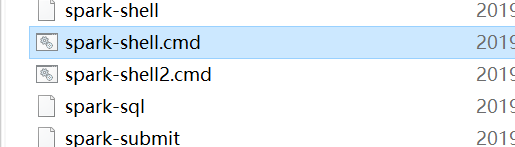

问题:双击spark-shell.cmd没有反应

解决方案:

(1.)进入Spark安装目录下的conf目录

(2.)复制conf spark-env.sh.template 文件为 spark-env.sh

(3.)在其中修改,增加如下内容:SPARK_LOCAL_IP=服务器IP地址

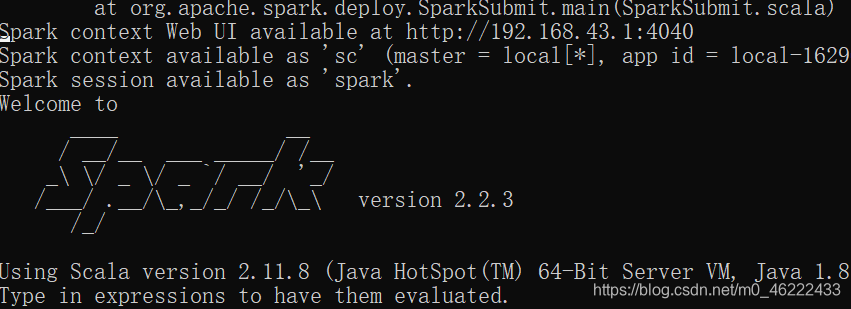

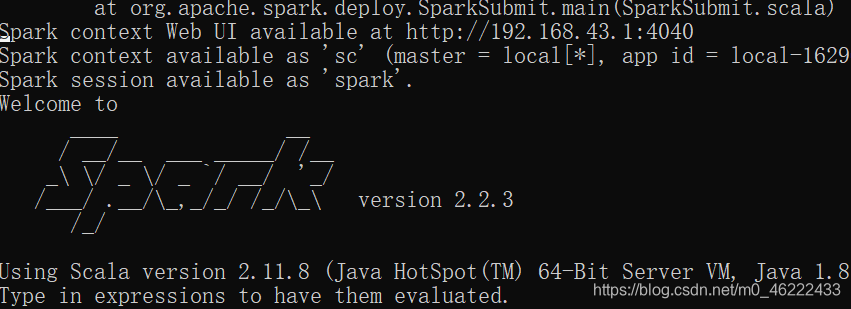

(4.)此时,再次双击spark-shell.cmd就可以打开,如下图

前提:java环境,hadoop环境,scala环境均已安装且版本没有问题

问题:双击spark-shell.cmd没有反应

解决方案:

(1.)进入Spark安装目录下的conf目录

(2.)复制conf spark-env.sh.template 文件为 spark-env.sh

(3.)在其中修改,增加如下内容:SPARK_LOCAL_IP=服务器IP地址

(4.)此时,再次双击spark-shell.cmd就可以打开,如下图