神经网络 by KnowingAI

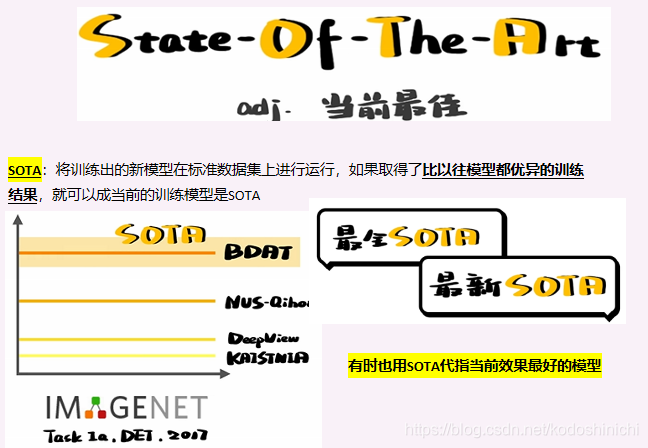

SOTA

神经网络

- 神经网络的出现是因为人们为了实现“机器智能”,通过理解人类思考的原因,仿照人脑中神经元的结构和工作原理设计出的一种网络结构;

- 人脑能够认出苹果的一系列过程——有视网膜接受到光信号,并转换成相应的电信号通过大脑皮层传递给视觉中枢,通过分析物体的颜色、轮廓、质地、形状等等特征从而确定这是一个苹果;神经网络进行物体识别的原理就是对上述过程的一个抽象;

- 各种各样的神经网络——

①输入单元为图结构,则为GNN

②将神经网络打包,就是胶囊神经网络(CAPSNET)

③对输入的数据进行卷积操作,从而得到CNN

图神经网络(GNN)

- 引入GNN的原因在于图结构可以表达的含义很广泛,故将图作为结构输入进神经网络中可以用于解决各种各样的问题;

- 对于图结构不同部分的研究也可解决不同问题——节点的属性预测,边的联系预测,还有整个图结构的识别分类…

- GNN在语音、视觉方面的研究——文本分类是因为文本可以看做是由字词组成的网络;动作识别是因为人体可以看做是骨架和支点的网络

总的来说,只要存在着图结构的领域就可以考虑应用GNN来解决问题

CNN

- 设定不同的卷积核,就能找到原图像中不同的特征

胶囊神经网络

- CNN在对图像进行处理时——

①会忽略特征与特征之间的相对关系

②也很难理解事物的旋转和缩放等操作

——因此使用CNN训练网络需要大量的数据使其能够认出不同位置、视角下的同一事物- 胶囊网络与CNN相比,可以更好地理解事物的组成、位置和姿态

RNN

- RNN——一个高度重视序列信息的网络;在语言领域,不同事物的顺序会导致语义的千差万别,且因为语法结构的划分,不同序列位置往往也隐含了相关信息,因此需要引入RNN来解决问题。

- 工作过程:每次输入一个数据时,除了按照网络权重进行计算,还要考虑隐状态中保存的上一次数据输入时神经网络的状态;随着数据的一次次输入,存储的信息也在不断地更新。

- RNN与自然语言处理:

①机器翻译——寻找相同的意义序列在不同语言之间的表达;

②诗歌生成——基于特定的主题,按照一定的规则输出有逻辑的词语序列

p.s. 诸如语音识别、股票量化交易估计等,这些可以把输入数据和时间序列联系起来的应用场景,同样可以利用RNN进行分析。

LSTM

- RNN用隐状态来保存上一时刻神经网络的状态信息,但是随着数据的不断输入,越久远的前状态信息所占据的比重就会越来越小,这就是为什么RNN只能用来保留短期记忆。

- 门是用来决定信息如何保留的小开关,数值范围[0,1];更新后的隐状态附带三个门——

①遗忘门:决定隐状态中保留多少原有信息;(遗忘哪些旧东西)

②输入门:决定保留多少当前网络状态中的信息;(记住哪些新东西)

③输出门:决定多大程度地输出隐状态中的信息。- LSTM更新后的机制:

①通过输入门对当前网络状态进行了解(short memory)

②通过遗忘门留下过往的重要信息(long memory)- GRU(门控循环单元)

①更新门(遗忘门+输入门):决定丢弃的旧信息和添加的新信息

②重置门:决定写入的上一时刻网络状态(捕捉短期记忆)

上述内容源自于B站up主@KnowingAI知智的原创内容

![[图片]](https://img-blog.csdnimg.cn/2021030617583556.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L2tvZG9zaGluaWNoaQ==,size_16,color_FFFFFF,t_70)

![[图片]](https://img-blog.csdnimg.cn/20210308182137359.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L2tvZG9zaGluaWNoaQ==,size_16,color_FFFFFF,t_70)

![[图片]](https://img-blog.csdnimg.cn/20210308183505985.png?x-oss-process=image/watermark,type_ZmFuZ3poZW5naGVpdGk,shadow_10,text_aHR0cHM6Ly9ibG9nLmNzZG4ubmV0L2tvZG9zaGluaWNoaQ==,size_16,color_FFFFFF,t_70)