已知BUG:(version:5) 1-爬取后生成的XML默认编码是Java环境决定导入数据库可能出问题 方法修改xml编码后导入

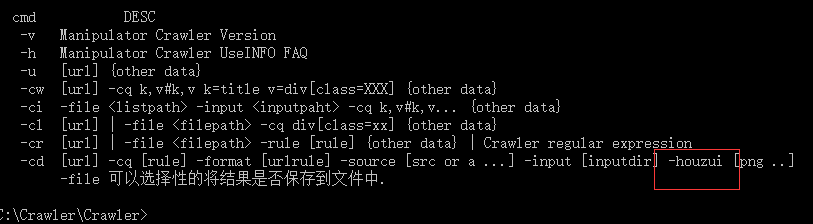

重点CL 和 CI命令

CL 是爬取List列表 会通过file生成文件

CI 中file是CL执行后生存的File文件

CL生成File文件(List),CI读取File文件(list)进行对List遍历,通过Cq命令提取List中每一个文章的内容,然后通过CI的input命令输出到xml中,就可以入库了。

流程:CL生成List CI读取LIST 完成任务

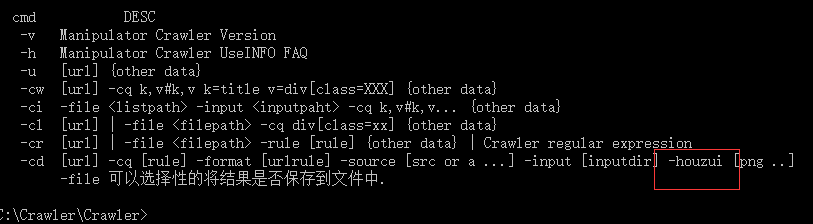

重点CL 和 CI命令

CL 是爬取List列表 会通过file生成文件

CI 中file是CL执行后生存的File文件

CL生成File文件(List),CI读取File文件(list)进行对List遍历,通过Cq命令提取List中每一个文章的内容,然后通过CI的input命令输出到xml中,就可以入库了。

流程:CL生成List CI读取LIST 完成任务