0. 前言

- 相关资料:

- arxiv

- github

- 论文解读

- 论文基本信息

- 领域:视频数据增强

- 作者单位:NAVER AI LAB(韩国最大搜索引擎公司)& 韩国科学技术院

- 发表时间:2020.12

- 一句话总结:印象中第一篇视频数据增强工作

1. 要解决什么问题

- 当前的视频分类模型存在过拟合的问题

- 模型学到的可能是背景或周围物体信息,而没有关注动作本身,这导致模型进入局部最优解。

- 目前的数据增强工作在静态图像领域,视频领域几乎没有什么工作。

2. 用了什么方法

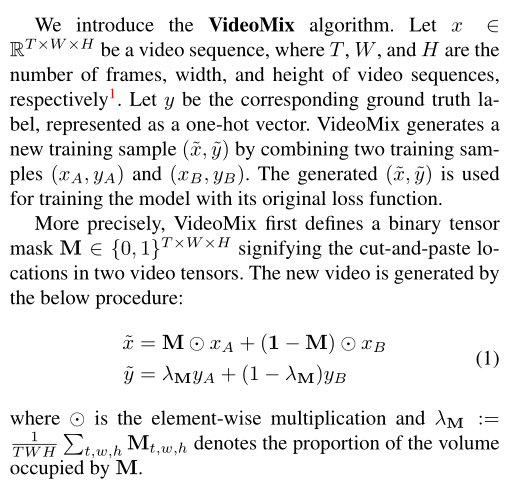

- 本文提出了一种VideoMix方法

- 此方法对图像数据增强CutMix的扩展。

- VideoMix的基本原理很简单

- 输入数据融合两个视频片段,输出结果也是融合两个视频片段。

- 输入数据怎么融合?

- 与Mixup不同,Mixup是将两个视频片段的每个像素点按照一定比例融合。VideoMix是每个像素点要么属于片段A要么属于片段B。

- 具体两个片段怎么拼成一个,后文介绍。

- 输出结果怎么融合?

- 就是两个片段原始标签的加权和。权重就是两个片段各自的比例。

- 结果是one-hot形式的。

- 详细定义可以参考下图原文,说得很清楚了

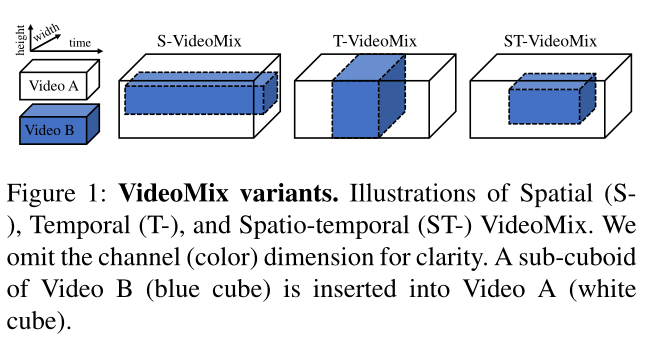

- 那两个视频片段要怎么融合呢?

- 三种融合方式,Spatial/Temporal/Spatio-Temporal,其实文字说起来不清楚,下面的图更清楚。

- Spatial,空间融合,即融合后clip的每一帧都包含两个原始clip的信息。

- Temporal,时间融合,即融合后clip的每一帧,要么属于输入clip A,要么属于输入 clip B

- Spatio-Temporal,时空融合,即将一个clip B融合到Clip A的部分帧中。这个方式等价于与前文中提到的,“将图像增强领域的CutMix直接引入视频”。

- 三种融合方式,Spatial/Temporal/Spatio-Temporal,其实文字说起来不清楚,下面的图更清楚。

- 实现细节:

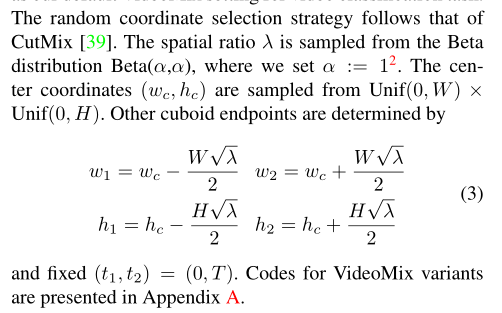

- 需要随机选择区域,具体选择方法参考了CutMix

- 随机选择的参数包括中心点坐标以及长长宽。

- 更多细节参考论文原文

- 在部分应用中,很难直接对输入视频进行操作(比如已经实现提取好特征,要直接对特征进行处理)。这时候建议使用Tempoal VideoMix。

3. 效果如何

-

论文中的一些结论

- 效果如何?从训练结果看,val loss减少,val accuracy增加。

- VideoMix之后学到了什么信息?作者认为不仅学到了动作本身,还学到了动作发生的位置。

- 如何验证?就是通过卷积神经网络可视化来实现。

- 效果如何?从训练结果看,val loss减少,val accuracy增加。

-

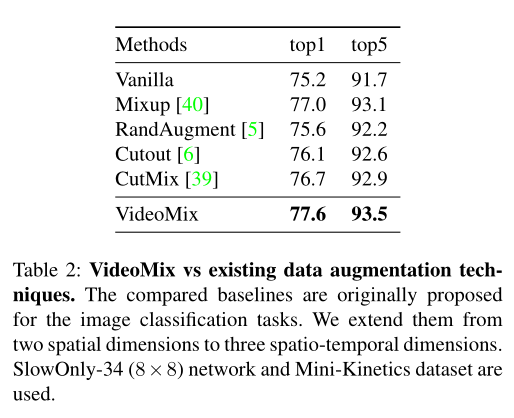

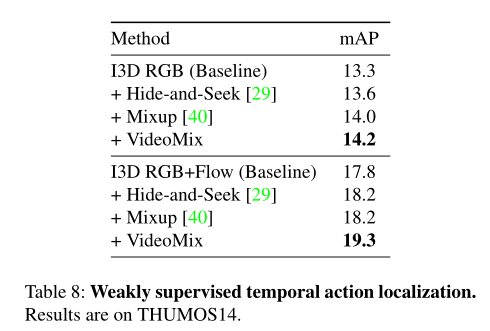

评估了图像层面的数据增强方式直接应用到视频领域的效果

-

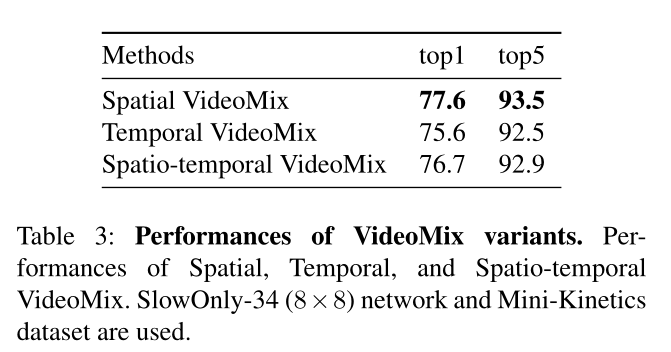

对比了VideoMix的集中不同的融合方式,空间融合效果最好

-

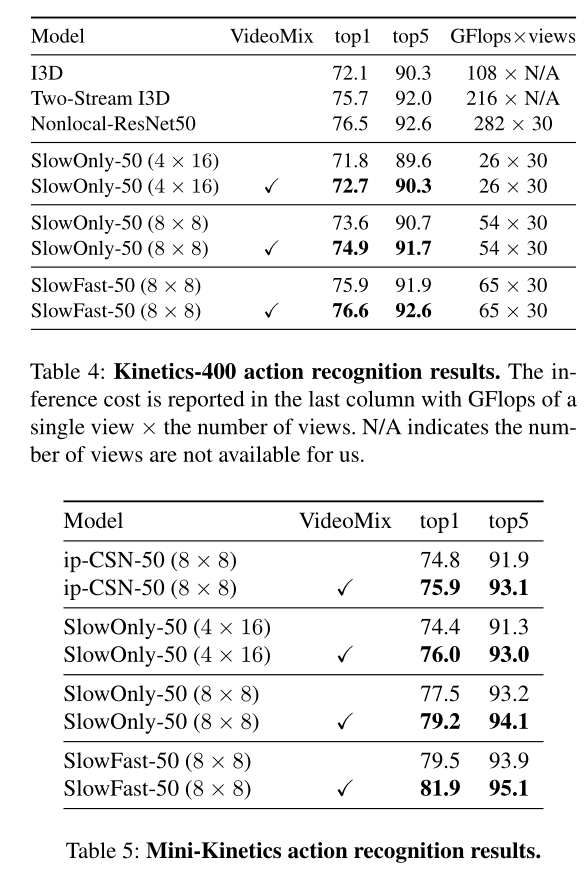

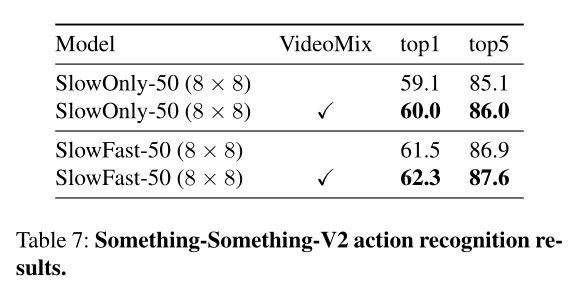

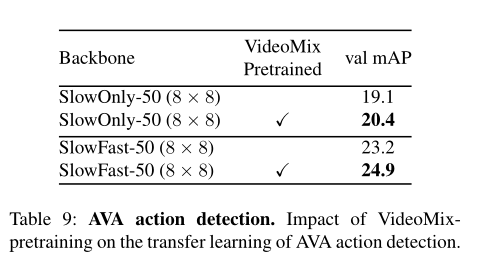

实验结果表明,在Kinetics-400/THUMOS14/AVA上,VideoMix都能提点

4. 还存在什么问题&可借鉴之处

- 这种数据增强方式其实还是比较容易想到的(看到这篇论文的时候有点难过……唉),后续有可能会复现一下。