Precision精确率, Recall召回率,是二分类问题常用的评价指标。混淆矩阵如下:

T和F代表True和False,是形容词,代表预测是否正确。

P和N代表Positive和Negative,是预测结果。

2. Precision

精确率计算公式:

理解:

TP+FP: 也就是全体Positive, 也就是预测的图片中是正类的图片的数目

TP: 也就是正类也被预测为正类的图片的个数

总之:预测正确的图片个数占总的正类预测个数的比例(从预测结果角度看,有多少预测是准确的)

3. Recall

召回率计算公式:

理解:

TP+FN: 也就是全体完全满足图片标注的图片的个数

TP:正类被预测为正类的图片个数

总之:确定了正类被预测为正类图片占所有标注图片的个数(从标注角度看,有多少被召回)

3.AP计算

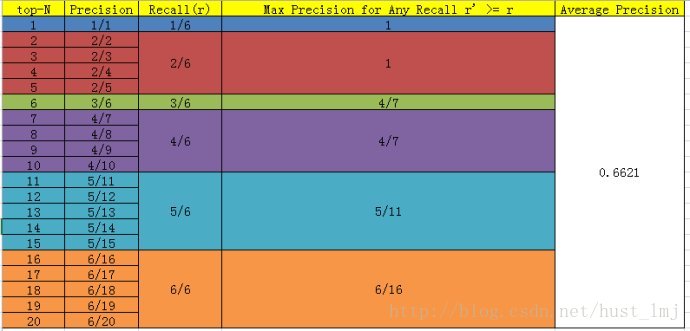

PASCAL VOC CHALLENGE自2010年后就换了新计算方法。新的计算方法假设这N个样本中有M个正例,那么我们会得到M个recall值(1/M, 2/M, …, M/M),对于每个recall值r,我们可以计算出对应(r’ > r)的最大precision,然后对这M个precision值取平均即得到最后的AP值。计算方法如下:

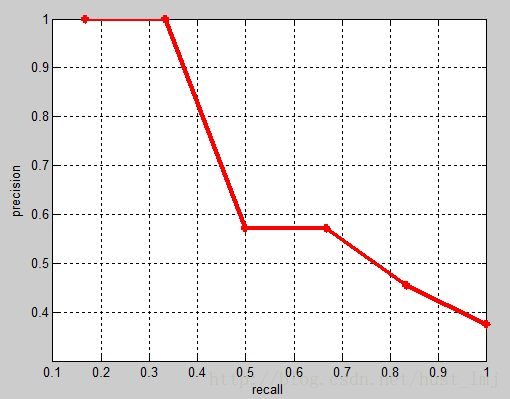

相应的Precision-Recall曲线中被用于计算AP的部分如下(每一个recall的节点都取precision的最大值连接起来):

4.mAP

AP衡量的是学出来的模型在每个类别上的好坏,mAP衡量的是学出的模型在所有类别上的好坏,得到AP后mAP的计算就变得很简单了,就是取所有AP的平均值。