AM-GCN: Adaptive Multi-channel Graph Convolutional Networks(论文解析,这是今年发表在ACM SIGKDD上的一篇文章)

摘要

图卷积网络在处理图形和网络数据的各种分析任务方面已经获得了很大的流行。然而,最近的一些研究提出了一个问题,即在一个具有丰富信息的复杂图中,全局控制网络是否能够最优地集成节点特征和拓扑结构。在本文中,我们首先提出一个实验研究。令人惊讶的是,我们的实验结果清楚地表明,在融合节点特征和拓扑结构的最先进的GCN能力是远离最佳的,甚至不那么令人满意。这种弱点可能会严重阻碍分类神经网络在某些分类任务中的能力,因为分类神经网络可能无法自适应地学习拓扑结构和节点特征之间的一些深度相关信息。我们能否弥补这一缺陷,设计一种新型的GCN网络,既能保留现有GCN网络的优点,又能大大提高融合拓扑结构和节点特征的能力?针对这一挑战,我们提出了一种用于半监督分类的自适应多通道图卷积网络(AM-GCN)。其核心思想是我们同时从节点特征、拓扑结构及其组合中提取特定和常见的嵌入,并使用注意机制来学习嵌入的自适应重要性权重。我们在基准数据集上的大量实验清楚地表明,AM-GCN从节点特征和拓扑结构中提取了最相关的信息,并且显著提高了分类精度。

一、Introduction

网络数据无处不在,比如社交网络、生物网络、引用网络。最近,图卷积网络(GCNs),一类设计用于学习图数据的神经网络,在解决图形分析问题方面显示出很大的流行性,例如节点分类[1,31],图形分类[7,37],链接预测[13,36]和推荐[6,34]。

典型的GCN [14]及其变体[11,16,27,30,36]通常遵循消息传递方式。一个关键步骤是特征聚合,即一个节点在每个卷积层中聚合来自其拓扑邻居的特征信息。这样,特征信息通过网络拓扑传播到节点嵌入,然后这样学习的节点嵌入被用于分类任务。整个过程由节点标签部分监督。GCN的巨大成功部分归功于GCN提供了一种基于拓扑结构和节点特征的融合策略来学习节点嵌入,并且融合过程由端到端的学习框架来监督。

然而,最近的一些研究揭示了最先进的GCN网络在融合节点特征和拓扑结构方面的某些弱点。例如,李等人[15]表明,GCN网络实际上是对节点特征进行拉普拉斯平滑,使整个网络中的节点嵌入逐渐收敛。Nt和Maeharad[20]和吴等人[30]证明了当特征信息在网络拓扑结构上传播时,拓扑结构对节点特征起到低通滤波的作用。高等人[8]在设计了一个条件随机场(CRF)层来明确地保持节点之间的连通性。

GCN真正从拓扑结构和节点特征中学习融合的是什么信息?这是一个基本问题,因为GCN网络经常被用作端到端的学习框架。对这个问题的明智回答可以帮助我们以有原则的方式理解GCN网络的能力和局限性。这立刻激发了我们的学习。

作为这项研究的第一个贡献,我们提出了实验,评估融合拓扑结构和节点特征GCN的能力。令人惊讶的是,我们的实验清楚地表明,在网络拓扑结构和节点特征上的融合能力明显远离最优甚至令人满意。即使在节点特征/拓扑与节点标签之间的相关性非常清楚的一些简单情况下,GCNs仍然不能充分融合节点特征和拓扑结构来提取最相关的信息(如第2节所示)。这种弱点可能会严重阻碍分类网络在某些分类任务中的能力,因为分类网络可能无法自适应地学习拓扑结构和节点特征之间的一些相关信息。

一旦最先进的GCN网络在融合方面的弱点被发现,一个自然的问题是,“我们能否弥补这一弱点,设计一种新型的通用GCN网络,既能保留最先进的GCN网络的优点,同时又能大大增强融合拓扑结构和节点特征的能力?”

GCNs良好的融合能力应该能够为分类任务充分提取和融合最相关的信息,然而,现实中最大的障碍是网络数据和分类任务之间的相关性通常非常复杂和不可知。分类可以与拓扑、节点特征或它们的组合相关联。针对这一挑战,提出了一种用于半监督分类的自适应多通道图卷积网络(AM-GCN)。中心思想是我们同时基于节点特征、拓扑结构及其组合来学习节点嵌入。其基本原理是特征之间的相似性和由拓扑结构推断的相似性是相互补充的,并且可以自适应地融合以导出用于分类任务的更深的相关信息。

技术上,为了充分利用特征空间中的信息,我们将节点特征生成的k近邻图作为特征结构图。利用特征图和拓扑图,我们在拓扑空间和特征空间上传播节点特征,从而用两个特定的卷积模在这两个空间中提取两个特定的嵌入。考虑到两个空间之间的共同特征,我们设计了一个具有参数共享策略的共同卷积模块,用于提取两个空间共享的共同嵌入。我们进一步利用注意机制来自动学习不同嵌入的重要性权重,以便自适应地融合它们。这样,节点标签能够监督学习过程,自适应地调整权重以提取最相关的信息。此外,我们还设计了一致性和差异约束,以保证学习嵌入的一致性和差异。

我们总结我们的主要贡献如下:

(1)我们提出了实验,评估融合拓扑结构和节点特征的GCN的能力,并确定GCN的弱点。我们进一步研究了重要的问题,即如何大幅度提高GCN分类的融合能力。

(2)我们提出了一种新的自适应多通道GCN框架,AM-GCN,它在拓扑和特征空间上执行图卷积运算。结合注意机制,可以充分融合不同的信息。

(3)我们在一系列基准数据集上的大量实验清楚地表明,AM-GCN优于最先进的GCNs,并从节点特征和拓扑结构中很好地提取了最相关的信息,用于具有挑战性的分类任务。

论文的其余部分组织如下。在第二节中,我们实验性地研究了GCN网络融合节点特征和拓扑的能力。在第三节中,我们开发了AM-GCN。我们在第4节报告实验结果,并在第5节回顾相关工作。我们在第6节总结了论文。

二、GCNS的融合能力:实验研究

在本节中,我们使用两个简单而直观的案例来检验最先进的GCNs是否能够自适应地从图中的节点特征和拓扑结构中学习,并将其充分融合以用于分类任务。主要思想是,我们将分别清楚地建立节点标签与网络拓扑和节点特征之间的高度相关性,然后我们将检查GCN在这两种简单情况下的性能。具有良好融合能力的GCN应在节点标签的监督下自适应地提取相关信息,以提供良好的结果。然而,如果性能与基线相比急剧下降,这将表明GCN不能自适应地从节点特征和拓扑结构中提取信息,即使节点特征或拓扑结构与节点标签之间存在高度相关性。

2.1 Case 1: Random Topology and Correlated Node Features

我们生成一个由900个节点组成的随机网络,其中任意两个节点之间建立边的概率为0.03。每个节点有一个50维的特征向量。为了生成节点特征,我们将3个标签随机分配给900个节点,对于具有相同标签的节点,我们使用一个高斯分布来生成节点特征。三类节点的高斯分布具有相同的协方差矩阵,但是三个不同的中心彼此远离。在该数据集中,节点标签与节点特征高度相关,但与拓扑结构不相关。

我们用GCN [14]来训练这个网络。对于每个类,我们随机选择20个节点用于训练,另外200个节点用于测试。我们仔细调整超参数,以报告最佳性能并避免过度平滑。此外,我们仅将MLP [21]应用于节点特征。GCN和MLP的分类准确率分别为75.2%和100%。

结果符合预期。由于节点特征与节点标签高度相关,因此MLP表现出优异的性能。GCN从节点特征和拓扑结构中提取信息,但不能自适应地融合它们以避免拓扑结构的干扰。它比不上MLP的高性能。

2.2 Case 2: Correlated Topology and Random Node Features

我们生成另一个有900个节点的网络。这一次,每个50维的节点特征是随机生成的。对于拓扑结构,我们使用随机块模型(SBM) [12]将节点分成3个社区(节点分别为0-299、300-599、600-899)。在每个社区内,建立边的概率设置为0.03,不同社区的节点之间建立边的概率设置为0.0015。在该数据集中,节点标签由社区确定,即同一社区中的节点具有相同的标签。

我们再次将GCN应用于这个网络。我们还将DeepWalk[22]应用于网络拓扑,即DeepWalk忽略的特征。GCN和DeepWalk的分类准确率分别为87%和100%。

DeepWalk表现良好,因为它对网络拓扑结构进行了全面建模。GCN从节点特征和拓扑结构中提取信息,但不能自适应地融合它们以避免节点特征的干扰。跟DeepWalk的高性能没法比。

总结。这些案例表明,GCN [14]目前的聚合机制远非最佳,甚至不能令人满意。即使节点标签与网络拓扑或节点特征之间的相关性很高,当前的GCN也不能充分利用节点标签的监督自适应地提取最相关的信息。然而,现实中的情况更加复杂,因为很难知道拓扑或节点特征是否与最终任务更相关,这促使我们重新思考GCN的当前机制。

三、 AM-GCN: THE PROPOSED MODEL

问题设置:我们关注属性图G = (A,X)中的半监督节点分类,其中A ∈ Rn×n是具有n个节点的对称邻接矩阵,X ∈ Rn×d是节点特征矩阵,d是节点特征的维数。具体来说,Aij= 1表示在节点I和j之间有一条边,否则,Aij= 0。我们假设每个节点属于一个C类。

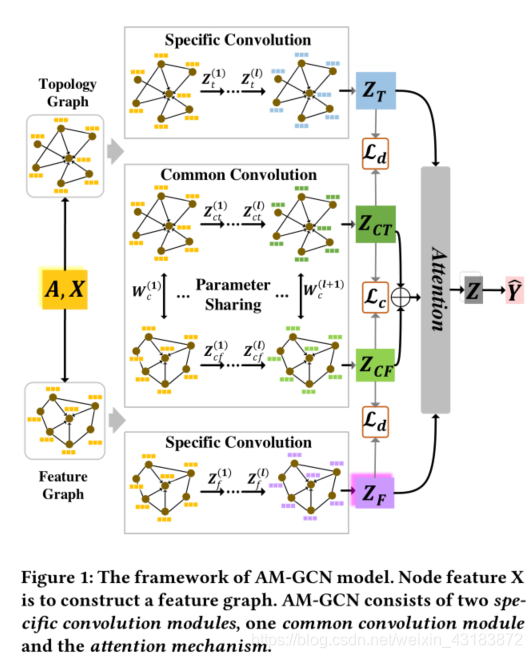

AM-GCN的总体框架如图1所示。其核心思想是AM-GCN允许节点特征不仅在拓扑空间中传播,而且在特征空间中传播,并且与节点标签最相关的信息应该从这两个空间中提取。为此,我们构造了一个基于节点特征X的特征图,然后通过两个特定的卷积模块,X能够在特征图和拓扑图上传播,分别学习两个特定的嵌入ZF和ZT。此外,考虑到这两个空间中的信息具有共同的特征,我们设计了一个具有参数共享策略的共同卷积模块来学习共同嵌入的ZCF和ZCT,并且采用了一致性约束Lc来增强ZCF和ZCT的“共同”性质。此外,还有一个差异约束Ld,以确保ZF和ZCF以及ZT 和ZCT之间的独立性。考虑到节点标签可能与拓扑或特征或两者相关,AM-GCN利用注意机制自适应地将这些嵌入与学习到的权重融合,以便为最终的分类任务提取最相关的信息Z。

3.1 Specific Convolution Module

首先,为了捕捉特征空间中节点的底层结构,我们基于节点特征矩阵X构造了一个k-近邻(kNN)图Gf= (Af,X),其中Afi是kNN图的邻接矩阵。具体来说,我们首先计算相似矩阵S ∈ Rn×n的n个节点。实际上,获取S的方法有很多种,这里列出了两种比较流行的方法,其中xj是节点i和j的特征向量:

1)余弦相似度:它用两个向量夹角的余弦值来度量相似度:

2)热核:相似度由等式计算。(2)其中t是热传导方程中的时间参数,我们设置t = 2。

这里我们统一选择余弦相似度来获得相似度矩阵S,然后我们为每个节点选择前k个相似节点对来设置边,最后得到邻接矩阵Af。

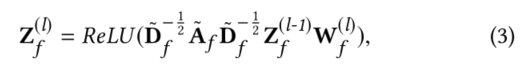

然后,利用特征空间中的输入图(Af,X),第l层输出Z(l) f可以表示为:

其中W(l)是GCN第l层的权重矩阵,ReLU是Relu激活函数,而initialZ(0) f = X。具体来说,我们有 Af = Af+If Df是Af的对角度矩阵。我们将最后一层输出嵌入表示为ZF。这样,我们可以学习捕捉ZF在特征空间特定信息的节点嵌入。

对于拓扑空间,我们有原始输入图Gt= (At,Xt),其中At= A,Xt= X。然后可以用与在特征空间中相同的方式计算基于拓扑图的学习输出嵌入Zt。因此,可以提取拓扑空间中编码的特定信息。

3.2 Common Convolution Module

实际上,特征空间和拓扑空间并不是完全不相关的。基本上,节点分类任务可能与特征空间或拓扑空间或两者中的信息相关联,这很难事先知道。因此,我们不仅需要提取这两个空间中的节点特定嵌入,还需要提取这两个空间共享的公共信息。这样,任务将变得更加灵活,以确定哪部分信息最相关。为了解决这个问题,我们设计了一个带参数共享策略的共GCN算法,使嵌入在两个空间共享。

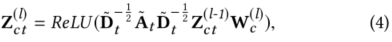

首先,我们利用共GCN从拓扑图中提取节点嵌入Zct,如下所示

其中,W(l)c是第l层的公共GCN权重矩阵,而Z(l-1)CT是第(l-1)层中的节点嵌入,并且Z(0) ct= X。当利用公共GCN从特征图(Af,X)中学习节点嵌入时,为了提取共享信息,我们为公共GCN的每个层共享相同的权重矩阵W(l)cf,如下所示:

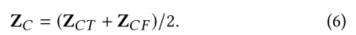

其中Z(l)cf是l层输出嵌入,Z(0) cf = X。共享权重矩阵可以从两个空间中过滤出共享特征。根据不同的输入图,我们可以得到两个输出嵌入ZCT和ZCF范,这两个空间的共同嵌入ZC是:

3.3 Attention Mechanism

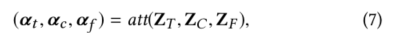

现在我们有两个具体的嵌入ZT和 ZF,和一个共同的嵌入ZC。考虑到节点标签可以与它们中的一个甚至它们的组合相关联,我们使用注意机制att(ZT、ZC、ZF)来学习它们相应的重要性(αt、αc、αf)如下:

这里αt,αc,αf∈Rn×1分别表示嵌入ZT,ZC,ZF的n个节点的注意值。

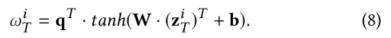

这里我们关注节点i,它在ZT中的嵌入是zi T∈ R1×h(即ZT的第I行)中的嵌入。我们首先通过非线性变换对嵌入进行变换,然后使用一个共享注意力向量q∈Rh′×1得到关注值ωi T如下:

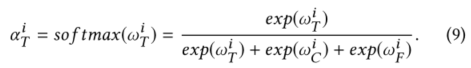

这里W∈Rh′×his为权重矩阵,b∈Rh′×1为偏置向量。类似地,我们可以分别得到嵌入矩阵zC和ZF中节点I的关注值ωi和ωi。然后,我们使用softmax函数对关注值ωi T、ωi C、ωI f进行归一化,以获得最终权重:

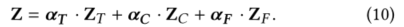

αi越大,相应的嵌入越重要。类似地,αi C= so f tmax(ωi C),αi F= so f tmax(ωi F)。对于所有的n个节点,我们已经学习了权重αt= [αi T],αc= [αi C],αf= [αi F] ∈ Rn×1,并表示αT= diag(αt),αC= diag(αc)和αF= diag(αf)。然后我们结合这三种嵌入得到最终的嵌入Z:

3.4 Objective Function

**3.4.1一致性约束。**对于两个输出嵌入ZCT和ZCF共同-GCN,尽管共同-GCN有共享的权重矩阵,这里我们设计了一个一致性约束,以进一步增强它们的通用性。

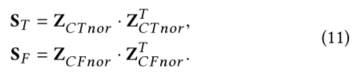

首先,我们使用L2归一化将嵌入矩阵归一化为ZCT nor,ZC F nor。然后,这两个归一化矩阵可用于捕捉如下的n个节点的相似性:

一致性意味着两个相似性矩阵应该相似,这就产生了以下约束:

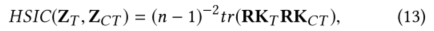

3.4.2差异约束。这里,因为嵌入ZT和ZCT是从同一个图Gt= (At,Xt)中学习的,为了确保它们能够捕获不同的信息,我们使用希尔伯特-施密特独立性准则(HSIC) [24],一种简单但有效的独立性度量,来增强这两种嵌入的差异。由于其简单性和简洁的理论性质,HSIC已经被应用于若干机器学习任务[10,19]。形式上,ZT和ZCTis的HSIC约束定义为:

其中kT和kCT是Gram矩阵,kT,i j= kT(zi T,zj T)和kCT,i j= kCT(zi CT,zj CT)。R = I-1/n eeT,其中I是单位矩阵,e是全一的列向量。在我们的实现中,我们为kt和KCT使用内积核函数。

同样,考虑到ZF和ZC F的嵌入也是从同一个图(Af,X)中得知的,它们的差异也应该通过HSIC得到增强:

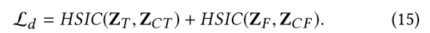

然后我们将视差约束设置为Ld:

3.4.3 Optimization Objective我们使用在等式中嵌入Z的输出。公式(10)对于具有线性变换和softmax函数的半监督多类分类。将n个节点的类别预测表示为Y =[yic]∈Rn×C,其中yic是节点i属于类别c的概率,然后Y可以通过以下方式计算:

中softmax(x)= exp(x)σC C = 1e XP(xc)实际上是所有类的归一化。

假设训练集是L,对于每一个l ∈ L,真实标签是Yl,预测标签是Yl。那么所有训练节点上的节点分类的交叉熵损失表示为Lt其中:

结合节点分类任务和约束条件,我们有以下总目标函数:

其中γ和β是一致性和视差约束项的参数。在标记数据的指导下,我们可以通过反向传播来优化所提出的模型,并学习用于分类的节点的嵌入。

4 EXPERIMENTS

4.1 Experimental Setup

数据集:我们提出的AM-GCN是在六个真实世界的数据集上进行评估的,这些数据集总结在表1中,此外,我们在补充中提供了所有的数据网站,以保证再现性。

Baselines: 我们比较了AM-GCN和两种现有的方法,包括两种网络嵌入算法和六种基于图形神经网络的方法。此外,我们在补充中提供了所有的代码网站,以供复制。

Parameters Setting: 为了更全面地评估我们的模型,我们为训练集选择了三个标签率(即每类20、40、60个标签节点),并选择1000个节点作为测试集。所有基线都用他们论文中建议的相同参数进行初始化,我们还进一步小心地变换参数以获得最佳性能。对于我们的模型,我们同时训练三个具有相同隐藏层维数(nhid1)和相同输出维数(nhid2)的2层GCNs,其中nhid1∈{ 512,768}和nhid 2∈{ 32,128,256}。我们用0.0001~0.0005的学习率和Adam优化器。此外,辍学率为0.5,重量衰减∈{ 5e 3,5e 4 }和k∈{ 2。。. 10}对于k-最近邻图。在{0.01,0.001,0.0001}和{ 1e 10,5e 9,1e 9,5e 8,1e 8 }中搜索一致性系数约束和视差约束。对于所有方法,我们使用相同的分区运行5次,并报告平均结果。我们使用准确性(ACC)和宏观F1评分(F1)来评估模型的性能。为了再现性,我们在附录中提供了具体的参数值(第a3节)。

CONCLUSION

在这篇文章中,我们重新思考了GCN的网络拓扑和节点特征的融合机制,令人惊讶地发现它远非最优。基于这个基本问题,我们研究了如何自适应地从拓扑和节点特征中学习最相关的信息,并充分融合它们进行分类。我们提出了一种多通道模型AM-GCN,它能够在融合拓扑和节点特征信息时学习合适的重要性权重。广泛的实验很好地证明了在真实世界数据集上,与最先进的模型相比,性能更优越。

个人总结

本文这种图说的非常清晰与简洁了,就不做过多的描述