我们总是喜欢拿“顺其自然” 来敷衍人生道路上的荆棘坎坷, 却很少承认,真正的顺其自然, 其实是竭尽所能之后的不强求,而非两手一摊的不作为。 --知乎 2020.08.1

mongoDB 学习平台:

https://mongoing.com/?s=mongodb+Cloud+Manager+

第1章MongoDB简介

MongoDB(源自单词humongous)是一种较新的数据库,它没有表、模式、SQL或行的概念。它没有事务、ACID兼容性、连接、外键或其他许多容易在凌晨引起问题的特性。

1.1了解MongoDB哲学

1.1.1使用正确的工具处理正确的工作

MongoDB中最重要的哲学概念是:一鞋难合众人脚。

1.1.2天然缺少对事务的支持

数据库将不会包含事务的语义(用于保·证数据一致性和存储的元素),

1.1.3 BSON和MongoDB

BSON(二进制JSON的英文简称)的开放数据格式。大多数情况下,使用BSON取代JSON并不会改变处理数据的方式,BSON通过使计算机更容易处理和搜索文档的方式,使MongoDB处理速度变得更快。BSON还添加了一些标准JSON不支持的特性,包括数字数据(例如int32和int64)的许多扩展类型,以及支持处理二进制数据。

1.1.4采用非关系方式

改进关系型数据库性能的方式是非常直接的:购买更大更快的服务器。

MongoDB通过一种非常聪明的方式解决了这些活跃/活跃集群问题, MongoDB是以BSON文档格式存储数据的,所以数据是自包含的。尽管相似的数据文档被存储在一起,但各个文档之间并没有关系。你需要的所有东西都在同一个地方。

因为MongoDB查询将在文档中寻找特定的键和值,该信息可以轻松地被扩散到所有可用的服务器上。每台服务器都将检查该查询,并返回结果。这样,可扩展性和性能的提升几乎是线性的。

MongoDB并不提供主/主复制,两台不同的服务器都可以接受写入请求。不过,它支持分片,允许将数据分散到多台机器中,每台机器都将负责更新数据集的不同部分。

- 分片集群的好处是可以添加额外的分片,来增加部署中的资源能力,而不必更改任何应用程序代码。

- 非分片数据库部署仅限于垂直缩放:可以添加更多的内存/CPU/磁盘,但是这很快就会变得非常昂贵。

分片的部署也可以垂直缩放,但更重要的是,它们可以基于能力要求进行横向扩展(水平扩展):

一个分片集群可以包含更多、能买得起的商用服务器,而不是几个非常昂贵的服务器。水平扩展非常适于通过云实例和容器进行弹性供应。

1.2将所有组合在一起

1.2.1生成或创建键

MongoDB要求每个文档必须有唯一标识符;在MongoDB中,该标识符被称为id。

除非为该字段指定某个值,否则MongoDB将自动创建唯一值。MongoDB是一个分布式数据库,所以其主要目标之一是消除对共享资源的依赖(例如检查主键是否独一无二)。非分布式的数据库通常使用一个简单的主键,例如自动递增的序列号。

MongoDB的默认id格式是一个Objectld,它是一个12字节的唯一标识符,可以独立地在分布式环境中生成。

1.2.2使用键和值

MongoDB不要求每个文档必须含有相同的字段,也不要求同名的字段有相同类型的值。如果MongoDB中不含某个键值对,那它就被认为是不存在的。

1.2.3实现集合

在MongoDB中,集合就是一组类似元素的集合。其中的元素不必相似(MongoDB本质上是非常灵活的);不过,当我们开始学习索引和高级查询时,就会看到在集合中放置类似元素的优点。可以在一个集合中混合各种不同的元素,但几乎没有必要这么做。

MongoDB的目标是使生活变得轻松,所以你应该按照自己感觉正确的方式去实现。最后但并非最不重要的是,集合可以按需求即时创建。尤其是,在第一次尝试保存文档时,MongoDB将创建引用它的集合。这意味着可以按照需求即时创建集合(但并不是应该这么做)。因为MongoDB也允许动态地创建索引,执行其他数据库级别的命令,所以可以利用该特性构建出一些非常动态的应用。

1.2.4了解数据库

可能理解MongoDB中数据库的最简单方式就是将它看成一个集合的集合。

1.3了解特性列表

1.3.1 WiredTiger

首先,引入了MongoDB的可插拔存储API和WiredTiger,它是一个性能卓越的数据库引擎。

WiredTiger在MongoDB 3.0中引入,是一个可选的存储引擎,现在是MongoDB 3.2的默认存储引擎。WiredTiger本身就使MongoDB达到一个全新水平,取代了内部数据存储和管理的旧MMAP模型。

WiredTiger允许MongoDB更好地优化驻留在内存中的数据和驻留在磁盘上的数据,而没有以前的杂乱溢出。其结果是,对所有用户而言, WiredTiger往往是一个真正的性能增益。

WiredTiger也更好地优化了数据存储在磁盘上的方式,提供了一个内置的压缩API,大大节省了磁盘空间。可以说,在安装了WiredTiger的机器上, MongoDB使数据库迈出了一大步。

1.3.2使用面向文档存储(BSON)

BSON更易于遍历(即浏览),遍历索引页非常快。尽管比起JSON, BSON需要稍微多一些的硬盘空间,但这并不是问题,

MongoDB可跨机器扩展。多占用一点硬盘空间,换来更好的查询和索引性能。

WiredTiger存储引擎支持多个压缩库,默认启用索引和数据压缩。压缩级别默认可以在每个服务器上设置,也可以在每个集合(在创建时)设置。

在存储数据时,较高的压缩级别会使用更多CPU,但可节省大量磁盘空间。使用BSON的第二个关键优点在于,很容易将BSON数据快速转换为编程语言的原生数据格式。如果以纯JSON方式存储数据,就需要添加一个较高级别的转换。

BSON也提供了对JSON的一些扩展 例如,通过BSON可以存储二进制数据,以及处理特定的数据类型。

因此, BSON可以存储任何JSON文档,但有效的BSON文档可能不是有效的JSON,

1.3.8存储二进制数据

GridFS是MongoDB在数据库中存储二进制数据的解决方案。

BSON支持在一个文档中存储最多16MB的二进制数据,这可能已经可以满足你的需求。

GridFS通过在files集合中存储文件的信息(称为元数据)来实现。数据本身被分成多块(称为信息块)存储在chunks集合中。这种方式使数据存储既简单又有扩展性:还使范围操作(例如获取文件的特定部分)变得更简单通常来说,我们将通过编程语言对应的MongoDB驱动来使用GridFS

1.3.9复制数据

MongoDB提供了包含主/从复制特性的安全网络,这种情况下只有一个数据库可以处于活跃状态,并且可以在任何时间写入,

复制集有一台主服务器(类似于主/从复制中的主服务器),它将处理所有来自客户端的请求。因为在指定的复制集中只有一台主服务器,它可以保证所有写入都会被正确处理。当写入操作·发生时,该操作也会被写入主服务器的oplog集合中。oplog集合将被复制到辅助服务器(可能有许多),并帮助它们将数据更新到与主服务器一致的状态。一旦主服务器出现故障,辅助服务器中的某一台将会成为主服务器,并负责处理所有来自客户端的写入请求。应用驱动将自动检测副本集配置或副本集状态的任何更改,根据更新的副本集状态重新连接。为让副本集维护主服务器,大多数健康的副本节点必须能够相互连接。例如,一套3个节点的副本集需要两个健康的节点来维护一个主服务器。

1.3.10实施分片

对于涉及大规模部署的应用, 自动分片可能是MongoDB最重要和最常用的特性。

在自动分片场景中, MongoDB将处理所有数据的分割和重组。它将保证数据进入正确的服务器,并以最高效的方式运行查询和重组结果。

事实上,从开发者的角度看,使用含有数百个分片的MongoDB数据库和使用单个MongoDB数据库并没有区别。与此同时,如果刚刚开始构建第一个基于MongoDB的网站,那么可能单实例MongoDB就足以满足需求(

1.3.11使用map和reduce函数

1.3.12聚集框架

1.4获取帮助

1.4.1访问网站

1.4.2剪切和粘贴MongoDB代码

1.4.3在Google小组中寻找解决方案决方案

第2章安装MongoDB

2.1选择版本

2.2在系统中安装MongoDB

2.2.1在Linux中安装MongoDB

参考博客: https://www.cnblogs.com/zhaoyingjie/p/12778048.html

[root@liruilong ~]# cd /etc/yum.repos.d

[root@liruilong yum.repos.d]# vim mongodb-org-4.0.repo

[mongdb-org]

name=MongoDB Repository

baseurl=http://mirrors.aliyun.com/mongodb/yum/redhat/7Server/mongodb-org/4.0/x86_64/

gpgcheck=0

enabled=1

# yum update

2.安装MongoDB

安装命令:

yum -y install mongodb-org

安装完成后

查看mongo安装位置 whereis mongod

查看修改配置文件 : vim /etc/mongod.conf

bindIp: 172.0.0.1 改为 bindIp: 0.0.0.0

(注意冒号与ip之间需要一个空格)

3.启动MongoDB

启动mongodb :sudo systemctl start mongod.service

停止mongodb :sudo systemctl stop mongod.service

2.2.2在Windows中安装MongoDB

2.3运行MongoDB

2.3.1先决条件

2.3.2研究安装目录布局

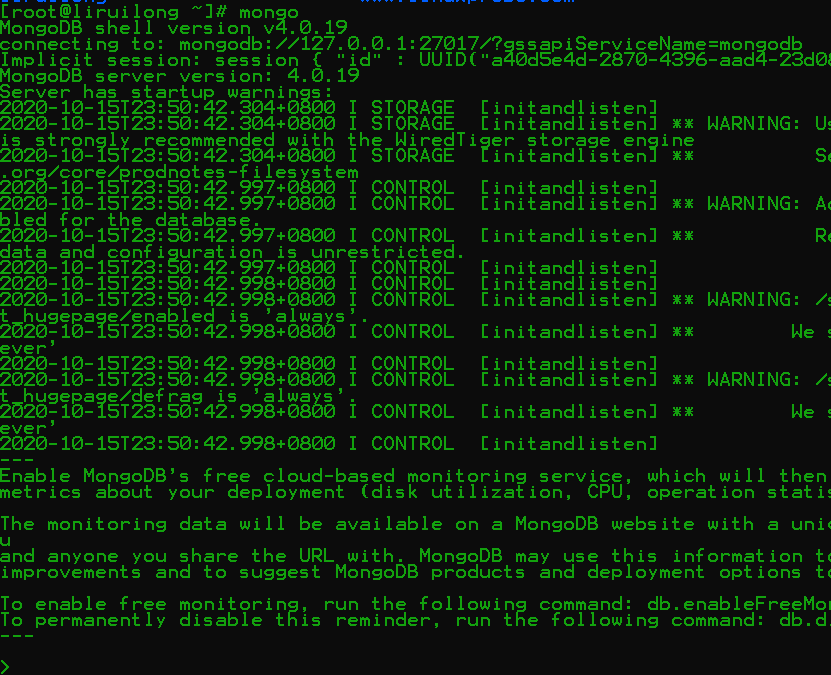

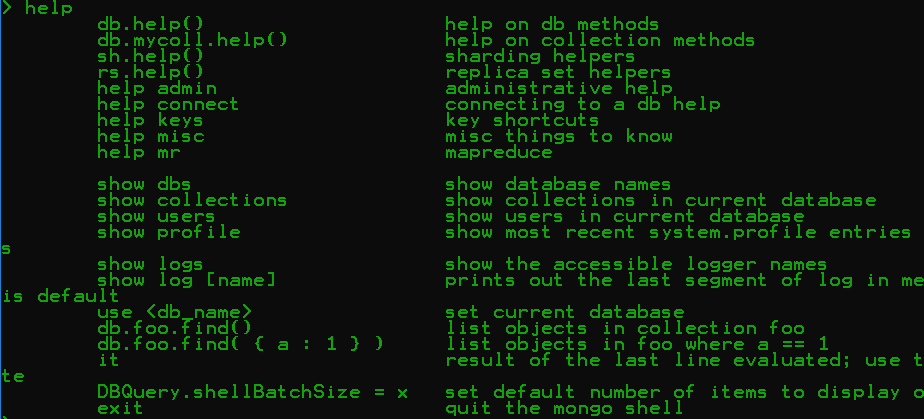

2.3.3使用MongoDB shell

> show dbs

admin 0.000GB

config 0.000GB

demo200712 0.000GB

local 0.000GB

test 0.000GB

> use demo200712

switched to db demo200712

> show collections

movie

> show users

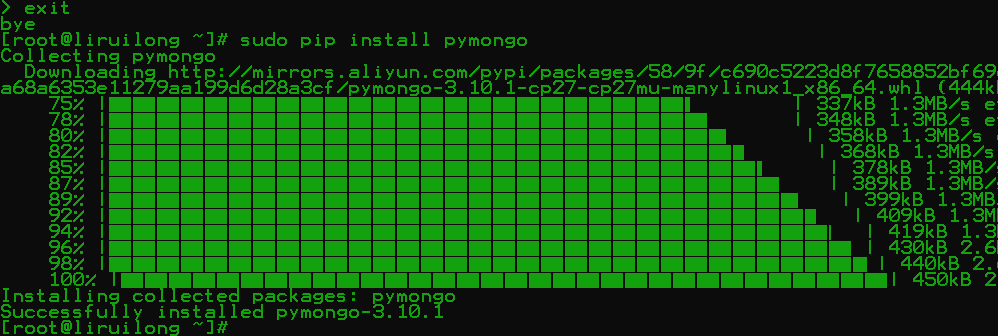

2.4添加额外的驱动

2.4.1 安装PHP驱动

2.4.2确 PHP安装正确

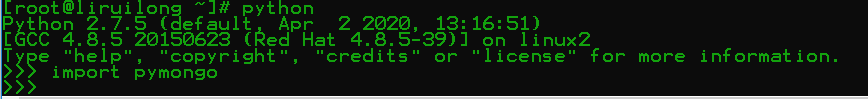

2.4.3安装Python驱动

2.4.4确认PyMongo安装正确

2.5小结

第3章数据模型

3.1设计数据库

3.1.1集合的更多细节

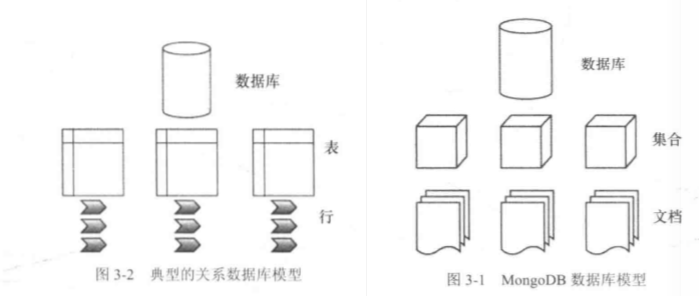

集合是MongoDB中的一个常用术语。可将集合看成存储文档(即数据)的容器,如图3-1所示。

数据库集合文档图3-1 MongoDB数据库模型现在将MongoDB的数据库模型与关系数据库的典型模型做比较

MongoDB中有几种不同类型的集合。默认的集合按照大小进行扩展:添加的数据越多,集合就变得越大。

还可以定义固定大小(capped)的集合。这些固定大小的集合只可以包含特定数量的数据,最老的文档将被新增的文档替代

MongoDB中的所有集合都有唯一的名称。

在使用createCollection函数创建集合时,其中的名称应该以字母或下划线()开头。名字中可以包含数字和字母;

不过$符号是MongoDB的保留关键字。类似地,其中不允许使用空白字符串(" ");也不可以使用null字符,并且不可以以"system."字符串开头。

MongoDB支持的集合名称的最大长度为128,很明显,并没有任何实际的理由需要创建如此长的名称。运行默认MMAPVI存储引擎的单个数据库默认最多可以创建24 000个名称空间, WiredTiger存储引擎没有这个限制。

每个集合至少包含两个名称空间:一个用于集合自身,另一个用于集合中创建的第一个索引。

如果为每个集合添加更多索引,将使用更多名称空间。这意味着从理论上讲,如果每个集合都只含有一个索引,那么每个数据库默认最多可以拥有12000个集合。不过在执行MongoDB服务应用(mongod)时,可以通过提供nssize参数,把名称空间的数目至多t 到2047MB.

3.1.2使用文档

文档由键/值对组成。例如, "Type": "Book"由键Type和值Book组成。 键的类型为字符串,但可以使用许多不同类型的数据作为值。值可以是任何类型的数据,例如数组甚至是二进制数据。 MongoDB使用BSON格式存储数据 所有可以添加到文档中的数据类型:

- String: 常用数据类型,包含一串文本(或任何其他种类的字符),该数据类型常用于存储文本值(例如, "Country": "Japan").

- Integer(32位和64 ): 该数据类型常用于存储数值(例如, 1"Rank": 1)。注意在整数的前后没有引号。

- Boolean: 该数据类型的值要么为真,要么为假。

- Double: 该数据类型用于存储浮点数。

- Min/Max keys: 该数据类型分别用于与BSON中的最低和最高值加以比较。

- Arrays: 该数据类型用于存储数组(例如, ["Membrey, Peter", "Plugge, Eelco", "Hows.David").

- Timestamp: 该数据类型用于存储时间戳。可以方便记录文档修改或添加的时间。

- Object: 该数据类型用于存储嵌入文档。

- Null: 该数据类型用于存储Null值。

- Symbol: 该数据类型的用法与字符串一致;不过,通常该数据类型将被语言保留用于特定的符号类型。

- Date: 该数据类型用于存储UNIX时间格式的当前日期或时间(POSIX时间).

- Object ID: 该数据类型用于存储文档的ID.

- Binary data: 该数据类型用于存储二进制数据。

- Regular expression: 该数据类型用于正则表达式。所有选项都通过按字母顺序提供的特殊字符表示。

- JavaScripr Code: 该数据类型用于JavaScript代码。 比较在文档中内嵌信息和引用另一个文档中的信息这两种方式的优劣。

3.1.3在文档中内嵌或引用信息

MongoDB(和其他非关系数据库)中,内嵌此类型信息会更加简单。毕竟,文档本身能够实现这样的操作。采用这种方式将保持数据库简洁,保证所有相关的信息都存储在单个·文档中.

使用MongoDB的经验法则是:尽可能地使用内嵌数据,这种方式要高效得多

3.1.4创建id字段

MongoDB数据库中的所有对象都包含唯一标识符,用于区分不同的对象。该标识符被称作id键,它将在创建集合时自动添加到所有文档中。

id键是添加到所有新创建文档中的第1个属性。即使不告诉MongoDB创建该键,它也会这么做。

id的类型默认被设置为由12字节二进制数据组成的BSON数据类型。

这个12字节的值包含4字节的时间戳(从1970年1月1日以来的秒数)、 3字节的机器ID、2字节的进程ID和3字节的计数器。

3.2构建索引

索引是一种数据结构,用于收集集合中文档特定字段的值的信息。

MongoDB的查询优化器使用该数据结构对集合中的文档进行快速排序。

记住,索引保证了在文档中查询数据的速度。基本上,可将索引看成已经执行并存储了结果的预定义查询。可以想象,这极大地增强了查询性能。

创建索引的最大优点在于在查询常用信息时会非常快捷,因为这些查询不需要遍历整个数据库以收集该信息。-旦掌握索引,创建(或删除)索引相对就会很容易。

每个集合最多可以拥有40个索引。通常来说,这远超个人的需要,不过某天你有可能不经意间就达到这个限制。

查看索引:

3.3使用地理空间索引.

索引类型之外, MongoDB还支持地理空间索引,可用于处理基于位置的查询。

例如,可以使用该特性查找距用户当前位置最近的已知目标。或者重新定义搜索,查询距离目前位置最近的,餐馆。

如果希望创建一个应用,希望根据指定的客户ZIP代码找到最近的分公司,那么这种类型的查询将特别有用。准备包含地理空间信息的文档必须有一个子对象或数组(第一个元素指定了对象类型,紧接着是该元素的经度和纬度),如下所示:

参数type可用于指定文档的GeoJSON对象类型,可以是

Point. MultiPoint, LineString.MultiLineString, MultiPolygon, Polygon或GeometryCollection。

如预料的一样,

- Point类型用于指定某个条目(本例中为餐馆)所在的准确位置,因此需要两个值:经度和纬度。

- LineString可用于指定某个沿着特定路线扩展的条目(例如街道),因此需要起点和终点,

- Polygon类型可用于指定(非默认的)图形(购物区域)。使用该类型时,需要保证起点和终点,是一致的,从而可以闭合这个环。另外,该点的坐标将通过在数组中内嵌数组的方式提供,

- 所有Multi版本(MultiPoint. MultiLineString等)是选中数据类型的数组,如下面的MultiPoint

> db.restaurants.insert({})

WriteResult({ "nInserted" : 1 })

> db.restaurants.insert({name:"liruilong",loc:{type:"Point",coordinates:[52.370451,5.217497]} })

WriteResult({ "nInserted" : 1 })

> db.streets. insert( (name: "Westblaak", loc: (type: "Linestring", coordinates: [[52.36881,4.890286] , (52.368762,4.890021] }}})

2020-10-27T08:05:00.452+0800 E QUERY [js] SyntaxError: missing ) in parenthetical @(shell):1:25

> db. stores.insert( (name: "SuperMal1", loc: {type: "Polygon", coordinates:[ [[52.146917,5.374337], [52.146966,5.375471], [52.146722,5.375085], [52.146744,5.374371,[52.146917,5.374337] ]]}})

2020-10-27T08:06:09.862+0800 E QUERY [js] SyntaxError: missing ) in parenthetical @(shell):1:24

> db.restaurants. insert ({name: "Shabu Shabu", loc: ( type: "MultiPoint", coordinates: [52.1487441, 5.3873406], [52.3569665,4.890517] }})

2020-10-27T08:16:19.440+0800 E QUERY [js] SyntaxError: missing ) in parenthetical @(shell):1:57

> db.restaurants.ensureindex({loc:"2dsphere"})

2020-10-27T08:18:01.426+0800 E QUERY [js] TypeError: db.restaurants.ensureindex is not a function :

@(shell):1:1

3.4可插拔的存储引擎

MongoDB的存储引擎是数据库的一部分,负责把数据存储在磁盘上。

在3.0版本之前,只能使用MongoDB原生的MMAPVI存储引擎。在3.2之前的任何版本中,这仍然是默认的存储引擎,但现在可以选择使用WiredTiger存储引擎替代,

3.5在真实世界中使用MongoDB

3.6小结

第4章使用数据

4.1浏览数据降

在MongoDB在第一次存储数据时自动创建数据库和集合。要切换到已有的数据库或者创建新的数据库,可在shell中使用use函数,

在命令后加上希望使用的数据库名称即可,无论它存不存在。

查看可用的数据库:

查看所有集合:

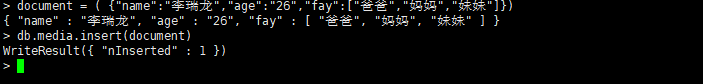

4.2在集合中插入数据

将文档插入到集合中后,返回WriteResult)的输出。WriteResult)将携带操作的状态,以及执行的动作。当插入文档时,返回nInserted属性以及插入文档的数量。

键名约束:

- $字符不能是键名的第一个字符。例如$tags.

- 圆点[.]不能出现在键名中。例如ta.gs.

- 名称_id被保留用作主键ID:尽管不推荐,但可以保存任何唯一值,例如字符串或整数。

创建集合时也存在一些限制。

- 集合的名称(包括数据库名和“.”分隔符)不能超过128个字符。

- 空字符串(" ")不能用作集合名称。

- 集合名必须以字母或下划线开头。

- 集合名system被MongoDB保留,不能使用。集合名不能包含null字符“0".

4.3查询数据

函数find()提供了从同一集合的多个文档中获取数据的最简单方式。它将是最常用的函数之一。

假设已经在library数据库的media集合中插入了之前的两个样例。如果在该集合上使用findo),结果将是其中的所有文档:

> show collections

media

> db.media.find()

{ "_id" : ObjectId("5f99fdc1540cc5e47fad265f"), "name" : "李瑞龙", "age" : "26", "fay" : [ ] }

>

> db.demo.find({type"1"})

> db.demo.find({type:"1"})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({type:"1"},{fileNmae:1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661") }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663") }

插入的参数(Title: 1)表示只返回标题字段中的信息。总是返回id字段,除非使用Lid: 0排除它。

> db.demo.find({type:"1"},{fileName:0})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({type:"1"},{fileName:1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "fileName" : "测试.txt" }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "fileName" : "test1.txt" }

>

4.3.1使用点号

> db.demo.find({"extend.filestate":""},{fileName:1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "fileName" : "测试.txt" }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "fileName" : "test1.txt" }

> db.demo.find({"extend.filestate":"1"},{fileName:1})

> db.demo.find({"fileName":"测试.txt"},{fileName:1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "fileName" : "测试.txt" }

> db.demo.find({"fileName":"测试.txt","test1.txt"},{fileName:1})

2020-10-29T08:05:15.691+0800 E QUERY [js] SyntaxError: missing : after property id @(shell):1:45

4.3.2使用函数sort, limit和skip

通过使用sort函数可以对查询返回的结果进行排序。可分别使用1或-1将结果按照升序或条序排序。该函数与SQL中的ORDER BY语句类似,它将使用键的名称和排序方法作为条件。

> db.demo.sort({fileName:1})

2020-10-29T08:10:19.639+0800 E QUERY [js] TypeError: db.demo.sort is not a function :

@(shell):1:1

> db.demo.find().sort({fileName:1})

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

在不指定参数的情况下,这是默认的排序顺序。还可以使用-1标志来进行降序排序。

注意:如果指定一个不存在的键用于排序,结果的顺序就是未定义的

> db.demo.find().sort({fileName:-1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

> db.demo.find().sort({liruilong:-1})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

通过使用limit)函数可以限制返回结果的最大数目。。

该函数只需要一个参数:希望返回的结果的数目。如果使用的参数为0,将返回所有结果。

> db.demo.find().sort({fileName:-1}).limit(1)

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find().sort({fileName:-1}).limit(0)

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

还可以使用skip0函数忽略掉集合中的前n个文档。结合limit和skip可以实现分页;

> db.demo.find().sort({fileName:-1}).limit(2)

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find().sort({fileName:-1}).skip(2)

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

> db.demo.find().sort({fileName:-1}).limit(1).skip(2)

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

可在find()函数中使用快捷方式忽略并限制结果的数目: fnd ( {},{} ,10,20).这里,将首先:略开头的20个文档,然后将结果数目限10个

> db.demo.find({},{},2,1)

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({},{},2,2)

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({},{},2,3)

> 4.3.3 使用固定集合、自然顺序和$natural

在MongoDB中使用查询时,需要注意固定集合、自然顺序和$natural.

自然顺序是数据库中集合的原生排序方法。所以,在查询集合中的文档时,如果没有显式指定排序顺序,结果将默认按照前向自然顺序返回。这通常与文档插入的顺序一致:不过,自然集合的自然顺序没有定义,可能取决于文档增长模式、用于查询的索引和所使用的存储引擎。

固定集合(capped collection)是数据库的一种集合,它的自然顺序保证与文档插入的顺序一致。保证自然顺序一直与文档插入顺序一致,这一点在需要将查询的结果严格按照文档插入顺序排序时非常有用。

固定集合还有另一个优点:大小固定。一旦固定集合达到设置的大小,最老的数据将被删除,最新的数据将被添加到末端,保证自然顺序与文档插入的顺序一致。该类型的集合可用于日志和自动归档记录

与标准集合不同,固定集合必须使用createCollection 函数,以显式方式创建。必须使用参数指定集合的大小(单位为字节),

固定集合保证了自然顺序与插入顺序一致,那么在查询数据时,就不需要再使用任何特殊的参数、任何其他特殊的命令或函数,除非希望逆转默认结果的顺序。这时将用到natural参数。例如,假设希望找到固定集合中最近的10条记录,该集合用于保存登录失败的记录。可使用Snatural参数来实现:

> db.createCollection("audit",{capped:true,size:20480})

{ "ok" : 1 }

> db.audit.find().sort({ $natural:-1}).limit(10)

>

已经添加到固定集合中的文档可以更新,但文档大小不能改变,如果出现这种情况,更新将会失败。也不可以从固定集合中删除文档,相反,如果希望删除文档,就必须删除整个集合并重建。

稍后将详细讲解删除集合的方法.还可以使用max:参数限制添加到固定集合中的文档数量,创建集合时使用该参数。

不过,必须注意保证集合有足够的空间容纳这些文档。如果在文档数目达到上限之前,数据大小先达到上限,那么最老的文档将被删除。

MongoDB shell包含一个工具,可用于检查现有集合已经使用的空间大小,无论是固定集合还是普通集合都可以查看。使用validate()函数调用该工具即可。

如果希望评估一个集合可能会变得多大,那么该方法非常有用。如前所述,可使用max:参数限制插入到固定集合中的文档数目,如下所示:

> db.createCollection("sudit100",{ capped:true,size:20,max:1000})

{ "ok" : 1 }

> db.sudit100.stats()

{

"ns" : "listFiles.sudit100",

"size" : 0,

"count" : 0,

"storageSize" : 4096,

"capped" : true,

"max" : 1000,

"maxSize" : 256,

"sleepCount" : 0,

"sleepMS" : 0,

"wiredTiger" : {

"metadata" : {

"formatVersion" : 1

},

............................ }

},

"nindexes" : 1,

"totalIndexSize" : 4096,

"indexSizes" : {

"_id_" : 4096

},

"ok" : 1

}

4.3.4获取单个文档

如果只希望返回一个结果,那可以使用findOne()函数来获取集合中的单个文档。该结果将与使用limit(1)函数得到的结果一致。

//db.media.find()

db.media.findOne()

{

"_id" : ObjectId("5f98bd6de0b9f4383bcce138"),

"name" : "李瑞龙",

"age" : "26",

"fay" : [

"爸爸",

"妈妈",

"妹妹"

]

}

4.3.5使用聚集命令

聚集命令中的3个函数: count, distinct和group.除了这3个基本的聚集函数, MongoDB还包含一个聚集框架。这个强大特性可以在不使用映射/归约框架的情况下,计算聚集结果。

count()

> show collections

audit

demo

media

sudit100

> db.demo.count()

3

> db.sudit100.count()

0

> db.media.count()

2

> db.demo.find({type:"1"}).count()

2

> db.demo.find({type:"1"}).limit(1).skip(3)

> db.demo.find({type:"1"}).limit(1).skip(2)

> db.demo.find({type:"1"}).limit(1).skip(1)

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({type:"1"}).limit(1).skip(1).count(true)

1distinct()

> db.demo.find({type:"1"}).limit(1).skip(1).count(true)

1

> db.demo.distinct("type")

[ "0", "1" ]

> db.demo.distinct("fileName")

[ "5ad3da678c4041f08f4d049be5e540ed", "test1.txt", "测试.txt" ]MongoDB的group命令的目的是返回一个已分组元素的数组。

函数group()接受3个参数: key, initial和reduce.参数key指定希望使用哪个键对结果进行分组

参数initial允许为每个已分组的结果提供基数(元素开始统计的起始基数),如果希望返回指定"的数字,这个参数就应默认为0.

reduce把所有类似的条目分组在一起。它接受两个参数:正在遍历的当前文档和聚集计数对象。在接下来的样例中,这些参数被称为items和prev,实质上, reduce参数在每遇到一个匹配标题的文档时都将把总数加1

> db.demo.group( { key:{fileName:true}, initial:{Total:0}, reduce:(items,prev)=>{ prev.Total += 1 } })

[

{

"fileName" : "测试.txt",

"Total" : 1

},

{

"fileName" : "5ad3da678c4041f08f4d049be5e540ed",

"Total" : 1

},

{

"fileName" : "test1.txt",

"Total" : 1

}

]

>除了key, initial和reduce参数,还可以指定另外3个可选参数:

- keyf:如果不希望使用文档中已有的键对结果进行分组,可以使用该参数替代key参数。此时,可以使用另一个指定了如何分组的函数对结果进行分组。

- cond:可以使用该参数指定一个额外的语句条件,文档必须满足该条件才能参加分组。可以像使用find()查询一样使用该参数搜索集合中的文档。如果未设置该参数(默认),那么集合中所有的文档都将被检查。

- finalize:可以使用该参数指定一个函数,用于在最终结果返回之前执行。例如,可以计算平均数或执行计数,并在结果中包含该信息。

函数group()目前在分片环境中无法正常工作,因此,在这种环境中应该使用mapreduce).另外,

在groupO)函数的输出结果中包含的键不能超过20 000个,否则将会抛出异常。此类情况也可以通过mapreduce)来处理。

4.3.6使用条件操作符

执行大于和小于比较以下特殊参数可用于在查询中执行大于和小于比较: $gt. $lt, $te和$lte。

- $gu(大于)参数。使用该参数指定文档中的某个整数必须大于指定的值时,才能在结果中返回:

> db.demo.find({fileSize:{$gte:0 }},{"fileName":0})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileSize:{$gt:0 }},{"fileName":0})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileSize:{$gt:1 }},{"fileName":0})

> db.demo.find({fileSize:{$gte:1 }},{"fileName":0})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

>

> db.demo.find({fileSize:{$gte:1 }},{"fileName":0})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileSize:{$gte:1,$lt:0 }},{"fileName":0})

> db.demo.find({fileSize:{$gte:1,$lt:1 }},{"fileName":0})

- 2,获取除特定文档之外的所有

> db.demo.find({type:{$ne : 1}})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({type:{$ne : 0}})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

- 3,指定一个匹配的数组·

可使用$in操作符指定一组可能的匹配值。SQL中对应的操作符为IN.下面的代码将使用Sin操作符从media集合中获取数据:

> db.demo.find({fileName:{$ne : 'test1.txt'}})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileName:{$in : 'test1.txt'}})

Error: error: {

"ok" : 0,

"errmsg" : "$in needs an array",

"code" : 2,

"codeName" : "BadValue"

}

> db.demo.find({fileName:{$in : ['test1.txt']}})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

>

- 4·查找某个不在数组中的值操作符

$nin与$in类似,不过它将搜索特定字段的值不在特定数组列表中的文档:

> db.demo.find({fileName:{$nin : ['test1.txt']}})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

>

> db.demo.find({fileName:{$nin : ['test1.txt',"5ad3da678c4041f08f4d049be5e540ed"]}})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileName:{$all : ['test1.txt',"5ad3da678c4041f08f4d049be5e540ed"]}})

>

- 5,匹配文档中的所有属性操作符$all的工作方式也与$in类似。不过, $all要求文档的所有属性都匹配,而$in操作符只要求文档中的一个属性匹配即可。

- 6,在文档中搜索多个表达式在单个查询中可以使用$or操作符搜索多个表达式,它将返回满足其中任何一个条件的文档。与$in操作符不同, $or允许同时指定键和值,而不是只指定值:

可以获取集合中除某些符合特定条件的文档之外的所有文档。注意,所选字段有许多潜在的值时, $ne可能带来很负面的性能影响。

- 7.使用$slice获取文档

> db.demo.find({"fileName":"test1.txt"},{"fileSize":{$slice:2}})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({"fileName":"test1.txt"},{"fileSize":{$slice:1}})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "c4ca4238a0b923820dcc509a6f75849b", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> 使用$slice投射可把数组字段限制为匹配结果的一个数组子集。如果希望通过限制结果元素的数目来节省带宽,那么该操作符非常有用。通过该操作符还可以获取结果中每页的n项数据,该特性通常称为分页。

该操作符接受两个参数:

第一个参数表示将要返回数据项的总数;

第二个参数是可选的,如果使用了该参数,那么第一个参数将用于定义偏移,第二个参数用于定义限制。参数limit也可以使用负值,从数组尾部而不是数组开头开始返回数据项。

- 8,搜索奇数/偶数

通过使用$mod操作符可以搜索由奇数或偶数组成的特定数据。该操作符将把目标值除以2,并检查该运算的余数是否为0,通过这种方式只提供偶数结果。

> db.demo.find({fileSize:{$mod:[2,0]}},{"md5":0})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

>

8、搜索奇数/偶数通过使用$mod操作符可以搜索由奇数或偶数组成的特定数据。该操作符将把目标值除以2,并检查该运算的余数是否为0,通过这种方式只提供偶数结果。

> db.demo.find({fileSize:{$mod:[2,1]}},{"md5":0})

{ "_id" : ObjectId("5f9a02c7540cc5e47fad2663"), "abstractFileId" : "c24caae23e8640d7866f5ba3868002c3", "createTime" : "2020-02-03T06:00:57.007Z", "updateTime" : "2020-02-03T06:00:57.007Z", "appId" : "", "fileId" : "8718cc3d96f24fcdad234f8ed139c6d0", "groupId" : "2e77af3e3ba047d09ecd7d5e79c3d6f0", "fileName" : "test1.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 1, "fileLastModified" : 1580709656815, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2020-02-03T06:00:57.007Z", "path" : "/2e77af3e3ba047d09ecd7d5e79c3d6f0/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

> db.demo.find({fileSize:{$mod:[2,0]}},{"md5":0})

{ "_id" : ObjectId("5f9a01fc540cc5e47fad2661"), "abstractFileId" : "2c46051d7ad8435d90854f93388a7f3f", "createTime" : "2019-09-06T02:55:00.705Z", "updateTime" : "2019-09-06T02:55:00.705Z", "appId" : "", "fileId" : "7708cd240102499fb2ea76be4ed30b8b", "groupId" : "2a35477e083d40f38e9c49ee6821264c", "fileName" : "测试.txt", "extension" : ".txt", "contentType" : "text/plain", "fileSize" : 0, "fileLastModified" : 1567738500562, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "reviseUserSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : "2019-09-06T02:55:00.705Z", "path" : "/2a35477e083d40f38e9c49ee6821264c/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 1 }

{ "_id" : ObjectId("5f9a028c540cc5e47fad2662"), "abstractFileId" : "88f5184ea0d04ba4a6db7585bf968ef9", "createTime" : "2018-11-15T09:01:27.593Z", "updateTime" : "2018-11-15T09:01:27.593Z", "fileName" : "5ad3da678c4041f08f4d049be5e540ed", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "0230fa68b633442dac7f8c2ee01b4265", "effectiveDate" : "2018-11-15T09:01:27.593Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

>

- 9,使用$size过滤结果通过操作符$size可以过滤出文档中数组大小符合条件的结果。例如,可以使用该操作符搜索只含有两首歌曲的CD:

4.3.7使用正则表达式

前缀表达式是一种正则表达式,它以一个左锚点("\A")或插入符号(^)开头,其后是几个字符(例如: "Matrix" )。

记住,不分大小写( "i" )的正则表达式查询,其性能很糟,因为使用这类查询时,需要执行大量的收缩。

> db.demo0808.find()

{ "_id" : "fff4fbc598024ac7935554c9d15bad30", "abstractFileId" : "82c1f30957b54533823341e3eff3feb0", "createTime" : "2020-07-15T01:25:25.469Z", "updateTime" : "2020-07-15T01:25:25.469Z", "fileName" : "其它报告", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "admin", "effectiveDate" : "2020-07-15T01:25:25.469Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : "fff2fa7ccce24bc782b7b5ead015392d", "abstractFileId" : "d0149c523fd04ec5a34cc21122638219", "createTime" : ISODate("2019-01-15T07:53:48.255Z"), "updateTime" : ISODate("2019-01-15T07:53:48.255Z"), "fileName" : "e18048c3dce643afb3559a345c1d4f9b", "fileSize" : NumberLong(0), "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : ISODate("2019-01-15T07:53:48.255Z"), "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

> db.demo0808.find({fileName:/^其 */i})

{ "_id" : "fff4fbc598024ac7935554c9d15bad30", "abstractFileId" : "82c1f30957b54533823341e3eff3feb0", "createTime" : "2020-07-15T01:25:25.469Z", "updateTime" : "2020-07-15T01:25:25.469Z", "fileName" : "其它报告", "fileSize" : 0, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "admin", "effectiveDate" : "2020-07-15T01:25:25.469Z", "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

4.4更新数据

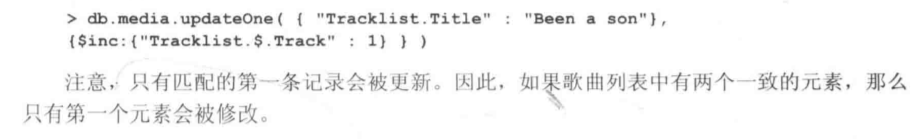

4.4.1使用updateo更新

在MongoDB中可以使用update()函数执行数据更新操作。该函数接受3个主要参数: criteria,objNew和options.

- 参数criteria可用于指定一个查询,该查询选择要更新的目标记录。

- 使用obijNew参数指定更新信息,也可以使用操作符来完成。

- 参数options用于指定更新文档时的选项,它的可选值有:upsert和 multi。

- 通过选项upsert可以指定该更新是否为upsert操作-它将告诉MongoDB,如果数据存在就更新,否则创建数据。

- 通过选项multi可以指定是否应该更新所有匹配的文档,或者只更新第一个文档(默认行为)。

> db.demo0808.updateOne({"fileName":"0808更新测试"},{$set:{"fileName":"测试.ppt"}},{upsert:true})

{

"acknowledged" : true,

"matchedCount" : 0,

"modifiedCount" : 0,

"upsertedId" : ObjectId("5fa491d83a95673bfe69d218")

}

> db.demo0808.find({"fileName":"0808更新测试"})

> db.demo0808.find({"fileName":"测试.ppt"})

{ "_id" : "ffa8fdfaa113446f88fd0a07eaed08ef", "abstractFileId" : "d2cf8d5393c449f58c587545d9444776", "createTime" : "2020-07-15T03:14:13.816Z", "updateTime" : "2020-07-15T03:14:13.816Z", "appId" : "", "fileId" : "03bd715060e245d9805e4f66d2618f12", "groupId" : "c1fa6fe5730748faa38ebc9d0275655d", "fileName" : "测试.ppt", "extension" : ".ppt", "contentType" : "application/vnd.ms-powerpoint", "fileSize" : 0, "fileLastModified" : 1567129291341, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "admin", "reviseUserSign" : "admin", "effectiveDate" : "2020-07-15T03:14:13.816Z", "path" : "/a19adc16bbd84f47b7741bbf45932603/0/技经资料/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 2 }

{ "_id" : ObjectId("5fa48fa23a95673bfe69d204"), "fileName" : "测试.ppt" }

{ "_id" : ObjectId("5fa491d83a95673bfe69d218"), "fileName" : "测试.ppt" }

> db.demo0808.find()

{ "_id" : "fff4fbc598024ac7935554c9d15bad30" }

{ "_id" : "fff2fa7ccce24bc782b7b5ead015392d", "abstractFileId" : "d0149c523fd04ec5a34cc21122638219", "createTime" : ISODate("2019-01-15T07:53:48.255Z"), "updateTime" : ISODate("2019-01-15T07:53:48.255Z"), "fileName" : "e18048c3dce643afb3559a345c1d4f9b", "fileSize" : NumberLong(0), "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "useGridFS" : false, "type" : "0", "shareSign" : 1, "userSign" : "d6af1ad234a54c02a0cf35f577326590", "effectiveDate" : ISODate("2019-01-15T07:53:48.255Z"), "path" : null, "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "fileExtend" : { }, "version_" : 1 }

{ "_id" : "ffa8fdfaa113446f88fd0a07eaed08ef", "abstractFileId" : "d2cf8d5393c449f58c587545d9444776", "createTime" : "2020-07-15T03:14:13.816Z", "updateTime" : "2020-07-15T03:14:13.816Z", "appId" : "", "fileId" : "03bd715060e245d9805e4f66d2618f12", "groupId" : "c1fa6fe5730748faa38ebc9d0275655d", "fileName" : "测试.ppt", "extension" : ".ppt", "contentType" : "application/vnd.ms-powerpoint", "fileSize" : 0, "fileLastModified" : 1567129291341, "thumbnailWH" : "0x0", "thumbnailPos" : "", "compressRate" : "0", "md5" : "d41d8cd98f00b204e9800998ecf8427e", "useGridFS" : true, "targetField" : "", "targetTable" : "", "remark" : "", "type" : "1", "shareSign" : 1, "userSign" : "admin", "reviseUserSign" : "admin", "effectiveDate" : "2020-07-15T03:14:13.816Z", "path" : "/a19adc16bbd84f47b7741bbf45932603/0/技经资料/", "lock_state" : "0", "fileState" : 1, "tenantId" : "0001", "extend" : { "filestate" : "", "fileversions" : "" }, "fileExtend" : { }, "version_" : 2 }

{ "_id" : ObjectId("5fa48fa23a95673bfe69d204"), "fileName" : "测试.ppt" }

{ "_id" : ObjectId("5fa491d83a95673bfe69d218"), "fileName" : "测试.ppt" }

4.4.2使用save()命令实现upsert

还可以使用save)命令执行upsert.为实现该操作,可指定_id值;可手动或自动添加该值.

如果不指定_id值, save()命令将认为它是一个插入操作,并将文档添加到集合中使用save)命令的主要优势是:

不需要指定使用update()命令时所需要使用的upsert参数。

> db.demo0817.save({_id:"5fb070b276e329b5bf255752"},{"id":"2134"})

WriteResult({

"nMatched" : 0,

"nUpserted" : 1,

"nModified" : 0,

"_id" : "5fb070b276e329b5bf255752"

})

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 23, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752" }

> db.demo0817.save({id:"23"},{"name":"1111111111111"})

WriteResult({ "nInserted" : 1 })

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 23, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752" }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

> db.demo0817.save({id:23},{"name":"1111111111111"})

WriteResult({ "nInserted" : 1 })

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 23, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752" }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

> db.demo0817.save({"_id":"5fb070b276e329b5bf255752",id:23},{"name":"1111111111111"})

WriteResult({ "nMatched" : 1, "nUpserted" : 0, "nModified" : 1 })

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 23, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

>

4.4.3 自动更新信息

可使用修改操作符以简单的方式对文档进行快速更新,不需要手动输入任何信息。例如,

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 23, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

> db.demo0817.u

db.demo0817.unsetWriteConcern( db.demo0817.update( db.demo0817.updateMany( db.demo0817.updateOne(

> db.demo0817.updateOne({"name":"lirui"},{$inc:{"id":23}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 46, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

>

1,使用$inc增加值

操作符$inc可以为指定的键执行(原子)更新操作,如果字段存在,就将该值增加给定的增量。如果字段不存在,就创建该字段。

> db.demo0817.find({})

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 55555, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

> db.demo0817.updateOne({id:"23"},{$inc:{ids:4}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.demo0817.find({})

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 55555, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23", "ids" : 4 }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

> db.demo0817.updateOne({id:"23"},{$inc:{ids:4}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.demo0817.find({})

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 55555, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23", "ids" : 8 }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

>

2,设置字段值:$set:

可以使用$set操作符将某个字段设置为指定值

> db.demo0817.updateOne({"name":"lirui"},{$set:{"id":55555}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.demo0817.find()

{ "_id" : ObjectId("5fb070b276e329b5bf255752"), "id" : 55555, "name" : "lirui" }

{ "_id" : ObjectId("5fb070ca76e329b5bf255753"), "id" : 2, "name" : "lsdirui" }

{ "_id" : "5fb070b276e329b5bf255752", "id" : 23 }

{ "_id" : ObjectId("5fb071c976e329b5bf255754"), "id" : "23" }

{ "_id" : ObjectId("5fb071ec76e329b5bf255755"), "id" : 23 }

>

3,删除指定字段,使用$unset:

通过$unset操作符可以删除指定的字段,

4,在指定字段添加值,$push:

通过$push操作符可以在指定字段中添加某个值。如果该字段是个数组,那么该值将被添加到数组中。

如果该字段尚不存在,那么该字段的值将被设置为数组。如果该字段存在,但不是数组,将会抛出错误。

> db.date.updateOne({name:"liruiong"},{$push:{"name2":"234324"}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.date.find()

{ "_id" : ObjectId("5fb06e7d432a096e6b86a978"), "name" : "liruiong", "name1" : "liruiklong1", "name2" : [ "234324" ] }

{ "_id" : ObjectId("5fb06e7f432a096e6b86a979"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e80432a096e6b86a97a"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e81432a096e6b86a97b"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e87432a096e6b86a97c"), "name" : "liruiondfgfdg", "name1" : "lirdfgfduiklong1" }

> db.date.updateOne({name:"liruiong"},{$set:{"name2":"1111111111234324"}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.date.find()

{ "_id" : ObjectId("5fb06e7d432a096e6b86a978"), "name" : "liruiong", "name1" : "liruiklong1", "name2" : "1111111111234324" }

{ "_id" : ObjectId("5fb06e7f432a096e6b86a979"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e80432a096e6b86a97a"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e81432a096e6b86a97b"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e87432a096e6b86a97c"), "name" : "liruiondfgfdg", "name1" : "lirdfgfduiklong1" }

> db.date.updateOne({name:"liruiong"},{$unset:{"name2":"1111111111234324"}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.date.find()

{ "_id" : ObjectId("5fb06e7d432a096e6b86a978"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e7f432a096e6b86a979"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e80432a096e6b86a97a"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e81432a096e6b86a97b"), "name" : "liruiong", "name1" : "liruiklong1" }

{ "_id" : ObjectId("5fb06e87432a096e6b86a97c"), "name" : "liruiondfgfdg", "name1" : "lirdfgfduiklong1" }

>

5,指定数组中的多个值,使用$push操作符可以将值添加到指定数组中,扩展指定元素中存储的数据。

如果希望在给定的数组中添加几个不同的值,可以使用可选的$each修改操作符.

> db.data.find()

{ "_id" : ObjectId("5fb06f09432a096e6b86a97d"), "name" : "kiruiong" }

{ "_id" : ObjectId("5fb06f2f432a096e6b86a97e"), "name" : "liruiong" }

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq" ] }

> db.data.updateOne({"name":"sdf",{$push:"array":{$each:["456","ert"]}}}

... )

2020-11-16T07:37:14.751+0800 E QUERY [js] SyntaxError: invalid property id @(shell):1:32

> db.data.updateOne({"name":"sdf"},{$push:"array":{$each:["456","ert"]}}} )

2020-11-16T07:38:07.941+0800 E QUERY [js] SyntaxError: missing } after property list @(shell):1:47

> db.data.updateOne({"name":"sdf"},{$push:{"array":{$each:["456","ert"]}}} )

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.data.find()

{ "_id" : ObjectId("5fb06f09432a096e6b86a97d"), "name" : "kiruiong" }

{ "_id" : ObjectId("5fb06f2f432a096e6b86a97e"), "name" : "liruiong" }

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert" ] }

>

6,使用$addToSet向数组中添加数据

操作符$addToSet是另一个可用于向数组中添加数据的命令。

不过,只有数据不存在的时候,该操作符才能将数据添加到数组中。

它的工作方式与$push不同。操作符$addToSet默认将接受一个参数。不过,在使用$addToSet时,可以使用$each操作符指定额外的参数。

> db.data.find()

{ "_id" : ObjectId("5fb06f09432a096e6b86a97d"), "name" : "kiruiong" }

{ "_id" : ObjectId("5fb06f2f432a096e6b86a97e"), "name" : "liruiong" }

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert", "55555" ] }

> db.data.updateOne({"name":"sdf"},{$addToSet:{"array":"55555"}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 0 }

> db.data.find()

{ "_id" : ObjectId("5fb06f09432a096e6b86a97d"), "name" : "kiruiong" }

{ "_id" : ObjectId("5fb06f2f432a096e6b86a97e"), "name" : "liruiong" }

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert", "55555" ] }

> db.data.updateOne({"name":"sdf"},{$addToSet:{"array":{$each:["55555","66666","7777"]}})

... )

2020-11-16T07:47:25.584+0800 E QUERY [js] SyntaxError: missing } after property list @(shell):1:86

> db.data.updateOne({"name":"sdf"},{$addToSet:{"array":{$each:["55555","66666","7777"]}}}) )

2020-11-16T07:47:30.102+0800 E QUERY [js] SyntaxError: missing ; before statement @(shell):1:89

> db.data.updateOne({"name":"sdf"},{$addToSet:{"array":{$each:["55555","66666","7777"]}}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.data.find()

{ "_id" : ObjectId("5fb06f09432a096e6b86a97d"), "name" : "kiruiong" }

{ "_id" : ObjectId("5fb06f2f432a096e6b86a97e"), "name" : "liruiong" }

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert", "55555", "66666", "7777" ] }

>

4.4.4从数组中删除元素

MongoDB中还包含了几种从数组中删除元素的方法,包括$pop, $pull和$pullAll.

操作符$pop可从数组中删除单个元素。

该操作符允许删除数组中的第一个或最后一个元素,具体取决于传入的参数。

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert", "55555", "66666", "7777" ] }

> db.data.updateOne({name:"sdf"},{$pop:{array:1}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.data.find({name:'sdf'})

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "123", "qweq", "456", "ert", "55555", "66666" ] }

> db.data.updateOne({name:"sdf"},{$pop:{array:-1}})

{ "acknowledged" : true, "matchedCount" : 1, "modifiedCount" : 1 }

> db.data.find({name:'sdf'})

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "qweq", "456", "ert", "55555", "66666" ] }

> 将传入的数值改为-2或-1000不会改变被移除的元素,只要使用的是负数,就会移除第一个教将移除最后一个元素,使用数字0也可以移除教组的最后一个元素。

1,删除所有指定值通过使用$pull操作符可以从数组中删除所有指定值。

2,删除数组中的多个元素,还可以从数组中删除多个含有不同值的元素。操作符$pullAll可以完成该操作。该操作符将接受一个希望移除元素的数组

> db.data.find({name:'sdf'})

{ "_id" : ObjectId("5fb1bb391f36a81a0fcca01e"), "name" : "sdf", "array" : [ "qweq", "456", "ert", "55555", "66666" ] }

> db.data.updateOne({name:"sdf"},{$pull:{array:"456"}})