Improving Text Understanding via Deep Syntax-Semantics Communication

动机

Syntax-Tree model与sequential semantic model相结合,提高下游任务性能。

Introduction

句子中句法和语义的比较。相同的颜色表示相同(相似)的语义目标。

Model

多层结合模型

定义

句子 S S S = {

w 1 w_1 w1,…, w n w_n wn},对应的sequential 表示:

树表示:

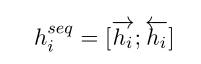

Sequential Encoder

Bi-LSTM:

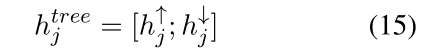

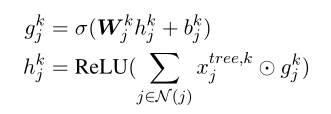

Tree Encoder(TreeLSTM or GCN)

TreeLSTM:Bi-LSTM:

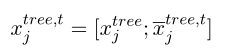

两个方向连接:

GCN:

N N N ( ( ( j j j ) ) )表示邻居节点,取GCN最后一层的输出作为树表示:

Deep Communication Model

将Sequential encoder 和Tree encoder视为一个完整的unit。

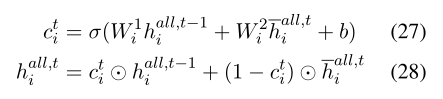

Local Interaction

Local Interaction的动机是鼓励sequential encoder和Tree encoder 从彼此的信息传播模式中学习更多(attenton)。

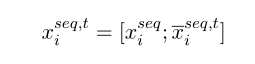

首先,当前步骤 t t t的sequential encoder 中的每个节点将上一时间步骤的相邻节点作为附加输入:

普通的attention:

n n n b b b s s s表示邻居

同样,Tree encoder 亦是如此:

Sentence-level Global Propagation

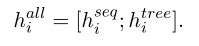

将 Deep Communication Model中的 h h h a ^a a l ^l l l ^l l i _i i 更新为:

h h h a ^a a l ^l l l ^l l i _i i = [ h h h s ^s s e ^e e q ^q q , ^, , t ^t t i _i i, h h h t ^t t r ^r r e ^e e e ^e e , ^, , t ^t t i _i i]

采用一个gate机制(只有输入门)进行global 传播:

上面带横线的 h h h表示ungated 数值。

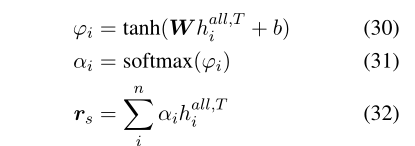

Decoding and Training

Inner - attention:

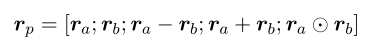

- 如果是自然语言推理任务:

两个句子被表示:

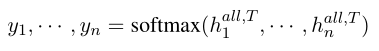

然后输出一个概率。 - 如果是分类任务,直接对输出softmax,取最大值作为被分类类别:

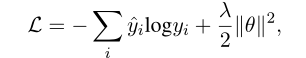

LOSS:交叉熵+ L 2 L_2 L2正则化

冷启动

为了避免冷启动训练,分别预训练独立的sequential encoder和tree encoder,然后在step 0 将它们的参数作为初始状态 h 0 h_0 h0。

结果

event factuality prediction(EFP):事件真实性预测

relation classification for drug-drug interaction(Rel):药物相互作用的关系分类

semantic role labeling (SRL):语义角色标注

自然语言推理任务:

Ablation Study

原文用的GloVe(88.2),实验证明用预训练模型对性能有大幅度提升。