独立冗余磁盘阵列

把多块独立的物理硬盘按不同的方式组合起来形成一个硬盘(逻辑硬盘),从而提供比单个硬盘更高的存储性能和提供数据备份技术

常用的RAID级别

组成磁盘整列的不同方式成为RAID级别

RAID0、RAID1、RAID5、RAID6、RAID1+0

RAID 0 条带化存储

N块硬盘并行组合,成一个新的逻辑盘

- RAID 0连续以位或字节为单位分割数据,并行读/写于多给磁盘上,因此具有很高的数据传输率,但它没有数据冗余

- RAID 0只是单纯提高性能,并没有为数据的可靠性提供保证,而且其中的一个磁盘失效将影响到所有数据

- RAID 0不能应用于数据安全性要求高的场景

RAID1 镜像存储

N(偶数)块硬盘组合,成为一个镜像,N/2容量

- 通过磁盘数据镜像实现数据冗余,在成对的独立磁盘上产生互为备份的数据

- 当原始数据繁忙时,可直接从镜像拷贝中读取数据,因此RAID1可以提高读取性能

- RAID1是磁盘整列中单位成本最高的,但提供了很高的数据安全性和可用性;当一个磁盘失效时,系统可以自动切换到镜像磁盘上读写,而不需要重组失效的数据

RAID5

- N(N>=3)块盘组成阵列,一份数据产生N-1个条带,同时还有一份校验数据,共N份数据在N块盘上循环均衡存储

- N块盘同时读写,读性能很高,但由于由校验机制问题,写性能相对不高

- (N-1)/N磁盘利用率

- 可靠性高,允许坏1块盘,不影响所有数据

RAID6

- N(N>=4)块盘组成阵列,(N-2)/N磁盘利用率

- 与RAID5相比,RAID6增加了第二个独立的奇偶校验信息块

- 两个独立的奇偶系统使用不同的算法,即使两块磁盘同时失效也不会影响数据的使用

- 相对于RAID5由更大的"写损失",因此写性能较差

RAID1+0(先做镜像,再做条带)

- N(偶数,N>=4)块盘两两镜像后,再组合成一个RAID0

- N/2磁盘利用率

- N/2块盘同时写入,N块盘同时读取

- 性能高,可靠性高

RAID 0+1(先做条带,再做镜像)

- 读写性能与RAID 1+0相同

- 安全性低于RAID 1+0

对比

| RAID级别 | 硬盘数量 | 磁盘利用率 | 保护能力 | 写性能 |

|---|---|---|---|---|

| RAID0 | N | N | 无 | 无 |

| RAID1 | N(偶数) | N/2 | 无 | 允许一个设备故障 |

| RAID5 | N>=3 | (N-1)/N | 有 | 允许一个设备故障 |

| RAID6 | N>=4 | (N-2)/N | 有 | 允许两个设备故障 |

| RAID10 | N>=4(偶数) | N-2 | 无 | 允许两个基组中各坏一个 |

实战配置

通用准备工作

检查是否已安装 mdadm 软件包

rpm -q mdadm

yum install -y mdadm

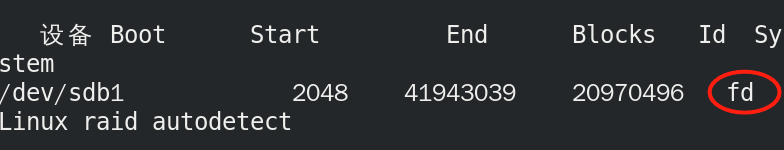

使用fdisk工具将新磁盘设备划分主分区

#ID标记好改为fd

fdisk /dev/sdb

fdisk /dev/sdc

fdisk /dev/sdd

fdisk /dev/sde

n p Enterx3 t fd w

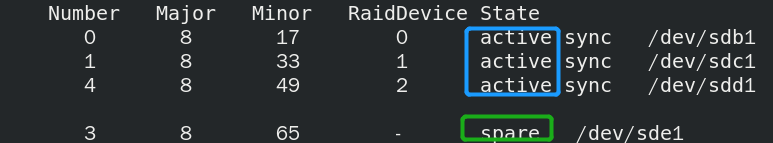

★创建RAID5设备

mdadm -Cv /dev/md0 -l5 -n3 /dev/sd[b-d]1 -x1 /dev/sde1

- -C 表示新建

- -v 显示创建过程的详细信息

- /dev/cat RAID5名称

- -a yes 如果有什么设备文件没有存在的话就自动创建

- -l 指定RAID的级别 l5表示RAID5

- -n 指定使用几块硬盘创建 RAID n3表示使用3块硬盘

- -dev/sd[bcd]1 指定使用这3块磁盘分区取创建RAID

- -x 指定使用几块硬盘做RAID的热备用盘

- /dev/sde1 指定用作与备用磁盘

每隔一段时间刷新信息输出

watch -n 10 ‘cat /proc/mdstat’

mdadm -D /dev/md0

创建并挂载文件系统

mkfs -t xfs /dev/md0

mkdir /myraid

mount /dev/md0 /myraid

★创建RAID10设备

创建两个RAID1,分别命名为md1 和md2

mdadm -Cv /dev/md1 -l1 -n2 /dev/sd[b-c]1

mdadm -Cv /dev/md2 -l1 -n2 /dev/sd[d-e]1

然后等待完成

mdadm -E /dev/sd[b-e]1

#查看四个磁盘是否已经作为RAID

指定md1、md2创建RAID 10

mdadm -Cv /dev/md10 -l0 -n2 /dev/md1 /dev/md2

完成后查看一下磁盘的详细信息

mdadm -D /dev/md10

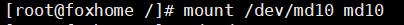

格式化RAID10后进行挂载

实现故障恢复

mdadm /dev/cat0 -f /dev/sdb1 #模拟sdb1故障

mdadm -D /dev/cat0 #查看发现以顶替的

更方便的管理软RAID的配置

如果不进行设置下次停用后将无法启动RAID10

echo 'DEVICE /dev/sdc1 /dev/sdb1 /dev/sdd1' > /etc/mdadm.conf

mdadm --detail --scan >> /etc/mdadm.conf

-

单个>为覆盖,两个>是追加

-

如果停用却没有设置,则需要返回创建RAID10的步骤

mdadm 命令其他常用选项

- -r 移除设备

- -a 添加设备

- -S 停止RAID

- -A 启动RAID

- –detail 查询一个RAID的详细信息

- –scan 从配置文件或者/proc/mdstat中扫描信息