VMware VCF4.0及vSphere 7

4月2日,VMware正式发行vSphere7以及VCF4.0(VMware Cloud Foundation )。vSphere7 整合了VM和Kubernetes平台,借助于VCF组件之一的NSX-T提供网络服务,包括了路由,交换,防火墙,负载均衡等功能服务。

有关vSphere7整合Kubernetes的具体介绍,请参考:

vSphere 7融合Kubernetes,构建现代化应用的平台

软件清单

本实验使用最新官网可下载组件进行安装,具体如下:

| 名称 | 版本 | 备注内部编号 | image |

|---|---|---|---|

| vSphere ESXi | 7.0.0 | 15843807 | VMware-VMvisor-Installer-7.0.0-15843807.x86_64.iso |

| vCenter | 7.0.0 | 15952498 | VMware-VCSA-all-7.0.0-15952498.iso |

| NSX-T | 3.0.0 | 15946739 | nsx-unified-appliance-3.0.0.0.0.15946739.ova |

硬件情况

| 名称 | 配置 | 参数说明 |

|---|---|---|

| 主机 | 三台服务器,共享管理集群和计算集群 | 每台提供2 core 2.20GHz CPU,128G内存,1.92T vSAN存储,2端口1000baseT和2端口10GbaseSX |

| 网络设备 | 48口1/10G 交换机 | 满足主机接入 |

资源需求

| 虚机 | vCPU | 内存G | 存储G |

|---|---|---|---|

| vCenter vCSA | 4 | 19 | 200 |

| NSX-T Manger | 6 | 24 | 300 |

| NSX-T Edge | 8 | 32 | 200 |

IP地址规划

| 名称 | 地址段 | 备注 |

|---|---|---|

| NSX-T管理器 | 192.168.10.40-43/24 | 192.168.10.40为VIP |

| NSX-T Edge | 192.168.10.31-32/24 | |

| vCenter | 192.168.10.10/24 | GW 192.168.1.1 |

| vSAN | 192.168.130.0/24 | 本网段互通 |

| vMotion | 192.168.140.0/24 | 本网段互通 |

| VTEP IP Pool | 192.168.13.101-199/24 | 本网段互通 |

| WCP master | 192.168.101-105/24 | |

| Pod CIDR | 172.211.0.0/20 | 内部 |

| Services CIDR | 172.96.0.0/23 | 内部 |

| Ingerss CIDR | 172.208.0.0/23 | 外部可路由 |

| Egress CIDR | 172.206.0.0/24 | 外部可路由 |

| 外网接口 | 10.Y.X.1/28 | 对端10.Y.X.13 |

系统逻辑图

注1:NSX-T3.0在主机准备时除了可以沿用原有的自建nVDS以外,还可以使用vSphere建立的vDS(命名为CVDS),包括单独vDS和混用计算流量vDS两种情况。但是,WCP兼容集群必须至少配置了vSphere Distributed Switch 7.0 ,即CVDS。

注2:所有与VTEP相关的⽹络MTU必须⼤于等于1600

注3:所有组件同步NTP和统一DNS

注4:所有主机的ESXi管理端口使用单独千兆端口和单独标准交换机

注5:如果使用vSAN,其磁盘组版本要升级到11或以上。

安装过程

1.在主机上安装ESXi

2.安装vCenter

- 导入ova文件

- 开启虚机,登录https://hostname:5480对vcsa进行配置安装。

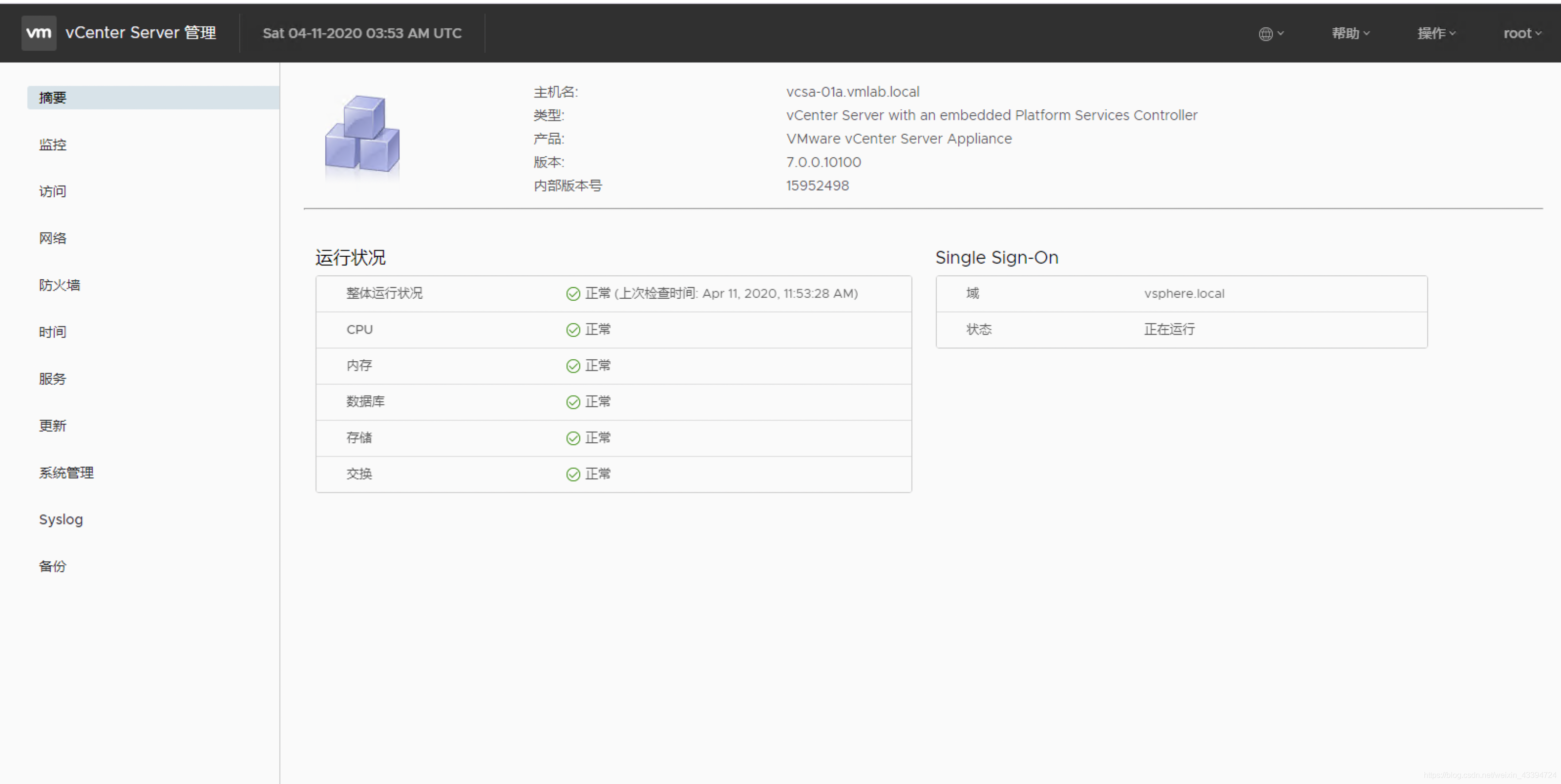

结束后页面:

- 再次登录https://hostname就可以进入vCenter管理界面了。配置好主机集群和存储。

- WCP在菜单->工作负载管理

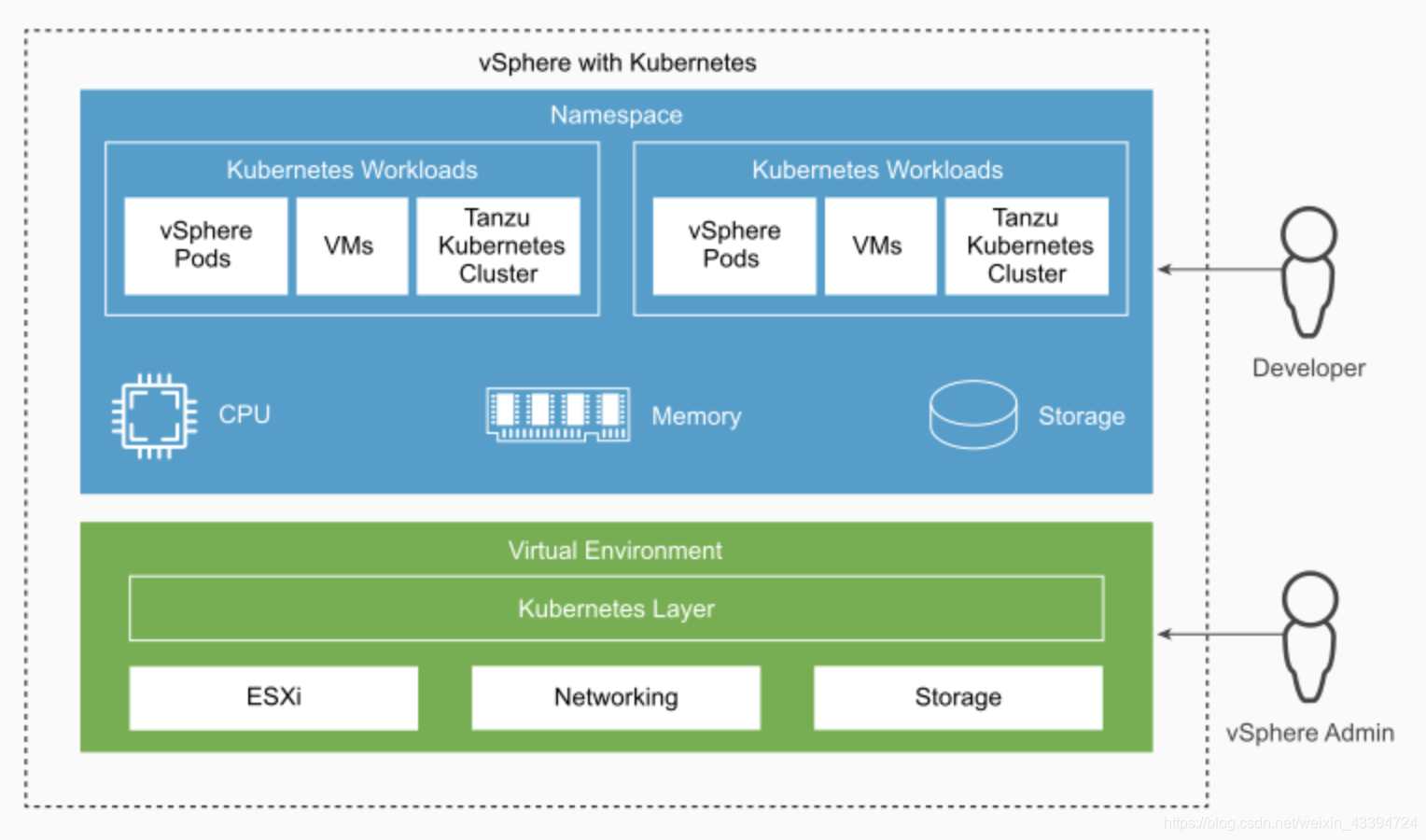

提示需要先安装NSX-T。此处需要了解几个概念:

提示需要先安装NSX-T。此处需要了解几个概念: - 工作负载:由在vSphere Pods、常规vm或两者组成的应用程序集合。

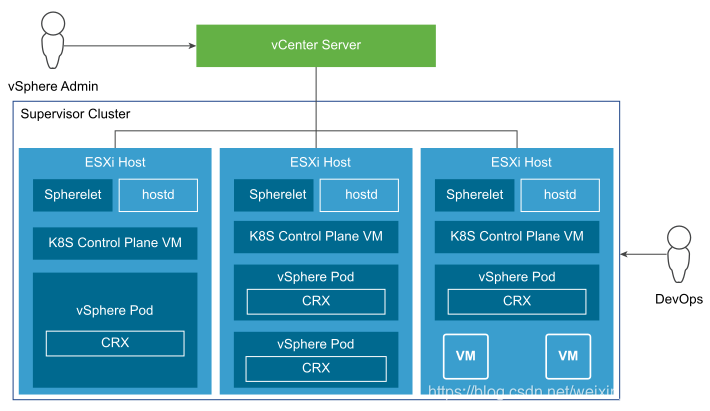

- Supervisor Cluster:为vSphere和Kubernetes启用的集群。

CRX:容器运行时执行程序(CRX)。从Hostd和vCenter服务器的角度来看,CRX类似于VM。CRX包括一个与hypervisor一起工作的半虚拟化Linux内核。CRX使用与VM相同的硬件虚拟化技术,并且有一个VM边界。这里使用了一种直接引导技术,它允许CRX的Linux客户端在不经过内核初始化的情况下初始化主init进程。这使得vSphere pod的启动速度几乎和容器一样快。在使用上,和原生POD的绝大多数命令一致。

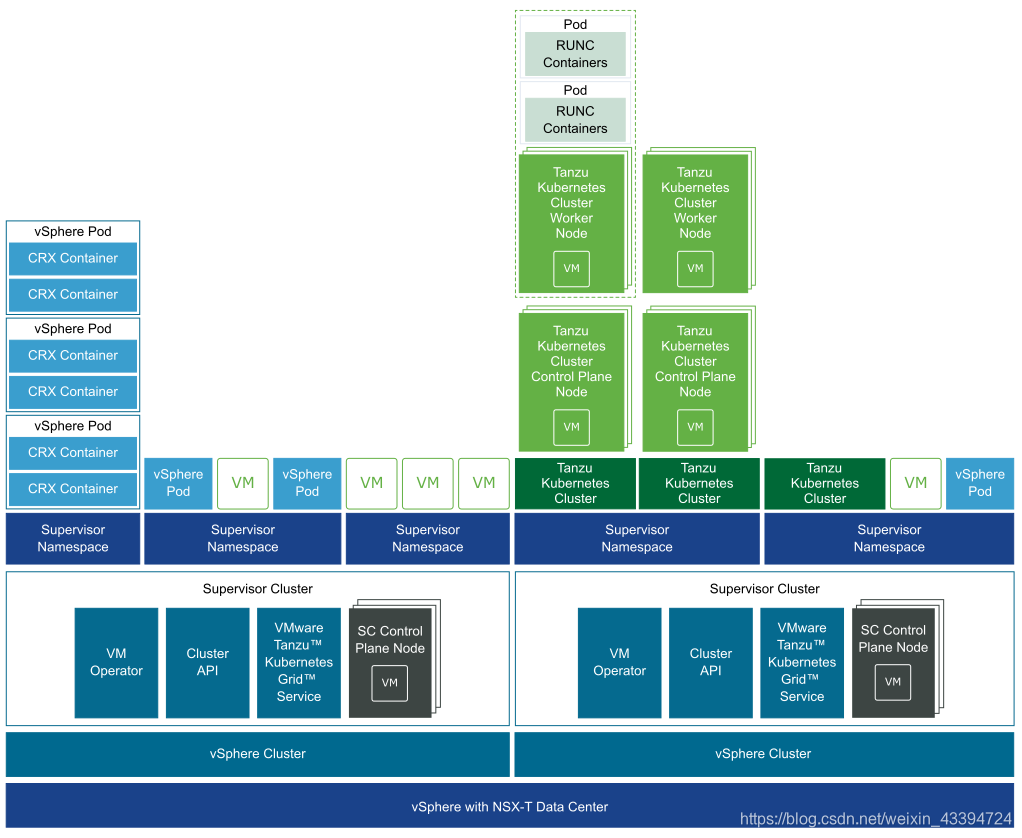

对于需要使用原生Kubernetes集群的需求,WCP平台使用Tanzu Kubernetes集群实现。 - Tanzu Kubernetes集群:是一个完整的开源Kubernetes软件的发行版,它由VMware打包、签名和支持。在Kubernetes的vSphere环境中,可以使用Tanzu Kubernetes网格服务在管理集群上提供Tanzu Kubernetes集群。通过使用kubectl和YAML定义,可以声明性地调用Tanzu Kubernetes网格服务API。

完整的vSphere with Kubernetes Architecture for Tanzu Kubernetes Clusters如下

3.安装NSX-T

按照上面对提示,安装并配置NSX-T。

-

导入OVA文件

-

运行NSX-T,登录。可以看到于2.5版本比较,首菜单去除了高级网络选项。

-

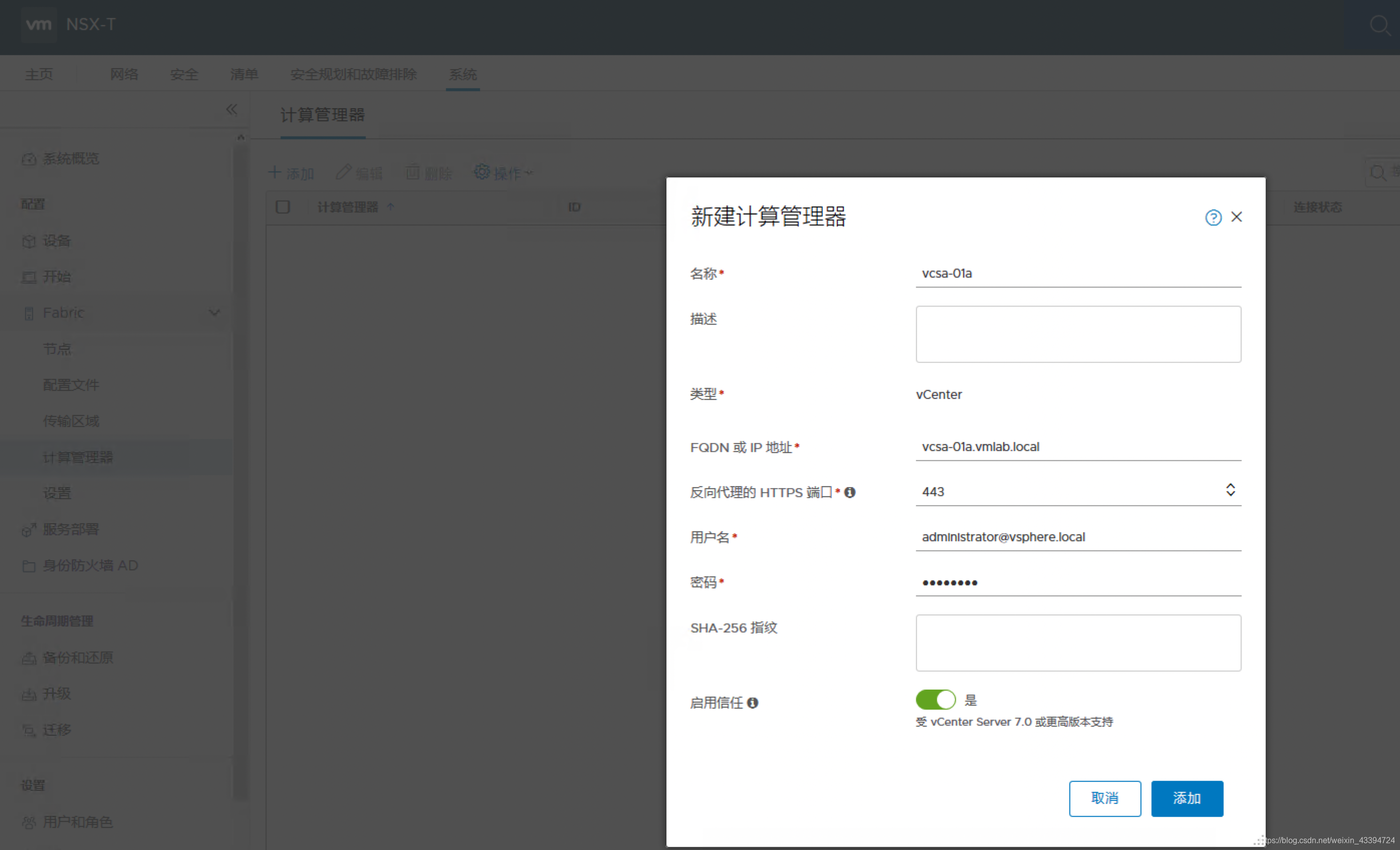

在NSX-T中注册VCSA,注意在此需要打开启用信任的按钮。

完成以后:

-

创建Transport Zones(不使用系统默认)

需要两个Transport Zones,分别是Overlay和VLAN的Transport Zones。 -

创建Host/Edge Uplink Profile,用于生成Host/Edge的Transport Node

-

创建VTEP使用的IP Pool

-

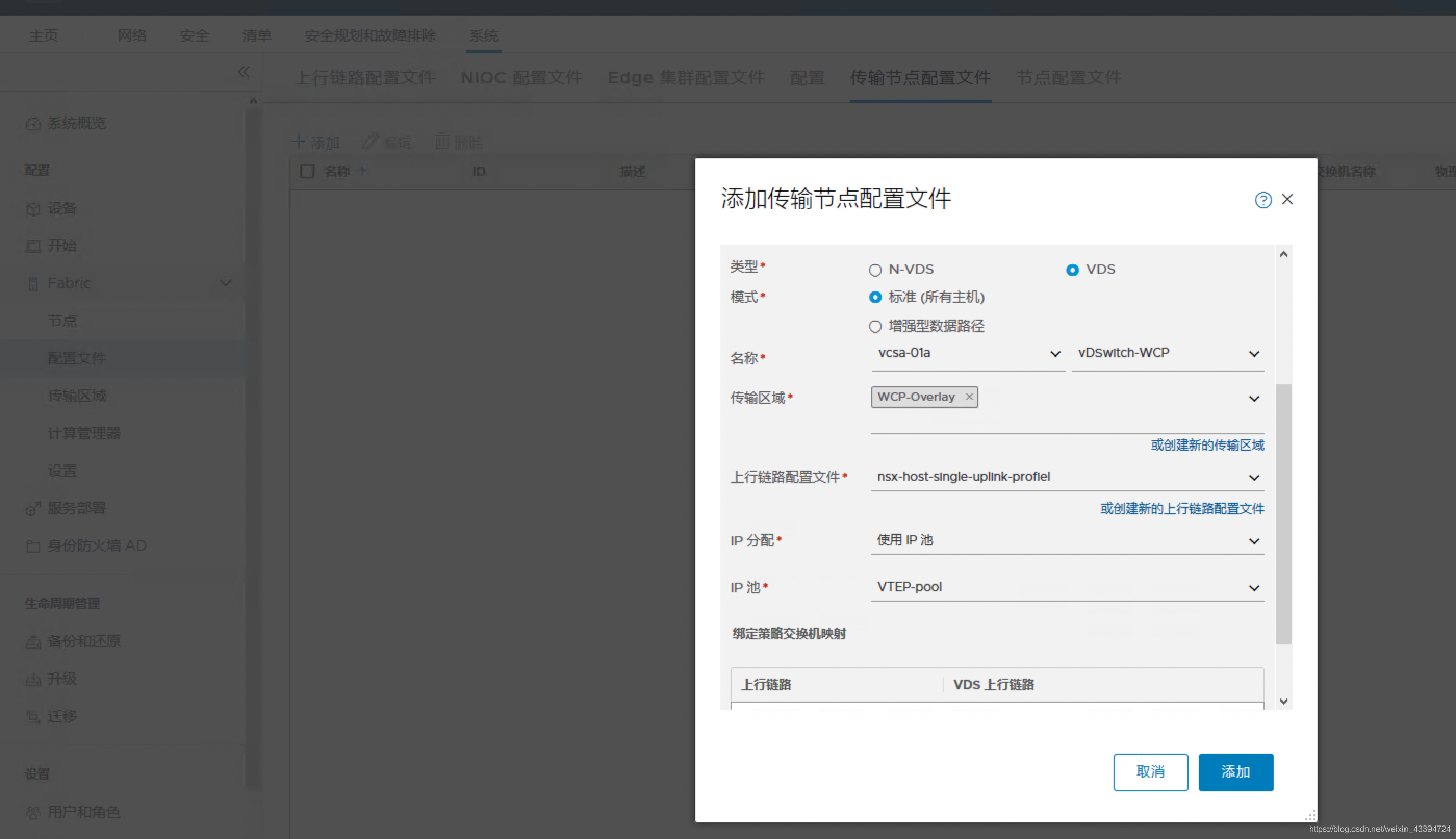

创建Transport Node Profile,注意选择vCenter建立vds作为Transport Node的交换机。

-

主机Transport Node准备

应用上一步创建的profile

-

添加Edge节点和Edge-Cluster,注意edge要创建两个交换机,分别用于Overlay和uplink vlan网络;由于edge是VM,所以要接在vCenter的vDS上,示例如下:

Name: nsxt-edge-01/2

Host name/FQDN: your edge fqdn

Form Factor: Large

Must provide CLI and Root Credentials

Enable SSH login for CLI and root to facilitate troubleshooting during beta

IP Assigment: Static

Management IP:

Default gateway:

Management Interface: vPG-management-10

Search domain names: optional, your DNS domain name

DNS Servers: your DNS server IP address

NTP Server: your NTP IP or fqdn

New Node Switch:

Edge Switch Name: overlay-switch

Transport Zone: nxs-overlay-tz

Uplink Profile: wcp-edge-uplinkprofile

IP Assignment: Use IP Pool

IP Pool: VTEP Pool

uplink1 - vPG-edge-overlay

New Node Switch:

Edge Switch Name: vlan-switch

Transport Zone: nsx-vlan-tz

Uplink Profile: wcp-t0-uplinkprofile

uplink1 - vPG-edge-vlan

Select “Finish”

建好的edge和cluster:

-

创建T0上联使用的分段(ls逻辑交换机)

-

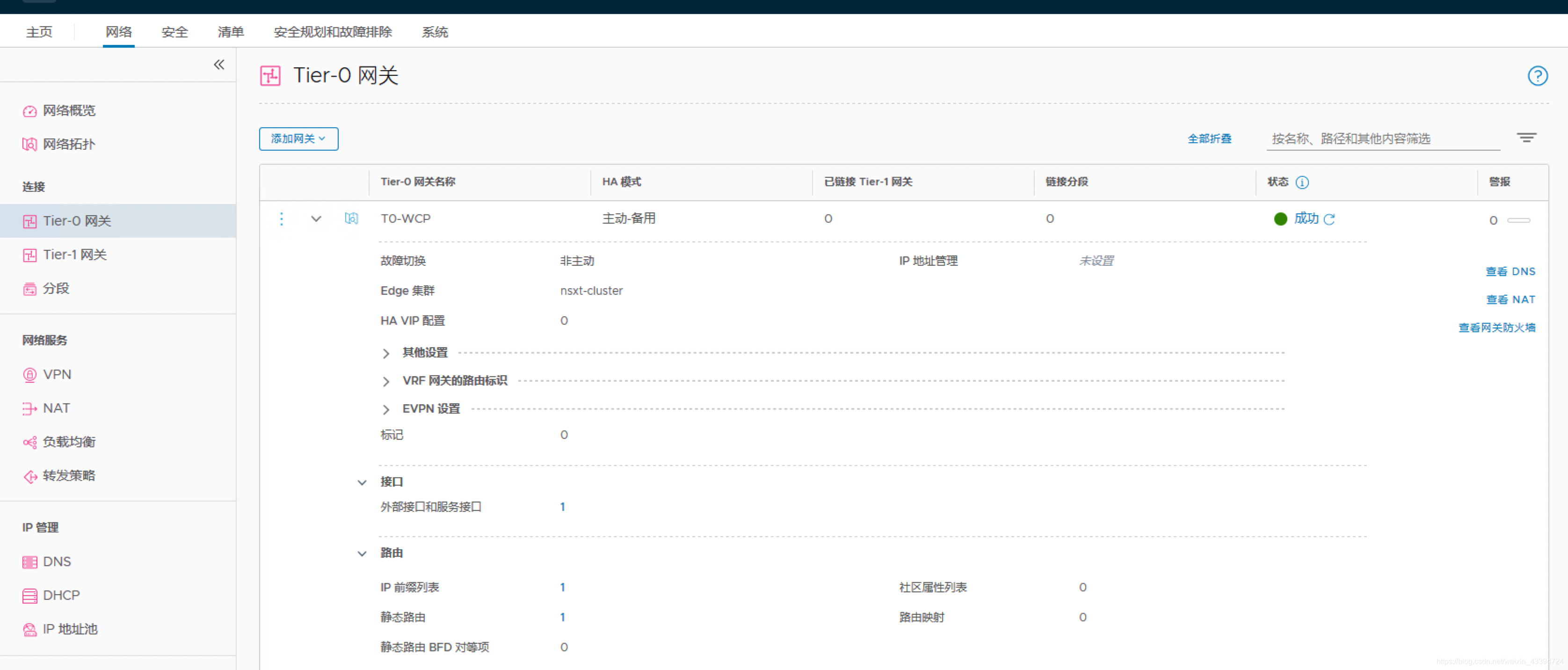

创建T0路由器

配置好出端口的IP地址和全网段静态路由(T0也支持BGP)

-

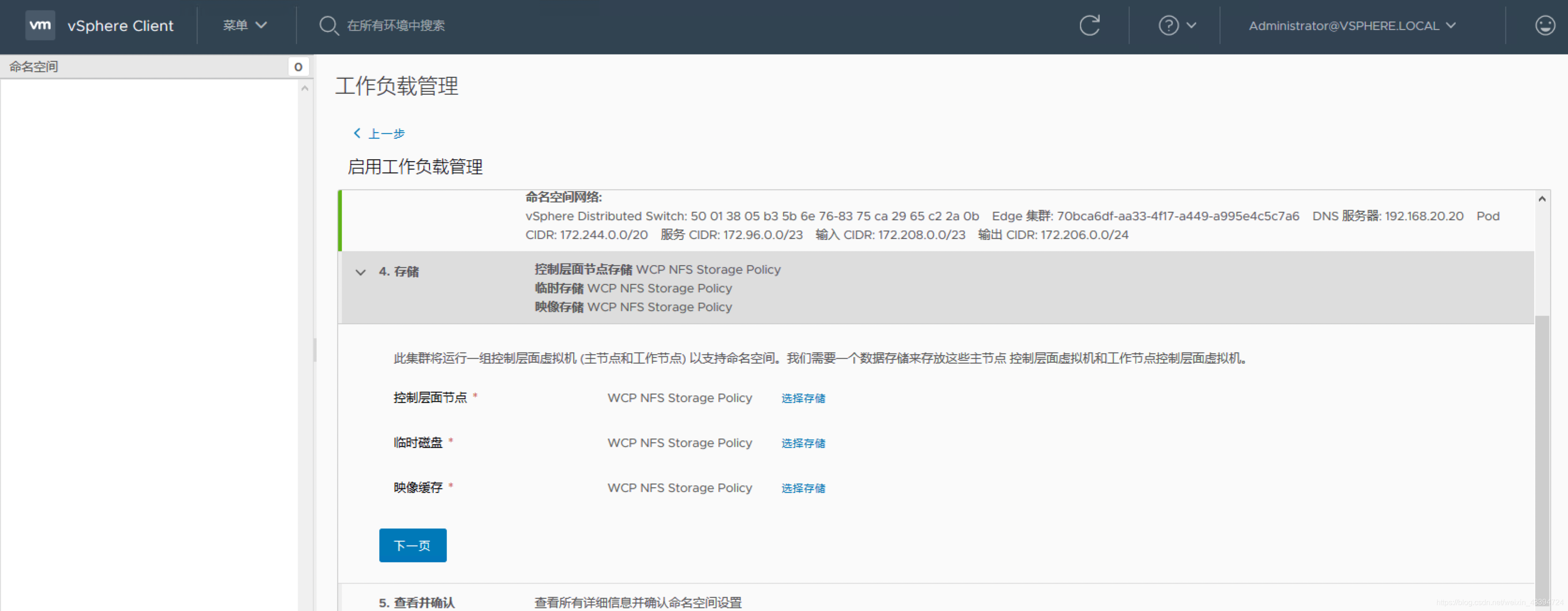

在vcsa上面创建Storage Profiles

路径:Menu→ Policies and Profiles → VM Storage Policies, Create VM Storage Policy

其中使用的tag要提前分配好 -

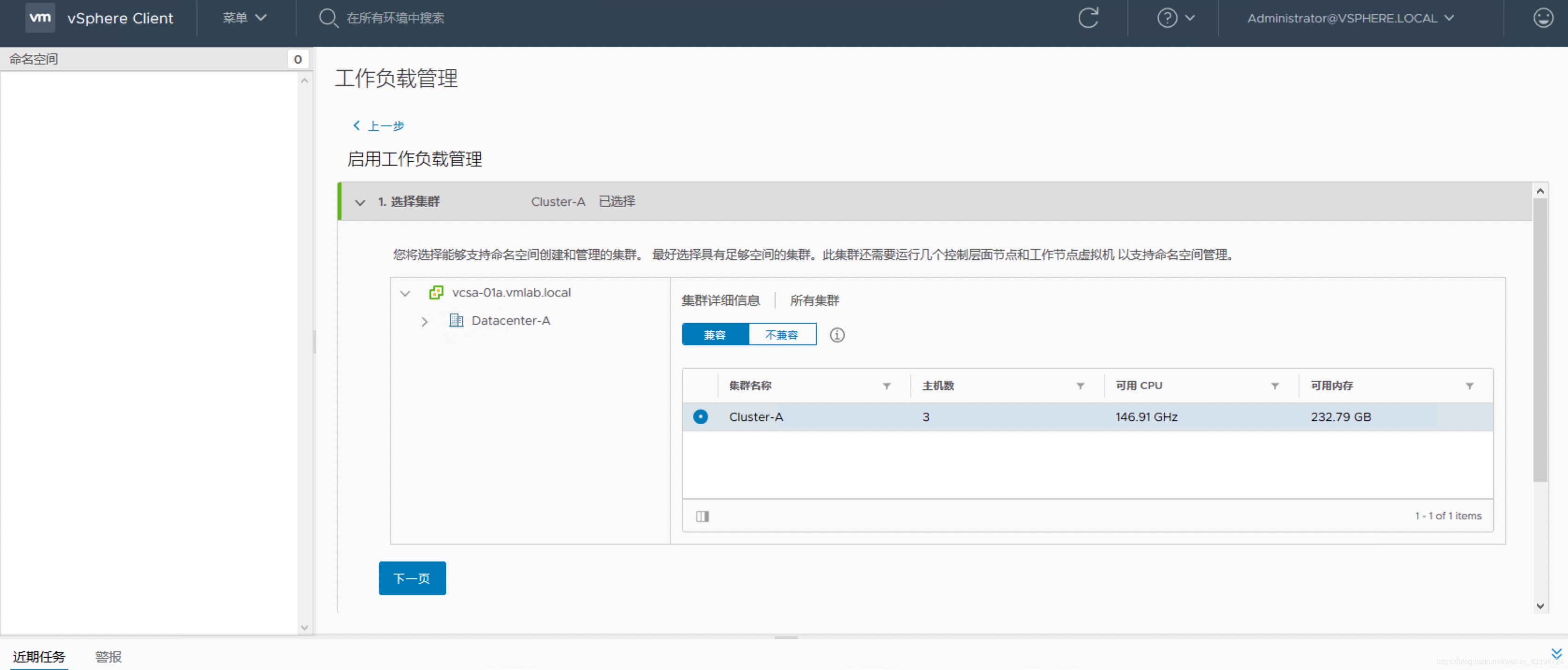

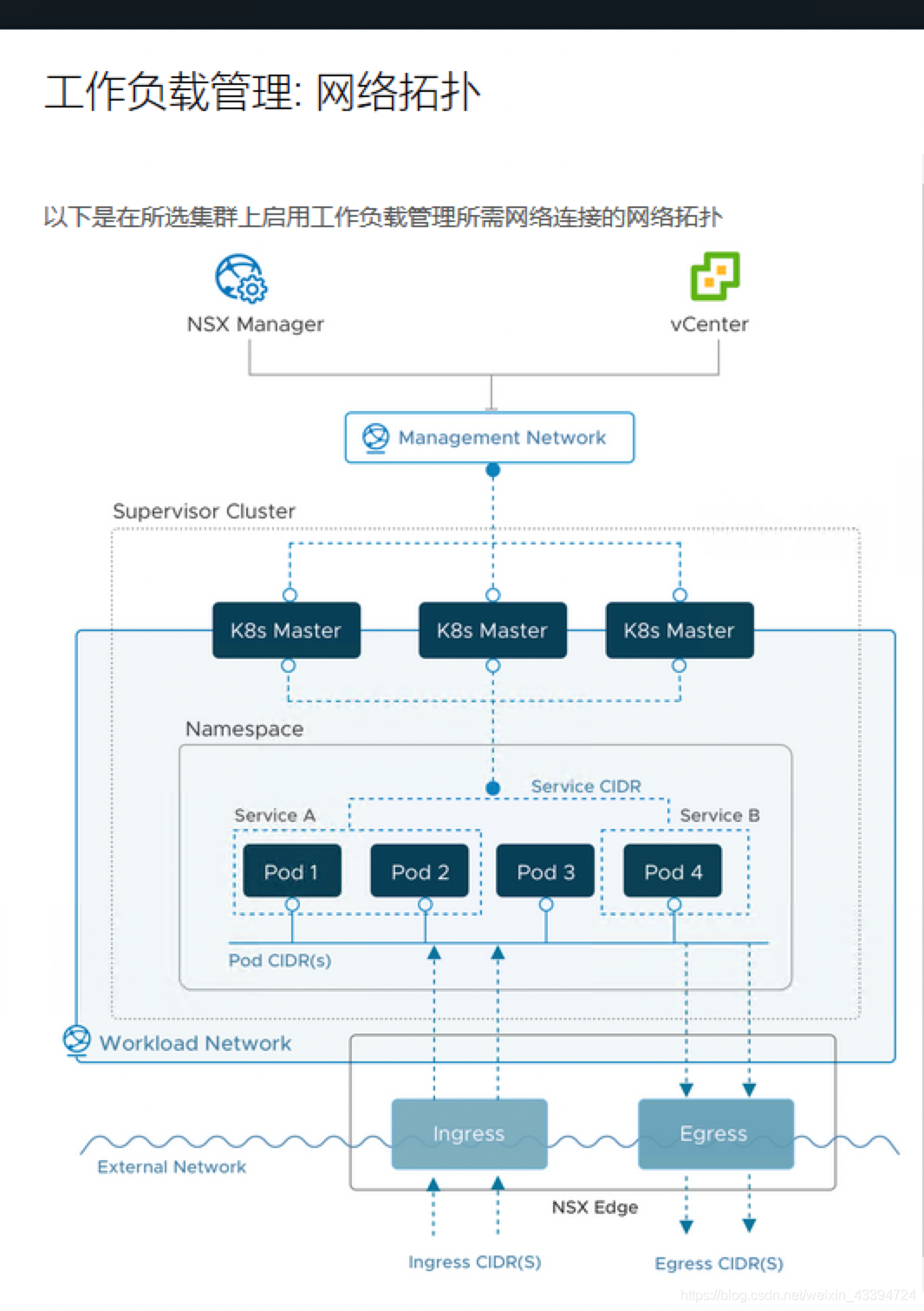

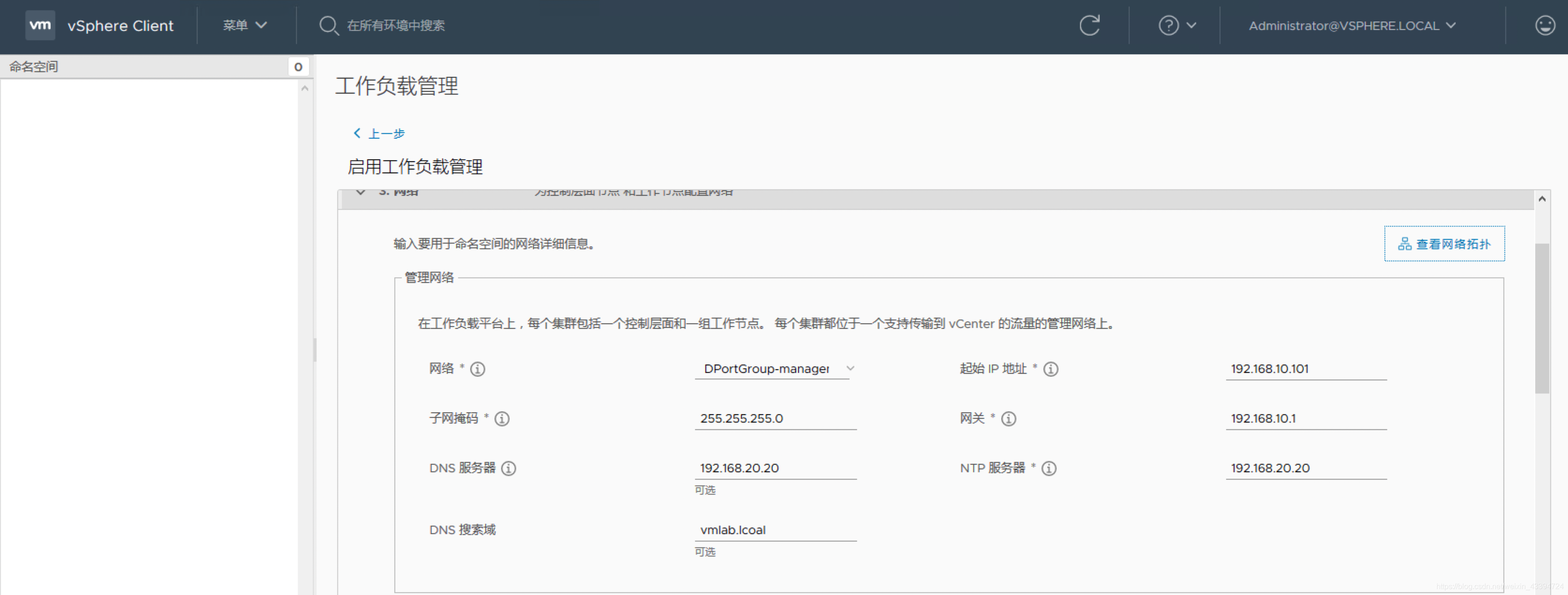

在计算集群启用WCP

- Pod CIDR:将从中为 Pod 分配 IP 的内部 CIDR 块。它们不能与工作负载管理 组件 (VC、NSX、ESX、Management DNS、NTP) 的 IP 重叠,也不应与用来 与 Pod 通信的其他数据中心 IP 重叠。

- Service CIDR:将从中为 Kubernetes ClusterIP 服务分配 IP 的内部 CIDR 块。它们不能与工作负载管理 组件 (VC、NSX、ESX、Management DNS、NTP) 的 IP 重叠, 也不应与用来与 Pod 通信的其他数据中心 IP 重叠。

- Ingess CIDR:将从中为 Kubernetes Ingress 和 LoadBalancer 类型的服务 分配 IP 的外部 CIDR 块。这些 CIDR 将来自外部网络的 IP 空间。 Supervisor Kubernetes 控制层面将为每个命名空间分配 1 个公用 Kubernetes Ingress IP (同一命名空间中的所有 Ingress 共享一个公用 IP), 为每个 LoadBalancer 类型的服务分配 1 个 IP (每个 Kubernetes LoadBalancer 类型的服务均分配有一个唯一 IP)。

- Egress CIDR:将用于通过 SNAT 规则将内部 Pod IP 转换为外部 IP 的外部 CIDR 块, 以允许 Pod 访问外部网络。这些 CIDR 应来自外部网络的 IP 空间。 Supervisor Kubernetes 控制层面将为每个命名空间 分配 1 个输出 IP。

网络拓扑如下

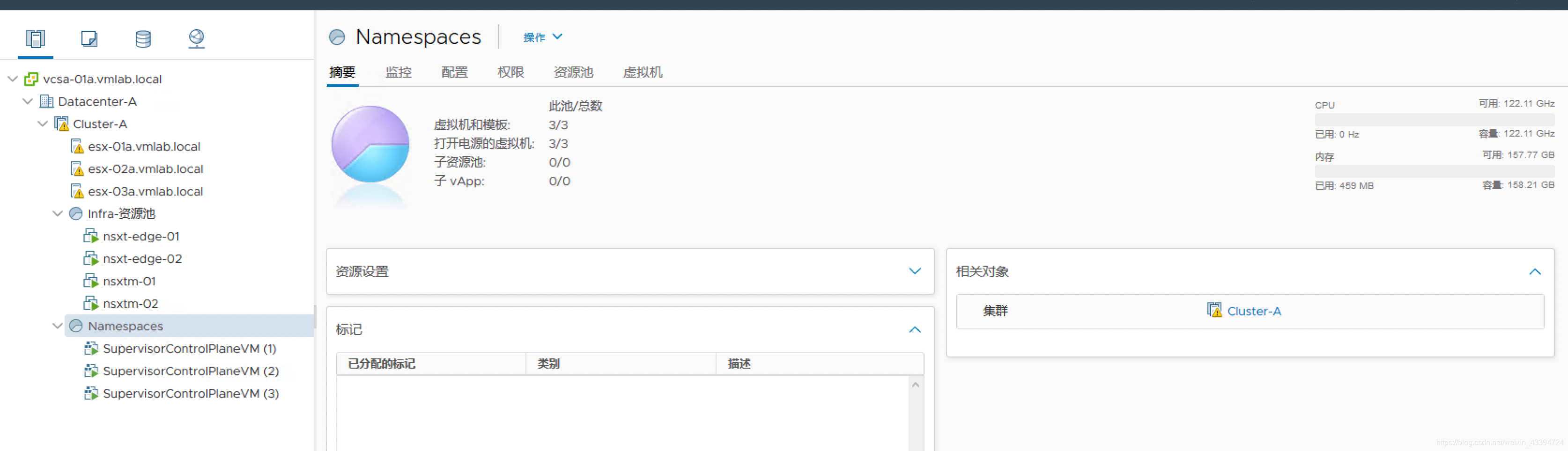

整个启用过程需要40-50分钟,成功以后在工作负载的界面可以看到

可以看到k8s的版本是v1.16.7.

在主机和虚机界面可以看到三台master节点

自此,WCP平台安装成功,系统可以创建Namespace了。