1. 简介

隐马尔可夫模型(HMM)是关于时序的概率模型。假设我们有三种骰子(A、B、C),每种骰子都有6面,但是这三种骰子不都是均匀的,即骰子出现数字1-6的概率不同,这三种骰子每个都有自己的概率分布且三者概率分布不同。现假设我们掷了5次,选择的骰子为o = [A,C,B,A,C];出现的数字分别是n = [1,3,2,3,1],我们称n为观测序列,因为是我们可以用眼睛看到的,o为隐藏序列,因为我们不知道用哪个骰子掷出了n这个观测序列。(掷骰子时,只告诉了我们结果,没告诉我们过程)HMM模型包含了观测序列和隐藏序列。

2. 定义

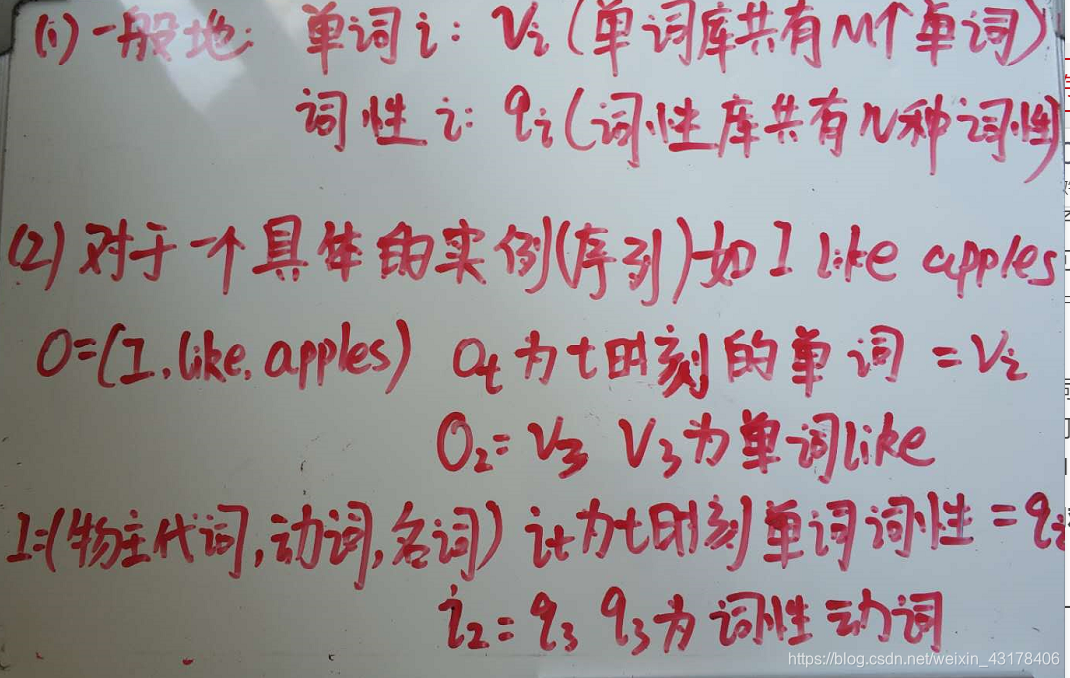

上文大概介绍了HMM,现以词性标注为例。我们能看到的是给出的一句话,看不到的是这句话每个单词对应的词性。假设句子I like apples。我们的观测序列就是I like apples,隐藏序列(也称为状态序列)就是其词性[物主代词,动词,名词]。HMM涉及的各种符号如下:

以上7个符号对照词性标注案例进行讲解

- 在词性标注中,观测序列是由单词构成的句子,那么词库有多少单词呢?由M表示,即词库里一共有M个单词,其中单词i可表示成 v i v_i vi,如I表示成 v 1 v_1 v1,like可表示成 v 2 v_2 v2,因此V就是所有单词的集合: V = v 1 , v 2 , . . . v M V={v_1,v_2,...v_M} V=v1,v2,...vM。重点记忆:词库中单词总数为M,单词i为 v i v_i vi

- 隐藏序列(状态序列)就是观测序列对应的词性序列,那么我们词库里的单词一共有多少种词性呢?由N表示,其实词性i可表示成 q i q_i qi, Q = q 1 , q 2 , . . . q N Q={q_1,q_2,...q_N} Q=q1,q2,...qN就是词性的集合。重点记忆:词性的种类数为N,词性i为 q i q_i qi

- 对于一个实例,就比如I like apples,其可用观测序列O表示,该句话对应的词性序列可用I表示,此时T为3

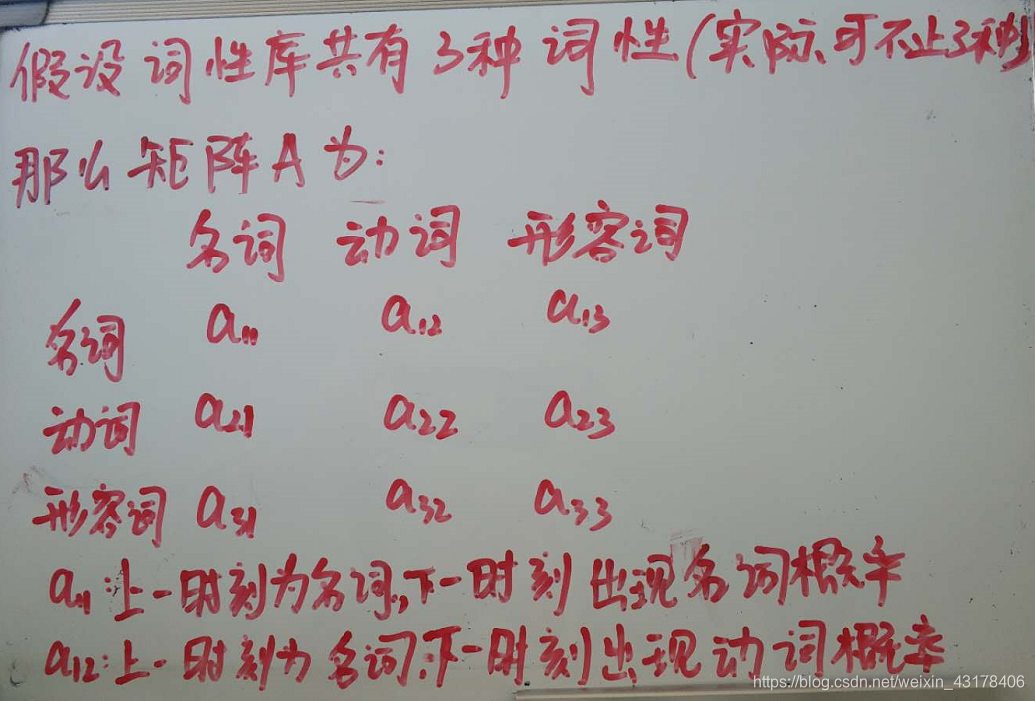

- 一般的,假如一开始出现的单词词性为名词,那么下一个单词出现动词的概率为多少?出现名词的概率呢?如果一开出现的是动词,那么下一个单词出现动词的概率为多少?出现名词的概率呢?这一过程可以由N*N的矩阵表示,矩阵index代表的是词性库中所有的词性,columns也是词性库中所有的词性,如下图所示:

故 a i j a_{ij} aij表示为t时刻单词词性(用 i t i_t it表示)为 q i q_i qi时,t+1时刻单词词性(用 i t + 1 i_{t+1} it+1表示)为 q j q_j qj的概率 - 一般的,假如知道单词词性为名词,那么他对应的单词是什么呢?apple还是banana,或是其他。

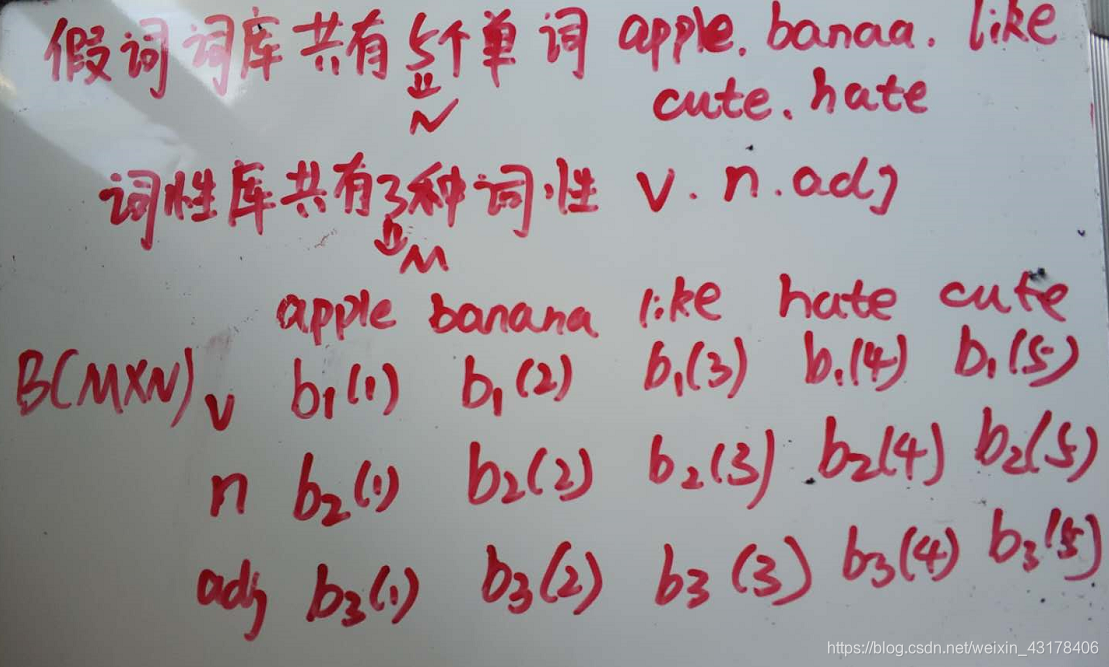

b 1 ( 2 ) b_1(2) b1(2):时刻t时,词性为动词,其对应的单词为banana的概率

b j ( k ) b_j(k) bj(k):时刻t时,词性( i t i_t it)为 q j q_j qj,其对应的单词为 o t o_t ot为 v k v_k vk的概率 - π i π_i πi为时刻t等于1时,单词的词性( i 1 i_1 i1)为 q i q_i qi的概率,举个例子,还是I like apples,t=1时刻即I这个单词,π=(I这个单词的词性为物主代词的概率,为名词的概率,为动词的概率,…)故π其实就是第一个单词为各种词性的概率构成的集合。其实π也可以理解为一种特殊的转移矩阵,即从词性0转移到词性名词的概率,从词性0转移到词性动词的概率。

- λ \lambda λ即马尔科夫的三元素,也即参数,用三元符号表示 λ = ( A , B , π ) \lambda=(A,B,\pi) λ=(A,B,π)

3. HMM假设条件

3.1 齐次马尔科夫假设

描述:任意时刻t的状态只依赖于前一时刻的状态,与其他时刻状态及观测无关,(注意这里的状态就是隐藏状态,观测就是观测值)。应用到HMM模型即t时刻的词性只与前一时刻的词性有关

P ( i t ∣ i t − 1 ) P(i_t|i_{t-1}) P(it∣it−1)正是由于该假设,我们才得到了状态转移矩阵A

3.2 观测独立性假设

任意时刻的观测只依赖于该时刻的马尔科夫链状态,与其他观测及状态无关。应用到HMM即t时刻的观测值至于t时刻的词性有关

P ( o t ∣ i t ) P(o_t|i_{t}) P(ot∣it)正是由于该假设,我们才得到了发射矩阵B

3.3 马尔科夫经典图

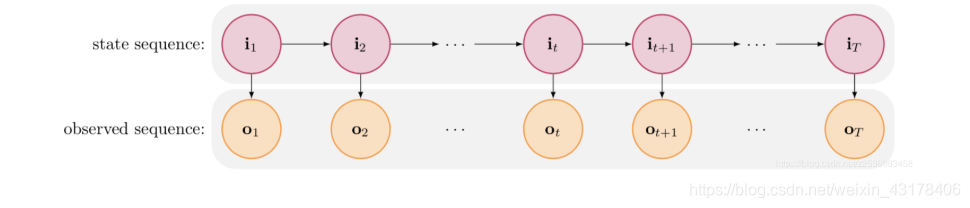

正是由于上述两个假设,得到我们经常看到的一张图:

从图可以看到 i t + 1 i_{t+1} it+1依赖于 i t i_{t} it,

o t o_{t} ot依赖于 i t i_{t} it

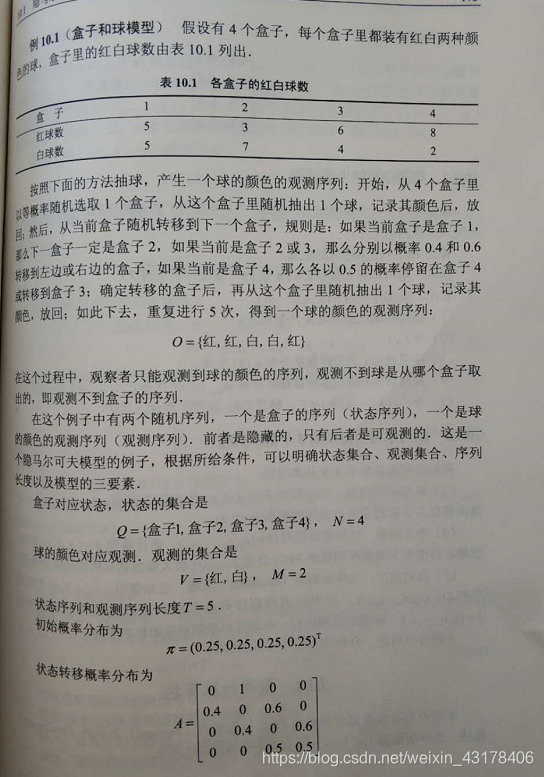

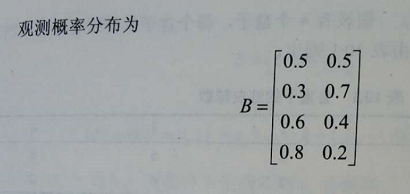

4. HMM实例

此案例来自小蓝书

5. HMM的3个基本问题

- 1.概率计算问题:

- 给定模型参数 λ = ( A , B , π ) \lambda=(A,B,\pi) λ=(A,B,π),和观测序列O,计算在模型在 λ \lambda λ下观测序列O出现的概率 P ( O ∣ λ ) P(O|\lambda) P(O∣λ),前后向算法

- 2.参数估计问题(估计模型参数 λ \lambda λ,分为两种情况):

- 2.1已知观测序列和和隐藏序列,求 λ \lambda λ,即 P ( λ ∣ O , I ) P(\lambda|O,I) P(λ∣O,I),用极大似然估计

- 2.2仅已知观测序列O,求 λ \lambda λ, 即 P ( λ ∣ O ) P(\lambda|O) P(λ∣O)

- 3.预测问题/推理问题/decoding:

- 已知O和 λ \lambda λ,求I,即 P ( I ∣ O , λ ) P(I|O,\lambda) P(I∣O,λ),维特比算法