目录

1.1.3 同现关系(Relations of Co-occurence)

2.1.3 实体特征 Basic entity features

经典论文:Efficient Estimation of Word Representations in Vector Space

Distributed Representations of Words and Phrases and their Compositionality

Linguistic Regularities in Continuous Space Word Representations [Mikolov &al.2013]

Semantic Compositionality through Recursive Matrix-Vector Spaces

Relation Classification via Convolutional Deep Neural Network [Zeng&al., 2014]

Classifying relations by ranking with convolutional neural networks.

0 前言:

- 关系抽取简介

- 语义关系

- 关系抽取中的特征

- 关系抽取数据集

- 基于模板的关系抽取

- 有监督实体关系抽取

- 弱监督实体关系抽取

- 远程监督实体关系抽取

- 无监督实体关系抽取

- 基于深度学习的关系抽取

1 语义关系:

是指隐藏在句法结构后面由词语的语义范畴建立起来的关系,其中各种详尽的语义关系建议对照着PPT进行查看(其实也就是我们认为的语法的问题)。同时具有一定的发展历史,所以这部分不在这里叙述。本篇文重点在于讲解机器学习下的关系提取

1.1 句法关系

位置关系( relation of positioin)

替代关系( relations of substitutability )

同现关系( relations of co-occurrence)

1.1.1 替代关系

1.1.3 同现关系(Relations of Co-occurence)

2 关系抽取的用处

- 构建知识库文本分析NLP应用

- 信息抽取

- 信息检索.

- 自动摘要

- 机器翻译

- 问答

- 释义

- 文本蕴涵推理

- 叙词表构建出 语义网络构建

- 词义消岐

- 语言建模

2.1 关系抽取中的特征

2.1.1 学习语义关系的方法

监督学习

-

优点:表现很好

- 缺点:需要大量标记数据和特征表示

无监督学习

- 优点:可扩展,适用于开放式信息提取

- 缺点:表现比较差

2.1.2 特征

目的:将数据映射为实体特性和关系特性

2.1.3 实体特征 Basic entity features

基本实体特征包括每个候选参数的字符串值以及标记这些参数的单个单词,可能是词形化或词干化

例如:

字符串值\单独的词、词形话或者词干化

- 优点:在大多数情况下,这样的特征对于一个良好的关系是信息足够的

- 缺点:这样的特征倾向于比较稀疏

Background entity features

- 句法信息,例如:语法角色

- 语义信息,例如:语义类别

可能使用特定任务的清单,如: ACE entity types

可能使用一般化的词汇资源,如: WorldNet

- 优点:解决了数据的稀疏性问题

- 缺点:需要人工的资源

- 优点:可以通过聚合一个词与在大文本集合中与所有其它词的交互来捕获它的含义。

- 缺点:会把不同的含义混杂在一起

2.1.4 关系特征

- 直接对关系进行表征,

- 例如对实体的上下文进行建模。

- 在两个参数之间的单词

- 处于参数的特定窗口或者一侧的单词

- 链接参数的依赖路径

- 一个完整的依赖图

- 最小支配子树

Background relational features

- 编码关于实体通常是如何交互的知识,而不仅仅是上下文

- 通过释义进行关系表征

- 占位符模式

- 通过聚类寻找相似上下文

3 关系抽取数据集

3.1 语义关系学习的标注数据

FewRel在去年的EMNLP2018上,由孙茂松教授领导的清华大学自然语言处理实验室发布的一个大规模精标注关系抽取数据集。以Wikipedia作为语料库,以Wikidata作为知识图谱构建的包含100个类别、70,000个实例,全面超越了以往的同.类精标注数据集。

意义:

应用在经典的监督/远程监督关系抽取任务中在新兴的少次学习(few-shot learning)任务上也有极大的探索价值和广阔的应用前景

3.2 基于模板的实体关系抽取

3.2.1 基于模板的方法

- 使用模式(规则)挖掘关系,基于触发词/字符串等。

- 基于依存句法

- 关系挖掘模式

Hearst的模式清单

基于依存句法

优点:

- 人工规则有 高准确率(high-precision)

- 可以为特定领域定制(tailor)

- 在小规模数据集_上容易实现,构建简单

缺点:

- 低召回率(low-recall)

- 特定领域的模板需要专家构建,要考虑周全所有可能的pattern很

- 难,也很费时间精力

- 需要为每条关系来定义pattern

- 难以维护

- 可移植性差

4 有监督实体关系的提取

- 基于特征向量的方法---从上下文信息、词性、语法等中抽取一系列特征

- 核分类关系特征---可能拥有复杂的结构

- 序列标注方法---关系中参数的跨度是可变的。

4.1 基于特征向量的方法

4.2 核分类

5 弱监督实体关系抽取

5.1 Bootstrapping

语义漂移示例

5.2 Label Propagation

5.2 Label Propagation

方法

5.3 协同(Co-learning)方法

基本流程:

-

选择2个不同的分类器,

- 使用相互独立的特征在2个训练集上训练,并分别在未标注集上测试

- 选取置信度高的实例扩展到另一个分类器的训练集中

- 如此迭代若干次,当精度达到阈值时停止。

6 远程监督实体关系抽取

6.1 远程监督

7 无监督实体关系抽取

8 基于深度学习的关系抽取

词嵌入

是什么?

●映射单词到一个实值的低维空间向量

如何做?

- neural networks (e.g., CBOW, skip-gram) [Mikolov&al.2013a]

- dimensionality reduction (e.g., LSA, LDA, PCA)

- explicit representation (words in the context)

我们为什么要关注它?

词嵌入对很多NLP任务都很重要,包括关系抽取

8.1 词嵌入-神经网络 NMLM模型

经典论文:Efficient Estimation of Word Representations in Vector Space

本文是word2vec的第一篇,提出了CBOW和Skip-gram两大模型

8.1.1 CBOW

框架:

CBOW所要做的就是利用一个单词前后

的单词,称为其上下文,context来预测它.

8.1.2 Skip-gram模型

看上去与CBOW正好相反,它接受一个单词,作为输入,预测在其上下文中的单词们.文中提到,增大contextwindow能提升word vector的质量.

Distributed Representations of Words and Phrases and their Compositionality

本文是word2vec的第二板斧,提出了一些提升的技巧

Skip-gram:

projection with PCA

Skip-gram的性质:

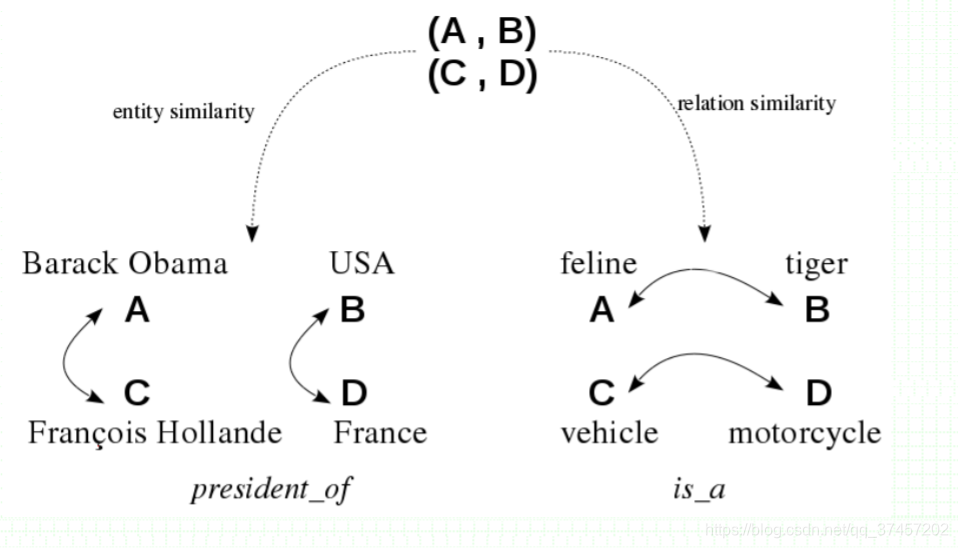

词嵌入具有线性结构,可以实现与矢量算术的类比.由于训练目标,输入和输出(在softmax之前)是具有线性关系

Linguistic Regularities in Continuous Space Word Representations [Mikolov &al.2013]

这篇文章主要就是介绍词向量支持基本代数运算的特性,并利用这一特性将之应用到SemEval 2012 Task来衡量

此论文中的词向量是通过RNNLM学习得来。

s(t)= f(Uw(t) + Ws(t-1))

Semantic Compositionality through Recursive Matrix-Vector Spaces

MV-RNN: Matrix-Vector R NN

本文的模型为解析树中的每个节点分配了一个向量和一个矩阵:

- 向量捕获了成分的内在意义

- 矩阵则捕获了它如何改变相邻单词或短语的意义

实验结果(使用的是SemEva1-2010 Task 8的数据集和评测)

Relation Classification via Convolutional Deep Neural Network [Zeng&al., 2014]

实验结果

Classifying relations by ranking with convolutional neural networks.