一、猫狗大战数据集

Cats vs. Dogs(猫狗大战)是Kaggle大数据竞赛某一年的一道赛题,利用给定的数据集,用算法实现猫和狗的识别。

数据集可以从Kaggle官网上下载:

https://www.kaggle.com/c/dogs-vs-cats

数据集由训练数据和测试数据组成,训练数据包含猫和狗各12500张图片,测试数据包含12500张猫和狗的图片。

为了以后查阅时不用翻视频(优酷广告真心长=.=),这里把视频里的内容重写一下,也当做是复习。

二、TensorFlow的实现

我电脑配的环境是win10(64位) + Python3.5.3 + CUDA 8.0 + cudnn 5.1 + tensorflow-gpu 1.1.0 + Pycharm。

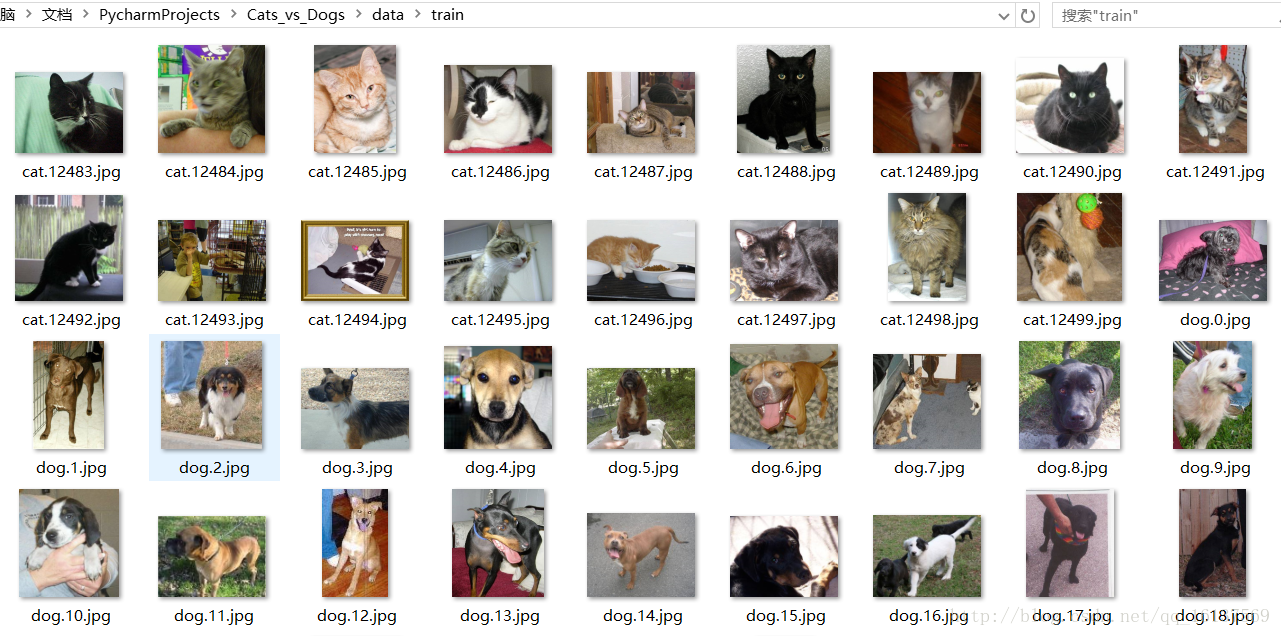

首先在Pycharm上新建Cats_vs_Dogs工程,工程目录结构为:

data文件夹下包含test和train两个子文件夹,分别用于存放测试数据和训练数据,从官网上下载的数据直接解压到相应的文件夹下即可logs文件夹用于存放我们训练时的模型结构以及训练参数input_data.py负责实现读取数据,生成批次(batch)model.py负责实现我们的神经网络模型training.py负责实现模型的训练以及评估

接下来分成数据读取、模型构造、模型训练、测试模型四个部分来讲。源码从文章末尾的链接下载。

1. 训练数据的读取——input_data.py

import tensorflow as tf

import numpy as np

import os- 1

- 2

- 3

首先是导入模块。

tensorflow和numpy不用多说,其中os模块包含操作系统相关的功能,可以处理文件和目录这些我们日常手动需要做的操作。因为我们需要获取test目录下的文件,所以要导入os模块。

# 获取文件路径和标签

def get_files(file_dir):

# file_dir: 文件夹路径

# return: 乱序后的图片和标签

cats = []

label_cats = []

dogs = []

label_dogs = []

# 载入数据路径并写入标签值

for file in os.listdir(file_dir):

name = file.split(sep='.')

if name[0] == 'cat':

cats.append(file_dir + file)

label_cats.append(0)

else:

dogs.append(file_dir + file)

label_dogs.append(1)

print("There are %d cats\nThere are %d dogs" % (len(cats), len(dogs)))

# 打乱文件顺序

image_list = np.hstack((cats, dogs))

label_list = np.hstack((label_cats, label_dogs))

temp = np.array([image_list, label_list])

temp = temp.transpose() # 转置

np.random.shuffle(temp)

image_list = list(temp[:, 0])

label_list = list(temp[:, 1])

label_list = [int(i) for i in label_list]

return image_list, label_list- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

函数get_files(file_dir)的功能是获取给定路径file_dir下的所有的训练数据(包括图片和标签),以list的形式返回。

由于训练数据前12500张是猫,后12500张是狗,如果直接按这个顺序训练,训练效果可能会受影响(我自己猜的),所以需要将顺序打乱,至于是读取数据的时候乱序还是训练的时候乱序可以自己选择(视频里说在这里乱序速度比较快)。因为图片和标签是一一对应的,所以要整合到一起乱序。

这里先用np.hstack()方法将猫和狗图片和标签整合到一起,得到image_list和label_list,hstack((a,b))的功能是将a和b以水平的方式连接,比如原来cats和dogs是长度为12500的向量,执行了hstack(cats, dogs)后,image_list的长度为25000,同理label_list的长度也为25000。接着将一一对应的image_list和label_list再合并一次。temp的大小是2×25000,经过转置(变成25000×2),然后使用np.random.shuffle()方法进行乱序。

最后从temp中分别取出乱序后的image_list和label_list列向量,作为函数的返回值。这里要注意,因为label_list里面的数据类型是字符串类型,所以加上label_list = [int(i) for i in label_list]这么一行将其转为int类型。

# 生成相同大小的批次

def get_batch(image, label, image_W, image_H, batch_size, capacity):

# image, label: 要生成batch的图像和标签list

# image_W, image_H: 图片的宽高

# batch_size: 每个batch有多少张图片

# capacity: 队列容量

# return: 图像和标签的batch

# 将python.list类型转换成tf能够识别的格式

image = tf.cast(image, tf.string)

label = tf.cast(label, tf.int32)

# 生成队列

input_queue = tf.train.slice_input_producer([image, label])

image_contents = tf.read_file(input_queue[0])

label = input_queue[1]

image = tf.image.decode_jpeg(image_contents, channels=3)

# 统一图片大小

# 视频方法

# image = tf.image.resize_image_with_crop_or_pad(image, image_W, image_H)

# 我的方法

image = tf.image.resize_images(image, [image_H, image_W], method=tf.image.ResizeMethod.NEAREST_NEIGHBOR)

image = tf.cast(image, tf.float32)

# image = tf.image.per_image_standardization(image) # 标准化数据

image_batch, label_batch = tf.train.batch([image, label],

batch_size=batch_size,

num_threads=64, # 线程

capacity=capacity)

# 这行多余?

# label_batch = tf.reshape(label_batch, [batch_size])

return image_batch, label_batch- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

函数get_batch()用于将图片分批次,因为一次性将所有25000张图片载入内存不现实也不必要,所以将图片分成不同批次进行训练。这里传入的image和label参数就是函数get_files()返回的image_list和label_list,是python中的list类型,所以需要将其转为TensorFlow可以识别的tensor格式。

这里使用队列来获取数据,因为队列操作牵扯到线程,我自己对这块也不懂,,所以只从大体上理解了一下,想要系统学习可以去官方文档看看,这里引用了一张图解释。

我认为大体上可以这么理解:每次训练时,从队列中取一个batch送到网络进行训练,然后又有新的图片从训练库中注入队列,这样循环往复。队列相当于起到了训练库到网络模型间数据管道的作用,训练数据通过队列送入网络。(我也不确定这么理解对不对,欢迎指正)

继续看程序,我们使用slice_input_producer()来建立一个队列,将image和label放入一个list中当做参数传给该函数。然后从队列中取得image和label,要注意,用read_file()读取图片之后,要按照图片格式进行解码。本例程中训练数据是jpg格式的,所以使用decode_jpeg()解码器,如果是其他格式,就要用其他解码器,具体可以从官方API中查询。注意decode出来的数据类型是uint8,之后模型卷积层里面conv2d()要求输入数据为float32类型,所以如果删掉标准化步骤之后需要进行类型转换。

因为训练库中图片大小是不一样的,所以还需要将图片裁剪成相同大小(img_W和img_H)。视频中是用resize_image_with_crop_or_pad()方法来裁剪图片,这种方法是从图像中心向四周裁剪,如果图片超过规定尺寸,最后只会剩中间区域的一部分,可能一只狗只剩下躯干,头都不见了,用这样的图片训练结果肯定会受到影响。所以这里我稍微改动了一下,使用resize_images()对图像进行缩放,而不是裁剪,采用NEAREST_NEIGHBOR插值方法(其他几种插值方法出来的结果图像是花的,具体原因不知道)。

缩放之后视频中还进行了per_image_standardization (标准化)步骤,但加了这步之后,得到的图片是花的,虽然各个通道单独提出来是正常的,三通道一起就不对了,删了标准化这步结果正常,所以这里把标准化步骤注释掉了。

然后用tf.train.batch()方法获取batch,还有一种方法是tf.train.shuffle_batch(),因为之前我们已经乱序过了,这里用普通的batch()就好。视频中获取batch后还对label进行了一下reshape()操作,在我看来这步是多余的,从batch()方法中获取的大小已经符合我们的要求了,注释掉也没什么影响,能正常获取图片。

最后将得到的image_batch和label_batch返回。image_batch是一个4D的tensor,[batch, width, height, channels],label_batch是一个1D的tensor,[batch]。

可以用下面的代码测试获取图片是否成功,因为之前将图片转为float32了,因此这里imshow()出来的图片色彩会有点奇怪,因为本来imshow()是显示uint8类型的数据(灰度值在uint8类型下是0~255,转为float32后会超出这个范围,所以色彩有点奇怪),不过这不影响后面模型的训练。

# TEST

import matplotlib.pyplot as plt

BATCH_SIZE = 2

CAPACITY = 256

IMG_W = 208

IMG_H = 208

train_dir = "data\\train\\"

image_list, label_list = get_files(train_dir)

image_batch, label_batch = get_batch(image_list, label_list, IMG_W, IMG_H, BATCH_SIZE, CAPACITY)

with tf.Session() as sess:

i = 0

coord = tf.train.Coordinator()

threads = tf.train.start_queue_runners(coord=coord)

try:

while not coord.should_stop() and i < 1:

img, label = sess.run([image_batch, label_batch])

for j in np.arange(BATCH_SIZE):

print("label: %d" % label[j])

plt.imshow(img[j, :, :, :])

plt.show()

i += 1

except tf.errors.OutOfRangeError:

print("done!")

finally:

coord.request_stop()

coord.join(threads)- 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

鉴于篇幅原因,其他部分见下一篇博客。