主要基于下面博文进行学习与验证

一文看懂kafka消息格式演变

概述

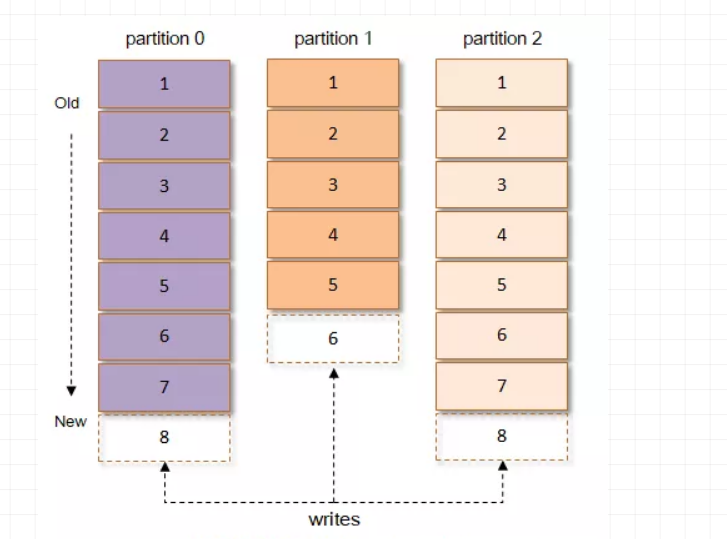

Kafka根据topic(主题)对消息进行分类,发布到Kafka集群的每条消息都需要指定一个topic,每个topic将被分为多个partition(分区)。每个partition在存储层面是追加log(日志)文件,任何发布到此partition的消息都会被追加到log文件的尾部,每条消息在文件中的位置称为offset(偏移量),offset为一个long型的数值,它唯一标记一条消息。

1、v0版消息格式(kafka 0.10之前的版本)

crc32(4B):crc32校验值。校验范围为magic至value之间。

magic(1B):消息格式版本号,此版本的magic值为0。

attributes(1B):消息的属性。总共占1个字节,低3位表示压缩类型:0表示NONE、1表示GZIP、2表示SNAPPY、3表示LZ4(LZ4自Kafka 0.9.x引入),其余位保留。

key length(4B):表示消息的key的长度。如果为-1,则表示没有设置key,即key=null。

key:可选,如果没有key则无此字段。

value length(4B):实际消息体的长度。如果为-1,则表示消息为空。

value:消息体。可以为空,比如tomnstone消息。

(1)新建一个分区为1、副本为1的topic,名称为msg_format_v0

bin/kafka-topics.sh --create --zookeeper hadoop1:2181,hadoop2:2181,hadoop3:2181 --replication-factor 1 --partitions 1 --topic msg_format_v0

(2)向topic中写入key="key", value="value"消息

import org.apache.kafka.clients.producer.*;

import java.util.Properties;

//0.8.2.1版本 api使用

public class TestProducer {

public static void main(String[] args) {

Properties props = new Properties();

props.put("bootstrap.servers", "hadoop1:9092,hadoop2:9092,hadoop3:9092");

props.put("acks", "all");

props.put("key.serializer", "org.apache.kafka.common.serialization.StringSerializer");

props.put("value.serializer", "org.apache.kafka.common.serialization.StringSerializer");

Producer<String, String> producer = new KafkaProducer<>(props);

producer.send(new ProducerRecord<>("msg_format_v0", "key", "value"));

producer.close();

}

}

pom依赖

<dependency>

<groupId>org.apache.kafka</groupId>

<artifactId>kafka-clients</artifactId>

<version>0.8.2.1</version>

</dependency>

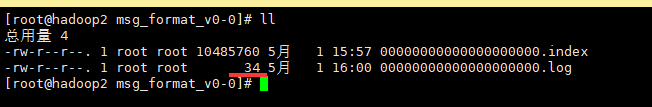

(3)日志消息大小预期与验证

预期

TotalSzie = LOG_OVERHEAD + RECORD_OVERHEAD_V0 + 3B的key + 5B的value = 12B + 14B + 3B + 5B = 34B

"key": 3B

"value": 5B

验证

root@hadoop2 kafka_2.10-0.8.2.1]# bin/kafka-run-class.sh kafka.tools.DumpLogSegments --files /data/kafka-logs/msg_format_v0-0/00000000000000000000.log

Dumping /data/kafka-logs/msg_format_v0-0/00000000000000000000.log

Starting offset: 0

offset: 0 position: 0 isvalid: true payloadsize: 5 magic: 0 compresscodec: NoCompressionCodec crc: 592888119 keysize: 3

(4)向topic中写入key=null, value="value"消息

Producer<Object, String> producer = new KafkaProducer<>(props);

producer.send(new ProducerRecord<>("msg_format_v0", "value"));

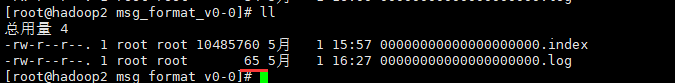

(5)日志消息大小预期与验证

预期

TotalSize = pre_size + LOG_OVERHEAD + RECORD_OVERHEAD_V0 + 0B的key + 5B的value = 34 + 12 + 14 + 5 = 65B

验证

[root@hadoop2 kafka_2.10-0.8.2.1]# bin/kafka-run-class.sh kafka.tools.DumpLogSegments --files /data/kafka-logs/msg_format_v0-0/00000000000000000000.log

Dumping /data/kafka-logs/msg_format_v0-0/00000000000000000000.log

Starting offset: 0

offset: 0 position: 0 isvalid: true payloadsize: 5 magic: 0 compresscodec: NoCompressionCodec crc: 592888119 keysize: 3

offset: 1 position: 34 isvalid: true payloadsize: 5 magic: 0 compresscodec: NoCompressionCodec crc: 2898297856

参考:

(1)一文看懂kafka消息格式演变