写在前面: 博主是一名软件工程系大数据应用开发专业大二的学生,昵称来源于《爱丽丝梦游仙境》中的Alice和自己的昵称。作为一名互联网小白,

写博客一方面是为了记录自己的学习历程,一方面是希望能够帮助到很多和自己一样处于起步阶段的萌新。由于水平有限,博客中难免会有一些错误,有纰漏之处恳请各位大佬不吝赐教!个人小站:http://alices.ibilibili.xyz/ , 博客主页:https://alice.blog.csdn.net/

尽管当前水平可能不及各位大佬,但我还是希望自己能够做得更好,因为一天的生活就是一生的缩影。我希望在最美的年华,做最好的自己!

上一篇博客《还不会使用大数据ETL工具Kettle,你就真的out了!》博主已经为大家介绍了Kettle简单的使用操作,也确实谈到了后面会出较复杂操作的教程,其中当数与大数据组件之前的一些操作。所以本篇博客,博主为大家带来Kettle集成配置大数据的教程,为下一篇Kettle的进阶操作做铺垫!

Kettle集成大数据

1. 修改配置文件

我们打开Kettle安装目录下的pentaho-big-data-plugin文件夹

data-integration\plugins\pentaho-big-data-plugin

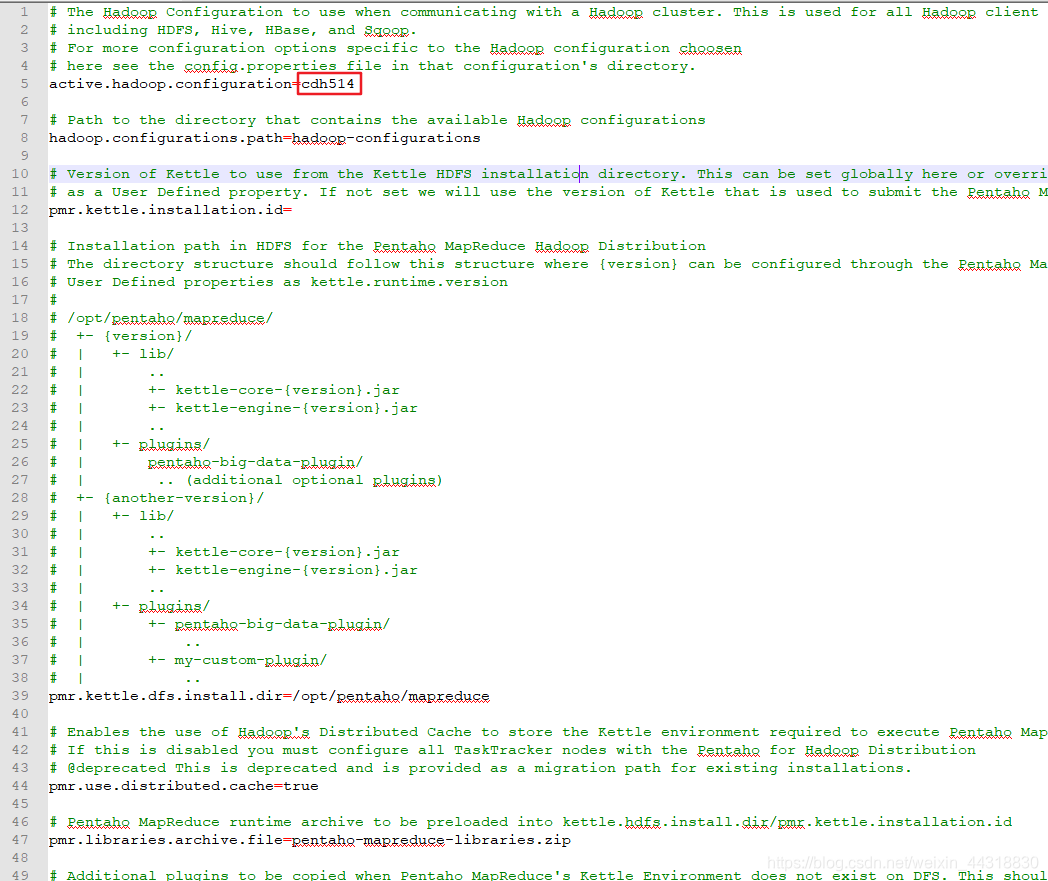

修改plugin.properties文件,把active.hadoop.configuration的值设置成:cdh514

2. 移动jar包路径

我们进入到cdh15文件夹的lib目下

data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\cdh514\lib

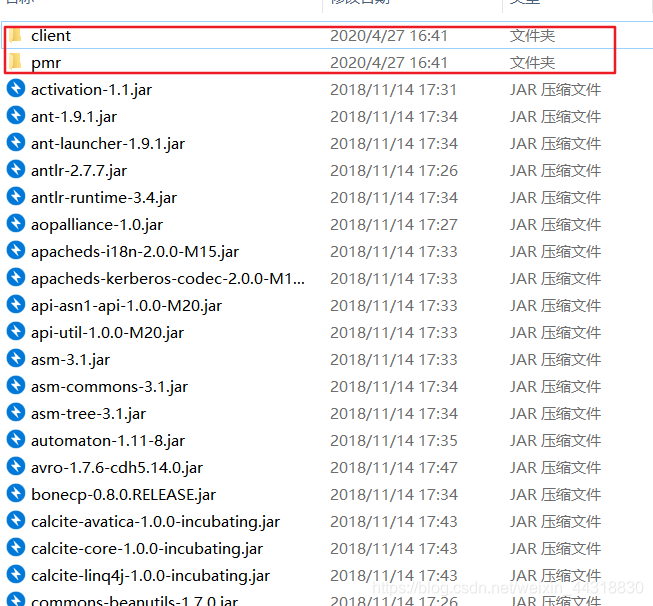

可以发现里面有两个文件夹和一堆jar包

我们只需要做的是把client和pmr这两个文件夹里的jar包拿出来放置到它们父目录,也就是图中所示目录下。

3.上传集群核心配置文件到本地并替换

因为后续我们需要kettle连接集群的大数据相关组件,所以这一步需要将集群上相关的核心配置文件上传到window本地,在kettle的目录下进行替换操作!

操作路径为:

data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\cdh514

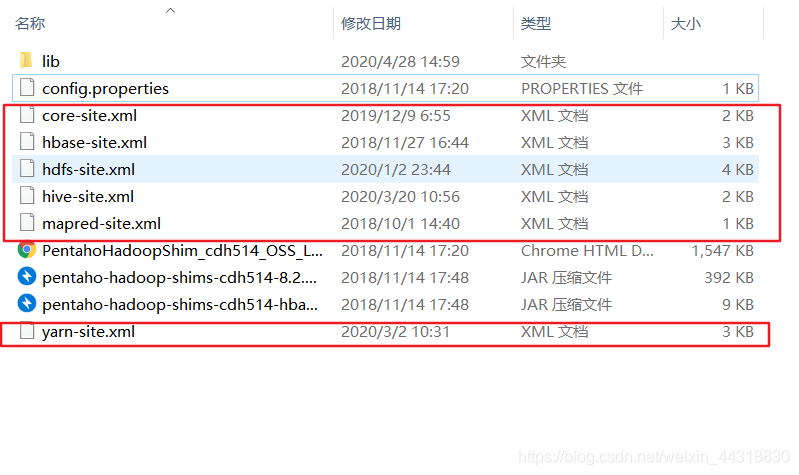

本步骤中,我们需要替换的配置文件有

是不是很眼熟,这不都是hadoop集群上的核心配置文件吗

是的,我们打开集群,进入到Hadoop的etc/hadoop目录下

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

开始往windows端上传文件

sz yarn-site.xml hdfs-site.xml mapred-site.xml core-site.xml

进入到hive的目录

cd /export/servers/hive-1.1.0-cdh5.14.0/conf

同理

sz hive-site.xml

为了后续也能正常使用hbase,这里的操作也与上面一致

cd /export/servers/hbase-1.2.0-cdh5.14.0/conf

sz hbase-site.xml

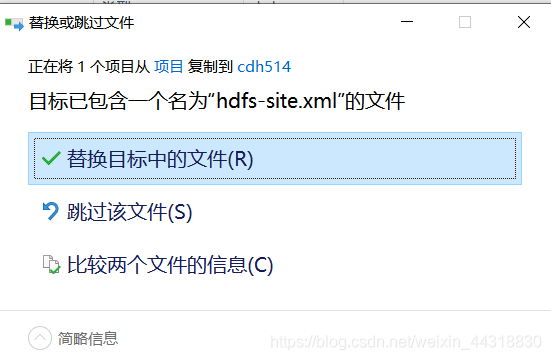

然后将文件全部复制到data-integration\plugins\pentaho-big-data-plugin\hadoop-configurations\cdh514下替换即可

执行到这里,我们来测试一下环境是否整合好了

4.测试

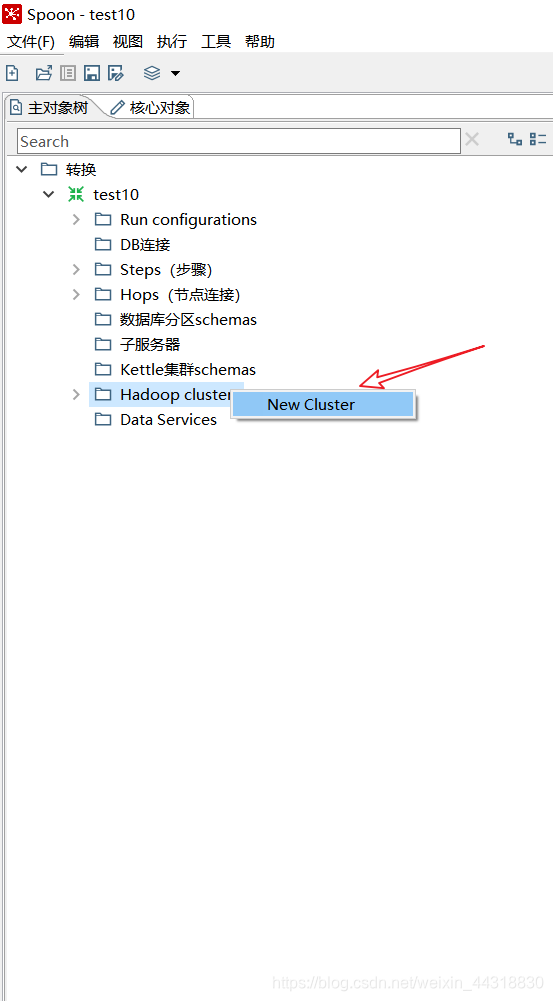

1. 新建一个集群(new Cluster)

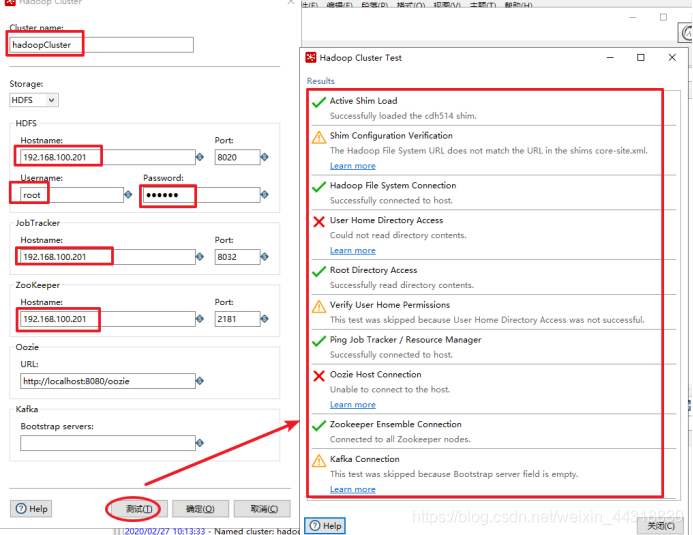

2. 配置集群信息

看到步骤2这样测试显示的结果,说明我们的环境就整合好了~

本篇只是环境整合篇,还未涉及到与Kettle任何实质性的操作,因此就到这就先结束了。下一篇博客博主将为大家详细介绍更多Kettle的转换操作,敬请期待!

如果对你有所帮助,记得点赞评论关注三连|ू・ω・` )