- 解压安装包

tar -xvf spark-2.0.1-bin-hadoop2.7.tgz

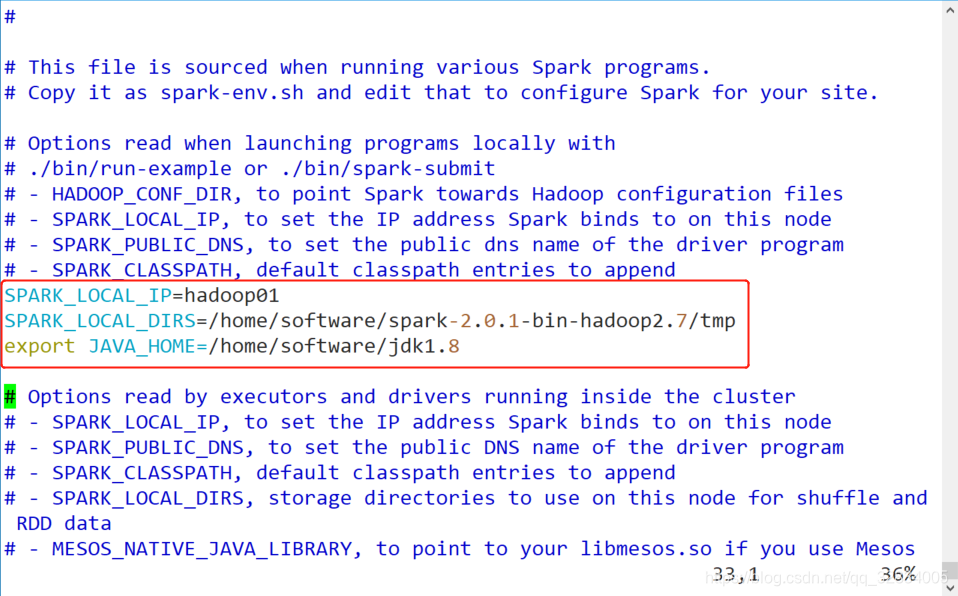

- 在spark的conf目录下,复制

spark-env.sh.template为spark-env.sh

cp spark-env.sh.template spark-env.sh

vim spark-env.sh

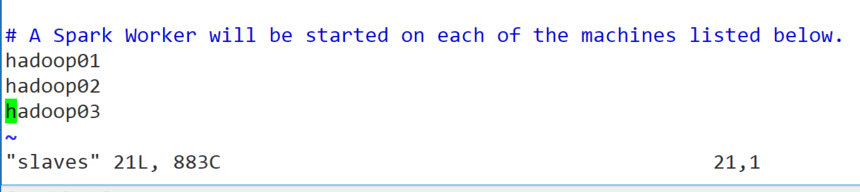

- 在spark的conf目录下,复制

slaves.template为slaves

cp slaves.template slaves

vim slaves

- 将spark安装目录远程拷贝到另外两个节点

scp -r spark-2.0.1-bin-hadoop2.7 hadoop02:/home/software/

scp -r spark-2.0.1-bin-hadoop2.7 hadoop03:/home/software/

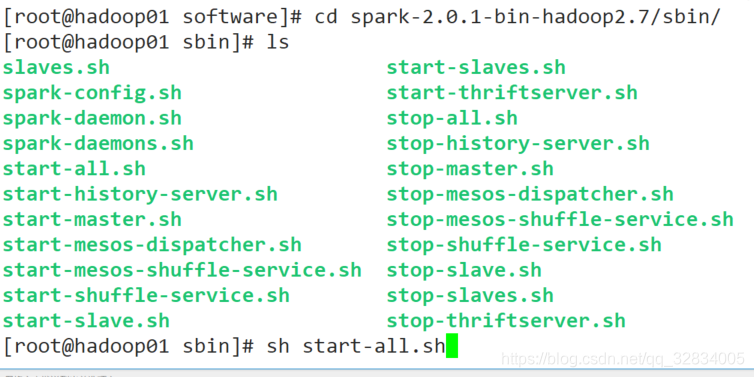

启动spark集群

- 进入spark的sbin目录,启动spark集群

sh start-all.sh

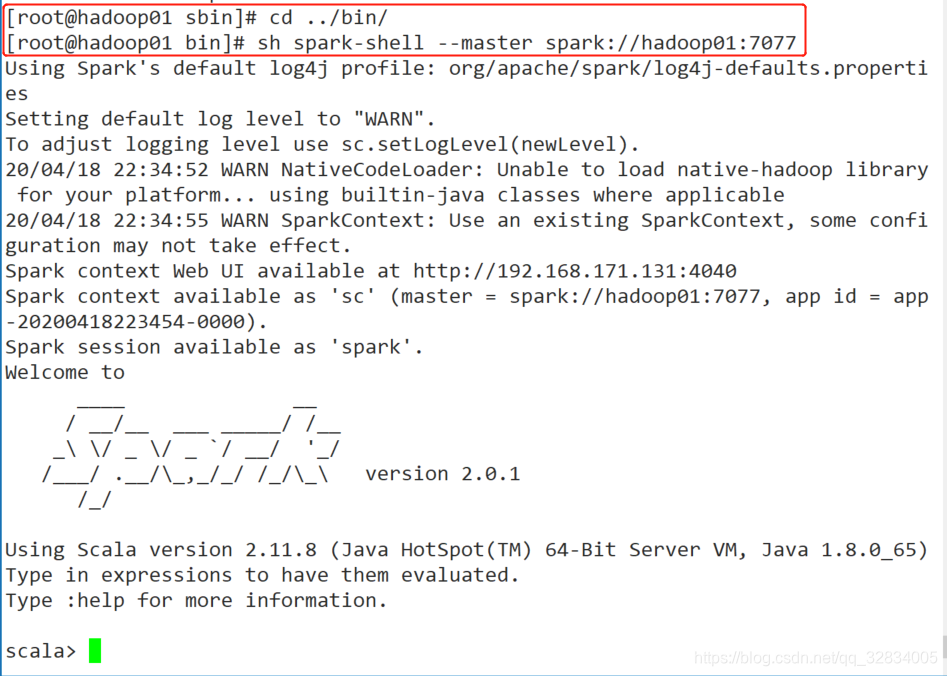

- 在spark的bin目录下,进入spark客户端

sh spark-shell --master spark://hadoop01:7077