首先说明之前的一个配置错误,因为我在配置/etc/sudoers 用户权限文件的时候 chen ALL=(ALL) ALL 字母没有大写,导致sudo命令不能用,在这里通过之前配置的朋友可以看看你的配置是否有问题,修改完成,记得吧sudoers文件权限修改成440

用命令 chmod 440 /etc/sudoers

这样之前的问题就解决了,然后我们来看下怎么安装ZK和hadoop的HA平台,

首先我们知道hadoop的ha是基于zk的,zk用来做主键切换保持一致性问题,很好,所以我们先安装zk集群,我们首先安装3台zk集群,

zookeeper的安装:

java

准备:安装jdk1.8

3.4.10

安装节点:奇数台 255台 3-11台

安装3台 hadoop01 hadoop02 hadoop03

步骤:

1)上传

2)解压

tar -xvzf zookeeper-3.4.10.tar.gz

3)配置环境变量

sudo vim /etc/profile

export JAVA_HOME=/home/chen/JDK1.8/jdk1.8.0_73

export ZOOKEEPER_HOME=/home/chen/zookeeper-3.4.10/zookeeper-3.4.10

export HADOOP_HOME=/home/chen/hadoop/hadoop-2.7.6

export PATH= JAVA_HOME/bin: HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

source /etc/profile

4)修改zk的配置文件

/home/hadoop/apps/zookeeper-3.4.10/conf

mv zoo_sample.cfg zoo.cfg

# The number of milliseconds of each tick 心跳时间间隔

tickTime=2000

# The number of ticks that the initial

# synchronization phase can take 初始化心跳连接次数

initLimit=10

# The number of ticks that can pass between

# sending a request and getting an acknowledgement

发送请求和返回响应之间的心跳次数

syncLimit=5

# the directory where the snapshot is stored.

# do not use /tmp for storage, /tmp here is just

# example sakes.

//zk的数据文件存储位置 zk的核心数据文件 一定要改

dataDir=/home/hadoop/data/zookeeperdata

# the port at which the clients will connect

# 客户端连接zk的端口 默认端口2181

clientPort=2181

# the maximum number of client connections.

# increase this if you need to handle more clients

#maxClientCnxns=60

#

# Be sure to read the maintenance section of the

# administrator guide before turning on autopurge.

#

#http://zookeeper.apache.org/doc/current/zookeeperAdmin.html#sc_maintenance

#

# The number of snapshots to retain in dataDir

#autopurge.snapRetainCount=3

# Purge task interval in hours

# Set to "0" to disable auto purge feature

#autopurge.purgeInterval=1

server.1=hadoop01:2888:3888

server.2=hadoop02:2888:3888

server.3=hadoop03:2888:3888

末尾追加:配置zk的所有的节点信息

zk集群中 每一个节点都有一个自己的独立的id

zk节点相互之间不能重复的 这个id认为规定的

通信选举的时候使用的就是id 范围0-255

server.id=主机名:2888:3888

2888:心跳端口

3888:选举端口

一行代表一个节点

hadoop01----1

hadoop02----2

hadoop03----3

5)到对应的节点上添加id文件

路径:dataDir=/home/hadoop/data/zookeeperdata

文件名:myid

文件内容 :对应的id 不要有多余的空格 或空行

mkdir /home/hadoop/data/zookeeperdata

vi myid

1

#文件里面指定id就可以,ID范围在0到255之间随便改,每个机器id要不一样

注意:修改hadoop05、hadoop06对应的myid ,你上面 server.1 这个server.1

myid 就要配置成 1 同理, hadoop05 配置为2 , Hadoop06配置为3

server.1=hadoop01:2888:3888

server.2=hadoop02:2888:3888

server.3=hadoop03:2888:3888

6)远程发送到其他节点

scp -r zookeeper-3.4.10 hadoop02:$PWD # $PWD 表示相同路径下

scp -r zookeeper-3.4.10 hadoop03:/home/hadoop/apps/

sudo scp /etc/profile hadoop02:/etc/

sudo scp /etc/profile hadoop03:/etc/

source /etc/profile

7)启动

关闭防火墙 sudo service iptables stop

启动:三个节点分别启动

hadoop01: zkServer.sh start

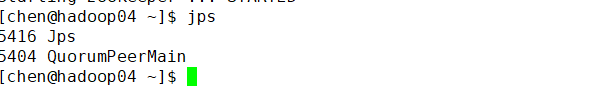

jps

6332 QuorumPeerMain

不代表启动成功

查看zk的状态:

zkServer.sh status

现在我们的ZK已经安装好了,而且已经启动了,然后我们先关闭zk集群

用命令:

zkServer.sh stop

然后我们开始安装hadoop的HA平台:

ha的搭建

1)集群规划

hdfs:2个namenode 4个datanode 2个zkfc

3个journalnode

yarn:2个resourcemanager 4个nodemanager

zk:3个zk

hadoop01 hadoop02 hadoop03 hadoop04

hdfs namenode namenode

zkfc zkfc

datanode datanode datanode datanode

journalnode jounalnode jounalnode

yarn: resourcemanager resourcemanager

nodemanager nodemanager nodemanager nodemanager

zk quorumpeermain quorumpeermain quorumpeermain

2)安装:

安装准备

1)主机名

2)ip

3)hosts

4)防火墙

5)selinux

6)普通用户的sudoers权限

7)修改系统的启动级别 3

8)安装jdk

9)ssh免密码登录

10)时间同步 ha必须做时间同步

sudo ntpdate ntp1.aliyun.com

删除之前的hadoop:

1)关闭hadoop集群

stop-dfs.sh

stop-yarn.sh

2)删除hadoop的安装包

rm -rf hadoop-2.7.6

3)删除hadoop的数据文件

4)重新上传一个安装包

安装步骤:

1)上传

Hadoop版本是2.7.6 然后zk的版本是3.4.10 都可以去官网找到安装包。

2)解压

tar -xvzf hadoop-2.7.6.tar.gz

3)配置环境变量

export JAVA_HOME=/home/chen/JDK1.8/jdk1.8.0_73

export ZOOKEEPER_HOME=/home/chen/zookeeper-3.4.10/zookeeper-3.4.10

export HADOOP_HOME=/home/chen/hadoop/hadoop-2.7.6

export PATH= JAVA_HOME/bin: HADOOP_HOME/bin:$HADOOP_HOME/sbin

source /etc/profile

验证:hadoop version

4)修改hadoop的配置文件

$HADOOP_HOME/etc/hadoop

hadoop-env.sh

修改:

export JAVA_HOME=/home/hadoop/apps/jdk1.8.0_73

core-site.xml

<!-- 指定 hdfs 的 访问入口 namenode的入口 这里的bd1807 就相当于两个namenode的组名-->

<property>

<name>fs.defaultFS</name>

<value>hdfs://bd1807/</value>

</property>

<!-- 指定 hadoop 数据存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/data/hadoopdata/</value>

</property>

<!-- 指定 zookeeper 集群访问地址 -->

<property>

<name>ha.zookeeper.quorum</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

hdfs-site.xml

<!-- 指定副本数 -->

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<!--指定 hdfs 两个namenode的 nameservice 为 bd1807,需要和 core-site.xml 中保持一致-->

<property>

<name>dfs.nameservices</name>

<value>bd1807</value>

</property>

<!-- bd1807 下面有两个 NameNode,分别是 nn1,nn2 -->

<property>

<name>dfs.ha.namenodes.bd1807</name>

<value>nn1,nn2</value>

</property>

<!-- nn1 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.bd1807.nn1</name>

<value>hadoop01:9000</value>

</property>

<!-- nn1 的 http 通信地址 web -->

<property>

<name>dfs.namenode.http-address.bd1807.nn1</name>

<value>hadoop01:50070</value>

</property>

<!-- nn2 的 RPC 通信地址 -->

<property>

<name>dfs.namenode.rpc-address.bd1807.nn2</name>

<value>hadoop02:9000</value>

</property>

<!-- nn2 的 http 通信地址 -->

<property>

<name>dfs.namenode.http-address.bd1807.nn2</name>

<value>hadoop02:50070</value>

</property>

<!-- 指定 NameNode 的 edits 元数据在 JournalNode 上的存放位置 端口8485-->

<property>

<name>dfs.namenode.shared.edits.dir</name>

<value>qjournal://hadoop01:8485;hadoop02:8485;hadoop03:8485/bd1807</value>

</property>

<!-- 指定 JournalNode 在本地磁盘存放数据的位置 -->

<property>

<name>dfs.journalnode.edits.dir</name>

<value>/home/hadoop/data/hadoopdata/journaldata</value>

</property>

<!-- 开启 NameNode 失败自动切换 -->

<property>

<name>dfs.ha.automatic-failover.enabled</name>

<value>true</value>

</property>

<!-- 配置失败自动切换实现方式 -->

<!-- 此处配置在安装的时候切记检查不要换行-->

<property>

<name>dfs.client.failover.proxy.provider.bd1807</name>

<value>org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider</value>

</property>

<!-- 配置隔离机制方法,多个机制用换行分割,即每个机制暂用一行-->

<property>

<name>dfs.ha.fencing.methods</name>

<value>

sshfence

shell(/bin/true)

</value>

</property>

<!-- 使用 sshfence 隔离机制时需要 ssh 免登陆 -->

<property>

<name>dfs.ha.fencing.ssh.private-key-files</name>

<value>/home/hadoop/.ssh/id_rsa</value>

</property>

<!-- 配置 sshfence 隔离机制超时时间 -->

<property>

<name>dfs.ha.fencing.ssh.connect-timeout</name>

<value>30000</value>

</property>

yarn-site.xml

<!-- 开启 RM 高可用 -->

<property>

<name>yarn.resourcemanager.ha.enabled</name>

<value>true</value>

</property>

<!-- 指定 RM 的 cluster id -->

<property>

<name>yarn.resourcemanager.cluster-id</name>

<value>yrc</value>

</property>

<!-- 指定 RM 的名字 -->

<property>

<name>yarn.resourcemanager.ha.rm-ids</name>

<value>rm1,rm2</value>

</property>

<!-- 分别指定 RM 的地址 -->

<property>

<name>yarn.resourcemanager.hostname.rm1</name>

<value>hadoop01</value>

</property>

<property>

<name>yarn.resourcemanager.hostname.rm2</name>

<value>hadoop02</value>

</property>

<!-- 指定 zk 集群地址 -->

<property>

<name>yarn.resourcemanager.zk-address</name>

<value>hadoop01:2181,hadoop02:2181,hadoop03:2181</value>

</property>

<!-- 要运行 MapReduce 程序必须配置的附属服务 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 开启 YARN 集群的日志聚合功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- YARN 集群的聚合日志最长保留时长 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>86400</value>

</property>

<!-- 启用自动恢复 -->

<property>

<name>yarn.resourcemanager.recovery.enabled</name>

<value>true</value>

</property>

<!-- 制定 resourcemanager 的状态信息存储在 zookeeper 集群上-->

<property>

<name>yarn.resourcemanager.store.class</name>

<value>org.apache.hadoop.yarn.server.resourcemanager.recovery.ZKRMStateStore</value>

</property>

mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

<!-- 指定 mr 框架为 yarn 方式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 设置 mapreduce rpc的历史服务器地址和端口号 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop03:10020</value>

</property>

<!-- mapreduce 历史服务器的 web 访问地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop03:19888</value>

</property>

slaves 从节点nodemanager datanode

hadoop01

hadoop02

hadoop03

hadoop04

5)将hadoop的安装包远程发送到其他节点

scp -r hadoop-2.7.6 hadoop02:/home/hadoop/apps/

scp -r hadoop-2.7.6 hadoop03:/home/hadoop/apps/

scp -r hadoop-2.7.6 hadoop04:/home/hadoop/apps/

source /etc/profile

hadoop version

6)从这一步开始 严格按照顺序执行

1)先启动journalnode

hadoop01 hadoop-daemon.sh start journalnode

hadoop02 hadoop-daemon.sh start journalnode

hadoop03 hadoop-daemon.sh start journalnode

2)格式化namenode 在一个namenode上执行格式化命令

在hadoop01执行

hadoop namenode -format

3)将hadoop01上的namenode的相关数据文件远程并发送到另一个namenode

节点hadoop02

scp -r dfs hadoop02:/home/hadoop/data/hadoopdata/

4)先启动zk

hadoop01

hadoop02

hadoop03

zkServer.sh start

5)格式化zkfc 选择一个namenode的节点

hdfs zkfc -formatZK

成功标志:

Successfully created /hadoop-ha/bd1807 in ZK

6)启动集群

启动hdfs

start-dfs.sh 任意节点执行

DFSZKFailoverController—zkfc

启动yarn

start-yarn.sh 最好在resourcemanager的节点

在哪一个节点执行上面的命令 在哪一个节点启动resourcemanager

另一个节点手动启动

yarn-daemon.sh start resourcemanager

注意:

单独启动zkfc的命令:

hadoop-daemon.sh start zkfc

ha验证:

先验证hdfs的主备切换:

namenode 2个

http://hadoop01:50070

http://hadoop02:50070

yarn的测试

http://hadoop01:8088

http://hadoop02:8088

mr 切换yarn的主节点

关机:

先关闭集群:

1)关闭hdfs

stop-dfs.sh

2)关闭yarn

stop-yarn.sh

3)关闭zk

zkServer.sh stop

再关机