0.准备

1.数据准备

hello world

dog fish

hadoop

spark

hello world

dog fish

hadoop

spark

hello world

dog fish

hadoop

spark

2.执行命令

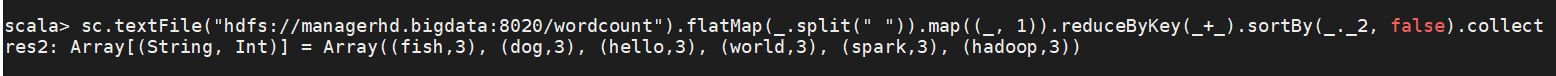

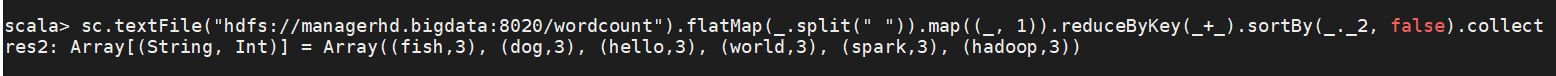

sc.textFile("hdfs://managerhd.bigdata:8020/wordcount").flatMap(_.split(" ")).map((_, 1)).reduceByKey(_+_).sortBy(_._2, false).collect

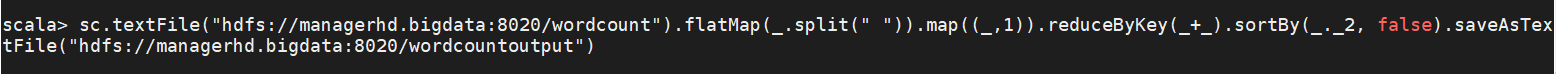

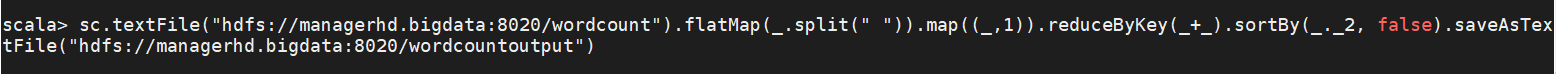

sc.textFile("hdfs://managerhd.bigdata:8020/wordcount").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_).sortBy(_._2, false).saveAsTextFile("hdfs://managerhd.bigdata:8020/wordcountoutput")

| 选项 |

说明 |

sc |

SparkContext对象,该对象是提交spark的程序入口 |

testFile() |

hdfs中读取数据 |

flatMap(_.split(" ")) |

拆分数据 |

map((_,1)) |

将单词和 1 构成元组 |

reduceByKey(_+_) |

按照key进行reduce,并将value累加 |

saveAsTextFile() |

将结果写入hdfs中 |