学习率衰减

加快神经网络的另一个办法就是随着时间推移慢慢减少学习率。我们将这个称之为学习率衰减。

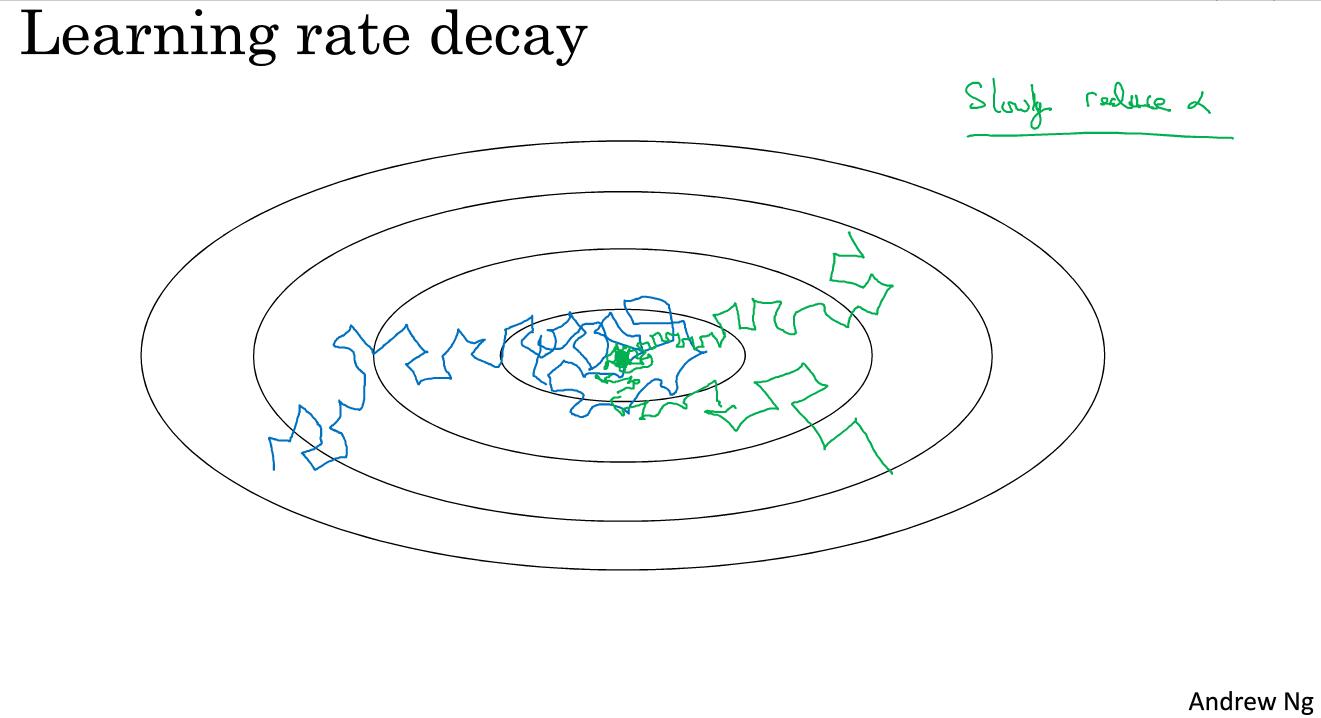

如图中蓝色线所示,当mini-batch不大的时候,噪声会比较明显。最后不会精确地收敛,而是在最小值附近不断地波动。但是如果我们不断减少学习率,最后情况就如同图中绿线所示,最后会在最小值附近很小的一块区域不断波动,而不会在比较大的区域里。

减小学习率的方法如下:

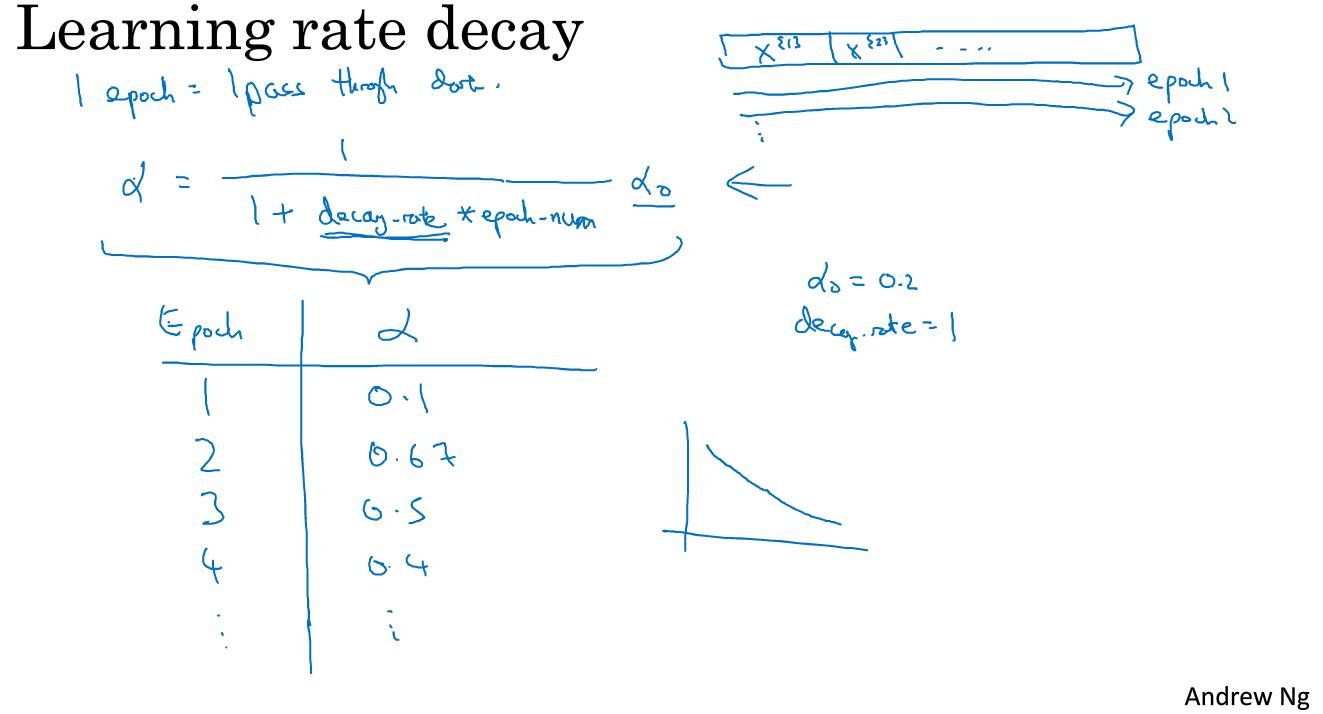

我们需要在第一代的时候遍历一遍数据,第一次遍历整个数据集称为第一代,第二次遍历整个数据集称为第二代。我们一般的计算公式是

其中decay-rate称为衰减率,这个也是我们需要调整的超参数。从图中我们可以看到,如果decay-rate的值是1,随着epoch-num的数值不断增加,学习率在不断下降。

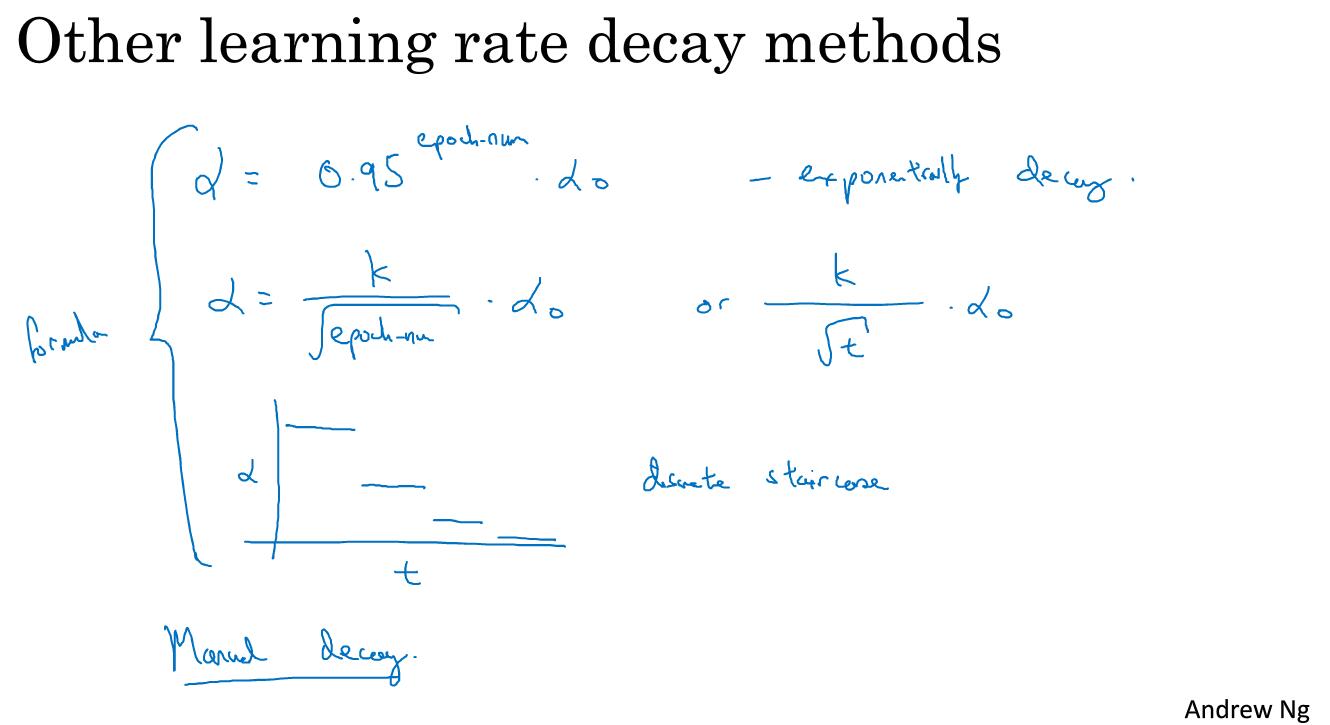

除了这个学习率衰减公式,还有别的衰减公式。