一、运行时的组件和基本原理

1、作业管理器

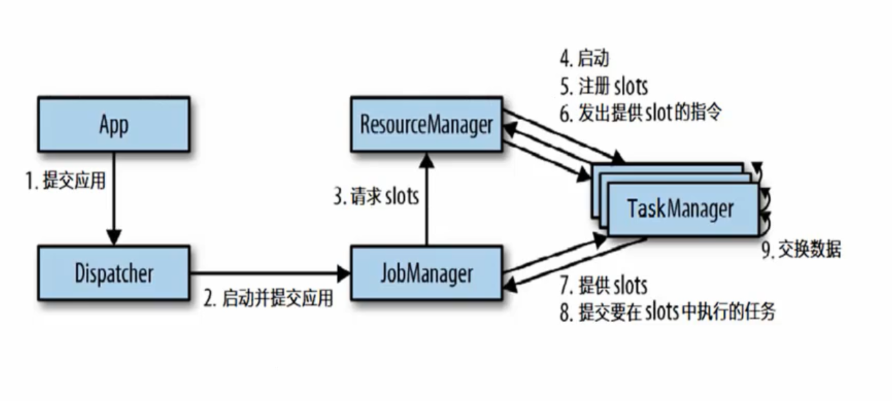

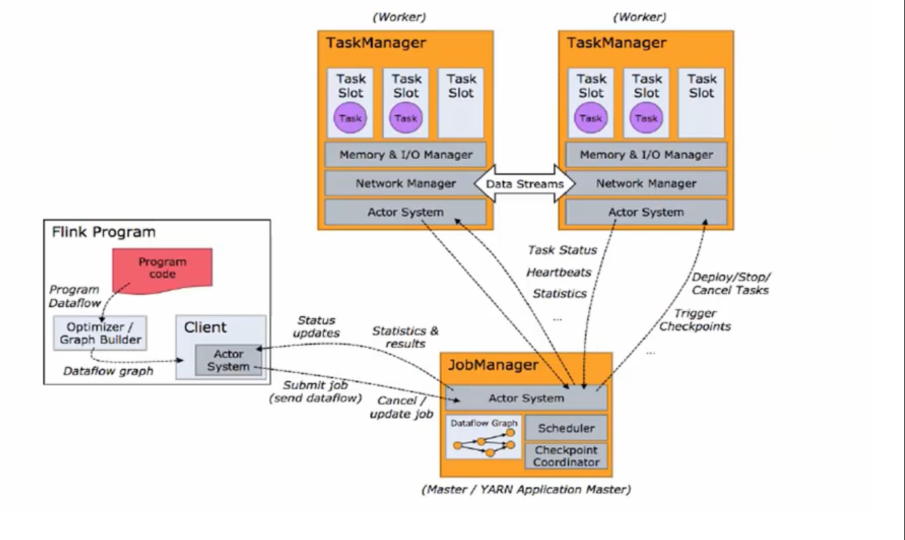

(1)控制一个应用程序执行的主进程,也就是说,每个应用程序都会被一个不同的JobManager所控制执行。

(2)JobManager会先接收到要执行的应用程序,这个应用程序会包括:作业图(JobGraph)、逻辑数据流图(Logical dataflow graph)和打包了所有的类、库和其他资源的Jar包。

(3)JobManager会把JobGraph转换成一个物理层面的数据流图,这个图被叫做“执行图”(ExecutionGraph),包含了所有可以并发执行的任务。

(4)JobManager会向资源管理器(ResourceManger)请求执行任务必要的资源,也就是任务管理器(TaskManager)上的插槽(slot)。一旦它获取到了足够的资源,就会将执行图分发到真正运行它们的TaskManager上。而在运行过程中,JobManager会负责所有需要中央协调的操作,比如检查点(checkpoints)的协调。

2、任务管理器( TaskManager)

(1)Fink中的工作进程。通常在Fnk中会有多个 askManager运行,每一个Task Manager都包含了一定数量的插槽(sots)。插槽的数量限制了askManageri能够执行的任务数量。

(2)启动之后, askManager会向资源管理器注册它的插槽;收到资源管理器的指令后, TaskManager就会将一个或者多个插槽提供给JobManager调用。 JobManage就可以向插槽分配任务( tasks)来执行了。

(3)在执行过程中,一个 askManager可以跟其它运行同一应用程序的TaskManager交换数据。

3、资源管理器( ResourceManager)

(1)主要负责管理任务管理器( TaskManager)的插槽(slot),TaskManger插槽是Fink中定义的处理资源单元。

(2)Flink为不同的环境和资源管理工具提供了不同资源管理器,比如YARNMesos、K85,以及 standalone部署。·

(3)当 JobManager申请插槽資源时, ResourceManager会将有空闲插槽的TaskManager分配给 JobManager。如果 ResourceManager没有足够的插槽来满足JobManager的请求,它还可以向資源提供平台发起会话,以提供启动 TaskManager进程的容器。

4、分发器( Dispatcher)

(1)可以跨作业运行,它为应用提交提供了REST接口。

(2)当一个应用被提交执行时,分发器就会启动并将应用移交给一个JobManager

(3)Dispatcher也会启动一个WebU,用来方便地展示和监控作业执行的信息。

(4)Dispatcher在架构中可能并不是必需的,这取决于应用提交运行的方式。

5、任务提交流程

6、任务提交到YARN上的流程

7、任务调度原理

二、Slot和并行度

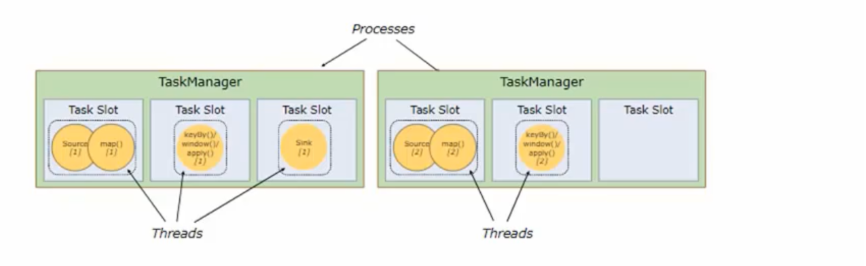

1、TaskManager和Slots

Fink中每一个 TaskManager都是一个MM进程,它可能会在独立的线程上执行一个或多个 subtask

为了控制一个 TaskManager能接收多少个task, TaskManager通过 task slot来进行控制(一个 TaskManager至少有一个slot)

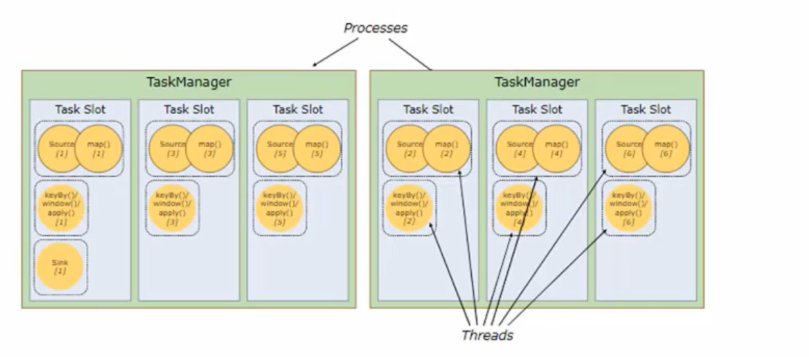

我们将上图前两个任务并行度提高到6:

默认情况下,Fink允许子任务共享sot,即使它们是不同任务的子任务。这样的结果是,一个sot可以保存作业的整个管道。

Task slot是静态的概念,是指 TaskManager具有的并发执行能力。

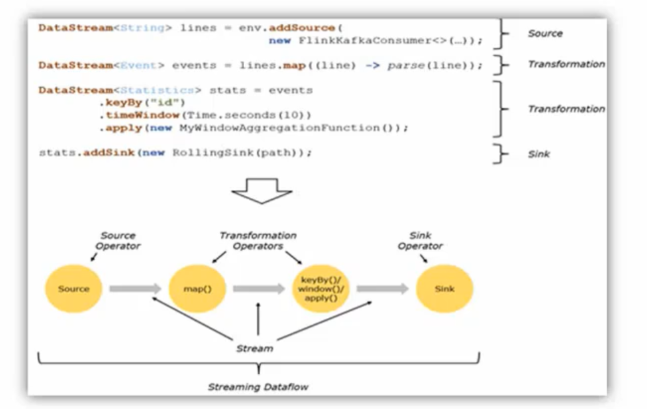

2、程序与数据流

所有的Fink程序都是由三部分组成的: Source、 Transformation和Sink。·

Source负责读取数据源, Transformation利用各种算子进行处理加工,Sink负责输出。

在运行时,Fink上运行的程序会被映射成"逻辑数据流”( dataflows),它包含了这三部分。

每一个 dataflow以一个或多个 sources开始以一个或多个sinks结束。 dataflow类似于任意的有向无环图(DAG)。

在大部分情况下,程序中的转换运算( transformations)跟 dataflow中的算子( operato)是—对应的关系。

三、数据流和执行图

1、执行图

Fink中的执行图可以分成四层: StreamGraph-> JobGraph-> ExecutionGraph>物理执行图。

StreamGraph:是根据用户通过 Stream AP|编写的代码生成的最初的图。用来表示程序的拓扑结构。

JobGraph: StreamGraph经过优化后生成了 JobGraph,提交给 JobManager的数据结构。主要的优化为,将多个符合条件的节点 chain在一起作为一个节点。

ExecutionGraph: JobManager根据 JobGraph生成 ExecutionGraphExecutionGraph是 ogRaph的并行化版本,是调度层最核心的数据结构。

物理执行图: JobManager根据 Execution Graph对Job进行调度后,在各个TaskManager上部署lask后形成的图",并不是一个具体的数据结构。

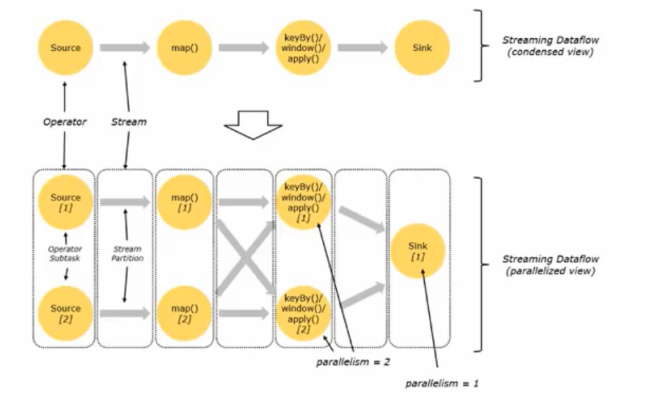

2、并行度

一个特定算子的子任务( subtask)的个数被称之为其并行度( parallelism)。

一般情况下,一个 stream的并行度,可以认为就是其所有算子中最大的并行度。

一个程序中,不同的算子可能具有不同的并行度算子之间传输数据的形式可以是 one-to-one( for warding)的模式也可以是redistributing的模式,具体是哪一种刑式,取决于算子的种类

One-to-one: stream维护着分区以及元素的顺序(比如ouce和map之间)。这意味着map算子的子任务看到的元素的个数以及顺序跟 source算子的子任务生产的元素的个数、顺序相同。map、 fliter、 flatMap等算子都是one-to-one的对应关系。

Redistributing: stream的分区会发生改变。每一个算子的子任务依据所选择的transformation发送数据到不同的目标任务。例如, kerBy基于 hashCode重分区、而 broadcast和 rebalance会随机重新分区,这些算子都会引起 redistribute过程,而 redistribute过程就类似于 Spark中的 shuffle过程。

四、任务调度控制

任务链

Flink采用了一种称为任务链的优化技术,可以在特定条件下减少本地通信的开销。为了满足任务链的要求,必须将两个或多个算子设为相同的并行度,并通过本地转发( ocal for ward)的方式进行连接。

相同并行度的one-to-one操作,Fink这样相连的算子链接在一起形成一个task,原来的算子成为里面的 subtask。

并行度相同、并且是 one-to-one操作,两个条件缺一不可。