爬虫学习入门篇

作为一名程序员,大家对于爬虫这个词的理解都有不同,我以前的理解就是一只spider在网络上爬取东西,不过我们能控制这只spider去爬取需要内容并存取到数据库中。后来才发现爬虫有点重要!!!

网络爬虫的介绍

在大数据时代,信息的采集是一项重要的工作,而互联网中的数据是海量的,如果单纯靠人力进行信息采集,不仅低效繁琐,搜集的成本也会提高。如何自动高效地获取互联网中我们感兴趣的信息并为我们所用是一个重要的问题,而爬虫技术就是为了解决这些问题而生的。

网络爬虫(Web crawler)也叫做网络机器人,可以代替人们自动地在互联网中进行数据信息的采集与整理。它是一种按照一定的规则,自动地抓取万维网信息的程序或者脚本,可以自动采集所有其能够访问到的页面内容,以获取相关数据。

从功能上来讲,爬虫一般分为数据采集,处理,储存三个部分。爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

为什么要学爬虫

- 可以实现搜索引擎。我们学会了爬虫编写之后,就可以利用爬虫自动地采集互联网中的信息,采集回来后进行相应的存储或处理,在需要检索某些信息的时候,只需在采集回来的信息中进行检索,即实现了私人的搜索引擎。

- 大数据时代,可以让我们获取更多的数据源。在进行大数据分析或者进行数据挖掘的时候,需要有数据源进行分析。我们可以从某些提供数据统计的网站获得,也可以从某些文献或内部资料中获得,但是这些获得数据的方式,有时很难满足我们对数据的需求,而手动从互联网中去寻找这些数据,则耗费的精力过大。此时就可以利用爬虫技术,自动地从互联网中获取我们感兴趣的数据内容,并将这些数据内容爬取回来,作为我们的数据源,再进行更深层次的数据分析,并获得更多有价值的信息。

- 可以更好地进行搜索引擎优化(SEO)。对于很多SEO从业者来说,为了更好的完成工作,那么就必须要对搜索引擎的工作原理非常清楚,同时也需要掌握搜索引擎爬虫的工作原理。而学习爬虫,可以更深层次地理解搜索引擎爬虫的工作原理,这样在进行搜索引擎优化时,才能知己知彼,百战不殆。

- 有利于就业。从就业来说,爬虫工程师方向是不错的选择之一,因为目前爬虫工程师的需求越来越大,而能够胜任这方面岗位的人员较少,所以属于一个比较紧缺的职业方向,并且随着大数据时代和人工智能的来临,爬虫技术的应用将越来越广泛,在未来会拥有很好的发展空间。

爬虫入门程序

1.环境准备

编译环境准备:

- l JDK1.8

- l IntelliJ IDEAl

- IDEA自带的Maven

IDEA操作步骤:

1.创建Maven工程itcast-crawler-first并给pom.xml加入依赖

<dependencies>

<!-- HttpClient -->

<dependency>

<groupId>org.apache.httpcomponents</groupId>

<artifactId>httpclient</artifactId>

<version>4.5.3</version>

</dependency>

<!-- 日志 -->

<dependency>

<groupId>org.slf4j</groupId>

<artifactId>slf4j-log4j12</artifactId>

<version>1.7.25</version>

</dependency>2.加入log4j.properties

log4j.rootLogger=DEBUG,A1

log4j.logger.cn.itcast = DEBUG

log4j.appender.A1=org.apache.log4j.ConsoleAppender

log4j.appender.A1.layout=org.apache.log4j.PatternLayout

log4j.appender.A1.layout.ConversionPattern=%-d{yyyy-MM-dd HH:mm:ss,SSS} [%t] [%c]-[%p] %m%n2.编写代码

编写最简单的爬虫,抓取网站首页:http://www.itcast.cn/

public static void main(String[] args) throws Exception {

CloseableHttpClient httpClient = HttpClients.createDefault();

HttpGet httpGet = new HttpGet("http://www.itcast.cn/");

CloseableHttpResponse response = httpClient.execute(httpGet);

if (response.getStatusLine().getStatusCode() == 200) {

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

System.out.println(content);

}

}测试结果:可以获取到页面数据

HTTPCilent详细介绍

1.GET请求

访问传智官网,请求url地址:http://www.itcast.cn/

public static void main(String[] args) throws IOException {

//创建HttpClient对象

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建HttpGet请求

HttpGet httpGet = new HttpGet("http://www.itcast.cn/");

CloseableHttpResponse response = null;

try {

//使用HttpClient发起请求

response = httpClient.execute(httpGet);

//判断响应状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

//如果为200表示请求成功,获取返回数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

//打印数据长度

System.out.println(content);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

httpClient.close();

}

}

}请求结果:

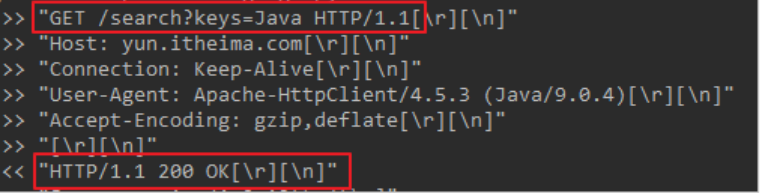

2.GET带参数请求

在传智中搜索学习视频,地址为:http://yun.itheima.com/search?keys=Java

public static void main(String[] args) throws IOException {

//创建HttpClient对象

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建HttpGet请求,带参数的地址https://www.baidu.com/s?wd=HttpClient

String uri = "http://yun.itheima.com/search?keys=Java";

HttpGet httpGet = new HttpGet(uri);

CloseableHttpResponse response = null;

try {

//使用HttpClient发起请求

response = httpClient.execute(httpGet);

//判断响应状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

//如果为200表示请求成功,获取返回数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

//打印数据长度

System.out.println(content);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

httpClient.close();

}

}

}请求结果

3.POST请求

使用POST访问传智官网,请求url地址:http://www.itcast.cn/

public static void main(String[] args) throws IOException {

//创建HttpClient对象

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建HttpGet请求

HttpPost httpPost = new HttpPost("http://www.itcast.cn/");

CloseableHttpResponse response = null;

try {

//使用HttpClient发起请求

response = httpClient.execute(httpPost);

//判断响应状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

//如果为200表示请求成功,获取返回数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

//打印数据长度

System.out.println(content);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

httpClient.close();

}

}

}请求结果:

4.POST带参数请求

在传智中搜索学习视频,使用POST请求,url地址为:http://yun.itheima.com/searchurl地址没有参数,参数keys=java放到表单中进行提交

public static void main(String[] args) throws IOException {

//创建HttpClient对象

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建HttpGet请求

HttpPost httpPost = new HttpPost("http://www.itcast.cn/");

//声明存放参数的List集合

List<NameValuePair> params = new ArrayList<NameValuePair>();

params.add(new BasicNameValuePair("keys", "java"));

//创建表单数据Entity

UrlEncodedFormEntity formEntity = new UrlEncodedFormEntity(params, "UTF-8");

//设置表单Entity到httpPost请求对象中

httpPost.setEntity(formEntity);

CloseableHttpResponse response = null;

try {

//使用HttpClient发起请求

response = httpClient.execute(httpPost);

//判断响应状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

//如果为200表示请求成功,获取返回数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

//打印数据长度

System.out.println(content);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

httpClient.close();

}

}

}请求结果

5.连接池

如果每次请求都要创建HttpClient,会有频繁创建和销毁的问题,可以使用连接池来解决这个问题。

测试以下代码,并断点查看每次获取的HttpClient都是不一样的。

public static void main(String[] args) {

PoolingHttpClientConnectionManager cm = new PoolingHttpClientConnectionManager();

// 设置最大连接数

cm.setMaxTotal(200);

// 设置每个主机的并发数

cm.setDefaultMaxPerRoute(20);

doGet(cm);

doGet(cm);

}

private static void doGet(PoolingHttpClientConnectionManager cm) {

CloseableHttpClient httpClient = HttpClients.custom().setConnectionManager(cm).build();

HttpGet httpGet = new HttpGet("http://www.itcast.cn/");

CloseableHttpResponse response = null;

try {

response = httpClient.execute(httpGet);

// 判断状态码是否是200

if (response.getStatusLine().getStatusCode() == 200) {

// 解析数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

System.out.println(content.length());

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

//不能关闭HttpClient

//httpClient.close();

}

}

}6.请求参数

有时候因为网络,或者目标服务器的原因,请求需要更长的时间才能完成,我们需要自定义相关时间

public static void main(String[] args) throws IOException {

//创建HttpClient对象

CloseableHttpClient httpClient = HttpClients.createDefault();

//创建HttpGet请求

HttpGet httpGet = new HttpGet("http://www.itcast.cn/");

//设置请求参数

RequestConfig requestConfig = RequestConfig.custom()

.setConnectTimeout(1000)//设置创建连接的最长时间

.setConnectionRequestTimeout(500)//设置获取连接的最长时间

.setSocketTimeout(10 * 1000)//设置数据传输的最长时间

.build();

httpGet.setConfig(requestConfig);

CloseableHttpResponse response = null;

try {

//使用HttpClient发起请求

response = httpClient.execute(httpGet);

//判断响应状态码是否为200

if (response.getStatusLine().getStatusCode() == 200) {

//如果为200表示请求成功,获取返回数据

String content = EntityUtils.toString(response.getEntity(), "UTF-8");

//打印数据长度

System.out.println(content);

}

} catch (Exception e) {

e.printStackTrace();

} finally {

//释放连接

if (response == null) {

try {

response.close();

} catch (IOException e) {

e.printStackTrace();

}

httpClient.close();

}

}

}END!!! 长路漫漫,JAVA为伴!!!